Agenti intelligenti

- 1. Agenti intelligenti Credit Articial Intelligence, A Modern Approach. Stuart Russell and Peter Norvig. Third Edition. Pearson Education. http://aima.cs.berkeley.edu/

- 2. un agente ├© sistema che percepisce l'ambiente esterno (il suo mondo) tramite dei sensori e agisce su di esso tramite degli attuatori La scelta dell'azione di un agente in un qualsiasi istante ├© funzione della sequenza percettiva (percept sequence) che l'agente ha accumulato attraverso i sensori e mai potr├Ā dipendere da qualcosa che non ha mai percepito. Internamente, la funzione agente di un agente ├© implementata da un programma agente. Un programma agente esegue il ciclo: Agente = architettura + programma agente Agente: chi era costui?

- 3. Esempio aspirapolvere A B Sequenza percettiva Azione [A, pulito] Destra [A, Sporco] Aspira [B, pulito] Sinistra [B, Sporco] Aspira [A, pulito] [A, pulito] Destra [B, pulito] [B, pulito] Sinistra ŌĆ” ŌĆ” La sequenza percettiva e la conseguente azione attuata dall'agente si pu├▓, in genere esprimere attraverso una tabella che da una parte evidenzia la sequenza percettiva e dall'altra contiene l'azione deliberata.

- 4. Esempio Agenti umani ŌĆó Sensori: occhi, orecchie, altri sensi ŌĆó Attuatori: mani, braccia, gambe, altre parti del corpo Agenti meccanici ŌĆó Sensori: videocamera, sensoristica di varia natura ŌĆó Attuatori: ingranaggi meccanici, motori, etc. Gli agenti sono ovunque ŌĆó Termostato ŌĆó Cellulari ŌĆó Aspirapolvere ŌĆó Robot ŌĆó Alexa Echo ŌĆó Macchine ŌĆó Uomini ŌĆó Etc.

- 5. Concetto di razionalit├Ā Regola generale ├ł necessario progettare le misure di prestazione di un agente in base all'effetto che si desidera ottenere sull'ambiente e non su come si pensa dovrebbe comportare l'agente In un dato momento, ci├▓ che ├© razionale dipende da quattro fattori: 1. la soglia di prestazione che determina il successo di un'azione, 2. la conoscenza pregressa dell'agente dell'ambiente in cui ├© inserito, 3. le azioni che l'agente pu├▓ effettuare 4. la sequenza percettiva che l'agente possiede per l'ambiente in cui ├© inserito Per ogni possibile sequenza percettiva un agente razionale ├© quello che sceglie l'azione che massimizzi il valore di prestazione, ovvero il successo dell'azione, in base alla sua conoscenza pregressa, alla sequenza percettiva dell'ambiente in cui ├© inserito e alle azioni a sua disposizione

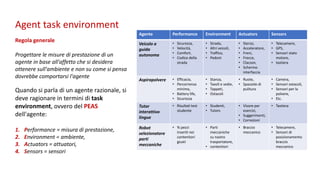

- 6. Agent task environment Regola generale Progettare le misure di prestazione di un agente in base all'affetto che si desidera ottenere sull'ambiente e non su come si pensa dovrebbe comportarsi l'agente Quando si parla di un agente razionale, si deve ragionare in termini di task environment, ovvero del PEAS dell'agente: 1. Performance = misura di prestazione, 2. Environment = ambiente, 3. Actuators = attuatori, 4. Sensors = sensori Agente Performance Environment Actuators Sensors Veicolo a guida autonoma ŌĆó Sicurezza, ŌĆó Velocit├Ā, ŌĆó Comfort, ŌĆó Codice della strada ŌĆó Strada, ŌĆó Altri veicoli, ŌĆó Traffico, ŌĆó Pedoni ŌĆó Sterzo, ŌĆó Acceleratore, ŌĆó Freni, ŌĆó Frecce, ŌĆó Clacson, ŌĆó Schermo interfaccia ŌĆó Telecamere, ŌĆó GPS, ŌĆó Sensori stato motore, ŌĆó tastiera Aspirapolvere ŌĆó Efficacia, ŌĆó Percorrenza minima, ŌĆó Battery life, ŌĆó Sicurezza ŌĆó Stanza, ŌĆó Tavoli e sedie, ŌĆó Tappeti, ŌĆó Ostacoli ŌĆó Ruote, ŌĆó Spazzole di pulitura ŌĆó Camera, ŌĆó Sensori ostacoli, ŌĆó Sensori per la polvere, ŌĆó Etc. Tutor interattivo lingue ŌĆó Risultati test studente ŌĆó Studenti, ŌĆó Tutors ŌĆó Visore per esercizi, ŌĆó Suggerimenti, ŌĆó Correzioni ŌĆó Tastiera Robot selezionatore parti meccaniche ŌĆó % pezzi inseriti nei contenitori giusti ŌĆó Parti meccaniche su nastro trasportatore, ŌĆó contenitori ŌĆó Braccio meccanico ŌĆó Telecamere, ŌĆó Sensori di posizionamento braccio meccanico

- 7. Tipi di ambienti ŌĆó Completamente osservabile (vs Parzialmente osservabile): i sensori di un agente gli danno accesso allo stato completo dell'ambiente in ogni momento. ŌĆó Agente singolo (vs multi-agente): un agente che opera da solo in un ambiente. ŌĆó Deterministico (vs stocastico): lo stato successivo dell'ambiente ├© Completamente determinato dallo stato corrente e dall'azione eseguita dall'agente. (Se l'ambiente ├© deterministico ad eccezione delle azioni di altri agenti, allora l'ambiente ├© strategico) ŌĆó Episodico (vs. sequenziale): l'esperienza dell'agente ├© divisa in "episodi" atomici (ciascun episodio consiste nell'eseguire una singola azione), e la scelta dell'azione in ciascun episodio dipende solo dall'episodio stesso. ŌĆó Statico (vs dinamico): l'ambiente ├© invariato mentre un agente sta deliberando. (L'ambiente ├© semi-dinamico se l'ambiente stesso non cambia con il passare del tempo ma il punteggio delle prestazioni dell'agente lo fa). ŌĆó Discreto (vs Continuo): un numero limitato di percezioni e azioni distinte, chiaramente definite. Ad esempio, la dama ├© un esempio di un ambiente Discreto, mentre l'auto a guida autonoma si evolve in modo Continuo. ŌĆó Noto (vs Ignoto): il progettista dell'agente pu├▓ avere o meno conoscenza delle leggi fisiche ambientali. Se l'ambiente ├© sconosciuto, l'agente dovr├Ā sapere come funziona per decidere.

- 8. Task environment Osservabile Agenti Deterministico Episodico Statico Discreto cruciverba Completamente Singolo Deterministico Sequenziale Statico Discreto Scacchi Completamente Multi Deterministico Sequenziale Semi Discreto Poker Parzialmente Multi Stocastico Sequenziale Statico Discreto Veicolo guida autonoma Parzialmente Multi Stocastico Sequenziale Dinamico Continuo Tutor interattivo lingue Parzialmente Multi Stocastico Sequenziale Dinamico Discreto Robot selezione parti meccaniche Parzialmente Singolo Stocastico Episodico Dinamico Continuo Tipi di ambienti: esempi

- 9. Tipi di Agenti ŌĆó Agenti reattivi semplici ŌĆó Agenti reattivi basati su modelli ŌĆó Agenti basati su obiettivi ŌĆó Agenti basati sull'utilit├Ā Tutti questi tipi di Agenti si possono ricondurre alla categoria dei learning agents (agenti capaci di apprendere), che possono migliorare la loro performance e attuare migliori azioni attraverso l'apprendimento.

- 10. Agenti reattivi semplici ŌĆó Selezionano un'azione, in base alla percezione corrente ignorando tutta la storia percettiva pregressa (es. aspirapolvere) ŌĆó Semplici ma limitati ŌĆó Possono lavorare solo quando l'ambiente (il suo mondo) ├© completamente osservabile ŌĆó Rispondono alla regola condizione-azione (if la-macchina-davanti-frena then inizia-a- frenare) ambiente/mondo agente attuatori sensori aspetto corrente del mondo azione da eseguire adesso Regole di condizione-azione

- 11. Agenti reattivi basati su modello Evoluzione degli agenti semplici: ŌĆó Devono sapere come evolve il mondo indipendentemente dalle loro azioni ŌĆó Devono conoscere l'effetto delle loro azioni sul mondo ŌĆó Un agente basato su modello tiene traccia dello stato corrente del mondo mediante un suo stato interno (che aggiorna dinamicamente) e sceglie l'azione da eseguire come un normale agente reattivo (regole di condizione-azione) ambiente/mondo agente attuatori sensori aspetto corrente del mondo azione da eseguire adesso Regole di condizione-azione Cosa fanno le mie azioni? Come evolve il mondo? Aggiorna stato

- 12. Agenti reattivi basati su obiettivi (goal) Evoluzione degli agenti su modello: ŌĆó Un agente basato su obiettivi, tiene traccia dello stato dell'ambiente e memorizza un insieme di obiettivi, quindi sceglie un'azione che lo porter├Ā, prima o poi, a soddisfarli. ambiente/mondo agente attuatori sensori aspetto corrente del mondo azione da eseguire adesso Obiettivi Cosa fanno le mie azioni? Come evolve il mondo? Aggiorna stato Come cambier├Ā il mondo se eseguo l'azione A

- 13. Agenti reattivi basati sull'utilit├Ā Evoluzione degli agenti su obiettivo: ŌĆó Un agente basato su utilit├Ā, oltre a tener traccia dello stato dell'ambiente impiega una funzione di utilit├Ā che misura le preferenze tra i vari stati del mondo. L'azione prescelta ├© quella che massimizza l'utilit├Ā attesa, calcolata come media pesata dei valori di utilit├Ā dei diversi stati possibili per la rispettiva probabilit├Ā di verificarsi. ambiente/mondo agente attuatori sensori aspetto corrente del mondo azione da eseguire adesso utilit├Ā Cosa fanno le mie azioni? Come evolve il mondo? Aggiorna stato Come cambier├Ā il mondo se eseguo l'azione A Quanto sar├▓ contento in uno stato simile

- 14. Agenti capaci di apprendere (learning agents) L'apprendimento presenta il vantaggio di permettere agli agenti di operare in ambienti inizialmente sconosciuti diventando col tempo pi├╣ competitivi. Un agente capace di apprendere ha quattro componenti astratte: 1. Elemento di apprendimento (learning element): ├© responsabile del miglioramento delle azioni esterne. ├ł quello che abbiamo considerato fin qui come se costituisse l'intero Agente. 2. Elemento esecutivo (performance element): ├© responsabile della selezione delle azioni esterne 3. Elemento critico (critic element): ├© quello che a partire dalle prestazioni correnti dell'agente, determina se e come modificare l'elemento esecutivo affinch├® in futuro si comporti meglio 4. Generatore di problemi (problem generator): suggerisce azioni che portino ad esperienze nuove ed esplorative ambiente/mondo Learning agent attuatori sensori Generatore di problemi elemento di apprendimento elemento critico elemento esecutivo conoscenza cambiamenti feedback obiettivi di apprendimento standard di prestazione

- 15. Rappresentazione di stati e transizioni Esistono tre modi in cui i componenti di un agente possono rappresentare l'ambiente abitato dall'agente stesso. Rappresentazione atomica Uno stato ├© una scatola nera priva di struttura interna. Ad esempio, trovare un percorso di guida: ogni stato ├© una citt├Ā. Algoritmi AI: ricerca, giochi, processi decisionali di Markov, modelli Markov nascosti, ecc. Rappresentazione fattorizzata Uno stato ├© un vettore di attributi. Ad esempio, posizione GPS, quantit├Ā di gas nel serbatoio. Algoritmi AI: soddisfacimento dei vincoli e reti bayesiane. Rappresentazione strutturata Uno stato include oggetti, ognuno dei quali pu├▓ avere attributi propri oltre a relazioni con altri oggetti. Algoritmi AI: logica del primo ordine, apprendimento basato sulla conoscenza, comprensione del linguaggio naturale.

![Esempio

aspirapolvere

A B

Sequenza percettiva Azione

[A, pulito] Destra

[A, Sporco] Aspira

[B, pulito] Sinistra

[B, Sporco] Aspira

[A, pulito]

[A, pulito]

Destra

[B, pulito]

[B, pulito]

Sinistra

ŌĆ” ŌĆ”

La sequenza percettiva e la conseguente azione

attuata dall'agente si pu├▓, in genere esprimere

attraverso una tabella che da una parte evidenzia la

sequenza percettiva e dall'altra contiene l'azione

deliberata.](https://image.slidesharecdn.com/agentiintelligenti-180301180932/85/Agenti-intelligenti-3-320.jpg)