Ceph•Ŕ•ů•Ń•ř©`•Į kvm

- 1. - 0 - 2015ńÍ11‘¬ Ceph•Ŕ•ů•Ń•ř©`•ĮĹYĻŻ °ę ĀĘŌŽ•ř•∑•ů •§•Š©`•łłŮľ{ÓI”Ú§»§∑§∆§ő–‘ń‹°ę •Ę•’•°©`•ŗ?•”•ł•Õ•Ļ•—©`•»• ©`•ļ÷Í ĹĽŠ…Á •«©`•Ņ•Ĺ•Í•Ś©`•∑•Á•ů?•Ķ©`•”•Ļ ¬ėI≤Ņ ī®∂ň ņŻļ£

- 2. - 1 - §Ō§ł§Š§ň Copyright 2015 AFfirm Business Partners All Rights Reserved. ĪĺēݧŌ°ĘSDS(Software Defined Storage)—u∆∑§ő QuantaStor §Ú”√§§§∆ Ceph Block Device(RBD)ôCń‹§ÚĆg¨F§Ķ§Ľ°ĘĀĘŌŽ•ř•∑•ů •§•Š©`•łłŮľ{ÓI”Ú §»§∑§∆§ő•—•’•©©`•ř•ů•Ļ§Úó ‘^§∑§Ņ§‚§ő§«§Ļ°£ ĀĘŌŽ•ř•∑•ů§»§∑§∆°ĘOSS§őKVM§Ú”√§§§∆§§§ř§Ļ°£ ĪĺŔYŃŌ§ő§™ÜĖ§§ļŌ§Ô§ĽŌ» •Ę•’•°©`•ŗ?•”•ł•Õ•Ļ•—©`•»• ©`•ļ÷Í ĹĽŠ…Á •«©`•Ņ•Ĺ•Í•Ś©`•∑•Á•ů?•Ķ©`•”•Ļ ¬ėI≤Ņ ī®∂ň TEL : 03-3583-7730(īķĪŪ) URL : http://affirmbp.com/ E-mail : toshimi_kawabata@affirmbp.com

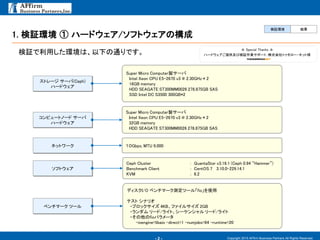

- 3. - 2 - 1. ó ‘^≠hĺ≥ ĘŔ •Ō©`•…•¶•ß•Ę/•Ĺ•’•»•¶•ß•Ę§őėč≥… Copyright 2015 AFfirm Business Partners All Rights Reserved. ó ‘^§«ņŻ”√§∑§Ņ≠hĺ≥§Ō°Ę“‘Ō¬§őÕ®§Í§«§Ļ°£ ó ‘^≠hĺ≥ ĹYĻŻ Super Micro Computer—u•Ķ©`•– Intel Xeon CPU E5-2670 v3 @ 2.30GHz * 2 16GB memory HDD SEAGATE ST300MM0026 278.875GB SAS SSD Intel DC S3500 300GB*2 •Ļ•»•ž©`•ł •Ķ©`•–(Ceph) •Ō©`•…•¶•ß•Ę £Ī£įGbps, MTU 9,000•Õ•√•»•Ô©`•Į Ceph Cluster : QuantaStor v3.16.1 (Ceph 0.94 °įHammer°Ī) Benchmark Client : CentOS 7 3.10.0-229.14.1 KVM : 6.2 •Ĺ•’•»•¶•ß•Ę •«•£•Ļ•ĮI/O •Ŕ•ů•Ń•ř©`•Įúy∂®•ń©`•Ž°łfio°Ļ§Ú Ļ”√ •∆•Ļ•» •∑• •Í•™ ?•÷•Ū•√•Į•Ķ•§•ļ 4KB°Ę•’•°•§•Ž•Ķ•§•ļ 2GB ?•ť•ů•ņ•ŗ •Í©`•…/•ť•§•»°Ę•∑©`•Ī•ů•∑•„•Ž •Í©`•…/•ť•§•» ?§Ĺ§őňŻ§őfio•—•ť•Š©`•Ņ -ioengine=libaio -direct=1 -numjobs=64 -runtime=20 •Ŕ•ů•Ń•ř©`•Į •ń©`•Ž °Ó Special Thanks °Ó •Ō©`•…•¶•ß•Ę§īŐŠĻ©ľį§”ó ‘^◊ųėI•Ķ•›©`•»£ļ÷Í ĹĽŠ…Á•»•••‚•Ū©`?•Õ•√•»ėĒ Super Micro Computer—u•Ķ©`•– Intel Xeon CPU E5-2670 v3 @ 2.30GHz * 2 32GB memory HDD SEAGATE ST300MM0026 278.875GB SAS •≥•ů•‘•Ś©`•»•ő©`•… •Ķ©`•– •Ō©`•…•¶•ß•Ę

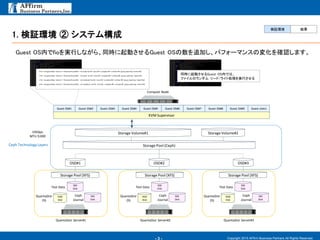

- 4. - 3 - Copyright 2015 AFfirm Business Partners All Rights Reserved. Ceph Technology Layers Storage Volume#1 Storage Volume#2 KVM Supervisor Guest OS#1 10Gbps MTU 9,000 Storage Pool (Ceph) 1. ó ‘^≠hĺ≥ Ęŕ •∑•Ļ•∆•ŗėč≥… OSD#1 OSD#2 OSD#3 QuantaStor Server#1 Storage Pool (XFS) QuantaStor OS HDD Disk SSD Disk Ceph Journal SSD DiskTest Data QuantaStor Server#2 Storage Pool (XFS) QuantaStor OS HDD Disk SSD Disk Ceph Journal SSD DiskTest Data QuantaStor Server#3 Storage Pool (XFS) QuantaStor OS HDD Disk SSD Disk Ceph Journal SSD DiskTest Data Guest OS#2 Guest OS#3 Guest OS#4 Guest OS#5 Guest OS#6 Guest OS#7 Guest OS#8 Guest OS#9 Guest OS#10 Compute Node # fio -ioengine=libaio -direct=1 -filename=fio_testfile -rw=read -bs=4k -size=2G -numjobs=64 -runtime=20 -group_reporting -name=file1 # fio -ioengine=libaio -direct=1 -filename=fio_testfile -rw=write -bs=4k -size=2G-numjobs=64 -runtime=20 -group_reporting -name=file1 # fio -ioengine=libaio -direct=1 -filename=fio_testfile -rw=randread -bs=4k -size=2G -numjobs=64 -runtime=20 -group_reporting -name=file1 # fio -ioengine=libaio -direct=1 -filename=fio_testfile -rw=randwrite -bs=4k -size=2G -numjobs=64 -runtime=20 -group_reporting -name=file1 Guest OSń৫fio§ÚĆg––§∑§ §¨§ť°ĘÕ¨ēr§ň∆ūĄ”§Ķ§Ľ§ŽGuest OS§ő ż§Ú◊∑ľ”§∑°Ę•—•’•©©`•ř•ů•Ļ§őČšĽĮ§Úī_’J§∑§ř§Ļ°£ Õ¨ēr§ň∆ūĄ”§Ķ§Ľ§ŽGuest OSń৫§Ō°Ę •’•°•§•Ž§ő•ť•ů•ņ•ŗ •Í©`•…/•ť•§•»ĄIņŪ§ÚĆg––§Ķ§Ľ§Ž ó ‘^≠hĺ≥ ĹYĻŻ

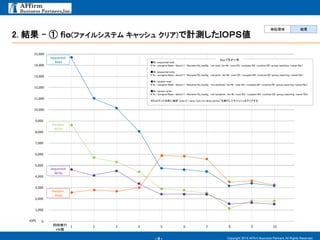

- 5. - 4 - 2. ĹYĻŻ - ĘŔ £ś£ť£Ô(•’•°•§•Ž•∑•Ļ•∆•ŗ •≠•„•√•∑•Ś •Į•Í•Ę)§«”čúy§∑§Ņ£…£Ō£–£”āé Copyright 2015 AFfirm Business Partners All Rights Reserved. 0 14,000 IOPS 1 Random Read 13,000 12,000 11,000 10,000 9,000 8,000 7,000 6,000 5,000 4,000 3,000 2,000 1,000 15,000 Sequential Write Random Write Sequential Read 2 3 4 5 6 7 8 9 10Õ¨ērĆg–– VM ż °Ų4k, sequential read # fio -ioengine=libaio -direct=1 -filename=fio_test2g -rw=read -bs=4k -size=2G -numjobs=64 -runtime=20 -group_reporting -name=file1 °Ų4k, sequential write # fio -ioengine=libaio -direct=1 -filename=fio_test2g -rw=write -bs=4k -size=2G -numjobs=64 -runtime=20 -group_reporting -name=file1 °Ų4k, random read # fio -ioengine=libaio -direct=1 -filename=fio_test2g -rw=randread -bs=4k -size=2G -numjobs=64 -runtime=20 -group_reporting -name=file1 °Ų4k, random write # fio -ioengine=libaio -direct=1 -filename=fio_test2g -rw=randwrite -bs=4k -size=2G -numjobs=64 -runtime=20 -group_reporting -name=file1 °ýfio•≥•ř•ů•…§ő«į§ňöįĽō°Īecho 3 >/proc/sys/vm/drop_caches°Ī§ÚĆg––§∑§∆•≠•„•√•∑•Ś§Ú•Į•Í•Ę§Ļ§Ž fio•—•ť•Š©`•Ņ ó ‘^≠hĺ≥ ĹYĻŻ

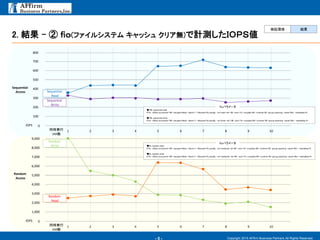

- 6. - 5 - 2. ĹYĻŻ - Ęŕ £ś£ť£Ô(•’•°•§•Ž•∑•Ļ•∆•ŗ •≠•„•√•∑•Ś •Į•Í•Ęüo)§«”čúy§∑§Ņ£…£Ō£–£”āé Copyright 2015 AFfirm Business Partners All Rights Reserved. 0IOPS 1 9,000 8,000 7,000 6,000 5,000 4,000 3,000 2,000 1,000 2 3 4 5 6 7 8 9 10Õ¨ērĆg–– VM ż Random Read Random Write °Ų4k, random read # fio -offset_increment=1M -ioengine=libaio -direct=1 -filename=fio_test2g -rw=randread -bs=4K -size=1G -numjobs=64 -runtime=30 -group_reporting -name=file1 -startdelay=0 °Ų4k, random write # fio -offset_increment=1M -ioengine=libaio -direct=1 -filename=fio_test2g -rw=randwrite -bs=4K -size=1G -numjobs=64 -runtime=30 -group_reporting -name=file1 -startdelay=0 0IOPS 1 800 700 600 500 400 300 200 100 2 3 4 5 6 7 8 9 10Õ¨ērĆg–– VM ż Sequential Read Sequential Write °Ų1M, sequential read # fio -offset_increment=1M -ioengine=libaio -direct=1 -filename=fio_test2g -rw=read -bs=1M -size=1G -numjobs=64 -runtime=30 -group_reporting -name=file1 -startdelay=0 °Ų1M, sequential write # fio -offset_increment=1M -ioengine=libaio -direct=1 -filename=fio_test2g -rw=write -bs=1M -size=1G -numjobs=64 -runtime=30 -group_reporting -name=file1 -startdelay=0 fio•—•ť•Š©`•Ņ fio•—•ť•Š©`•Ņ ó ‘^≠hĺ≥ ĹYĻŻ Sequential Access Random Access