CV勉強会CVPR2019読み会: Video Action Transformer Network

- 1. 論文紹介 Video Action Transformer Network 2019/7/6@CV勉強会 酒井 俊樹

- 2. 自己紹介 名前:酒井 俊樹 所属:NTTドコモ 仕事:Deep Learningを使ったAPI/サービスの研究開発 ● 画像認識のAPI開発 ● 法人様向けソリューション提供 ● スポーツ動画解析技術開発 本発表は個人で行うものであり、所属組織とは関係ありません。 2

- 3. 著者 ※特に断りのない限り、図表は著者らの論文、プロジェクトページ (https://rohitgirdhar.github.io/ActionTransformer/)および著者らの動画から引用 3

- 4. 概要: Spatio-temporal Action LocalizationでSOTA ● Spatio-temporal Action Localization(アクションの時空間定位?) =ビデオクリップ中のKeyFrameについて、人の動作の認識&定位を行う ● 提案手法で既存手法から+3.5%, +7.5%の精度向上(評価データの違い) ● NLP分野でスタンダードとなったTransformerを利用したネットワークを提案 4

- 5. 本論文を紹介する理由① ● 動画のようなより複雑なタスクへのDeep Learningの適用が拡大 ○ 初期: 小さい、短い動画クリップの分類 →実用的でない ○ 最近: 大きな画像でActionの時空間的な定位 →実サービスで利用できそう ■ AVA Dataset: 長めの動画中の人の Actionを特定、時空間的に定位 ● 80種類のAction ● 15分の動画 x 430本 5 →1.62M action labels [Gu et al., CVPR 2018]

- 6. 本論文を紹介する理由② ● NLP界隈ではスタンダードなTransformerをきちんと理解しておきたい& CV分野でのRNN/LSTMの代替として、CV分野での適用方法を知りたい ○ Transformer: Attentionを利用したネットワークで、機械翻訳で SOTAを大幅に更新 ○ その後、様々なNLPタスクのネットワークが Transformerベースに 6Attention Is All You Need [?ukasz Kaiser et al., arXiv, 2017/06]

- 7. 先行研究: Two-Stream In?ated 3DConvNet(I3D) ● Videoのアクション分類のための手法 ● Two-Stream: フレームのRGB情報だけでなく、optical ?ow情報も入力 ● 3D ConvNet: 畳み込みをh, w方向だけでなく、t(もしくはd)方向にも ● In?ated: 2Dで、画像を入力として学習した重みを、3D Convの初期値とする 7[Carreira & Zisserman, CVPR 2017] H W T

- 8. 先行研究: I3Dのアクションの時空間定位への応用 ● 動画クリップを特徴マップに変換 ○ ビデオクリップ、OpticalFlowなど入力 ○ I3D等複数のネットワーク ● RPNを用いて人領域を抽出 ● 抽出された領域の特徴を抽出 ● 学習ベースの分類器でBBox回帰、クラス分類 8 [Jiang et al., 2019]

- 9. 提案手法 ● 動画クリップを特徴マップに変換 ○ ビデオクリップ、Flowなど入力ビデオクリップのみ ○ I3D等複数のネットワーク I3Dのみ ● RPNを用いて人領域を抽出 ● 抽出された領域の特徴を抽出Transformerを使って特徴量化 ● 学習ベースの分類器でBBox回帰、クラス分類 9 ビデオクリップ入力 I3D Transformer BBox回帰 クラス分類 Region Proposal

- 11. Transformer ● 自己注意を用いて、周辺の情報(Context)を選択的に利用して次の層の出力を計 算するネットワーク 11 I like cat more than dog embed layer 1の特徴量 layer 2の特徴量

- 12. Transformer ● 自己注意を用いて、周辺の情報(Context)を選択的に利用して次の層の出力を計 算するネットワーク 12 I like cat more than dog embed layer 1の特徴量 出力候補の特徴(value) 線形変換 key query softmax = weight layer 2の特徴量 重みづけ平均を 取ったうえで線形変換 線形変換 線形変換 上記を繰り返してより深く

- 13. Transformer ● Location Embedding: 位置情報が失われてしまうので、位置をCodeした 特徴をConcatenateする(実際には、位置のインデックスではなく、位置をCodeした数値担っている) ● Multi-head Attention: 線形変換を複数用意することで、 AttentionのQ, K, Vを複数用意する ● 13 1 2 3 4 5 6

- 14. Transformer ● RNNよりも高精度 ● 前のtの計算を待たないので、GPUでの学習効率が良い ○ 学習時 ○ 推論時のエンコーダー ● Convolution, RNNよりも、より広範なContextの情報を利用することができる 14

- 15. 提案手法のネットワーク 15 ビデオ クリップ入力 I3D Transformer(2 head x 3) BBox回帰 クラス分類 600x600 64 frame 3channel 25x25 16 frame 128 channel ● 単語→h, w, tで定義される1つのmap上の点 ● クエリ→RPNで抽出されたKeyFrame上の 領域の特徴 RPNの抽出領域をクエリとして、時空間上の点に 注意を向け、特徴量を計算している Resion Proposal

- 16. 抽出された領域からのクエリの作成 1. 抽出された領域はRoIプーリング&Maxプーリングで7x7x1x128の特徴に変換 2. 128次元のデータに変換 ● HighRes: Region内での特徴の分布情報を残せるように a. 1x1 Conv処理をかけて7x7x128の特徴を算出 b. 線形変換により128次元の特徴に変換 ● LowRes: 単純なプーリング a. H, W方向に平均を取って 128次元の特徴に変換 16

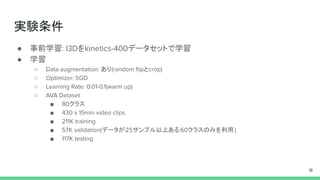

- 18. 実験条件 ● 事前学習: I3Dをkinetics-400データセットで学習 ● 学習 ○ Data augmentation: あり(random ?ipとcrop) ○ Optimizer: SGD ○ Learning Rate: 0.01-0.1(warm up) ○ AVA Dataset ■ 80クラス ■ 430 x 15min video clips ■ 211K training ■ 57K validation(データが25サンプル以上ある60クラスのみを利用) ■ 117K testing 18

- 19. 結果①: クラス分類部分の精度 ● RPN部分をGroundtruthで代替することで、Transformer部分だけの効果を測定 ○ GT Boxesを使うと、I3DよりもTransformerの法が、低Flopsで高精度 ○ GT Boxesを使わないとTransformerで精度が下がる ■ RPNの提案するRegion数を64と少なめにしたことが影響している (300にした版は後述) 19

- 20. 結果②: BBox抽出の精度 ● Actionのクラスを1つにまとめて評価 ○ I3Dヘッドの方が高精度 ○ Transformerは、クラス分類側に大きな精度向上をもたらす半面、 位置は正確さが犠牲になる傾向がある 20

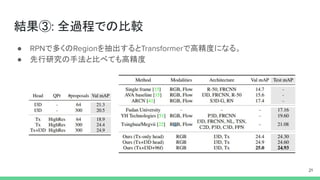

- 21. 結果③: 全過程での比較 ● RPNで多くのRegionを抽出するとTransformerで高精度になる。 ● 先行研究の手法と比べても高精度 21

- 22. 注意の可視化 ● 左: Keyの値の可視化(PCAで3次元に落とす) ○ 人というカテゴリに着目している Txと人のインスタンスに着目している Tx ● 右: Attentionの向いている部分の可視化 ○ 人オブジェクトに注意が向いている 22

- 23. ● 出現回数の多いクラスの方が精度が高い傾向にあるが、例外もある ● 領域が大きなActionの方が高精度 ● 一つのクリップ内で、BBoxが少ない方が高精度 23

- 25. 定性評価: 失敗した例 a. 似た動作を喫煙と誤推定 b. 異なる人にアクションを紐づける c. まだ動作が始まっていない/終わってしまったシーンにアクションを紐づけ 25

- 26. 所感 ● 先行研究よりも構成要素をよりシンプルにして精度向上している点が良い ● 特徴マップ上のx, y, tで定義される点をkey, valueとしてAttentionをかける点が、動 画データでのTransformerの使い方として参考になる ○ CV分野でもLSTM等からTransformerへの置き換えが進むか? ● 動画の処理では計算量が課題という点は残っている ● 2週間ほどで他のチームに精度がぬかされているので、 そちらのチームの手法も気になる 26

![本論文を紹介する理由①

● 動画のようなより複雑なタスクへのDeep Learningの適用が拡大

○ 初期: 小さい、短い動画クリップの分類 →実用的でない

○ 最近: 大きな画像でActionの時空間的な定位 →実サービスで利用できそう

■ AVA Dataset: 長めの動画中の人の Actionを特定、時空間的に定位

● 80種類のAction

● 15分の動画 x 430本

5

→1.62M action labels

[Gu et al., CVPR 2018]](https://image.slidesharecdn.com/cvkantocvpr2019videoactiontransformernetwork-190706045907/85/CV-CVPR2019-Video-Action-Transformer-Network-5-320.jpg)

![本論文を紹介する理由②

● NLP界隈ではスタンダードなTransformerをきちんと理解しておきたい&

CV分野でのRNN/LSTMの代替として、CV分野での適用方法を知りたい

○ Transformer: Attentionを利用したネットワークで、機械翻訳で SOTAを大幅に更新

○ その後、様々なNLPタスクのネットワークが Transformerベースに

6Attention Is All You Need [?ukasz Kaiser et al., arXiv, 2017/06]](https://image.slidesharecdn.com/cvkantocvpr2019videoactiontransformernetwork-190706045907/85/CV-CVPR2019-Video-Action-Transformer-Network-6-320.jpg)

![先行研究: Two-Stream In?ated 3DConvNet(I3D)

● Videoのアクション分類のための手法

● Two-Stream: フレームのRGB情報だけでなく、optical ?ow情報も入力

● 3D ConvNet: 畳み込みをh, w方向だけでなく、t(もしくはd)方向にも

● In?ated: 2Dで、画像を入力として学習した重みを、3D Convの初期値とする

7[Carreira & Zisserman, CVPR 2017]

H

W

T](https://image.slidesharecdn.com/cvkantocvpr2019videoactiontransformernetwork-190706045907/85/CV-CVPR2019-Video-Action-Transformer-Network-7-320.jpg)

![先行研究: I3Dのアクションの時空間定位への応用

● 動画クリップを特徴マップに変換

○ ビデオクリップ、OpticalFlowなど入力

○ I3D等複数のネットワーク

● RPNを用いて人領域を抽出

● 抽出された領域の特徴を抽出

● 学習ベースの分類器でBBox回帰、クラス分類

8

[Jiang et al., 2019]](https://image.slidesharecdn.com/cvkantocvpr2019videoactiontransformernetwork-190706045907/85/CV-CVPR2019-Video-Action-Transformer-Network-8-320.jpg)