IBM FlashSystem 840 UA

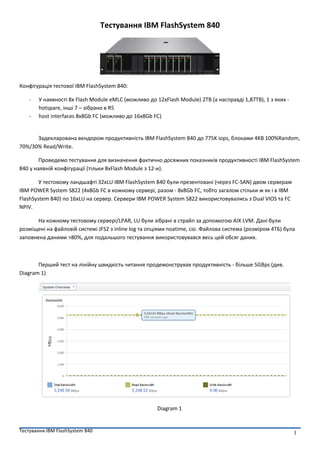

- 1. ąóąĄčüčéčāą▓ą░ąĮąĮčÅ IBM FlashSystem 840 1 ąóąĄčüčéčāą▓ą░ąĮąĮčÅ IBM FlashSystem 840 ąÜąŠąĮčäč¢ą│čāčĆą░čåč¢čÅ č鹥čüč鹊ą▓ąŠčŚ IBM FlashSystem 840: - ąŻ ąĮą░čÅą▓ąĮąŠčüčéč¢ 8čģ Flash Module eMLC (ą╝ąŠąČą╗ąĖą▓ąŠ ą┤ąŠ 12čģFlash Module) 2TB (ą░ ąĮą░čüą┐čĆą░ą▓ą┤č¢ 1,87TB), 1 ąĘ čÅą║ąĖčģ - hotspare, č¢ąĮčłč¢ 7 ŌĆō ąĘč¢ą▒čĆą░ąĮąŠ ą▓ R5 - host interfaces 8x8Gb FC (ą╝ąŠąČą╗ąĖą▓ąŠ ą┤ąŠ 16x8Gb FC) ąŚą░ą┤ąĄą║ą╗ą░čĆąŠą▓ą░ąĮą░ ą▓ąĄąĮą┤ąŠčĆąŠą╝ ą┐čĆąŠą┤čāą║čéąĖą▓ąĮč¢čüčéčī IBM FlashSystem 840 ą┤ąŠ 775K iops, ą▒ą╗ąŠą║ą░ą╝ąĖ 4KB 100%Random, 70%/30% Read/Write. ą¤čĆąŠą▓ąĄą┤ąĄą╝ąŠ č鹥čüčéčāą▓ą░ąĮąĮčÅ ą┤ą╗čÅ ą▓ąĖąĘąĮą░č湥ąĮąĮčÅ čäą░ą║čéąĖčćąĮąŠ ą┤ąŠčüčÅąČąĮąĖčģ ą┐ąŠą║ą░ąĘąĮąĖą║č¢ą▓ ą┐čĆąŠą┤čāą║čéąĖą▓ąĮąŠčüčéč¢ IBM FlashSystem 840 čā ąĮą░čÅą▓ąĮč¢ą╣ ą║ąŠąĮčäč¢ą│čāčĆą░čåč¢čŚ (čéč¢ą╗čīą║ąĖ 8čģFlash Module ąĘ 12-ąĖ). ąŻ č鹥čüč鹊ą▓ąŠą╝čā ą╗ą░ąĮą┤čłą░čäčéč¢ 32čģLU IBM FlashSystem 840 ą▒čāą╗ąĖ ą┐čĆąĄąĘąĄąĮč鹊ą▓ą░ąĮč¢ (č湥čĆąĄąĘ FC-SAN) ą┤ą▓ąŠą╝ čüąĄčĆą▓ąĄčĆą░ą╝ IBM POWER System S822 (4čģ8Gb FC ą▓ ą║ąŠąČąĮąŠą╝čā čüąĄčĆą▓ąĄčĆč¢, čĆą░ąĘąŠą╝ - 8x8Gb FC, č鹊ą▒č鹊 ąĘą░ą│ą░ą╗ąŠą╝ čüčéč¢ą╗čīą║ąĖ ąČ čÅą║ č¢ ą▓ IBM FlashSystem 840) ą┐ąŠ 16čģLU ąĮą░ čüąĄčĆą▓ąĄčĆ. ąĪąĄčĆą▓ąĄčĆąĖ IBM POWER System S822 ą▓ąĖą║ąŠčĆąĖčüč鹊ą▓čāą▓ą░ą╗ąĖčüčī ąĘ Dual VIOS čéą░ FC NPIV. ąØą░ ą║ąŠąČąĮąŠą╝čā č鹥čüč鹊ą▓ąŠą╝čā čüąĄčĆą▓ąĄčĆč¢/LPAR, LU ą▒čāą╗ąĖ ąĘč¢ą▒čĆą░ąĮč¢ ą▓ čüčéčĆą░ą╣ą┐ ąĘą░ ą┤ąŠą┐ąŠą╝ąŠą│ąŠčÄ AIX LVM. ąöą░ąĮč¢ ą▒čāą╗ąĖ čĆąŠąĘą╝č¢čēąĄąĮč¢ ąĮą░ čäą░ą╣ą╗ąŠą▓č¢ą╣ čüąĖčüč鹥ą╝č¢ JFS2 ąĘ inline log čéą░ ąŠą┐čåč¢čÅą╝ąĖ noatime, cio. ążą░ą╣ą╗ąŠą▓ą░ čüąĖčüč鹥ą╝ą░ (čĆąŠąĘą╝č¢čĆąŠą╝ 4ąóąæ) ą▒čāą╗ą░ ąĘą░ą┐ąŠą▓ąĮąĄąĮą░ ą┤ą░ąĮąĖą╝ąĖ >80%, ą┤ą╗čÅ ą┐ąŠą┤ą░ą╗čīčłąŠą│ąŠ č鹥čüčéčāą▓ą░ąĮąĮčÅ ą▓ąĖą║ąŠčĆąĖčüč鹊ą▓čāą▓ą░ą▓čüčÅ ą▓ąĄčüčī čåąĄą╣ ąŠą▒čüčÅą│ ą┤ą░ąĮąĖčģ. ą¤ąĄčĆčłąĖą╣ č鹥čüčé ąĮą░ ą╗č¢ąĮč¢ą╣ąĮčā čłą▓ąĖą┤ą║č¢čüčéčī čćąĖčéą░ąĮąĮčÅ ą┐čĆąŠą┤ąĄą╝ąŠąĮčüčéčĆčāą▓ą░ą▓ ą┐čĆąŠą┤čāą║čéąĖą▓ąĮč¢čüčéčī - ą▒č¢ą╗čīčłąĄ 5GBps (ą┤ąĖą▓. Diagram 1) Diagram 1

- 2. ąóąĄčüčéčāą▓ą░ąĮąĮčÅ IBM FlashSystem 840 2 ąØą░čüčéčāą┐ąĮąĖą╣ č鹥čüčé ąĮą░ čłą▓ąĖą┤ą║č¢čüčéčī ąĘą░ą┐ąĖčüčā ą┐čĆąŠą┤ąĄą╝ąŠąĮčüčéčĆčāą▓ą░ą▓ ą┐čĆąŠą┤čāą║čéąĖą▓ąĮč¢čüčéčī ą╝ą░ą╣ąČąĄ 2GBps (ą┤ąĖą▓. Diagram 2) Diagram 2 ąóąĄčüčé ą▒ą░ą│ą░č鹊ą┐ąŠč鹊ą║ąŠą▓ąŠą│ąŠ ąĮą░ą▓ą░ąĮčéą░ąČąĄąĮąĮčÅ - 100% Random, čüą┐č¢ą▓ą▓č¢ą┤ąĮąŠčłąĄąĮąĮčÅ Read/Write=80/20, čĆąŠąĘą╝č¢čĆ ą▒ą╗ąŠą║čā 4KB ŌĆō ą┐čĆąŠą┤čāą║čéąĖą▓ąĮč¢čüčéčī ą▒č¢ą╗čīčłąĄ 500K iops (ą┤ąĖą▓. Diagram 3) Diagram 3

- 3. ąóąĄčüčéčāą▓ą░ąĮąĮčÅ IBM FlashSystem 840 3 ą¤ąŠą▓č鹊čĆąĖą╝ąŠ č鹥čüčé ą▒ą░ą│ą░č鹊ą┐ąŠč鹊ą║ąŠą▓ąŠą│ąŠ ąĮą░ą▓ą░ąĮčéą░ąČąĄąĮąĮčÅ - 100% Random, čüą┐č¢ą▓ą▓č¢ą┤ąĮąŠčłąĄąĮąĮčÅ Read/Write=80/20, ąĘą╝č¢ąĮčÄčÄčćąĖ čĆąŠąĘą╝č¢čĆ ą▒ą╗ąŠą║čā ą┤ą░ąĮąĖčģ (Diagram 4 ŌĆō ą┐čĆąŠą┤čāą║čéąĖą▓ąĮč¢čüčéčī ą▓ iops, Diagram 5 ŌĆō ą▓č¢ą┤ą┐ąŠą▓č¢ą┤ąĮąĖą╣ čćą░čü ą▓č¢ą┤ą│čāą║čā ąĮą░ čüąĄčĆą▓ąĄčĆč¢ ą┤ąĖčüą║ąŠą▓ąŠčŚ ą┐č¢ą┤čüąĖčüč鹥ą╝ąĖ ą▓ ms). 4KB 8KB 16KB 32KB 64KB 128KB IBM FlashSystem 840 507724 325057 174311 90340 45839 23059 0 100000 200000 300000 400000 500000 600000 IOPS Diagram 4 - IBM FlashSystem 840 100% Random, Read/Write= 80/20 0 5 10 15 20 25 4KB 8KB 16KB 32KB 64KB 128KB ms 4KB 8KB 16KB 32KB 64KB 128KB IBM FlashSystem 840, write ms 0.6 1.1 2.9 7.6 16.2 31 IBM FlashSystem 840, read ms 1.2 2.4 4.8 9.6 18.8 34.5 Diagram 5 - IBM FlashSystem 840 average latency

- 4. ąóąĄčüčéčāą▓ą░ąĮąĮčÅ IBM FlashSystem 840 4 ąÉ ą┤ą╗čÅ ąĮą░čüčéčāą┐ąĮąŠą│ąŠ č鹥čüčéčā ąĘą░ą╗ąĖčłąĖą╝ąŠ čĆąŠąĘą╝č¢čĆ ą▒ą╗ąŠą║čā ą┤ą░ąĮąĖčģ ąĮąĄąĘą╝č¢ąĮąĮąĖą╝ ŌĆō 8KB, ą░ ąĘą╝č¢ąĮčÄą▓ą░čéąĖ ą▒čāą┤ąĄą╝ąŠ čüą┐č¢ą▓ą▓č¢ą┤ąĮąŠčłąĄąĮąĮčÅ Read/Write. ą»ą║ ą▓ąĖą┤ąĮąŠ ąĮą░ Diagram 6 ŌĆō ą╝ą░ą║čüąĖą╝ą░ą╗čīąĮą░ ą┐čĆąŠą┤čāą║čéąĖą▓ąĮč¢čüčéčī ą▒čāą╗ą░ ą┤ąŠčüčÅą│ąĮčāčéą░ ąĮą░ čüą┐č¢ą▓ą▓č¢ą┤ąĮąŠčłąĄąĮąĮč¢, ą▓č¢ą┤ą╝č¢ąĮąĮąŠą╝čā ą▓č¢ą┤ 100% Read. 100% Write 10% Read 90% Write 20% Read 80% Write 30% Read 70% Write 40% Read 60% Write 50% Read 50% Write 60% Read 40% Write 70% Read 30% Write 80% Read 20% Write 90% Read 10% Write 100% Read IBM FlashSystem 840 187480 199834 213311 226443 241190 257174 274482 296792 325265 385369 378269 0 50000 100000 150000 200000 250000 300000 350000 400000 450000 IOPS Diagram 6 - IBM FlashSystem 840 100% Random, Read/Write= 0/100-100/0

- 5. ąóąĄčüčéčāą▓ą░ąĮąĮčÅ IBM FlashSystem 840 5 ąØą░ą┤ą░ą╗č¢ čĆąŠąĘą│ą╗čÅąĮąĄą╝ąŠ čéą░ą║ąĖą╣ ą░čüą┐ąĄą║čé ŌĆō čÅą║ ąĘą╝č¢ąĮąĖčéčīčüčÅ ą┐čĆąŠą┤čāą║čéąĖą▓ąĮč¢čüčéčī IBM FlashSystem 840 ą┐č¢ą┤ čćą░čü ąŠąĮąŠą▓ą╗ąĄąĮąĮčÅ firmware? ąÆąĄąĮą┤ąŠčĆąĖ ąĘą░ą▓ąČą┤ąĖ čĆąĄą║ąŠą╝ąĄąĮą┤čāčÄčéčī ą▓ąĖą║ąŠąĮčāą▓ą░čéąĖ ąŠąĮąŠą▓ą╗ąĄąĮąĮčÅ firmware ą┐č¢ą┤ čćą░čü ąĮą░ą╣ą╝ąĄąĮčłąŠą│ąŠ ąĮą░ą▓ą░ąĮčéą░ąČąĄąĮąĮčÅ, ą░ą╗ąĄ ąĮč¢ą║ąŠą╗ąĖ ąĮąĄ čāč鹊čćąĮčÄčÄčéčī, čēąŠ čüą░ą╝ąĄ ą┐č¢ą┤ čåąĖą╝ čĆąŠąĘčāą╝č¢čÄčéčīŌĆ” 1K iops, 10K iops, 100K iops? ąŚą│ąĄąĮąĄčĆčāčöą╝ąŠ ąĮą░ą▓ą░ąĮčéą░ąČąĄąĮąĮčÅ ą▒ą╗ąĖąĘčīą║ąŠ ~100K iops - 100% Random, čüą┐č¢ą▓ą▓č¢ą┤ąĮąŠčłąĄąĮąĮčÅ Read/Write=80/20, čĆąŠąĘą╝č¢čĆ ą▒ą╗ąŠą║čā 8KB, čéą░ ą┐ąŠčćąĮąĄą╝ąŠ ąŠą┤ąĮąŠčćą░čüąĮąŠ ąŠąĮąŠą▓ą╗ąĄąĮąĮčÅ firmware ąĮą░ IBM FlashSystem 840. ą»ą║ ą▓ąĖą┤ąĮąŠ ąĮą░ Diagram 7 čéą░ 8, ąĘąĮąĖąČąĄąĮąĮčÅ ą┐čĆąŠą┤čāą║čéąĖą▓ąĮąŠčüčéč¢ ą┐ąŠ ą║č¢ą╗čīą║ąŠčüčéč¢ iops ą┤čāąČąĄ ą║ąŠčĆąŠčéą║ąŠčćą░čüąĮąĄ (ą▒ąĄąĘą┐ąŠčüąĄčĆąĄą┤ąĮčīąŠ ą┐č¢ą┤ čćą░čü ąŠąĮąŠą▓ą╗ąĄąĮąĮčÅ ą║ąŠąĮčéčĆąŠą╗ąĄčĆč¢ą▓, ą▒č¢ą╗čīčł ą┤ąĄčéą░ą╗čīąĮąŠ/online ą┤ą░ąĮą░ čüąĖčéčāą░čåč¢čÅ ąĘąŠą▒čĆą░ąČąĄąĮą░ ąĮą░ Diagram 9 ), ą░ ąĮąĄąĘąĮą░čćąĮąĄ ąĘą▒č¢ą╗čīčłąĄąĮąĮčÅ čćą░čüčā ą▓č¢ą┤ą│čāą║čā ą▓č¢ą┤ą▒čāą▓ą░čöčéčīčüčÅ ą┐č¢ą┤ čćą░čü ą▓ąĄčĆąĖčäč¢ą║ą░čåč¢čŚ RAID stripes. Diagram 7 Diagram 8 0 20000 40000 60000 80000 100000 120000 140000 16:10 16:16 16:21 16:27 16:32 16:38 16:43 16:49 16:54 17:00 17:05 17:11 17:16 17:22 17:27 17:33 17:38 17:44 17:49 17:55 18:00 18:06 18:11 18:17 18:22 18:28 18:33 18:39 18:44 18:50 18:55 19:01 19:06 Disk xfers IO/sec 0.0 0.1 0.2 0.3 0.4 0.5 0.6 0.7 0.8 0.9 16:10 16:16 16:21 16:27 16:32 16:38 16:43 16:49 16:54 17:00 17:05 17:11 17:16 17:22 17:27 17:33 17:38 17:44 17:49 17:55 18:00 18:06 18:11 18:17 18:22 18:28 18:33 18:39 18:44 18:50 18:55 19:01 19:06 Disk Service Time msec/xfer

- 6. ąóąĄčüčéčāą▓ą░ąĮąĮčÅ IBM FlashSystem 840 6 Diagram 9

- 7. ąóąĄčüčéčāą▓ą░ąĮąĮčÅ IBM FlashSystem 840 7 ąöčÅą║čāčÄ ąĘą░ čāą▓ą░ą│čā! ą×ą╗ąĄą│ ąÜąŠčĆąŠą╗čī ąøąĖčüč鹊ą┐ą░ą┤ 2014 http://ua.linkedin.com/pub/oleg-korol/26/920/716/