Into to Generative AI Human Singularity.pdf

- 1. Human Singularity Human First. AI Next! humansingularity.it Intro to Generative AI

- 2. Una linea tracciata CŌĆÖ├© una linea molto chiara gi├Ā tracciata: tra chi imparer├Ā come potenziarsi con lŌĆÖintelligenza artificiale e la sapr├Ā sfruttare. E chi ne sar├Ā sfruttato. Oggi ├© uno dei momenti in cui dovrete decidere da che parte della linea stare: ŌŚÅ da chi che si fa fare i compiti o da chi decide di definire nuovi orizzonti per la sua conoscenza ŌŚÅ da chi passa ore su tiktok a vedere balletti o chi usa quel tempo per capire dove va il mondo. La generazione precedente vi sta lasciando unŌĆÖeredit├Ā pesante, clima, guerra ed AI. Se non vi piace il mondo in cui state, iniziate a costruire nuove strade

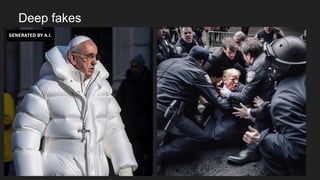

- 3. Deep fakes 3

- 6. Il nostro primo incontro con lŌĆÖAI (Social Media) Nella prima sfida con le AI ŌĆścurativeŌĆÖ ├© stata disastrosa per la societ├Ā ŌŚÅ Polarizzazione ŌŚÅ Filter Bubbles ŌŚÅ Fake News ŌŚÅ Personalizzazione Eccessiva ŌŚÅ Effetti sulla Salute Mentale ŌŚÅ Sovraesposizione a Contenuti Dannosi ŌŚÅ Norme Sociali Negative ŌŚÅ Privacy e Raccolta Dati ŌŚÅ Dipendenza dai Social Media ŌŚÅ Disinformazione e Manipolazione ŌŚÅ Impatto sui Giovani ŌŚÅ Bias Algoritmico ŌŚÅ Economia dell'Attenzione ŌŚÅ Problemi di Benessere Psicologico

- 7. 7 Potenzialit├Ā delle AI Generative ŌŚÅ Innovazione Creativa ŌŚÅ E’¼ācienza nella Produzione di Contenuti ŌŚÅ Supporto alla Ricerca e allo Sviluppo ŌŚÅ Educazione e Apprendimento ŌŚÅ Assistenza nella Presa di Decisioni Problemi Potenziali ŌŚÅ Disinformazione e Manipolazione ŌŚÅ Problemi di Copyright e Originalit├Ā ŌŚÅ Impatto sul Lavoro Creativo ŌŚÅ Bias e Discriminazione ŌŚÅ Sicurezza e Uso Malintenzionato ŌŚÅ Questioni di Privacy ŌŚÅ Impatto Sociale ed Etico

- 8. Impatto sul mondo del lavoro ŌŚÅ Impatto Differenziato: L'AI influenzer├Ā diversi settori in modi differenti, creando nuove opportunit├Ā in alcuni campi mentre ne riduce in altri. ├ł importante valutare queste dinamiche specifiche del settore. ŌŚÅ Evoluzione dei Ruoli: Molte professioni subiranno un'evoluzione piuttosto che una semplice sostituzione, con l'AI che assume compiti ripetitivi o computazionalmente intensivi, liberando gli umani per ruoli che richiedono creativit├Ā, empatia e capacit├Ā decisionali complesse. ŌŚÅ Sviluppo delle Competenze: L'accento si sposter├Ā sull'acquisizione di competenze complementari all'AI, come il pensiero critico, la risoluzione creativa di problemi e l'intelligenza emotiva.

- 9. EŌĆÖ ŌĆśsoloŌĆÖ unŌĆÖaltra rivoluzione industriale (Harari) ŌŚÅ Connettendo le Rivoluzioni: La prima rivoluzione industriale ha trasformato il mondo, accelerando lo sviluppo tecnologico ma anche portando a profonde disuguaglianze e tensioni globali. ŌŚÅ Conseguenze Inaspettate: L'introduzione di nuove tecnologie ha avuto impatti profondi sulla societ├Ā, contribuendo all'emergere di ideologie estreme come imperialismo, comunismo e nazismo. ŌŚÅ Una Nuova Svolta con l'AI: Oggi, l'AI rappresenta un'altra rivoluzione industriale. La sua portata e potenziale sono immensi, ma porta con s├® nuove sfide etiche e sociali. ŌŚÅ La Necessit├Ā di Agire con Saggezza: Non possiamo permetterci di ripetere gli errori del passato. ├ł fondamentale imparare dalle lezioni storiche per guidare l'AI verso un futuro che beneficia tutti, evitando le trappole delle disuguaglianze e dei conflitti. <video completo: https://www.youtube.com/watch?v=UzOJiqN_DpM >

- 10. Con le Generative AI siamo di fronte ad unŌĆÖintelligenza ŌĆ£alienaŌĆØ? Yuval Noah Harari 10 Origini Cognitive Distinte I processi computazionali dell'IA differiscono fondamentalmente dalla cognizione umana. Modo di ragionare Unico L'IA non "pensa" o "sente" nel modo in cui lo fanno gli esseri umani. Le decisioni dell'IA, basate sull'elaborazione dei dati, sono prive di emozioni e coscienza umane, rendendole imprevedibili per noi. Mancanza di Background Evolutivo Comune A differenza delle forme di vita terrestri, l'IA non condivide la nostra storia evolutiva, rendendo il suo comportamento alieno. Sviluppo di abilit├Ā sconosciute La Generative AI pu├▓ produrre contenuti, prendere decisioni e svolgere compiti in modi che vanno oltre le capacit├Ā umane. Implicazioni Etiche e Filosofiche Se l'IA raggiunge un punto in cui sembra avere le proprie motivazioni o desideri, solleva profonde domande riguardo alle capacit├Ā decisionali, ai diritti e al modo in cui ci relazioniamo con questa entit├Ā "aliena".

- 11. Il fatto che sia aliena, non ci aliena dalle nostre responsabilit├Ā 11 Anche se definiamo l'intelligenza artificiale come "aliena" a causa della sua natura e del suo funzionamento distinti rispetto all'intelligenza umana, ci├▓ non ci esime dalle responsabilit├Ā associate al suo sviluppo, implementazione e uso. Siamo noi, come esseri umani, a progettare, programmare e implementare queste tecnologie. Pertanto, qualsiasi decisione o azione intrapresa da un sistema AI ├©, in ultima analisi, il risultato delle scelte umane, sia direttamente (attraverso la programmazione esplicita) sia indirettamente (attraverso i dati con cui l'AI ├© stata addestrata). ├ł essenziale riconoscere e affrontare le implicazioni etiche, sociali e legali dell'IA, garantendo che venga utilizzata in modo che rispetti i diritti umani, l'equit├Ā e la giustizia. La definizione di AI come "aliena" non dovrebbe mai essere usata come scusa per evitare la responsabilit├Ā o l'accountability.

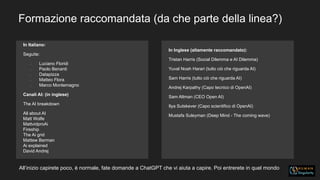

- 12. Formazione raccomandata (da che parte della linea?) In Italiano: Seguite: ŌĆó Luciano Floridi ŌĆó Paolo Benanti ŌĆó Datapizza ŌĆó Matteo Flora ŌĆó Marco Montemagno Canali AI: (in inglese) The AI breakdown All about AI Matt Wolfe MattvidproAi Fireship The Ai grid Mattew Berman Ai explained David Andrej In Inglese (altamente raccomandato): Tristan Harris (Social Dilemma e AI Dilemma) Yuval Noah Harari (tutto ci├▓ che riguarda AI) Sam Harris (tutto ci├▓ che riguarda AI) Andrej Karpathy (Capo tecnico di OpenAI) Sam Altman (CEO Open AI) Ilya Sutskever (Capo scientifico di OpenAI) Mustafa Suleyman (Deep Mind - The coming wave) AllŌĆÖinizio capirete poco, ├© normale, fate domande a ChatGPT che vi aiuta a capire. Poi entrerete in quel mondo

- 13. La famiglia AI AI rappresenta una serie di concetti molto differenti tra di loro ŌĆ” semplificando: 1. Intelligenza Arti’¼üciale Basata su Regole (Rule-Based AI) 2. Intelligenza Arti’¼üciale di Apprendimento Automatico (Machine Learning AI) 3. Intelligenza Arti’¼üciale di Deep Learning (Deep Learning AI) 4. AI Generativa (Generative AI) 5. AI Ibrida (Hybrid AI)

- 14. 1. Intelligenza Arti’¼üciale Basata su Regole ŌŚÅ De’¼ünizione: Utilizza un insieme de’¼ünito di regole e logica per prendere decisioni. ŌŚÅ Esempi: Sistemi esperti, motori di inferenza. ŌŚÅ Caratteristiche: ŌŚÅ Prevedibilit├Ā elevata. ŌŚÅ Limitata alla conoscenza pre-programmata. ŌŚÅ Meno e’¼ācace in ambienti complessi e variabili. ESEMPIO: Sistema Esperto per la Diagnosi Medica ŌŚÅ Funzionamento: ŌŚÅ Base di Conoscenza: Il sistema ├© programmato con una vasta base di conoscenza che include sintomi, segni, diagnosi e trattamenti di varie malattie. ŌŚÅ Motore di Inferenza: Utilizza un insieme di regole logiche per elaborare le informazioni. Ad esempio, se un paziente ha febbre (sintomo) e dolore alla gola (sintomo), il sistema potrebbe inferire un possibile caso di faringite (diagnosi) basandosi sulle regole prede’¼ünite. ŌŚÅ Interfaccia Utente: I medici inseriscono i sintomi e i segni clinici del paziente nell'interfaccia del sistema. Il sistema poi elabora queste informazioni in base alle sue regole.

- 15. 2. Intelligenza Arti’¼üciale di Apprendimento Automatico 15 ŌŚÅ De’¼ünizione: Apprende dai dati per migliorare le sue prestazioni nel tempo. ŌŚÅ Esempi: Classi’¼ücatori, sistemi di raccomandazione. ŌŚÅ Caratteristiche: ŌŚÅ Capacit├Ā di apprendere senza essere esplicitamente programmati. ŌŚÅ Utilizza grandi quantit├Ā di dati per l'apprendimento. ŌŚÅ Pu├▓ adattarsi a nuove situazioni basandosi sull'esperienza. Sistema di Raccomandazione per Streaming ŌŚÅ Funzionamento: ŌŚÅ Raccolta Dati: Il sistema raccoglie dati sulle preferenze e sul comportamento degli utenti, come i ’¼ülm guardati, le valutazioni date, o le canzoni ascoltate. ŌŚÅ Elaborazione e Apprendimento: Utilizza algoritmi di machine learning per analizzare questi dati. Gli algoritmi individuano schemi e preferenze nei comportamenti degli utenti. ŌŚÅ Raccomandazioni Personalizzate: Sulla base di queste analisi, il sistema genera raccomandazioni personalizzate per ogni utente, suggerendo ’¼ülm, serie TV o brani musicali che potrebbero piacere.

- 16. 3. Intelligenza Arti’¼üciale di Deep Learning 16 ŌŚÅ De’¼ünizione: Un sottoinsieme del machine learning che utilizza reti neurali profonde. ŌŚÅ Esempi: Riconoscimento vocale, visione arti’¼üciale. ŌŚÅ Caratteristiche: ŌŚÅ Capacit├Ā di elaborare e interpretare dati complessi (es. immagini, linguaggio). ŌŚÅ Richiede grandi quantit├Ā di dati per l'e’¼ācacia. ŌŚÅ Pu├▓ identi’¼ücare pattern nascosti nei dati. Esempio: Riconoscimento Facciale in Smartphone ŌŚÅ Funzionamento: ŌŚÅ Acquisizione dell'Immagine: Quando un utente registra il proprio viso, il sistema utilizza la fotocamera per catturare diverse immagini del volto sotto vari angoli e condizioni di illuminazione. ŌŚÅ Elaborazione tramite Reti Neurali Convoluzionali (CNN): Queste immagini vengono poi elaborate da reti neurali convoluzionali, un tipo di rete neurale profonda specializzata nel riconoscere e analizzare le caratteristiche visive. ŌŚÅ Estrazione delle Caratteristiche: Il sistema estrae caratteristiche uniche del viso, come la forma degli occhi, il naso, la bocca, e il contorno del volto. ŌŚÅ Confronto e Veri’¼üca: Ogni volta che l'utente tenta di sbloccare il telefono, il sistema cattura un'immagine in tempo reale e la confronta con il modello salvato, veri’¼ücando l'identit├Ā.

- 17. 4. AI Generativa 17 ŌŚÅ De’¼ünizione: Crea nuovi contenuti o dati che non esistevano prima. ŌŚÅ Esempi: GPT (Generative Pre-trained Transformer), DALL-E per la generazione di immagini. ŌŚÅ Caratteristiche: ŌŚÅ Capacit├Ā di generare contenuti originali e creativi. ŌŚÅ Usa tecniche come reti generative avversarie (GANs) e modelli di trasformazione. ŌŚÅ Utile in applicazioni creative e innovative. Creazione di Arte Digitale con GANs ŌŚÅ Funzionamento: ŌŚÅ Addestramento: Le GANs vengono addestrate con un vasto dataset di immagini d'arte, apprendendo vari stili e tecniche. ŌŚÅ Generazione e Confronto: Una parte della rete, il generatore, crea nuove immagini. Un'altra parte, il discriminatore, valuta queste immagini confrontandole con quelle reali, fornendo feedback al generatore. ŌŚÅ A’¼ānamento Continuo: Il generatore continua a migliorare le sue creazioni ’¼üno a quando il discriminatore non riesce pi├╣ a distinguere le immagini generate da quelle reali. Occhio a questa che vi frega il lavoro ŌĆ” o ve lo potenzia. Poi ci torniamo ŌĆ”

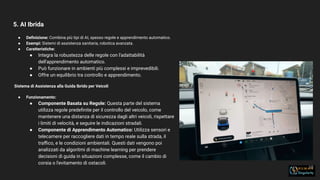

- 18. 5. AI Ibrida 18 ŌŚÅ De’¼ünizione: Combina pi├╣ tipi di AI, spesso regole e apprendimento automatico. ŌŚÅ Esempi: Sistemi di assistenza sanitaria, robotica avanzata. ŌŚÅ Caratteristiche: ŌŚÅ Integra la robustezza delle regole con l'adattabilit├Ā dell'apprendimento automatico. ŌŚÅ Pu├▓ funzionare in ambienti pi├╣ complessi e imprevedibili. ŌŚÅ Offre un equilibrio tra controllo e apprendimento. Sistema di Assistenza alla Guida Ibrido per Veicoli ŌŚÅ Funzionamento: ŌŚÅ Componente Basata su Regole: Questa parte del sistema utilizza regole prede’¼ünite per il controllo del veicolo, come mantenere una distanza di sicurezza dagli altri veicoli, rispettare i limiti di velocit├Ā, e seguire le indicazioni stradali. ŌŚÅ Componente di Apprendimento Automatico: Utilizza sensori e telecamere per raccogliere dati in tempo reale sulla strada, il tra’¼āco, e le condizioni ambientali. Questi dati vengono poi analizzati da algoritmi di machine learning per prendere decisioni di guida in situazioni complesse, come il cambio di corsia o l'evitamento di ostacoli.

- 19. 6. AGI: non esiste ancora e non ├© un mostro cattivo che distrugger├Ā il mondo 19 ŌŚÅ De’¼ünizione: Combina pi├╣ tipi di AI, spesso regole e apprendimento automatico. ŌŚÅ Esempi: Sistemi di assistenza sanitaria, robotica avanzata. ŌŚÅ Caratteristiche: ŌŚÅ Integra la robustezza delle regole con l'adattabilit├Ā dell'apprendimento automatico. ŌŚÅ Pu├▓ funzionare in ambienti pi├╣ complessi e imprevedibili. ŌŚÅ Offre un equilibrio tra controllo e apprendimento. Sistema di Assistenza alla Guida Ibrido per Veicoli ŌŚÅ Funzionamento: ŌŚÅ Componente Basata su Regole: Questa parte del sistema utilizza regole prede’¼ünite per il controllo del veicolo, come mantenere una distanza di sicurezza dagli altri veicoli, rispettare i limiti di velocit├Ā, e seguire le indicazioni stradali. ŌŚÅ Componente di Apprendimento Automatico: Utilizza sensori e telecamere per raccogliere dati in tempo reale sulla strada, il tra’¼āco, e le condizioni ambientali. Questi dati vengono poi analizzati da algoritmi di machine learning per prendere decisioni di guida in situazioni complesse, come il cambio di corsia o l'evitamento di ostacoli.

- 20. Allineamento Il concetto di allineamento nell'intelligenza artificiale (AI), in particolare nelle AI di livello generale (AGI, Artificial General Intelligence), riguarda la sfida di garantire che queste intelligenze avanzate abbiano obiettivi, valori e decisioni che siano in armonia con gli interessi e il benessere umano. Il problema dell'allineamento ├© fondamentale perch├®, man mano che le capacit├Ā delle AGI si avvicinano o superano l'intelligenza umana in un'ampia gamma di compiti, diventa cruciale assicurarsi che le loro azioni non risultino involontariamente dannose per l'umanit├Ā.

- 21. Superallineamento Superallinamento, o superintelligenza, si riferisce a un potenziale stadio futuro in cui un'AGI avrebbe capacit├Ā cognitive che superano di gran lunga quelle di qualsiasi essere umano in quasi tutti gli aspetti significativi, come la creativit├Ā, il ragionamento generale, e l'apprendimento. Una tale intelligenza potrebbe migliorare autonomamente le proprie capacit├Ā in modi che noi non possiamo prevedere o controllare facilmente.

- 22. La gestione di unŌĆÖintelligenza superiore ŌŚÅ Incomprensibilit├Ā delle Decisioni: Come gli umani spesso faticano a comprendere il processo decisionale di intelligenze inferiori (come gli animali), potremmo trovarci in difficolt├Ā a comprendere le decisioni o le motivazioni di un'AGI superintelligente. ŌŚÅ Divergenza degli Obiettivi: Esiste il rischio che, nonostante gli sforzi di allineamento, le priorit├Ā di un'AGI divergano da quelle umane, portando a risultati non intenzionali o addirittura pericolosi. ŌŚÅ Rapidit├Ā dell'Evoluzione: La capacit├Ā di un'AGI di migliorare se stessa potrebbe far s├¼ che evolva cos├¼ rapidamente da sfuggire al controllo umano, rendendo obsoleto qualsiasi tentativo di guida o correzione.

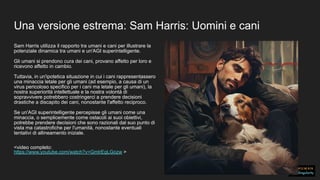

- 23. Una versione estrema: Sam Harris: Uomini e cani Sam Harris utilizza il rapporto tra umani e cani per illustrare la potenziale dinamica tra umani e un'AGI superintelligente. Gli umani si prendono cura dei cani, provano affetto per loro e ricevono affetto in cambio. Tuttavia, in un'ipotetica situazione in cui i cani rappresentassero una minaccia letale per gli umani (ad esempio, a causa di un virus pericoloso specifico per i cani ma letale per gli umani), la nostra superiorit├Ā intellettuale e la nostra volont├Ā di sopravvivere potrebbero costringerci a prendere decisioni drastiche a discapito dei cani, nonostante l'affetto reciproco. Se un'AGI superintelligente percepisse gli umani come una minaccia, o semplicemente come ostacoli ai suoi obiettivi, potrebbe prendere decisioni che sono razionali dal suo punto di vista ma catastrofiche per l'umanit├Ā, nonostante eventuali tentativi di allineamento iniziale. <video completo: https://www.youtube.com/watch?v=GmlrEgLGozw >

- 24. Agenti ŌĆ” che sostituiscono lavori Gli agenti nell'ambito dell'intelligenza artificiale (AI) si riferiscono a sistemi o software dotati di autonomia che possono percepire il loro ambiente attraverso sensori e agire su quell'ambiente attraverso attuatori per raggiungere determinati obiettivi o compiti. Questi agenti possono variare in complessit├Ā da semplici agenti statici, che seguono regole predefinite, a complessi agenti intelligenti, che possono apprendere, adattarsi e prendere decisioni in modo autonomo.

- 25. Spiegazione delle principali differenze ŌŚÅ Complessit├Ā crescente: Dall'AI basata su regole all'AI generativa, la complessit├Ā e la capacit├Ā di gestire dati e contesti complessi aumentano. ŌŚÅ Autonomia e Apprendimento: Mentre l'AI basata su regole dipende da input prede’¼üniti, il machine learning e il deep learning si adattano e imparano autonomamente. ŌŚÅ Creativit├Ā e Innovazione: L'AI generativa spicca per la sua capacit├Ā di creare contenuti nuovi e originali, aprendo strade per applicazioni creative.

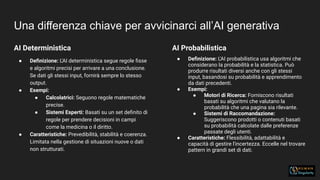

- 26. Una differenza chiave per avvicinarci allŌĆÖAI generativa AI Deterministica ŌŚÅ De’¼ünizione: L'AI deterministica segue regole ’¼üsse e algoritmi precisi per arrivare a una conclusione. Se dati gli stessi input, fornir├Ā sempre lo stesso output. ŌŚÅ Esempi: ŌŚÅ Calcolatrici: Seguono regole matematiche precise. ŌŚÅ Sistemi Esperti: Basati su un set de’¼ünito di regole per prendere decisioni in campi come la medicina o il diritto. ŌŚÅ Caratteristiche: Prevedibilit├Ā, stabilit├Ā e coerenza. Limitata nella gestione di situazioni nuove o dati non strutturati. AI Probabilistica ŌŚÅ De’¼ünizione: L'AI probabilistica usa algoritmi che considerano la probabilit├Ā e la statistica. Pu├▓ produrre risultati diversi anche con gli stessi input, basandosi su probabilit├Ā e apprendimento da dati precedenti. ŌŚÅ Esempi: ŌŚÅ Motori di Ricerca: Forniscono risultati basati su algoritmi che valutano la probabilit├Ā che una pagina sia rilevante. ŌŚÅ Sistemi di Raccomandazione: Suggeriscono prodotti o contenuti basati su probabilit├Ā calcolate dalle preferenze passate degli utenti. ŌŚÅ Caratteristiche: Flessibilit├Ā, adattabilit├Ā e capacit├Ā di gestire l'incertezza. Eccelle nel trovare pattern in grandi set di dati.

- 27. AI Probabilistica Generativa Perch├© ├© spuntata come un fungo? 27 ŌŚÅ Avanzamenti in Deep Learning: L'uso di reti neurali profonde ha permesso un trattamento pi├╣ so’¼üsticato dei dati, rendendo l'AI pi├╣ capace di generare contenuti complessi e realistici. ŌŚÅ Maggiore Disponibilit├Ā di Dati: L'aumento della quantit├Ā e variet├Ā di dati ha fornito il "materiale" necessario per allenare modelli pi├╣ avanzati. ŌŚÅ Aumento della Potenza di Calcolo: Progressi nell'hardware hanno permesso di eseguire modelli di deep learning pi├╣ complessi in tempi ragionevoli. ŌŚÅ Aumento smisurato delle risorse economiche: quanto cosa un giorno di ŌĆ£allenamentoŌĆØ di GPT4? ŌŚÅ Innovazioni nei Modelli di Apprendimento: Come le reti generative avversarie (GANs) e i modelli trasformativi, che hanno rivoluzionato la creazione di immagini, testo e audio. ŌŚÅ Perch├® ├ł Importante per i Creativi ŌŚÅ L'AI probabilistica generativa apre nuove frontiere nella creativit├Ā digitale, offrendo strumenti che possono assistere nella progettazione gra’¼üca, nella creazione di contenuti multimediali, e persino nell'arte e nel design. Questi strumenti non sostituiscono la creativit├Ā umana, ma la ampli’¼ücano, permettendo ai professionisti di esplorare nuove possibilit├Ā che erano impensabili solo pochi anni fa.

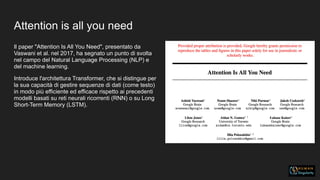

- 28. EŌĆÖ tutta colpa dei Transformer 28 Cosa diavolo sono?: Il modello transformer, introdotto nel 2017 da Vaswani et al., ├© un'architettura di rete neurale progettata per l'elaborazione del linguaggio naturale (NLP). In cosa hanno cambiato il gioco: ŌŚÅ Attenzione: La caratteristica principale dei transformer ├© il meccanismo di attenzione, che consente al modello di ponderare l'importanza di diverse parti di un input (ad esempio, parole in una frase) in base al contesto. ŌŚÅ Elaborazione Parallela: A differenza delle architetture precedenti, i transformer elaborano tutti i token (es. parole) contemporaneamente, migliorando notevolmente l'e’¼ācienza. Impatto sui Modelli Generativi ŌŚÅ Elaborazione del Linguaggio Naturale: Prima dei transformer, le reti neurali facevano fatica a comprendere e generare testi lunghi e complessi. I transformer hanno permesso un salto di qualit├Ā nella comprensione del linguaggio e nella generazione di testo. ŌŚÅ Applicazioni Creative: Hanno aperto la strada a nuove applicazioni nel campo della creativit├Ā digitale, come la scrittura assistita, la generazione automatica di testo e persino la composizione musicale. ŌŚÅ Elaborazione Uni’¼ücata: I Transformer sono in grado di elaborare vari tipi di input (testo, immagini, ecc.) in un formato uni’¼ücato. Questo ├© reso possibile dal loro meccanismo di attenzione, che pu├▓ essere applicato a diversi tipi di dati oltre al testo. ŌŚÅ

- 29. Versatilit├Ā dei Transformer 29 ŌŚÅ Elaborazione Uni’¼ücata: I Transformer sono in grado di elaborare vari tipi di input (testo, immagini, ecc.) in un formato uni’¼ücato. Questo ├© reso possibile dal loro meccanismo di attenzione, che pu├▓ essere applicato a diversi tipi di dati oltre al testo. ŌŚÅ Modelli Multimodali: Alcuni modelli basati su Transformer, come DALL-E di OpenAI, sono stati speci’¼ücamente progettati per lavorare con testi e immagini contemporaneamente, creando rappresentazioni uni’¼ücate dei dati. ŌŚÅ Ampio Apprendimento da dati non strutturati: I Transformer possono apprendere da enormi set di dati non strutturati, come le immagini su internet o i video su piattaforme di streaming. Questo li rende incredibilmente potenti nel catturare e generare rappresentazioni realistiche e creative di dati complessi. ŌŚÅ Adattabilit├Ā: La capacit├Ā di adattarsi a diversi tipi di dati signi’¼üca che i Transformer possono essere utilizzati in una vasta gamma di applicazioni, dalla generazione di arte alla creazione di contenuti multimediali. ŌŚÅ Capacit├Ā di Elaborazione esponenziale: Con l'aumento della potenza computazionale e la disponibilit├Ā di enormi set di dati, i modelli basati su Transformer sono cresciuti in termini di dimensioni e capacit├Ā. Questo ha portato a miglioramenti signi’¼ücativi nella loro e’¼ācienza e nella qualit├Ā dell'output generativo. ŌŚÅ Innovazioni Accelerate: La combinazione di queste tecnologie avanzate ha portato a un ciclo di innovazione e miglioramento che si autoalimenta, dove ogni progresso in un'area (come l'hardware o gli algoritmi) ampli’¼üca i progressi in altre aree.

- 30. Attention is all you need Il paper "Attention Is All You Need", presentato da Vaswani et al. nel 2017, ha segnato un punto di svolta nel campo del Natural Language Processing (NLP) e del machine learning. Introduce l'architettura Transformer, che si distingue per la sua capacit├Ā di gestire sequenze di dati (come testo) in modo pi├╣ efficiente ed efficace rispetto ai precedenti modelli basati su reti neurali ricorrenti (RNN) o su Long Short-Term Memory (LSTM).

- 31. Ultimo sforzo Cosa sono gli LLM (Large Language Models) 31 ŌŚÅ De’¼ünizione: Gli LLM sono modelli di linguaggio di grandi dimensioni basati sull'architettura transformer. Sono addestrati su vasti corpora di testo per apprendere a comprendere e generare linguaggio umano. ŌŚÅ Esempi: GPT (Generative Pretrained Transformer) di OpenAI e BART di Google sono esempi di LLM. ŌŚÅ Capacit├Ā: Gli LLM possono generare testo coerente, rispondere a domande, sintetizzare informazioni, e persino creare contenuto creativo come poesie o testi per canzoni. Perch├® Sono Importanti per la Generative AI ŌŚÅ Innovazione nel Generare Contenuti: Gli LLM hanno radicalmente migliorato la capacit├Ā delle macchine di generare testo creativo e coerente, aprendo nuove possibilit├Ā in campi come la scrittura, la pubblicit├Ā e i media. ŌŚÅ Interazione Avanzata: Consentono un'interazione pi├╣ naturale e ’¼éuida tra utenti e sistemi basati sull'AI, rendendo queste tecnologie pi├╣ accessibili e utili in una variet├Ā di applicazioni creative.

- 32. Perch├® Gli LLM Sono Auto-Regressivi 32 ŌŚÅ Generazione di Testo Sequenziale: Gli LLM auto-regressivi generano testo un pezzo alla volta (ad esempio, una parola per volta). Ogni nuova parola generata si basa su tutte le parole precedenti nella sequenza. In sostanza, il modello "ricorda" ci├▓ che ha gi├Ā generato e utilizza queste informazioni per decidere cosa produrre dopo. ŌŚÅ Utilizzo del Contesto: Questa capacit├Ā di considerare il contesto passato rende gli LLM particolarmente e’¼ācaci nel produrre testi che sono coerenti e ’¼éuiscono logicamente da ci├▓ che ├© stato detto prima. Auto-regressione in LLM ŌŚÅ Sequenzialit├Ā: In un modello auto-regressivo, ogni nuova parola (o token) generata in una sequenza dipende da tutte le parole (o token) generate prima di essa. ŌŚÅ Dipendenza dai Precedenti: Il modello "guarda indietro" alle parole precedentemente prodotte per prevedere la prossima parola nella sequenza. In altre parole, la generazione di ciascuna nuova parola ├© una "regressione" basata sul contesto fornito dalle parole precedenti. Come Funziona Inizio della Sequenza: Il modello inizia con un input iniziale, che pu├▓ essere una parola, una frase o anche solo un prompt vuoto. Predizione della Parola Successiva: Basandosi su questo input, il modello usa ci├▓ che ha appreso durante l'addestramento per prevedere quale dovrebbe essere la parola successiva nella sequenza. Iterazione: Questo processo viene ripetuto per ogni nuova parola aggiunta, con il modello che considera l'intera sequenza ’¼üno a quel punto per fare la sua prossima previsione. Memento boomer: la risposta ├© dentro di te ŌĆ” e per├▓ ├© sbagliata

- 33. 33 Punti di Forza degli LLM ŌŚÅ Coerenza e Fluenza nel Testo: Grazie alla loro natura auto-regressiva, gli LLM sono bravi a mantenere coerenza e ’¼éuenza nel testo. Possono continuare una storia o un argomento in modo logico e coerente. ŌŚÅ Creativit├Ā e Versatilit├Ā: Possono generare una vasta gamma di contenuti, da articoli informativi a poesie, dimostrando una notevole ’¼éessibilit├Ā. ŌŚÅ Capacit├Ā di Apprendimento: Sono capaci di imparare e adattarsi a vari stili di scrittura e argomenti grazie all'ampia gamma di testi su cui vengono addestrati. Limiti degli LLM ŌŚÅ Mancanza di Comprensione Profonda: Nonostante la loro e’¼ācienza nel generare testo, gli LLM non "comprendono" il testo nel modo in cui lo farebbe un essere umano. La loro generazione si basa su pattern e statistiche piuttosto che su una vera comprensione. ŌŚÅ Bias nei Dati: Gli LLM possono replicare o ampli’¼ücare i bias presenti nei dati su cui vengono addestrati. Questo pu├▓ portare a problemi di equit├Ā o accuratezza. ŌŚÅ Di’¼ācolt├Ā con Fatti e Dettagli Speci’¼üci: Possono lottare nel gestire informazioni speci’¼üche o attuali, soprattutto se tali informazioni non erano presenti o erano rare nel set di dati di addestramento. ŌŚÅ Generazione di Contenuti Non A’¼ādabili: In alcuni casi, possono generare informazioni convincenti ma inesatte o fuorvianti.

- 34. LI POSSIAMO USARE PER: Sostegno nella scrittura, produzione di bozze, raffinamento stilistico. Guida nella scrittura del codice. Siamo facilmente sedotti dalla loro chiarezza. Tuttavia, non comprendono la realt├Ā del mondo. I Large Language Models di tipo Auto-Regressivo mostrano una doppia natura. NON SONO INDICATI PER: Dare risposte precise e omogenee (allucinazioni!) Tenere conto delle novit├Ā (anteriori all'ultima formazione) Agire correttamente (riproducono comportamenti dell'insieme formativo) Pensare, progettare, fare aritmetica Impiegare "tools", come motori di ricerc calcolatrici, interrogazioni su database..

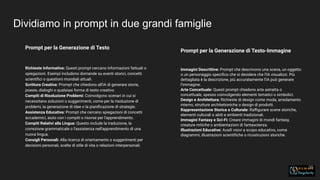

- 35. Dividiamo in prompt in due grandi famiglie 35 Prompt per la Generazione di Testo Richieste Informative: Questi prompt cercano informazioni fattuali o spiegazioni. Esempi includono domande su eventi storici, concetti scienti’¼üci o questioni mondiali attuali. Scrittura Creativa: Prompt che chiedono all'IA di generare storie, poesie, dialoghi o qualsiasi forma di testo creativo. Compiti di Risoluzione Problemi: Coinvolgono scenari in cui si necessitano soluzioni o suggerimenti, come per la risoluzione di problemi, la generazione di idee o la piani’¼ücazione di strategie. Assistenza Educativa: Prompt che cercano spiegazioni di concetti accademici, aiuto con i compiti o risorse per l'apprendimento. Compiti Relativi alla Lingua: Questo include la traduzione, la correzione grammaticale o l'assistenza nell'apprendimento di una nuova lingua. Consigli Personali: Alla ricerca di orientamento o suggerimenti per decisioni personali, scelte di stile di vita o relazioni interpersonali. Prompt per la Generazione di Testo-Immagine Immagini Descrittive: Prompt che descrivono una scena, un oggetto o un personaggio speci’¼üco che si desidera che l'IA visualizzi. Pi├╣ dettagliata ├© la descrizione, pi├╣ accuratamente l'IA pu├▓ generare l'immagine. Arte Concettuale: Questi prompt chiedono arte astratta o concettuale, spesso coinvolgendo elementi tematici o simbolici. Design e Architettura: Richieste di design come moda, arredamento interno, strutture architettoniche o design di prodotti. Rappresentazione Storica o Culturale: Ra’¼āgurare scene storiche, elementi culturali o abiti e ambienti tradizionali. Immagini Fantasy e Sci-Fi: Creare immagini di mondi fantasy, creature mitiche o ambientazioni di fantascienza. Illustrazioni Educative: Ausili visivi a scopo educativo, come diagrammi, illustrazioni scienti’¼üche o ricostruzioni storiche.

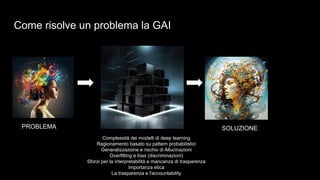

- 36. Come risolve un problema la GAI PROBLEMA SOLUZIONE Complessit├Ā dei modelli di deep learning Ragionamento basato su pattern probabilistici Generalizzazione e rischio di Allucinazioni Overfitting e bias (discriminazioni) Sforzi per la interpretabilit├Ā e mancanza di trasparenza Importanza etica La trasparenza e l'accountability

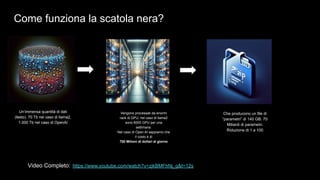

- 37. Come funziona la scatola nera? UnŌĆÖimmensa quantit├Ā di dati (testo). 70 Tb nel caso di llama2, 1.000 Tb nel caso di OpenAI Che producono un file di ŌĆ£parametriŌĆØ di 140 GB. 70 Miliardi di parametri. Riduzione di 1 a 100 Vengono processati da enormi rack di GPU, nel caso di llama2 sono 6000 GPU per una settimana. Nel caso di Open AI sappiamo che il costo ├© di 700 Milioni di dollari al giorno Video Completo: https://www.youtube.com/watch?v=zjkBMFhNj_g&t=12s

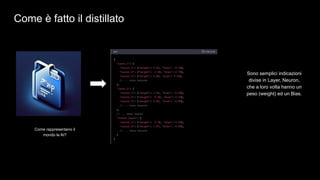

- 38. Un super distillato di dati ed un codice semplice Vengono interpretate da un ridotto codice di 500 linee di C. (unŌĆÖemail ├© tra 500 e 1000 linee) Che producono un file di ŌĆ£parametriŌĆØ di 140 GB. 70 Miliardi di parametri. Riduzione di 1 a 100

- 39. Come ├© fatto il distillato Sono semplici indicazioni divise in Layer, Neuron, che a loro volta hanno un peso (weight) ed un Bias. Come rappresentano il mondo le AI?

- 40. Supersemplificando Rete Neurale: Immagina una rete neurale come un ufficio molto complesso in cui entra dell'informazione (in questo caso, dati) che deve essere elaborata per prendere una decisione o raggiungere una conclusione. Layer (Strati): Questi sono come diversi reparti all'interno dell'ufficio. Ogni reparto (o strato) ha una parte specifica del lavoro da elaborare riguardo le informazioni in arrivo. In una rete neurale, hai pi├╣ strati attraverso i quali passano i dati, e ogni strato successivo impara a riconoscere schemi sempre pi├╣ complessi basandosi sull'output del precedente. Neurons (Neuroni): All'interno di ogni reparto, hai dei lavoratori (neuroni). Proprio come i lavoratori in un ufficio, ognuno ├© responsabile di gestire una piccola parte del compito. In una rete neurale, i neuroni sono le unit├Ā di elaborazione di base che lavorano insieme per processare i dati in ingresso e produrre un risultato. Weight (Pesi): Pensa ai pesi come alla quantit├Ā di attenzione o importanza che un lavoratore (neurone) d├Ā alle informazioni che riceve. Se il peso ├© alto, significa che il lavoratore considera quella informazione molto importante per prendere una decisione. Se ├© basso, l'informazione non ├© cos├¼ influente. Bias: Questo pu├▓ essere visto come lo stile di lavoro personale o l'inclinazione di ogni lavoratore (neurone). ├ł una sorta di regolazione o filtro che applicano alla loro parte di lavoro in base alla propria prospettiva. In una rete neurale, il bias consente ai neuroni di considerare l'input sufficientemente significativo da passarlo al reparto successivo. Quando l'ufficio (rete neurale) riceve un nuovo compito (dati in ingresso), ogni reparto (strato) elabora le informazioni, con i lavoratori (neuroni) che si concentrano su aspetti diversi secondo il loro ruolo (pesi e bias). Il reparto finale produce il risultato (dati in uscita), che ├© il frutto del lavoro dell'intero ufficio sul compito. Nel contesto di un modello di linguaggio, tutto questo processo viene utilizzato per comprendere e generare testo: l'"ufficio" elabora le parole in ingresso e decide quale dovrebbe essere la prossima in una frase.

- 41. Che informazioni vengono mantenute nel passaggio? Schemi e Strutture: Il modello mantiene schemi statistici, strutture e relazioni trovate nei dati. Ci├▓ include la grammatica, frasi comuni, associazioni di parole e regole sintattiche. Conoscenza Generale: Fatti, conoscenze comuni e informazioni che si verificano frequentemente nel dataset sono codificate nei parametri. Modelli Linguistici: Le regole semantiche e sintattiche della lingua, che consentono al modello di costruire risposte coerenti e contestualmente appropriate. Concetti e Idee: Concetti astratti, idee e le relazioni tra di loro che sono necessari per comprendere e generare testo relativamente a vari argomenti. Capacit├Ā di Inferenza: La capacit├Ā del modello di fare inferenze o previsioni su informazioni mancanti in un prompt, basate sugli schemi che ha appreso. Variazioni Stilistiche: Sebbene non ogni sfumatura stilistica sia mantenuta, il modello cattura una gamma di stili di scrittura sufficienti a generare testi diversi e plausibili.

- 42. Cosa viene perso nel passaggio? Istanze di Dati Specifici: I dettagli esatti e le specificit├Ā dei dati di addestramento non vengono mantenuti. Esempi individuali, come frasi specifiche, paragrafi o documenti, non sono conservati nei parametri. Ridondanze: Qualsiasi informazione ridondante nel dataset, che potrebbe includere frasi ripetute o conoscenze comuni, non ├© replicata nei parametri del modello. Dati Rumorosi: Anomalie o errori nei dati che non contribuiscono agli schemi generali che il modello dovrebbe imparare vengono idealmente filtrati durante l'addestramento. Caratteristiche di Basso Livello: Caratteristiche stilistiche dettagliate o idiosincrasie di autori o fonti particolari potrebbero non essere conservate a meno che non contribuiscano alla comprensione della lingua da parte del modello. Tutto quello che riguarda la marca, i valori, lŌĆÖetica e la cultura di unŌĆÖazienda o di una marca, vengono persi nel passaggio. Se vogliamo che la AI rappresenti la nostra azienda, dobbiamo ricostruirli.

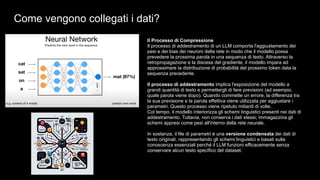

- 43. Come vengono collegati i dati? Il Processo di Compressione Il processo di addestramento di un LLM comporta l'aggiustamento dei pesi e dei bias dei neuroni della rete in modo che il modello possa prevedere la prossima parola in una sequenza di testo. Attraverso la retropropagazione e la discesa del gradiente, il modello impara ad approssimare la distribuzione di probabilit├Ā del prossimo token data la sequenza precedente. Il processo di addestramento implica l'esposizione del modello a grandi quantit├Ā di testo e permettergli di fare previsioni (ad esempio, quale parola viene dopo). Quando commette un errore, la differenza tra la sua previsione e la parola effettiva viene utilizzata per aggiustare i parametri. Questo processo viene ripetuto miliardi di volte. Col tempo, il modello interiorizza gli schemi linguistici presenti nei dati di addestramento. Tuttavia, non conserva i dati stessi; immagazzina gli schemi appresi come pesi all'interno della rete neurale. In sostanza, il file di parametri ├© una versione condensata dei dati di testo originali, rappresentando gli schemi linguistici e basati sulla conoscenza essenziali perch├® il LLM funzioni efficacemente senza conservare alcun testo specifico del dataset.

- 44. Q* Il modello Q*, menzionato in recenti dispute riguardanti OpenAI, si riferisce a un presunto nuovo metodo per creare sistemi di intelligenza artificiale potenti. Secondo quanto riportato, questo modello sarebbe in grado di eseguire calcoli matematici a livello di scuola elementare, e alcune persone in OpenAI ritengono che questo potrebbe rappresentare una pietra miliare nella ricerca dell'intelligenza artificiale generale (AGI). In termini di qualit├Ā, il termine "qualitative" nel contesto di Q* pu├▓ riferirsi alla capacit├Ā di comprendere e manipolare concetti concreti e astratti, un'abilit├Ā che ├© fondamentale per risolvere problemi matematici, che a loro volta richiedono una certa capacit├Ā di pianificazione e ragionamento logico oltre pi├╣ passaggi. Riuscire ad aggiungere un parametro qualitativo, risparmierebbe allŌĆÖAI un enorme sforzo, anzich├® ŌĆ£andare per tentativiŌĆØ, avrebbe la capacit├Ā di valutare lŌĆÖesito di ogni tentativo, risparmiando unŌĆÖenorme quantit├Ā di risorse. Fino a 100.000 volte pi├╣ potente

- 45. In conclusione, abbiamo parlato di ŌĆ” Introduzione alle Diverse Tipologie di AI: Esplorazione dell'AI basata su regole, dell'apprendimento automatico, del deep learning, dell'AI generativa e ibrida. Focus sull'AI Generativa: Discussione sull'AI generativa, le sue capacit├Ā e applicazioni, incluse le innovazioni nei modelli di apprendimento come le GANs e i modelli trasformativi. Importanza dei Large Language Models (LLM): Spiegazione dei LLM, il loro ruolo nell'AI generativa, e la loro importanza nell'innovazione del generare contenuti. Approfondimento sui Transformer e LLM Auto-Regressivi: Analisi del modello transformer, la sua rilevanza per i LLM e il loro impatto sulla generazione di contenuti. Potenziale e Limiti dell'AI Generativa: Discussione sulla doppia natura degli LLM auto-regressivi, i loro punti di forza e limiti, inclusi i problemi di bias e mancanza di comprensione profonda. Implicazioni Etiche e Filosofiche: Riflessione sulle implicazioni etiche e filosofiche dell'uso dell'AI, enfatizzando la responsabilit├Ā umana nel suo sviluppo e impiego. Sviluppo e Futuro dell'AI Generativa: Prospettive sul futuro dell'AI generativa, sottolineando i progressi recenti e le potenziali implicazioni future, come nel caso del modello Q* di OpenAI.

- 46. Ho chiesto a ChatGPT di farsi delle domande Come vengono gestiti i problemi di bias nei modelli di AI generativa? Qual ├© il potenziale impatto sociale e lavorativo dell'AI generativa? Come si possono affrontare le sfide etiche legate all'uso dell'AI generativa? In che modo i Large Language Models differiscono dai modelli di AI tradizionali? Quali sono gli aspetti legali relativi alla propriet├Ā intellettuale generata dall'AI? Come si prevede che l'AI generativa si evolver├Ā nei prossimi anni? Quali sono i limiti attuali dell'AI generativa e come possono essere superati?

- 47. E darsi delle risposte Gestione del Bias nei Modelli di AI Generativa: Il bias nei modelli di AI viene affrontato attraverso diversi metodi, come la cura nella selezione e nella diversificazione dei dati di addestramento, l'analisi dei risultati per identificare e correggere i bias, e l'implementazione di algoritmi per rilevare e mitigare pregiudizi automaticamente. ├ł un processo continuo che richiede attenzione e aggiornamenti costanti. Impatto Sociale e Lavorativo: L'AI generativa pu├▓ portare a significativi cambiamenti nel mercato del lavoro, automatizzando alcune professioni ma creando anche nuove opportunit├Ā in campi come la programmazione, il design e l'analisi dei dati. Socialmente, pu├▓ migliorare l'accessibilit├Ā e personalizzazione di servizi come l'educazione e l'intrattenimento, ma solleva anche questioni sulla privacy e la sicurezza dei dati. Sfide Etiche dell'AI Generativa: Le sfide etiche includono la creazione responsabile e l'utilizzo dell'AI, assicurando che non venga utilizzata per scopi dannosi. ├ł fondamentale sviluppare linee guida etiche e quadri normativi che regolino il suo impiego, specialmente in aree sensibili come la sorveglianza, la manipolazione dei media e la discriminazione.

- 48. E darsi delle risposte Differenze tra LLM e Modelli Tradizionali: I Large Language Models si distinguono per la loro capacit├Ā di elaborare e generare linguaggio umano su ampia scala. A differenza dei modelli tradizionali pi├╣ limitati a compiti specifici, gli LLM possono comprendere e produrre testi complessi, permettendo applicazioni pi├╣ versatili. Aspetti Legali della Propriet├Ā Intellettuale: La propriet├Ā intellettuale generata dall'AI solleva questioni legali riguardanti la titolarit├Ā dei diritti e la responsabilit├Ā per il contenuto prodotto. ├ł un campo in evoluzione, con la necessit├Ā di nuove leggi e regolamentazioni per affrontare queste sfide. Evoluzione Futura dell'AI Generativa: Ci si aspetta che l'AI generativa continui a evolversi, diventando sempre pi├╣ sofisticata e capace. Le future innovazioni potrebbero includere maggiore comprensione del contesto, miglioramento nell'interazione uomo-macchina e applicazioni in settori emergenti come la medicina personalizzata e la pianificazione urbana. Limiti Attuali e Superamento: I limiti attuali dell'AI generativa includono la comprensione superficiale del contesto e la difficolt├Ā nel gestire compiti che richiedono intuizione umana o ragionamento complesso. Il superamento di questi limiti richiede ricerche avanzate in apprendimento profondo, elaborazione del linguaggio naturale e integrazione con altre forme di intelligenza artificiale.

- 49. Ora tocca a voi Q&A

- 50. Determinati nell'approccio, coraggiosi nellŌĆÖesecuzione, miglioriamo con ogni interazione. Grazie mille per aver aiutato a dar forma al nostro pensiero con i vostri suggerimenti! Per continuare la conversazione: andrea@humansingularity.it 348 6344420