[NDC17] KubernetesŽ°ú ÍįúŽįúžĄúŽ≤Ą ÍįĄŽč®Ūěą žįćžĖīŽāīÍłį

- 1. seungyong@devsisters.com žė§ žäĻ žö© KubernetesŽ°ú ÍįúŽįúžĄúŽ≤Ą ÍįĄŽč®Ūěą žįćžĖīŽāīÍłį ÍįúŽįúŪĆÄ ŽąĄÍĶ¨Žāė ŪēĄžöĒŪē† ŽēĆ žĄúŽ≤ĄŽ•ľ ŽĚĄžöł žąė žěąÍ≤Ć

- 2. Žāīžö© (Kopub M) ŽįúŪĎúžěź žÜĆÍįú žė§ žäĻ žö© ‚ÄĘ ŪėĄ DEVSISTERS žĄúŽ≤ĄÍįúŽįúžěź ‚ÄĘ Publishing Infra ‚ÄĘ Cookie Run: OvenBreak ‚ÄĘ Cookie Run for Kakao, LINE Cookie Run ‚ÄĘ NEXON ‚Äď Erlang ÍłįŽįėžĚė žĚł Í≤ĆžěĄ Ž≥īžĚīžä§ žĪó žĄúŽ≤Ą ÍįúŽįú ‚ÄĘ žä§ŪÉÄŪäłžóÖ (WeClay) ‚ÄĘ GIST(ÍīĎž£ľÍ≥ľŪēôÍłįžą†žõź) Ūēôžā¨Í≥ľž†ē 1Íłį 2

- 3. ŽćįŽłĆžčúžä§ŪĄįž¶ą žĄúŽ≤ĄŪĆÄ ‚ÄĘ Ž™®ŽĎźÍįÄ DevOps Engineer ‚ÄĘ žĄúŽ≤Ą ÍĶ¨ž°įŽ•ľ žĄ§Í≥ĄŪēėÍ≥†, žĖīŽĖ§ žĖłžĖī, žĖīŽĖ§ žä§ŪÉ̞̥ žďłžßÄ, ŪĒĄŽ°úŪ܆žĹú ÍĶ¨ž°įŽ•ľ žě°Í≥†, ‚ÄĘ Í≤ĆžěĄ ÍłįŪöćžóź žįłžó¨ŪēėÍ≥†, Í≤ĆžěĄ Ž°úžßĀžóź ŽßěŽäĒ žĄúŽ≤Ą žĹĒŽďúŽ•ľ žßúÍ≥†, ‚ÄĘ ÍįúŽįúŽ∂ÄŪĄį ŪĒĄŽ°úŽćēžÖėÍĻĆžßÄ žĄúŽ≤Ą ŽįįŪŹ¨, Ž™®ŽčąŪĄįŽßĀŪēėÍ≥†, žě•žē†Ž•ľ ŽĆÄžĚĎŪēėÍ≥†, ‚ÄĘ Ž≠ĒÍįÄ žēĄžČ¨žöįŽ©ī žÉąŽ°ú ŽßĆŽď§Í≥† (libquic, LogQuery žčúžä§ŪÖú, ‚Ķ) Ūē† žĚľžĚī ŽßéÍ≥† Žč§žĖĎŪēėŽč§ 3

- 4. ŽćįŽłĆžčúžä§ŪĄįž¶ą žĄúŽ≤ĄŪĆÄ ‚ÄĘ žĚīÍ≤Ć ŪėĄžč§ž†ĀžúľŽ°ú ÍįÄŽä•ŪēėŽ†§Ž©ī.. Íłįžą†Ž°ú ŪēīÍ≤įŪē† žąė žěąŽäĒ žĚľžĚÄ Íłįžą†Ž°ú ŪíÄžěź! 4

- 5. Cookie Run: OvenBreak ‚ÄĘ 2016ŽÖĄ 10žõĒ 27žĚľ ž∂úžčú ‚ÄĘ ÍłÄŽ°úŽ≤Ć žõźŽĻĆŽďú 11Íįú žĖłžĖī žßÄžõź ‚ÄĘ 1ž≤úŽßĆ Žč§žöīŽ°úŽďú 5

- 6. Ž¨łž†ú ž†úÍłį žôú ÍįúŽįú žĄúŽ≤ĄŽ•ľ ‚ÄúžįćžĖīŽāīŽäĒ Í≤É‚ÄĚ žĚī ŪēĄžöĒŪĖąŽäĒÍįÄ

- 7. žÉą žĄúŽ≤ĄÍįÄ žú†ž†ÄŽ•ľ ŽßĆŽā† ŽēĆÍĻĆžßÄ 1. Ž¨łž†ú ž†úÍłį DEV STAGE PROD (Live, Real, ..) QA 7 ÍįúŽįú žĄúŽ≤Ą ŪôėÍ≤Ĺ žĄúŽ≤ĄžôÄ ŪĀīŽĚľžĚė ž≤ę ŽßĆŽā® Í≤Äžąė QAžóĒžßÄŽčąžĖī ŪÖĆžä§Ūäł žä§ŪÖĆžĚīžßē žöīžėĀ ŪôėÍ≤ĹÍ≥ľ žú†žā¨ ŽįįŪŹ¨ ž†Ą ŽßąžßÄŽßČ ŪÖĆžä§Ūäł ŪĒĄŽ°úŽćēžÖė žč§ž†ú žú†ž†ÄŽď§žĚī ž†ĎžÜćŪēėŽäĒ žĄúŽ≤Ą žė§Žäė ŽįúŪĎúÍįÄ Žč§Ž£į Í≤É ÍįúŽįúžěźÍįÄ Ž°úžĽ¨žóźžĄú ÍĶ¨ŪėĄžĚĄ ŽßąžĻėŽ©ī,

- 8. Dev žĄúŽ≤Ą ŪēėŽāėŽ•ľ Ž™®ŽĎźÍįÄ ÍįôžĚī žďł žąė žěąžĚĄÍĻĆ? 1. Ž¨łž†ú ž†úÍłį ÍįúŽįú žīąÍłįžóźŽäĒ ‚Äėdev‚Äô žĄúŽ≤Ą ŪēėŽāėŽ•ľ ŽĚĄžõÄ 8

- 9. Dev žĄúŽ≤Ą ŪēėŽāėŽ•ľ Ž™®ŽĎźÍįÄ ÍįôžĚī žďł žąė žěąžĚĄÍĻĆ? 1. Ž¨łž†ú ž†úÍłį Ž°úÍ∑łžĚł žóįŽŹô ŪĆÄ UX ÍįúžĄ† ŪĆÄ Ž°úÍ∑łžĚł žĚłž¶Ě Žį©žčĚ Ž≥ÄÍ≤Ĺ Dev API ŪėłŪôė X žôú žēĪžĚī ŪĀ¨ŽěėžčúŽāėžßÄ?? 9

- 10. Dev žĄúŽ≤Ą ŪēėŽāėŽ•ľ Ž™®ŽĎźÍįÄ ÍįôžĚī žďł žąė žěąžĚĄÍĻĆ? 1. Ž¨łž†ú ž†úÍłį ‚ÄúŽįłŽüįžä§ ŽćįžĚīŪĄįŽ•ľ ŽįĒÍŅĒžēľ ŪēėŽäĒŽćį, Žč§Ž•ł Ž∂ĄŽď§žóźÍ≤Ć žėĀŪĖ•žĚĄ ž£ľÍłį žčęžĖīžöĒ‚ÄĚ ÍįúŽįú ŪôėÍ≤Ĺ žĄúŽ≤ĄÍįÄ ŪēėŽāėŽßĆ žěąžúľŽ©ī Žß§žöį Ž∂ąŪéł 10 ‚ÄúžĚīŽ≤§Ūäł QA ŪēėŽ†§Ž©ī žĄúŽ≤Ą žčúÍįĄžĚĄ ŽĮłŽěėŽ°ú ŽįĒÍŅĒžēľ ŪēėŽäĒŽćį ÍīúžįģžĚĄÍĻĆžöĒ?‚ÄĚ ‚ÄúŽ≤ąžó≠ žěĎžó̥֞ ŪēėÍ≥† žč∂žĚÄŽćį, ŪÖĆžä§Ūäłžö© ŪĀīŽĚľžĚīžĖłŪ䳎•ľ Žß§žĚľ ŽįõÍłį žčęžĖīžöĒ‚ÄĚ

- 11. 1. Ž¨łž†ú ž†úÍłį ÍįúŽįú žĄúŽ≤ĄŽ•ľ ŽĎź ŽĆÄ ŽĚĄžõĆžĄú ŽŹĆŽ†§ žďįžěź! Dev Dev2 Í∑łŽ†áŽč§Ž©ī, 11

- 12. 1. Ž¨łž†ú ž†úÍłį ŪēúŽč¨ ž†ēŽŹĄŽäĒ Ž≤ĄŪÖľžúľŽāė, ŪôėÍ≤Ĺ ŽĎź ÍįúŽ°úŽäĒ Ž∂Äž°Ī. Dev Dev2 Í∑łŽ†áŽč§Ž©ī, ÍįúŽįú žĄúŽ≤ĄŽ•ľ žĄł ŽĆÄ ŽĚĄžõĆžĄú‚Ķ!? Dev3 12

- 13. ‚ÄĘ žčúž†źžóź ŽĒįŽĚľ ŪēĄžöĒŪēú ÍįúŽįú žĄúŽ≤Ą ŪôėÍ≤Ĺ žąėÍįÄ žú†ŽŹôž†Ā ‚ÄĘ ÍįĀÍįĀžĚė ÍįúŽįú žĄúŽ≤ĄÍįÄ žĖīŽĖ§ ‚Äúžó≠Ūē†‚Ä̞̥ ŪēėŽäĒžßÄ Ž™®Ž¶Ą ‚ÄĘ ‚ÄúžĚī žĄúŽ≤ĄŽäĒ ŽąĄÍįÄ žĖīŽĖ§ žö©ŽŹĄŽ°ú žďįÍ≥† žěąŽäĒ žĄúŽ≤ĄžĚľÍĻĆ?‚ÄĚ ‚ÄĘ ‚ÄúŽāīÍįÄ žĚī žĄúŽ≤Ą žć®ŽŹĄ ŽźėŽāė?‚ÄĚ ‚ÄĘ ‚ÄúžĚīž†ú žēą žďįŽäĒ žĄúŽ≤ĄžĚłÍįÄ?‚ÄĚ 1. Ž¨łž†ú ž†úÍłį 13

- 14. ÍĶ¨ŪėĄ ÍįúŽįú žĄúŽ≤ĄŽ•ľ žįćžĖīŽāīŽäĒ žĄúŽĻĄžä§ ŽßĆŽď§Íłį

- 15. ÍĶ¨ŪėĄ žä§Ūéô ‚ÄĘ žõźŪēėŽäĒ žčúž†źžóź žõźŪēėŽäĒ Ž≤Ąž†ĄžĚė žĄúŽ≤Ą ŪôėÍ≤Ş̥ žó¨Žü¨ Íįú ŽĚĄžöł žąė žěąžĖīžēľ Ūē® ‚ÄĘ žĄúŽ≤Ą ŪôėÍ≤ĹžĚė Ž©ĒŪÉÄ ž†ēŽ≥īŽ•ľ žČĹÍ≤Ć ŪôēžĚł ÍįÄŽä•Ūēīžēľ Ūē® ‚ÄĘ žĄúŽ≤ĄžĚė Ž≤Ąž†Ą, Ž™©ž†Ā, ŽĚĄžöī Žā†žßú, ŽĚĄžöī žā¨ŽěĆ ŽďĪŽďĪ 2. ÍĶ¨ŪėĄ 15

- 16. Dev1 DB ÍįúŽįú žĄúŽ≤Ą ÍĶ¨ž°į 2. ÍĶ¨ŪėĄ Logging Infra 16 Dev1 Dev2 DB Dev2 ‚Ķ

- 17. Game Server League Server Scheduler Server App Backoffice (žöīžėĀŪąī) ÍįúŽįú žĄúŽ≤Ą ÍĶ¨ž°į 2. ÍĶ¨ŪėĄ DB Logging Infra žĄúŽ≤Ą ŪôėÍ≤ĹŽ≥Ą Ž∂ĄŽ¶¨ ŪēĄžöĒ 17 Dev1 DB Dev1

- 23. 2. ÍĶ¨ŪėĄ ‚ÄĘ ŽĚĄžöł žĄúŽ≤ĄÍįÄ ŽßéÍ≥†, žĄúŽ≤Ą ÍįĄžóź ŪÜĶžč†ŽŹĄ ŪēĄžöĒ ‚ÄĘ ž∂ĒÍįÄ žĄúŽ≤Ą ŪôėÍ≤ĹžĚī ŪēĄžöĒŪē† ŽēĆŽßąŽč§ žÉą žĄúŽ≤Ą žĚłžä§ŪĄīžä§Ž•ľ? ‚ÄĘ ÍįÄŽä•žĚÄ ŪēėžßÄŽßĆ Ž≥Ķžě°. žĄúŽ≤Ą ÍįúŽįúžěź žĚīžôłŽäĒ žā¨žö©ŪēėÍłį žĖīŽ†§žõÄ ‚ÄĘ Ž™®Žď† žĄúŽ≤Ą žēĪŽď§žĚÄ Dockerized (ŽėźŽäĒ Dockerize ÍįÄŽä•) Container Orchestration Tool žĚĄ žć® Ž≥īžěź! 23

- 24. 2. ÍĶ¨ŪėĄ Container Orchestration? ‚ÄĘ Multi-node Docker (or other containers) Cluster 24 Host Host 1 Host 2 Host N nginx nginx

- 25. 2. ÍĶ¨ŪėĄ Container Orchestration? ‚ÄĘ Scheduling: žÉąŽ°ú ŽĚĄžöł ŽŹĄžĽ§ žĽ®ŪÖĆžĚīŽĄąŽ•ľ žĶúž†ĀžĚė Ž®łžč†žóź ŽĚĄžöįÍłį (ex. ÍįÄžě• Ž©ĒŽ™®Ž¶¨ žÜĆŽĻĄÍįÄ ŽāģžĚÄ Ž®łžč†) 25 Host 1 Host 2 Host N nginx nginx

- 26. 2. ÍĶ¨ŪėĄ Container Orchestration? ‚ÄĘ Scaling: ŽŹĄžĽ§ žĽ®ŪÖĆžĚīŽĄąŽ•ľ (žó¨Žü¨ Ž®łžč†žóź) žó¨Žü¨ ŽĆÄ ŽĚĄžöįÍłį (+ ž£ĹžúľŽ©ī žāīŽ¶¨Íłį) 26 Host 1 Host 2 Host N nginx 3 nginx nginx nginx

- 27. 2. ÍĶ¨ŪėĄ Container Orchestration? ‚ÄĘ Load balancing: ŪäĻž†ē žĄúŽĻĄžä§ žöĒž≤≠žĚĄ žó¨Žü¨ ŽŹĄžĽ§ žĽ®ŪÖĆžĚīŽĄąŽ°ú Ž∂Ąžāį 27Host 1 Host 2 Host N nginx nginx nginx

- 28. 2. ÍĶ¨ŪėĄ Amazon ECS Docker (Swarm mode) Kubernetes Container Orchestration Tool Í≥†Ž•īÍłį 28 X AWS žĚėž°īžĄĪ Ž≥Ķžě°. ÍłįŽä• Ž∂Äžč§ X žč¨ŪĒĆ ÔĀä ÍłįŽä• Ž∂Äž°Ī O

- 29. 2. ÍĶ¨ŪėĄ ‚ÄĘ Google ŽāīŽ∂Ğ󟞥ú žā¨žö©ŪēėŽćė BorgžĚė open source Ž≤Ąž†ľ ‚ÄĘ ŪôúŽįúŪēėÍ≤Ć ÍįúŽįúŽźėÍ≥† žěąŽäĒ ŪĒĄŽ°úž†ĚŪäł ‚ÄĘ žčúžä§ŪÖú ÍĶ¨ž∂ēžóź ž†ĀŪē©Ūēú ÍįĀžĘÖ ÍłįŽä•Žď§ ‚ÄĘ žěźž≤ī DNSŽ•ľ ŪÜĶŪēú ŽāīŽ∂Ä žĄúŽĻĄžä§ discovery ‚ÄĘ Namespace ‚Äď ÍįĀ žĄúŽ≤Ą ŪôėÍ≤ĹŽ≥Ą ŪĀīŽü¨žä§ŪĄį ÍĶ¨Ž∂Ą žö©žĚī ‚ÄĘ GCP(GKE), AzurežóźžĄú managed service ž†úÍ≥Ķ ‚ÄĘ ŪēėžßÄŽßĆ AWS žóźžĄúŽŹĄ ÍįĀžĘÖ Žį©Ž≤ēžúľŽ°ú ÍĶ¨ž∂ē ÍįÄŽä• Kubernetes 29 Container Orchestration Tool Í≥†Ž•īÍłį

- 30. ŽĻ†Ž•īÍ≤Ć žāīŪéīŽ≥īŽäĒ Kubernetes 30 ‚ÄĘ Pod - žĶúžÜĆ Žč®žúĄ (‚Čą docker container) apiVersion: v1 kind: Pod metadata: name: nginx-app label: name: nginx-app spec: containers: - name: nginx-app image: nginx:1.7.9 ports: - containerPort: 80 name: http protocol: TCP Host 1 172.x.x.1 nginx Host 2 172.x.x.2 10.x.x.100:80

- 31. ŽĻ†Ž•īÍ≤Ć žāīŪéīŽ≥īŽäĒ Kubernetes 31 ‚ÄĘ Replica Set ‚Äď Pod Scaler Host 1 172.x.x.1 nginx Host 2 172.x.x.2 10.x.x.100:80 apiVersion: extensions/v1beta1 kind: ReplicaSet metadata: name: nginx-rs spec: replicas: 3 template: metadata: labels: app: nginx-app spec: containers: - name: nginx image: nginx:1.7.9 ports: - containerPort: 80 Host 3 172.x.x.3 nginx 10.x.x.110:80 nginx 10.x.x.120:80

- 32. ŽĻ†Ž•īÍ≤Ć žāīŪéīŽ≥īŽäĒ Kubernetes 32 ‚ÄĘ 2. ÍĶ¨ŪėĄ ‚ÄĘ Service Host 1 172.x.x.1 nginx Host 2 172.x.x.2 10.x.x.100:80 Host 3 172.x.x.3 nginx 10.x.x.110:80 nginx 10.x.x.120:80 Service nginx-svc 10.x.x.130:80 apiVersion: v1 kind: Service metadata: name: nginx-svc spec: type: ClusterIP selector: app: nginx-app ports: - port: 80 name: web-port protocol: TCP

- 33. ŽĻ†Ž•īÍ≤Ć žāīŪéīŽ≥īŽäĒ Kubernetes 33 ‚ÄĘ 2. ÍĶ¨ŪėĄ ‚ÄĘ Service apiVersion: v1 kind: Service metadata: name: nginx-svc spec: type: ClusterIP selector: app: nginx-app ports: - port: 80 name: web-port protocol: TCP

- 34. ŽĻ†Ž•īÍ≤Ć žāīŪéīŽ≥īŽäĒ Kubernetes 34 ‚ÄĘ 2. ÍĶ¨ŪėĄ ‚ÄĘ Service apiVersion: v1 kind: Service metadata: name: nginx-svc spec: type: ClusterIP selector: app: nginx-app ports: - port: 80 name: web-port protocol: TCP Service nginx-svc 10.x.x.130:80 Service Discovery ŪĀīŽü¨žä§ŪĄį ŽāīžóźžĄú (ŽėźŽäĒ ŪĀīŽü¨žä§ŪĄįžĚė DNS addressŽ•ľ ŽįĒŽĚľŽ≥łŽč§Ž©ī) nginx-svc:web-port -> 10.x.x.130:80 žúľŽ°ú resolve ex. curl http://nginx-svc:web-port = curl http://10.x.x.130:80

- 35. ŽĻ†Ž•īÍ≤Ć žāīŪéīŽ≥īŽäĒ Kubernetes 35 ‚ÄĘ 2. ÍĶ¨ŪėĄ ‚ÄĘ Namespace ‚ÄĘ Kubernetes Žāī Ž¶¨žÜƞ䧞Ěė ŽÖľŽ¶¨ž†Ā Ž∂ĄŽ¶¨ Žč®žúĄ (C++ ŽďĪžĚė Í∑łÍ≤ÉÍ≥ľ ŽĻĄžä∑) nginx-svc žĄúŽĻĄžä§žĚė namespaceÍįÄ ‚Äôns1‚Äô, žöĒž≤≠žĚĄ Ž≥īŽāīŽäĒ ŽŹĄžĽ§žĚė namespaceÍįÄ ns1žĚī žēĄŽčąŽĚľŽ©ī (ex. ns2) nginx-svc.ns1:web-port

- 36. Game Server League Server Scheduler Server App Backoffice (žöīžėĀŪąī) Íłįž°ī ÍįúŽįú žĄúŽ≤Ą ÍĶ¨ž°į 2. ÍĶ¨ŪėĄ DB Logging Infra 36 Node ‚Äėdev2‚Äô Node ‚Äėdev1‚Äô

- 37. Namespace ‚Äėdev2‚Äô 2. ÍĶ¨ŪėĄ KubernetesŽ•ľ ž†Āžö©Ūēú žĄúŽ≤Ą ÍĶ¨ž°į Amazon ElastiCache (Redis) Amazon RDS (MySQL) Game Server League Server Scheduler Server Backoffice (žöīžėĀŪąī) Namespace ‚Äėdev1‚Äô 37 Logging Infra

- 38. 2. ÍĶ¨ŪėĄ Kubernetes ž†Āžö©ŪēėÍłį ‚ÄĘ ÍįĀ žĄúŽ≤Ą žĖīŪĒĆŽ¶¨žľÄžĚīžÖėŽď§žĚÄ Ž™®ŽĎź Kubernetes Ž°ú ‚ÄĘ žĄúŽ≤Ą ŪôėÍ≤Ĺ (dev1, dev2, ..)Ž≥Ą namespace žÉĚžĄĪ ‚ÄĘ http://gameserver:80 žúľŽ°ú žöĒž≤≠ ‚ěě ÍįôžĚÄ žĄúŽ≤Ą ŪôėÍ≤ĹžĚė game serverŽ°ú žöĒž≤≠Žź® Game Server League Server Scheduler Server Backoffice (žöīžėĀŪąī) 38

- 39. 2. ÍĶ¨ŪėĄ Kubernetes ž†Āžö©ŪēėÍłį ‚ÄĘ Redis, MySQL ‚ěě AWSžóźžĄú ž†úÍ≥ĶŪēėŽäĒ žĄúŽĻĄžä§ žā¨žö© ‚ÄĘ ÍįĀÍįĀ žĄúŽ≤Ą ŪôėÍ≤ĹŽ≥Ą spaceŽ•ľ Ž∂ĄŽ¶¨Ūē† Žį©Ž≤ē ž°īžě¨ ‚ÄĘ MySQL ‚Äď Database ‚ÄĘ Redis ‚Äď DB number ‚ÄĘ Couchbase ‚ěě Kubernetes ‚ÄĘ Ž≥ĄŽŹĄ žĚłžä§ŪĄīžä§ ÍĶ¨žĄĪ žčú žĄúŽ≤Ą ŪôėÍ≤ĹŽ≥Ą space Ž∂ĄŽ¶¨ Ž∂ąŪéł ‚ěě Kubernetes ÍįĀ žĄúŽ≤Ą ŪôėÍ≤Ĺ namespacežóź containerŽ°ú ŽĚĄžõÄ DB 39

- 40. 2. ÍĶ¨ŪėĄ Kubernetes ž†Āžö©ŪēėÍłį ‚ÄĘ Logging Infra ‚ěě Kubernetes ‚ÄĘ ComponentžôÄ ŽĚĄžöł ŽÖłŽďúÍįÄ ŽßéžĚÄŽćį, ÍįĀÍįĀžĚÄ Ž¶¨žÜƞ䧎•ľ Ž≥ĄŽ°ú žēą žĒÄ (Zookeeper, Kafka, ElasticSearch, Logstash, ..) ‚ÄĘ Ex. Zookeeper: 3ŽĆÄ, Mem 500M, CPU < 5% (1 core) Logging Infra Í≥ĶŪÜĶ 40

- 41. Kubernetes ŪĀīŽü¨žä§ŪĄį ŽĚĄžöįÍłį ‚ÄĘ Managed Cluster Service ‚ÄĘ Google Cloud ‚Äď GKE (Google Container Engine) ‚ÄĘ Azure ‚Äď Azure Container Service ‚ÄĘ AWSŽäĒ žßĀž†Ď ÍĶ¨ž∂ē ŽėźŽäĒ Ž≥ĄŽŹĄžĚė tool žĚīžö© ‚ÄĘ kube-aws, kops, kargo, Tectonic, ‚Ķ https://kubernetes.io/docs/getting-started-guides/#table-of-solutions 2. ÍĶ¨ŪėĄ 41

- 42. Kubernetes ŪĀīŽü¨žä§ŪĄį ŽĚĄžöįÍłį ‚ÄĘ kube-aws ‚ÄĘ CoreOS ‚ÄĘ Flannel ‚ÄĘ Amazon CloudFormation 2. ÍĶ¨ŪėĄ 42

- 43. Kubernetes ŪĀīŽü¨žä§ŪĄįžóź žĄúŽĻĄžä§ ŽĚĄžöįÍłį ‚ÄĘ žú†Ūėē 1. žõĻ žĄúŽĻĄžä§ ‚ÄĘ Game Server, ‚Ķ ‚ÄĘ Non-stateful ‚ÄĘ ReplicaSet Í≥ľ Service žā¨žö© 2. ÍĶ¨ŪėĄ ReplicaSet game-server replicas: 2 Pod game-server-x29fb Pod game-server-a1234 Service game-server 43

- 44. žě†ÍĻź! ŪĀīŽĚľžĚīžĖłŪäłÍįÄ Kubernetes žĄúŽĻĄžä§žóź ž†ĎžÜćŪēėŽ†§Ž©ī NodePort 2. ÍĶ¨ŪėĄ apiVersion: v1 kind: Service metadata: name: nginx-svc spec: type: NodePort selector: app: nginx-app ports: - port: 80 name: http protocol: TCP Worker 1 172.20.7.95 Worker 2 172.20.7.112 nginx nginx service TCP 30035 TCP 30035 44 Ž™®Žď† ŽÖłŽďúžĚė ‚ÄėŪäĻž†ē‚Äô ŪŹ¨Ū䳎°ú ž†ĎžÜćŪēėŽ©ī ŪēīŽčĻ žĄúŽĻĄžä§Ž°ú ŽĚľžöįŪĆÖ

- 45. žě†ÍĻź! ŪĀīŽĚľžĚīžĖłŪäłÍįÄ Kubernetes žĄúŽĻĄžä§žóź ž†ĎžÜćŪēėŽ†§Ž©ī 2. ÍĶ¨ŪėĄ ‚ÄĘ Í∑łŽüľ ŽŹôž†ĀžúľŽ°ú žÉĚžĄĪŽźú ŪŹ¨Ūäł Ž≤ąŪėłŽ•ľ žôłžõĆžēľ ŽźėŽāėžöĒ? (žßĀž†Ď žßÄž†ēžĚī ÍįÄŽä•ŪēėŽāė, ŽĆÄŽěĶ 3ŽßĆŽ≤ą ~ 6ŽßĆŽ≤ąŽĆÄ ŪŹ¨Ū䳎ßĆ žā¨žö© ÍįÄŽä•) ‚ÄĘ Kubernetes worker ŪēėŽāėÍįÄ ž£ĹžúľŽ©ī DNS recordŽäĒ žĖīŽĖĽÍ≤Ć.. ‚ÄĘ Í∑łŽüľ ŪöĆžā¨ Žß̞󟞥ú Ingress ACL Ž™®Žď† ŪŹ¨Ūäł žė§ŪĒąžĚĄ Ūēīžēľ ŪēėŽāėžöĒ? ‚ÄĘ HTTPS žďįÍ≥† žč∂žĚÄŽćį žĚłž¶ĚžĄúŽäĒ Žėź žĖīŽĖĽÍ≤Ć.. 45

- 46. Ingress Controller 2. ÍĶ¨ŪėĄ ReplicaSet game-server replicas: 2 Pod game-server-x29fb Pod game-server-a1234 Service game-server AWS Elastic Load Balancer proxy Service Backoffice backoffice.login-dev.??.com game.login-dev.??.com 46 login-dev žĄúŽ≤ĄŪôėÍ≤Ĺ NodePort

- 47. Kubernetes ŪĀīŽü¨žä§ŪĄįžóź žĄúŽĻĄžä§ ŽĚĄžöįÍłį ‚ÄĘ žú†Ūėē 2. Stateful Service ‚ÄĘ Zookeeper, Kafka, .. ‚ÄĘ Ž≥īŪÜĶ ÍįĀ ÍįúŽ≥Ą pod Ž≥ĄŽ°ú žßĀž†Ď ž†ĎÍ∑ľ ŪēĄžöĒ ‚ÄĘ Pod ŪēėŽāėŽ•ľ ÍįÄžßÄŽäĒ ReplicaSet ŽįŹ Service ÍĶ¨žĄĪ + NodePort ‚ÄĘ KubernetesžĚė Persistent Volume + AWS EBS žĚīžö© 2. ÍĶ¨ŪėĄ 47 Host 1 kafka-1 Amazon EBS Host 2 Host 2 kafka-1 Amazon EBS ReplicaSet zookeeper-1 replicas: 1 Pod zookeeper-1-a1234 Service zookeeper-1 172.x.x.100:42181

- 48. žĄúŽ≤ĄŽ•ľ ŽĚĄžöįŽäĒ žõĻ ŪéėžĚīžßÄ ŽßĆŽď§Íłį ‚ÄĘ žĚīž†ú CLI Ž°ú žĄúŽ≤ĄŽ•ľ ŽĚĄžöł žąė žěąÍ≤Ć ŽźėžóąŽč§! ‚ÄĘ ŪēėžßÄŽßĆ žó¨ž†ĄŪěą Ž∂ąŪéł ‚Äď žĖīŽĖ§ žĄúŽ≤ĄÍįÄ žěąŽäĒžßÄ, ŽąĄÍįÄ ŽĚĄžõ†ŽäĒžßÄ ŽďĪŽďĪ ‚ÄĘ žĄúŽ≤ĄŽ•ľ ŽĚĄžöįÍ≥†, ŽāīŽ¶¨Í≥†, žÉĀŪÉúŽ•ľ ŪôēžĚłŪēėŽäĒ žõĻ ŪéėžĚīžßÄŽ•ľ ŽßĆŽď§žěź 2. ÍĶ¨ŪėĄ 48

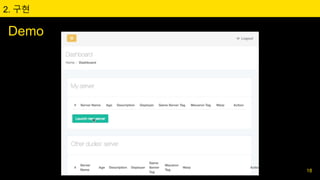

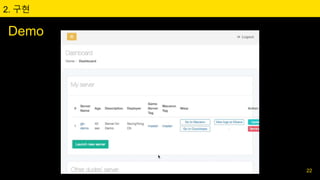

- 49. Stove ‚ÄĘ ÍįúŽįú žĄúŽ≤ĄŽ•ľ ŽĚĄžöįŽäĒ žõĻ ‚ÄĘ Python / Django ‚ÄĘ Pykube 2. ÍĶ¨ŪėĄ 49

- 50. Stove ‚ÄĘ ŽĖ† žěąŽäĒ žĄúŽ≤ĄžĚė ž†ēŽ≥īŽ•ľ žČĹÍ≤Ć ŪĆĆžēÖ ÍįÄŽä• (ŽĚĄžöī žā¨ŽěĆ, Ž≤Ąž†ľ, ŽĚĄžöī Žā† ŽďĪ) ‚ÄĘ žĄúŽ≤ĄŽ≥ĄŽ°ú Žď§žĖīÍįą žõĻ ŪéėžĚīžßÄ ŽßĀŪĀ¨ 2. ÍĶ¨ŪėĄ 50

- 51. Stove ‚ÄĘ žĽ§Žįč&ŪĎłžčú ‚ěĒ Automated Docker Build ‚ÄĘ Github API ŪÜĶŪēú Ž≤Ąž†ľŽ≥Ą commit log ‚ÄĘ žĄúŽ≤Ą žĚīŽ¶ĄÍ≥ľ žĄ§Ž™ÖžĚĄ ž†ĀžĖī Ž™©ž†ĀžĚĄ žēĆ žąė žěąÍ≤Ć ‚ÄĘ ŽüįžĻė / žóÖŽćįžĚīŪäł / žā≠ž†ú žčú Slack Webhook ‚ÄĘ žā¨Žāī Žį©žÜ° žčúžä§ŪÖúÍ≥ľ žóįÍ≥ĄŪēėžó¨ ÍįúŽįúŪĆÄ žēĆŽ¶ľ ‚Äúxx žĄúŽ≤Ą žóÖŽćįžĚīŪäł žčúžěĎŪē©ŽčąŽč§‚ÄĚ 2. ÍĶ¨ŪėĄ 51

- 52. ÍįúŽįú žĄúŽ≤ĄÍįÄ ŽßéžēĄžßÄŽčą.. žĖīŽĒĒŽ°ú Ž∂ôžĖīžēľ ŪēėŽāė?! 2. ÍĶ¨ŪėĄ ‚ÄĘ Íłįž°īžóźŽäĒ žĄúŽ≤Ą ŪôėÍ≤ĹžĚī Í≥†ž†ēž†ĀžĚīžóąžúľŽĮÄŽ°ú ŪēėŽďú žĹĒŽĒ© (ex. ŽĒĒŽ≤ĄÍ∑ł ŪĀīŽĚľžĚīžĖłŪäł ŽüįžĻė žčú ‚Äėdev‚Äô, ‚Äėdev2‚Äô, ‚Äėdev3‚Äô ž§Ď Í≥†Ž•īÍłį) ‚ÄĘ žĄúŽ≤ĄÍįÄ ŽßéžēĄžßÄÍ≥†, ŽēĆžóź ŽĒįŽĚľ Žč§Ž•ł žĄúŽ≤Ąžóź ž†ĎžÜćŪēīžēľ ŪēėŽäĒŽćį, žÜźžúľŽ°ú žĚľžĚľŪěą ž£ľžÜĆŽ•ľ žďįÍłį ŪěėŽď§Žč§ 52

- 53. ÍįúŽįú žĄúŽ≤ĄÍįÄ ŽßéžēĄžßÄŽčą.. žĖīŽĒĒŽ°ú Ž∂ôžĖīžēľ ŪēėŽāė?! ‚ÄĘ Preset API ‚ÄĘ ž†ĎžÜćŪē† žĄúŽ≤Ą ž£ľžÜĆ ‚ÄĘ ž†ĎžÜć žčú žā¨žö©Ūē† Ž¶¨žÜĆžä§ Ž≤Ąž†ľ / Í≤ƞ쥎ćįžĚīŪĄį Ž≤Ąž†ľ 2. ÍĶ¨ŪėĄ 53

- 55. Í∑łŽěėžĄú, Ž™©ŪĎúŽäĒ Žč¨žĄĪŪĖąŽāėžöĒ? 1. ÍįúŽįúŪĆÄ ŽąĄÍĶ¨Žāė ŪēĄžöĒŪē† ŽēĆ žĄúŽ≤ĄŽ•ľ ŽĚĄžöł žąė žěąÍ≤Ć ‚ěě Žč¨žĄĪ ‚ÄĘ ŪĀīŽĚľžĚīžĖłŪäł ÍįúŽįúžěźŽāė QA žóĒžßÄŽčąžĖīŽŹĄ ŪēĄžöĒžóź ŽĒįŽĚľ žĄúŽ≤Ą On/Off/Update ‚ÄĘ ÍįĀ žĄúŽ≤ĄžĚė ž†ēž≤īžĄĪžĚī Ž™ÖŪôēŪēīž†ł ÍįúŽįú žčú API, ŽćįžĚīŪĄį ž∂©ŽŹĆ ŽďĪ žĚīžäą ÍįźžÜĆ ‚ÄĘ ŽßąžĻ® ŽŹÖŽ¶Ĺ ŪÖĆžä§Ūäł žĄúŽ≤ĄÍįÄ ŪēĄžöĒŪĖąŽćė ŪÉÄ ŪĆÄŽď§ ‚ÄĘ žēĆŪĆĆŽüį (Machine Learning), ŪÖĆžä§Ūäł žěźŽŹôŪôĒ, ‚Ķ 3. Ž¶¨Ž∑į 55

- 56. Í∑łŽěėžĄú, Ž™©ŪĎúŽäĒ Žč¨žĄĪŪĖąŽāėžöĒ? 2. ÍįúŽįú žĄúŽ≤Ą ŪôėÍ≤Ĺ žöīžėĀ ŽĻĄžö©žĚė ÍįźžÜĆ ‚ÄĘ AWS Reserved Instance ‚ÄĘ ŽĒįŽ°ú ŽĚĄžöįÍłį žē†Žß§Ūēú ÍįĀžĘÖ žĄúŽĻĄžä§Žď§ (ex. Žč§ÍĶ≠žĖī CS Ž≤ąžó≠ Žīá) 3. Ž¶¨Ž∑į 56

- 57. KubernetesŽäĒ žė≥žĚÄ žĄ†ŪÉĚžĚīžóąŽāė? ‚ÄĘ Yes. ÍĶ¨ŪėĄžóź ŪēĄžöĒŪēú ÍłįŽä•Žď§žĚĄ ŽĻĄÍĶźž†Ā ŪéłŪēėÍ≤Ć žďł žąė žěąžóąžĚĆ ‚ÄĘ žēĄžČ¨žõ†Žćė ž†ź ‚ÄĘ Ž≥Ķžě°Ūēú žÖčžóÖ Í≥ľž†ē (GCPŽ•ľ žďįžßÄ žēäŽäĒŽč§Ž©ī) ‚ÄĘ Ž≥Ķžě°Ūēú Ž¨łžĄú ‚ÄĘ API version žĚī žěźž£ľ Ž≥ÄÍ≤ĹŽź® (ex. extensions/v1beta1 ‚ěĒ v1) 3. Ž¶¨Ž∑į 57

- 58. Kubernetes on Production Environment? ‚ÄĘ žĶúÍ∑ľ Production žā¨žö© žā¨Ž°Ä ŽßéžĚĆ (Pokemon Go, NCSOFT ŽďĪ) ‚ÄĘ žŅ†Ūā§Žüį žė§ŽłźŽłĆŽ†ąžĚīŪĀ¨: X ‚ÄĘ ŽŹôÍłįŽ∂Äžó¨žôÄ žēąž†ēžĄĪ žĚīžäą ‚ÄĘ IDC / On-Premise Ž¨ľŽ¶¨ žĄúŽ≤Ą ŪôėÍ≤Ş󟞥ú žú†žö©Ūē† ŽďĮ 3. Ž¶¨Ž∑į 58