2. 自己紹介

2

1997年 東京大学工学部電子情報工学科卒業

2002年 同大学院博士課程修了.石塚研究室.博士(工学)

産業技術総合研究所 研究員

2005年 スタンフォード大学客員研究員

2007年 東京大学 大学院工学系研究科総合研究機構/技術経営戦略学

専攻/知の構造化センター 准教授

専門は、Web工学、人工知能

人工知能学会論文賞(2002年)

情報処理学会長尾真記念特別賞受賞(2007年)

人工知能学会 創立20周年記念事業賞、現場イノベーション賞(2012年)

2012年より、人工知能学会 編集委員長?理事。2007年より国際WWW会議プロ

グラム委員。WWW2014ではウェブマイニングトラックのトラックチェア。

オーマ株式会社技術顧問、経営共創基盤(株)顧問、Pluga AI Asset Management 技術顧

問、国立情報学研究所客員准教授、国家戦略会議 叡智のフロンティア部会委員等

SPYSEE, READYFOR、研究室の学生:Gunosy

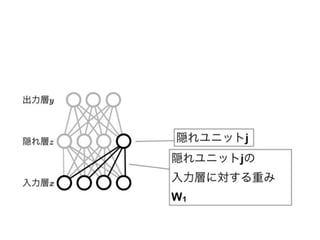

18. Deep Learningの展開

? DBN

? Auto-encoder

– Sparse autoencoder

– Denoising autoencoder

– ….

? 関数をどのようなものを使うか

– Sigmoid

– Max

– Rectifier

? ロバスト性を入れる

– さまざまなdropout

20. DL関連の国際会議

? ICLR: International Conference on Learning

Representations(2013, 2014)

? ICMLやNIPSでも、DL関連のワークショップ

が継続的に開かれている

DL関連のニュース

? Google Brain:トロント大J. Hinton教授と学生の会社をGoogleが

買収(2013)

? BaiduがシリコンバレーにDeep Learningの研究所を作る(2013)

? FBに人工知能研究所設立: NY大のYann LeCun教授(2013)

? Yahoo!が画像のDeep LearningのためにLookFlowという会社を

買収(2013)

? Googleが、Deep Learningの会社 Deep Mindを500億円で買収

(2014)

日経ビジネス2013年4月15日号

21. 深層学習≠表現学習(Representation Learning)

? Ten Priors for Representation Learning in AI [Bengio2014]

– Smoothness

– Multiple explanatory factors

– A hierarchical organization of explanatory factors

– Semi-supervised learning

– Shared factors across tasks

– Manifolds

– Natural clustering

– Temporal and spatial coherence

– Sparsity

– Simplicity of factor dependencies

? 「深層」であることは、表現を学習するための有力な方法のひとつ

23. 例:年収予測

性別 地域 身長 好きな色 年収

男 東京 168 赤 250

男 埼玉 176 白 700

男 神奈川 183 青 1200

女 東京 155 別に 400

男 千葉 174 赤 180

女 東京 163 緑 5000

? 年齢いれようよ

? 職業も必要でしょう

? 業種とかスキルとかも

入れた方がいいんじゃない?

なぜ人間には

それが分かるの?

経験?

28. フレーム問題(Dennett 1984)

? R1と名付けられた一台のロボットがあった。ある日、R1の予備バッテリーをしまってある部屋に時限爆弾が仕掛けられ、それはまもなく爆発する

ようにセットされていた。部屋には一台のワゴンがあり、バッテリーはその上にある。R1はバッテリー救出作戦を立てた。すなわち、PULLOUT

(WAGON, ROOM)という行動を行えば、バッテリーを部屋から持ち出すことができると考えた。R1はただちにこれを実行した。ところが、不幸なこ

とに爆弾もまたワゴンの上にあった。R1は爆弾がワゴンの上にあることを知っていたが、ワゴンを引っぱり出すことが、バッテリーと一緒に爆弾

も持ち出すことになるということに気が付かなかった。自分が計画した行動のこの明白な帰結を見落としていたR1は、部屋の外で爆発してしまっ

た。

? 技術者たちは考えた。ロボットは自分の行動の帰結として、自分の意図したものだけではなく、副産物についての帰結も認識できなければなら

ない、ロボットは周囲の状況の記述を用いて自分の行動を計画するから、そのような記述から副産物についての帰結を演繹(deduce)させれば

よい、と。こうしたわけで、R1D1(robot-deducer)がつくられた。R1D1はR1と同じ苦境にたたされた。R1D1も、PULLOUT(WAGON, ROOM)を考えつ

いた。それからR1D1は、設計されたとおり、この行動の帰結を考え始めた。R1D1は、ワゴンを部屋から引っぱり出しても部屋の壁の色は変わら

ないということを演繹し、ワゴンを引けば車輪が回転するだろうという帰結の証明にとりかかった。そのとき爆弾は爆発した。

? 技術者たちは考えた。われわれはロボットに、関係のある(relevant)帰結と関係のない(irrelevant)帰結との区別を教えてやり、関係のないもの

は無視するようにさせなければならない、と。こうしたわけで、R2D1(robot-relevant-deducer:分別のある演繹ロボット)がつくられた。R2D1も例

の苦境にたたされた。すると、驚いたことに、このロボットは、部屋に入ろうともせず、じっとうずくまって考えていた。設計者たちは「何かしろ」と

叫んだ。R2D1は「してますよ」と答えた。「私は、無関係な帰結を探し出してそれを無視するのに忙しいんです。そんな帰結が何千とあるんです。

私は、関係のない帰結を見つけると、すぐそれを無視しなければならないもののリストにのせて、……」また爆発してしまった。

(例) 倉庫に箱があり、箱の中にバッテリーと時限爆弾がある。

この箱を持ち出すようにロボットに命令すると???

そのまま持ち出して爆発

持ち出す方法の計算中に爆発

持ち出す方法の計算方法の

計算中に爆発

3号:

2号:

1号:

31. Zebra = horse + stripes?

? (1) Suppose the name "horse" is grounded by iconic and categorical representations,

learned from experience, that reliably discriminate and identify horses on the basis of

their sensory projections.

? (2) Suppose "stripes" is similarly grounded.

? Now consider that the following category can be constituted out of these elementary

categories by a symbolic description of category membership alone:

? (3) "Zebra" = "horse" & "stripes”

? What is the representation of a zebra? It is just the

symbol string "horse & stripes." But because "horse"

and "stripes" are grounded in their respective iconic

and categorical representations, "zebra" inherits the

grounding, through its grounded symbolic

representation. In principle, someone who had never

seen a zebra (but had seen and learned to identify

horses and stripes) could identify a zebra on first

acquaintance armed with this symbolic

representation alone (plus the nonsymbolic -- iconic

and categorical -- representations of horses and

stripes that ground it).

35. インデックスとしての表現

? 表現と計算量にはトレードオフがある。

– マッカーシーらの論理主義者達はフレーム問題を記述の量減らしと狭くとらえたため, か

えって処理の量を増やしてしまっている(有限のアルゴリズムがあればよいとするようだ)。 記

述の量と処理の量はトレードオフである。そのため双方を考慮しなければいけない。(松原

1990)

? ある程度「汎用的に」使えるように、データをあらかじめ加工しておく。

– 検索におけるインデックス作り

? 途中までやって、中間表現として、おいておく。

– 例えば「シマ」という概念:いろいろな表現の生成に使える。

– 料理で言うと、魚の切り身とか、肉の薄切りとか

? この「途中までやっておく」という処理が、表現学習において重要

Deep Learningがまさに、中間表現を作る仕組みの

端緒を開いている!

そのポイントは、データ量、ロバスト性、それを支える計算量だった。

36. 気に食わないこと:Encode? Decode?

? 手続き的な処理とどう関係するの?

– チューリングマシン

? 信号処理の符号化、復号との関係は?

? もっといろいろあるのでは

– 食べたらおいしい

– 叩いたら壊れる

– 割り切れる

? 手続きが定義され、「同一性」が定義される。

– 実は「最初にMがあるか」とか「ツイートの長

さ」とかも、手続き的な素性

? 任意の手続きでEncode, Decodeしてもよいはず。

? 任意の手続きも階層的になっていてよいはず。

– 手続きも抽象化されているはず。

? Encoder, Decoder自体が、DLの高次概念(高次

の手続き)になっているはず。

Encode

Decode

40. 1. 画像

2. 観測したデータ(画像+音声+圧力センサー+…) → マルチモーダルな抽象化

3. 自分の行動に関するデータ + 観測したデータ → 行為と帰結の抽象化

4. 行為を介しての抽象化

→ 名詞だけでなく動詞

(その様態としての形容詞や副詞)

5. 高次特徴の言語による

バインディング

6. バインディングされた言語データの大量の入力 → さらなる抽象化、言語理解、自動翻訳

プランニング

推論?オントロジー

言語身体性

→ 画像特徴の抽象化

シンボルグラウンディング

Deep Learningがすごいのではなく、

Deep Learningの先に広がる世界がすごい

41. 今後のDL研究

? 研究のロードマップ

– 時系列処理

– 行動と観測のデータ入力

– 概念と言語ラベルのグラウンディング

– 大量の言語表現の入力

– …

? 人工知能で最も難しかった問題(表現の獲得)に、突破の糸口が見えた

– 「なぜ、できないの?できて当たり前」という人工知能ができた当初の仮説に

戻るべき

? ディープラーニング:大脳新皮質

– 脳の各構造をどのように作っていけばよいか?という言い方もできる。

42. 第6回 AIツール入門講座のご案内

? 日程 : 2014年7月10日( 木) 9:30-16:30( 予定)

? 会場 : 東京工業大学キャ ンパス? イ ノ ベーショ ンセンタ ー

( 〒108-0023 東京都港区芝浦3-3-6 JR田町駅すぐ )

? 参加費: 一般会員11,000円, 学生会員5,000円, 非会員16,000円

? URL : 人工知能学会HP h p://www.ai-gakkai.or.jp/category/ai-seminar/

( 近日中に上記ページに申込みページを 公開し ます)

? 連絡先: account@ai-gakkai.or.jp

人工知能に関連するツールや応用アプリ ケーショ ン開発における入門講座を 実

施する 「 AIツ ール入門講座」 のご案内です。 今回は、 東京工業大学キャ ン パス?

イ ノ ベーショ ンセンタ ー( 東京都港区) にて、 いま注目を浴びている機械学習手

法である Deep Learning、 そし て3Dエージェ ン ト と の音声対話を 実現する ツ ール

キッ ト MMDAgentの2件のツール入門講座を 開催いたし ます。 当講座では、 実際に

ツ ールを ご自分の手で操作し ながら 学ぶこ と ができ ますので、 導入を 考えておら

れる 学生? 研究者? 企業の方々にと っ て有意義な機会にな る と 思っ ており ま す。

ぜひお誘いあわせのう え、 奮っ てご参加下さ い。

主催: 一般社団法人 人工知能学会

担当企画委員

松村 冬子( 青山学院大学)

笹嶋 宗彦( 株式会社YMP-Mundus, 大阪大学)

松下 光範( 関西大学)

講座 (1) Deep Learning( 深層学習)

講師: 中山 浩太郎( 東京大学)

講座 (2) 音声イ ンタ ラ ク ショ ン構築ツールキッ ト MMDAgent

( 協賛: JST CREST uDialogue プロジェ ク ト )

講師: 李 晃伸( 名古屋工業大学)

![深層学習≠表現学習(Representation Learning)

? Ten Priors for Representation Learning in AI [Bengio2014]

– Smoothness

– Multiple explanatory factors

– A hierarchical organization of explanatory factors

– Semi-supervised learning

– Shared factors across tasks

– Manifolds

– Natural clustering

– Temporal and spatial coherence

– Sparsity

– Simplicity of factor dependencies

? 「深層」であることは、表現を学習するための有力な方法のひとつ](https://image.slidesharecdn.com/random-140704215342-phpapp01/85/-21-320.jpg)