2014.02.20冲5章ニューラルネットワーク

- 1. PRML輪読会 第9回 made by C.M.Bishop modified by T.Sakaki PATTERN RECOGNITION AND MACHINE LEARNING Chapter 5.4 The Hessian Matrix Chapter 5.5 Regularization Neural Networks

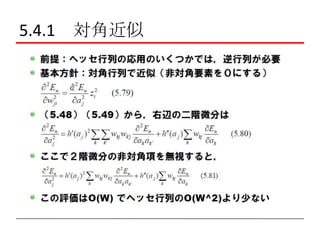

- 3. 5.4.1 対角近似

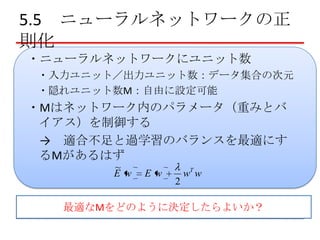

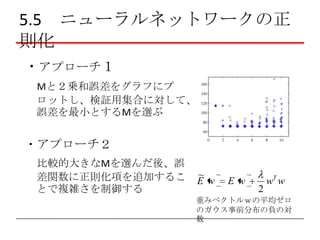

- 9. 5.5 ニューラルネットワークの正 則化 ?ニューラルネットワークにユニット数 ?入力ユニット/出力ユニット数:データ集合の次元 ?隠れユニット数M:自由に設定可能 ?Mはネットワーク内のパラメータ(重みとバ イアス)を制御する → 適合不足と過学習のバランスを最適にす るMがあるはず ~ E w Ew 2 wT w 最適なMをどのように決定したらよいか?

- 10. 5.5 ニューラルネットワークの正 則化 ?アプローチ1 Mと2乗和誤差をグラフにプ ロットし、検証用集合に対して、 誤差を最小とするMを選ぶ ?アプローチ2 比較的大きなMを選んだ後、誤 差関数に正則化項を追加するこ とで複雑さを制御する ~ E w Ew 2 wT w 重みベクトルwの平均ゼロ のガウス事前分布の負の対 数

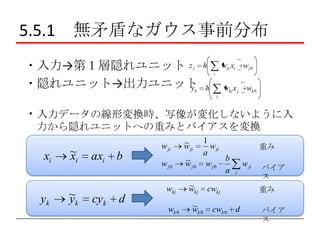

- 11. 5.5.1 無矛盾なガウス事前分布 ?入力→第1層隠れユニット z ?隠れユニット→出力ユニット y j k h w ji xi wj0 i h wkj x j wk 0 j ?入力データの線形変換時、写像が変化しないように入 力から隠れユニットへの重みとバイアスを変換 xi yk ~ xi ~ yk axi cyk b d w ji ~ w ji wj0 ~ wj0 wkj wk 0 ~ wkj ~ wk 0 1 w ji a b wj0 a 重み w ji i 重み cwkj cwk 0 バイア ス d バイア ス

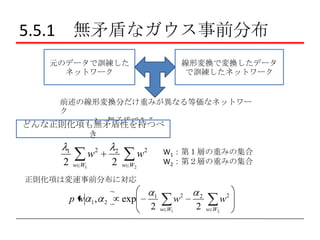

- 12. 5.5.1 無矛盾なガウス事前分布 元のデータで訓練した ネットワーク 線形変換で変換したデータ で訓練したネットワーク 前述の線形変換分だけ重みが異なる等価なネットワー ク → 無矛盾である どんな正則化項も無矛盾性を持つべ き w2 1 2 2 w W1 W1:第1層の重みの集合 W2:第2層の重みの集合 w2 2 w W2 正則化項は変速事前分布に対応 pw 1 , 2 exp w2 1 2 w W1 w2 2 2 w W2

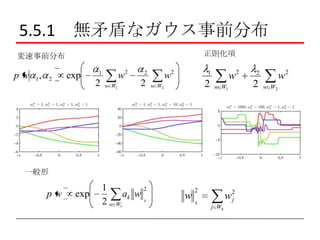

- 13. 5.5.1 無矛盾なガウス事前分布 正則化項 変速事前分布 pw 1, 2 exp w2 1 2 w W1 w2 2 2 w2 1 2 w W2 w W1 一般形 pw exp 1 2 ak w k 2 w W1 w 2 k w2 j j Wk w2 2 2 w W2

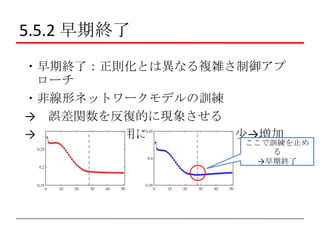

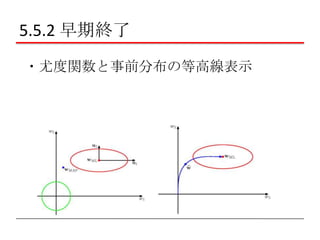

- 14. 5.5.2 早期終了 ?早期終了:正則化とは異なる複雑さ制御アプ ローチ ?非線形ネットワークモデルの訓練 → 誤差関数を反復的に現象させる → ただし、検証用に関する誤差は減少→増加 ここで訓練を止め る →早期終了

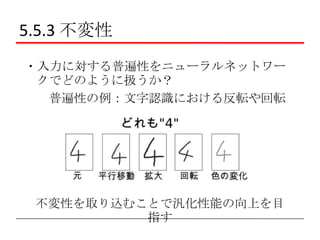

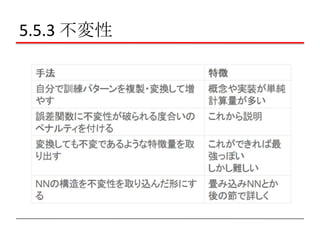

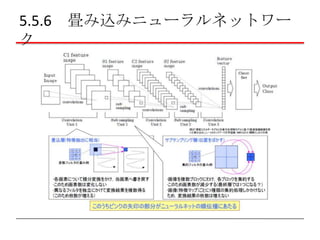

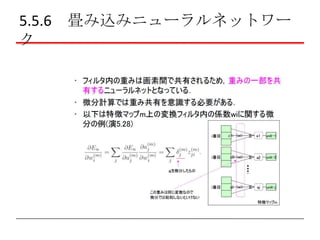

- 17. 5.5.3 不変性

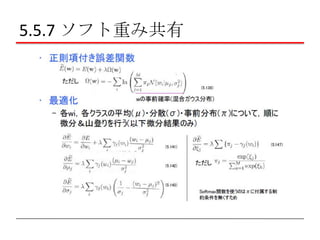

- 29. 5.5.7 ソフト重み共有

- 30. 5.5.7 ソフト重み共有

![[PRML] パターン認識と機械学習(第3章:線形回帰モデル)](https://cdn.slidesharecdn.com/ss_thumbnails/prmlchapter3-171003081954-thumbnail.jpg?width=560&fit=bounds)