滨肠尘濒2018読み会冲辞惫别谤惫颈别飞&补尘辫;骋础狈蝉

- 1. Copyright (C) 2018 DeNA Co.,Ltd. All Rights Reserved.Copyright (C) 2018 DeNA Co.,Ltd. All Rights Reserved. July 25, 2018 Kentaro Tachibana AI System Dept. DeNA Co., Ltd. ICML2018読み会 Overview & GANs

- 2. Copyright (C) 2018 DeNA Co.,Ltd. All Rights Reserved. 自己紹介 ? 名前:橘 健太郎 ● 2008?17年 東芝 研究開発センター ● 音声合成の研究開発に従事 ● 2014?17年9月 情報通信研究機構(NICT)出向 ● 音声翻訳アプリVoiceTraの音声合成を担当 ● 2017年10月 DeNA入社 ● アニメキャラ生成に携わる (https://dena.com/intl/anime-generation/) ? 狠狠撸 share ● 声质変换の概要と最新手法の绍介 ● Icassp2018 発表参加報告 FFTNet, Tactron2紹介

- 3. Copyright (C) 2018 DeNA Co.,Ltd. All Rights Reserved. アジェンダ ? ICMLについて ? 概要 ? 計数 ? GANs関連論文の傾向 -task別に分類- ? GANs関連から論文紹介 3編 ? まとめ?所感

- 4. Copyright (C) 2018 DeNA Co.,Ltd. All Rights Reserved. ICML2018概要 (1/4) ? ICMLとは ? International conference on Machine Learning ? 機械学習系のトップカンファレンスの一つ、今回で35回目 ? 本会議、Workshop(Theoretical Foundations and Applications of Deep Generative Models) に参加しました ? 会場 :Stockholmsmassan Stockholm, SWEDEN ? Stockholmsm?ssan, Stockholm SWEDEN 主なスポンサー

- 5. Copyright (C) 2018 DeNA Co.,Ltd. All Rights Reserved. ICML2018概要 (2/4) ? 企業出展 かなり盛況な印象。 著者と直接話せる貴重な場であった。 NVIDIAのデモが完成度が高く、印象に残った。 ? スーパースローモーション ? 画像のオブジェクト編集

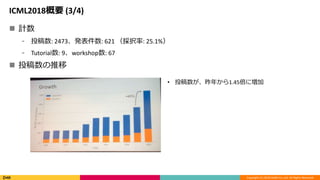

- 6. Copyright (C) 2018 DeNA Co.,Ltd. All Rights Reserved. ICML2018概要 (3/4) ? 計数 ? 投稿数: 2473、発表件数: 621 (採択率: 25.1%) ? Tutorial数: 9、workshop数: 67 ? 投稿数の推移 ? 投稿数が、昨年から1.45倍に増加

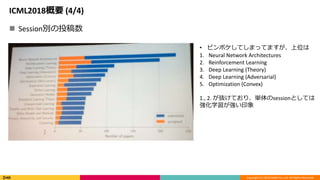

- 7. Copyright (C) 2018 DeNA Co.,Ltd. All Rights Reserved. ICML2018概要 (4/4) ? Session別の投稿数 ? ピンボケしてしまってますが、上位は 1. Neural Network Architectures 2. Reinforcement Learning 3. Deep Learning (Theory) 4. Deep Learning (Adversarial) 5. Optimization (Convex) 1., 2. が抜けており、単体のsessionとしては 強化学習が強い印象

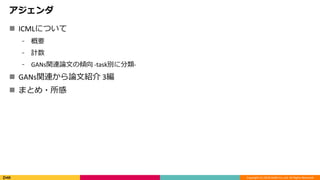

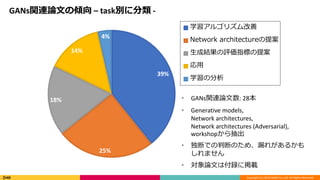

- 8. Copyright (C) 2018 DeNA Co.,Ltd. All Rights Reserved. 39% 25% 18% 14% 4% 学習アルゴリズム改善 Network architectureの提案 生成結果の評価指標の提案 応用 学習の分析 GANs関連論文の傾向 – task別に分類 - ? GANs関連論文数: 28本 ? Generative models, Network architectures, Network architectures (Adversarial), workshopから抽出 ? 独断での判断のため、漏れがあるかも しれません ? 対象論文は付録に掲載

- 9. Copyright (C) 2018 DeNA Co.,Ltd. All Rights Reserved. 紹介論文 1. 学習アルゴリム改善 ? Which Training Methods for GANs do actually Converge? 2. Network architectureの提案 ? ??RadialGAN: Leveraging multiple datasets to improve target-specific predictive models using Generative Adversarial Networks 3. 生成評価指標の提案 ? Assessing Generative Models via Precision and Recall

- 10. Copyright (C) 2018 DeNA Co.,Ltd. All Rights Reserved. 紹介論文 1. 学習アルゴリム改善 ? Which Training Methods for GANs do actually Converge? 2. Network architectureの提案 ? ??RadialGAN: Leveraging multiple datasets to improve target-specific predictive models using Generative Adversarial Networks 3. 生成評価指標の提案 ? Assessing Generative Models via Precision and Recall

- 11. Copyright (C) 2018 DeNA Co.,Ltd. All Rights Reserved. Which Training Methods for GANs do actually Converge? ? 背景 ? GANは、強力な生成モデルだが、学習が困難 ? 学習の挙動が完全に理解されたわけではない ? 数多くの学習安定化手法が提案されている (WGAN [1]、WGAN-GP [2]など) ? どの手法が実際に収束しているのかを調査する ? 貢献 1. 簡易な実験により、unregularized GAN学習はいつも収束はするわけでないことを確認 2. 最新の学習安定化手法についての収束性の調査 1. WGAN、WGAN-GPはいつも収束するわけではない 2. Instance noise [3]、zero-centered gradient penalties [4] はいつも収束する 3. シンプルなgradient penaltiesの提案 4. 実験的評価により、3.の収束安定性を確認

- 12. Copyright (C) 2018 DeNA Co.,Ltd. All Rights Reserved. Dirac-GAN ? Dirac-GANの導入 ? 種々のGAN学習安定アルゴリズムを収束安定性を確認するため、簡易の目的関数を準備 ? 目的関数 ? GAN ? Dirac-GAN ? 真の分布、generatorをδ関数、discriminatorを線形関数で表現 上記を代入すると ? ? ? ∶ true data distribution ? ? ∶ generator distribution ? ? ? ∶ disctriminator ? ? ? ∶ generator ? ∶ parameters of the generator ψ ∶ parameters of the discriminator , ? ? = , ? ? ? = ? ? = ? , ? ? ? = 0 ? ≠ ? Vanilla-GAN: WGAN: ? ? = ?

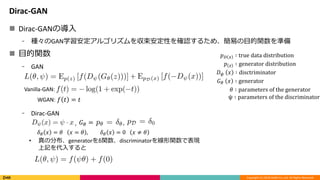

- 13. Copyright (C) 2018 DeNA Co.,Ltd. All Rights Reserved. Dirac-GAN ? 既存の学習安定化手法における収束特性の可視化 ? Gradient vector fieldの導入 ? Jacobianの固有値の実数部が全て負であった場合、平衡状態となり、安定する→ 収束する [5] Jacobian 平衡状態:時間的 に変化しない状態 WGAN: 固有値 : ±? となり、安定とはならない Zero-centered gradient penalty: 固有値 : ? ? 2 ± ?2 4 ? ?′ 0 2 ?, ? > 0 で、固有値は全て負となるため、収束する をdiscriminatorに追加 ? ? ? ?

- 14. Copyright (C) 2018 DeNA Co.,Ltd. All Rights Reserved. Dirac-GAN ? その他手法の収束特性 ? Non-saturating GAN、instance noise で収束が確認できる ? しかし、non-saturating GANは 非常に低速

- 15. Copyright (C) 2018 DeNA Co.,Ltd. All Rights Reserved. Regularized gradient vector field ? Discriminatorの正則化項として、以下を目的関数に追加することを提案 ? Regularized gradient vector field ? 正則化項により、安定に収束する

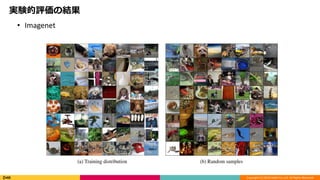

- 16. Copyright (C) 2018 DeNA Co.,Ltd. All Rights Reserved. 実験的評価の結果 ? Imagenet

- 17. Copyright (C) 2018 DeNA Co.,Ltd. All Rights Reserved. 実験的評価の結果 ? CelebA-HQ

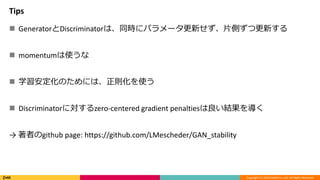

- 18. Copyright (C) 2018 DeNA Co.,Ltd. All Rights Reserved. Tips ? GeneratorとDiscriminatorは、同時にパラメータ更新せず、片側ずつ更新する ? momentumは使うな ? 学習安定化のためには、正則化を使う ? Discriminatorに対するzero-centered gradient penaltiesは良い結果を導く → 著者のgithub page: https://github.com/LMescheder/GAN_stability

- 19. Copyright (C) 2018 DeNA Co.,Ltd. All Rights Reserved. 紹介論文 1. 学習アルゴリム改善 ? Which Training Methods for GANs do actually Converge? 2. Network architectureの提案 ? ??RadialGAN: Leveraging multiple datasets to improve target-specific predictive models using Generative Adversarial Networks 3. 生成評価指標の提案 ? Assessing Generative Models via Precision and Recall

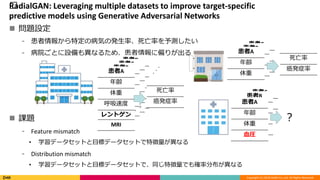

- 20. Copyright (C) 2018 DeNA Co.,Ltd. All Rights Reserved. ??RadialGAN: Leveraging multiple datasets to improve target-specific predictive models using Generative Adversarial Networks ? 問題設定 ? 患者情報から特定の病気の発生率、死亡率を予測したい ? 病院ごとに設備も異なるため、患者情報に偏りが出る ? 課題 ? Feature mismatch ? 学習データセットと目標データセットで特徴量が異なる ? Distribution mismatch ? 学習データセットと目標データセットで、同じ特徴量でも確率分布が異なる 患者D 年齢 体重 呼吸速度 レントゲン MRI 患者C 年齢 体重 呼吸速度 レントゲン MRI 患者B 年齢 体重 呼吸速度 レントゲン MRI 患者A 年齢 体重 呼吸速度 レントゲン MRI 患者C 年齢 体重 患者B 年齢 体重 患者A 年齢 体重 患者C 年齢 体重 患者B 年齢 体重 血圧 患者A 年齢 体重 血圧 死亡率 癌発症率 ? 死亡率 癌発症率

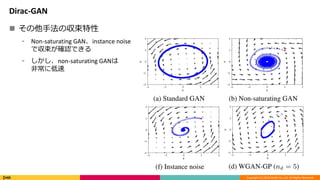

- 21. Copyright (C) 2018 DeNA Co.,Ltd. All Rights Reserved. ? アイデア ? CycleGANベースに複数GANを利用 ? 患者データを潜在空間にmappingし、共通空間で扱う ? 要素 ? Encoder ??: ?(?) × ? → ?, ? Decoder ? Discriminator ? Loss 1. Adversarial loss 2. Cycle-consistency loss 3. Optimization ??RadialGAN アルゴリズム Di :病院 X(i) :患者データ Y(i) :予測したいデータ Z :潜在空間 ?? = ?? ?(?), ? ∈ ? ??: ? → ?(?) × ?, ?(?) , ? = ?? ?? ∈ ?(?) × ? ? ?(?) , ? = ? ?(?) , ? ∈ ????: ?(?) × ? → [0, 1],

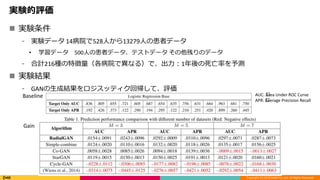

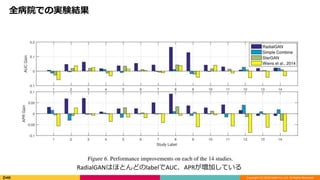

- 22. Copyright (C) 2018 DeNA Co.,Ltd. All Rights Reserved. 実験的評価 ? 実験条件 ? 実験データ 14病院で528人から13279人の患者データ ? 学習データ 500人の患者データ、テストデータ その他残りのデータ ? 合計216種の特徴量(各病院で異なる)で、出力:1年後の死亡率を予測 ? 実験結果 ? GANの生成結果をロジスッティク回帰して、評価 AUC: ?Area Under ROC Curve APR: ?Average Precision Recall Baseline Gain

- 23. Copyright (C) 2018 DeNA Co.,Ltd. All Rights Reserved. 全病院での実験結果 RadialGANはほとんどのlabelでAUC、APRが増加している

- 24. Copyright (C) 2018 DeNA Co.,Ltd. All Rights Reserved. 紹介論文 1. 学習アルゴリム改善 ? Which Training Methods for GANs do actually Converge? 2. Network architectureの提案 ? ??RadialGAN: Leveraging multiple datasets to improve target-specific predictive models using Generative Adversarial Networks 3. 生成評価指標の提案 ? Assessing Generative Models via Precision and Recall

- 25. Copyright (C) 2018 DeNA Co.,Ltd. All Rights Reserved. Assessing Generative Models via Precision and Recall ? 背景 ? 生成モデルの結果を定量的に評価することは難しい ? 尤度のような密度推定では、尤度が下がったからといって、品質?多様性が改善してるわけ ではない [6] ? 最新の評価手法 Inception score (IS) [7]と ?Frechet inception distance (FID) [8] では、異なる軸での 評価が出来ない ? 貢献 ? 確率分布に対するprecision (品質)とrecall (多様性)の定義を提案 ? GANのmode dropping、model inventingを定量的に測定 ? 既存の生成モデルを提案法の軸で比較

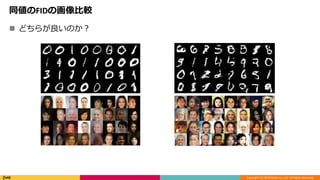

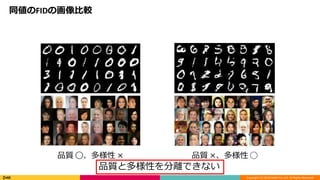

- 26. Copyright (C) 2018 DeNA Co.,Ltd. All Rights Reserved. 同値のFIDの画像比較 ? どちらが良いのか?

- 27. Copyright (C) 2018 DeNA Co.,Ltd. All Rights Reserved. 同値のFIDの画像比較 品質 ?、多様性 × 品質 ×、多様性 ? 品質と多様性を分離できない

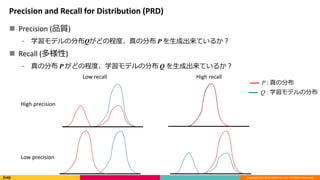

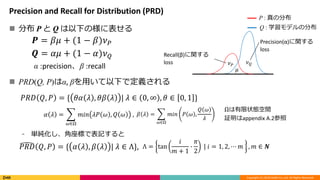

- 28. Copyright (C) 2018 DeNA Co.,Ltd. All Rights Reserved. Precision and Recall for Distribution (PRD) ? Precision (品質) ? 学習モデルの分布Qがどの程度、真の分布 P を生成出来ているか? ? Recall (多様性) ? 真の分布 P がどの程度、学習モデルの分布 Q を生成出来ているか? P : 真の分布 Q : 学習モデルの分布 High precision Low precision Low recall High recall

- 29. Copyright (C) 2018 DeNA Co.,Ltd. All Rights Reserved. Precision and Recall for Distribution (PRD) ? 分布 P と Q は以下の様に表せる ? PRD(Q, P)はα, βを用いて以下で定義される ? 単純化し、角座標で表記すると ? ? ? ? ? P : 真の分布 Q : 学習モデルの分布 Recall(β)に関する loss Precision(α)に関する loss ? = ?? + (1 ? ?)? ? ? = ?? + (1 ? ?)? ? ??? ?, ? = { ?? ? , ?? ? | ? ∈ 0, ∞ , ? ∈ 0, 1 } ? ? = ?∈Ω ??? ?? ? , ? ? , 証明はappendix A.2参照 α :precision、β :recall ? ? = ?∈Ω ??? ? ? , ? ? ? ??? ?, ? = { ? ? , ? ? | ? ∈ Λ}, Λ = tan ? ? + 1 ? ? 2 | ? = 1, 2, ? ? , ? ∈ ? Ωは有限状態空間

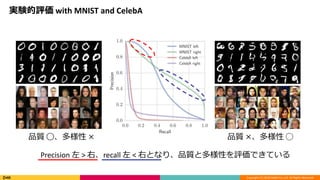

- 30. Copyright (C) 2018 DeNA Co.,Ltd. All Rights Reserved. 実験的評価 with MNIST and CelebA 品質 ?、多様性 × 品質 ×、多様性 ? Precision 左 > 右、recall 左 < 右となり、品質と多様性を評価できている

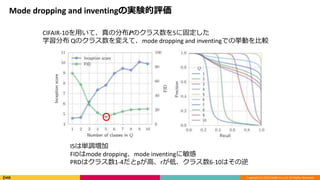

- 31. Copyright (C) 2018 DeNA Co.,Ltd. All Rights Reserved. Mode dropping and inventingの実験的評価 CIFAIR-10を用いて、真の分布Pのクラス数を5に固定した 学習分布 Qのクラス数を変えて、mode dropping and inventingでの挙動を比較 ISは単調増加 FIDはmode dropping、mode inventingに敏感 PRDはクラス数1-4だとpが高、rが低、クラス数6-10はその逆

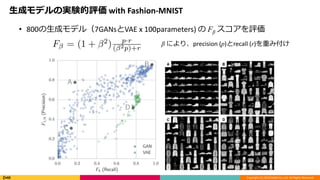

- 32. Copyright (C) 2018 DeNA Co.,Ltd. All Rights Reserved. 生成モデルの実験的評価 with Fashion-MNIST ? 800の生成モデル(7GANsとVAE x 100parameters) の Fβ スコアを評価 β により、precision (p)とrecall (r)を重み付け

- 33. Copyright (C) 2018 DeNA Co.,Ltd. All Rights Reserved. まとめ?所感 ? まとめ ? ICML2018について、概要と計数について紹介 ? GANs関連論文の傾向と、3編を紹介 ? 所感 ? GANsの分野では、学習アルゴリズムの改善、応用などバランスよく研究されている。 ? 技術進展のスピードはとても速い、追いて行かれない様、アンテナを張っていく ? USの大手IT企業が大学と共著で発表していた論文が非常に多かった ? 展示会でも積極的にリクルート活動をしている印象

- 34. Copyright (C) 2018 DeNA Co.,Ltd. All Rights Reserved. 参考文献 [1] ?Arjovsky, M. and Bottou, L. Towards principled meth- ods for training generative adversarial networks. CoRR, abs/1701.04862, 2017. [2] ?Gulrajani, I., Ahmed, F., Arjovsky, M., Dumoulin, V., and Courville, A. C. Improved training ofwasserstein gans. In Advances in Neural Information Processing Systems 30: Annual Conference on Neural Information Processing Systems 2017, 4-9 December 2017, Long Beach, CA, USA, pp. 5769–5779, 2017. [3] ?S?nderby, C. K., Caballero, J., Theis, L., Shi, W., and Huszár, F. Amortised MAP inference for image super- resolution. CoRR, abs/1610.04490, 2016. [4] ?Roth, K., Lucchi, A., Nowozin, S., and Hofmann, T. Stabi- lizing training of generative adversarial networks through ?regularization. In Advances in Neural Information Pro- cessing Systems 30: Annual Conference on Neural In- formation Processing Systems 2017, 4-9 December 2017, Long Beach, CA, USA, pp. 2015–2025, 2017. [5] ?Mescheder, L. M., Nowozin, S., and Geiger, A. The numer- ics of gans. In Advances in Neural Information Process- ing Systems 30: Annual Conference on Neural Informa- tion Processing Systems 2017, 4-9 December 2017, Long Beach, CA, USA, pp. 1823–1833, 2017. [6] ?Salimans, T., Goodfellow, I., Zaremba, W., Cheung, V., Rad- ford, A., and Chen, X. Improved Techniques for Training GANs. In Advances in Neural Information Processing Systems (NIPS), 2016. [7] ?Heusel, M., Ramsauer, H., Unterthiner, T., Nessler, B., Klambauer, G., and Hochreiter, S. Gans trained by a two time-scale update rule converge to a nash equilib- rium. In Advances in Neural Information Processing Systems (NIPS), 2017. [8] ?Theis, L., Oord, A. v. d., and Bethge, M. A note on the eval- uation of generative models. In International Conference on Learning Representations (ICLR), 2016.

- 35. Copyright (C) 2018 DeNA Co.,Ltd. All Rights Reserved. 付録 (1/3) タスク名 論文 学習アルゴリズム改善 mode collapse回避、学習安定性向上、更新式 改善など Which Training Methods for GANs do actually Converge? Chi-square Generative Adversarial Network Tempered Adversarial Networks Improved Training of Generative Adversarial Networks Using Representative Features A Two-Step Computation of the Exact GAN Wasserstein Distance First Order Generative Adversarial Networks Mixed batches and symmetric discriminators for GAN training Stochastic Variance Reduced Gradient Optimization of Generative Adversarial Networks Bayesian Modelling and Monte Carlo Inference for GAN Approximability of Discriminators Implies Diversity in GANs On catastrophic forgetting and mode collapse in Generative Adversarial Networks

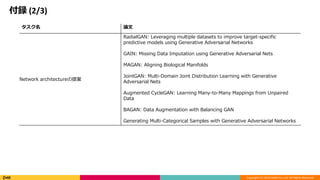

- 36. Copyright (C) 2018 DeNA Co.,Ltd. All Rights Reserved. 付録 (2/3) タスク名 論文 Network architectureの提案 RadialGAN: Leveraging multiple datasets to improve target-specific predictive models using Generative Adversarial Networks GAIN: Missing Data Imputation using Generative Adversarial Nets MAGAN: Aligning Biological Manifolds JointGAN: Multi-Domain Joint Distribution Learning with Generative Adversarial Nets Augmented CycleGAN: Learning Many-to-Many Mappings from Unpaired Data BAGAN: Data Augmentation with Balancing GAN Generating Multi-Categorical Samples with Generative Adversarial Networks

- 37. Copyright (C) 2018 DeNA Co.,Ltd. All Rights Reserved. 付録 (3/3) タスク名 論文 生成結果の評価指標の提案 GANの生成結果を客観評価する手法を提案 A Classification-Based Study of Covariate Shift in GAN Distributions Geometry Score: A Method For Comparing Generative Adversarial Networks On Accurate Evaluation of GANs for Language Generation Assessing Generative Models via Precision and Recall Towards GAN Benchmarks Which Require Generalization 応用 既存architectureを新たな分野へ適用 NetGAN: Generating Graphs via Random Walks BinGAN: Learning Compact Binary Descriptors with a Regularized GAN MolGAN: An implicit generative model for small molecular graphs Generative Buyer-Seller Adversarial Networks 学習の分析 学習安定性に向けた分析 Nonstationary GANs: Analysis as Nonautonomous Dynamical Systems

Editor's Notes

- #23: Logistic regressionの結果 と真値でAPR AUC ROC curveの面積、完全に重なった時は0.5 APR -> 一番良い時は

![Copyright (C) 2018 DeNA Co.,Ltd. All Rights Reserved.

Which Training Methods for GANs do actually Converge?

? 背景

? GANは、強力な生成モデルだが、学習が困難

? 学習の挙動が完全に理解されたわけではない

? 数多くの学習安定化手法が提案されている (WGAN [1]、WGAN-GP [2]など)

? どの手法が実際に収束しているのかを調査する

? 貢献

1. 簡易な実験により、unregularized GAN学習はいつも収束はするわけでないことを確認

2. 最新の学習安定化手法についての収束性の調査

1. WGAN、WGAN-GPはいつも収束するわけではない

2. Instance noise [3]、zero-centered gradient penalties [4] はいつも収束する

3. シンプルなgradient penaltiesの提案

4. 実験的評価により、3.の収束安定性を確認](https://image.slidesharecdn.com/icmlrinko-180728035855/85/Icml2018-_overview-GANs-11-320.jpg)

![Copyright (C) 2018 DeNA Co.,Ltd. All Rights Reserved.

Dirac-GAN

? 既存の学習安定化手法における収束特性の可視化

? Gradient vector fieldの導入

? Jacobianの固有値の実数部が全て負であった場合、平衡状態となり、安定する→ 収束する [5]

Jacobian

平衡状態:時間的

に変化しない状態

WGAN:

固有値 : ±? となり、安定とはならない

Zero-centered gradient penalty:

固有値 : ?

?

2

±

?2

4

? ?′ 0 2 ?, ? > 0 で、固有値は全て負となるため、収束する

をdiscriminatorに追加

?

?

?

?](https://image.slidesharecdn.com/icmlrinko-180728035855/85/Icml2018-_overview-GANs-13-320.jpg)

![Copyright (C) 2018 DeNA Co.,Ltd. All Rights Reserved.

? アイデア

? CycleGANベースに複数GANを利用

? 患者データを潜在空間にmappingし、共通空間で扱う

? 要素

? Encoder ??: ?(?)

× ? → ?,

? Decoder

? Discriminator

? Loss

1. Adversarial loss

2. Cycle-consistency loss

3. Optimization

??RadialGAN アルゴリズム

Di :病院

X(i) :患者データ

Y(i) :予測したいデータ

Z :潜在空間

?? = ?? ?(?), ? ∈ ?

??: ? → ?(?) × ?, ?(?)

, ? = ?? ?? ∈ ?(?)

× ?

? ?(?)

, ? = ? ?(?)

, ? ∈ ????: ?(?)

× ? → [0, 1],](https://image.slidesharecdn.com/icmlrinko-180728035855/85/Icml2018-_overview-GANs-21-320.jpg)

![Copyright (C) 2018 DeNA Co.,Ltd. All Rights Reserved.

Assessing Generative Models via Precision and Recall

? 背景

? 生成モデルの結果を定量的に評価することは難しい

? 尤度のような密度推定では、尤度が下がったからといって、品質?多様性が改善してるわけ

ではない [6]

? 最新の評価手法 Inception score (IS) [7]と ?Frechet inception distance (FID) [8] では、異なる軸での

評価が出来ない

? 貢献

? 確率分布に対するprecision (品質)とrecall (多様性)の定義を提案

? GANのmode dropping、model inventingを定量的に測定

? 既存の生成モデルを提案法の軸で比較](https://image.slidesharecdn.com/icmlrinko-180728035855/85/Icml2018-_overview-GANs-25-320.jpg)

![Copyright (C) 2018 DeNA Co.,Ltd. All Rights Reserved.

参考文献

[1] ?Arjovsky, M. and Bottou, L. Towards principled meth- ods for training generative adversarial networks. CoRR, abs/1701.04862, 2017.

[2] ?Gulrajani, I., Ahmed, F., Arjovsky, M., Dumoulin, V., and Courville, A. C. Improved training ofwasserstein gans. In Advances in Neural

Information Processing Systems 30: Annual Conference on Neural Information Processing Systems 2017, 4-9 December 2017, Long Beach,

CA, USA, pp. 5769–5779, 2017.

[3] ?S?nderby, C. K., Caballero, J., Theis, L., Shi, W., and Huszár, F. Amortised MAP inference for image super- resolution. CoRR,

abs/1610.04490, 2016.

[4] ?Roth, K., Lucchi, A., Nowozin, S., and Hofmann, T. Stabi- lizing training of generative adversarial networks through ?regularization. In

Advances in Neural Information Pro- cessing Systems 30: Annual Conference on Neural In- formation Processing Systems 2017, 4-9

December 2017, Long Beach, CA, USA, pp. 2015–2025, 2017.

[5] ?Mescheder, L. M., Nowozin, S., and Geiger, A. The numer- ics of gans. In Advances in Neural Information Process- ing Systems 30: Annual

Conference on Neural Informa- tion Processing Systems 2017, 4-9 December 2017, Long Beach, CA, USA, pp. 1823–1833, 2017.

[6] ?Salimans, T., Goodfellow, I., Zaremba, W., Cheung, V., Rad- ford, A., and Chen, X. Improved Techniques for Training GANs. In Advances in

Neural Information Processing Systems (NIPS), 2016.

[7] ?Heusel, M., Ramsauer, H., Unterthiner, T., Nessler, B., Klambauer, G., and Hochreiter, S. Gans trained by a two time-scale update rule

converge to a nash equilib- rium. In Advances in Neural Information Processing Systems (NIPS), 2017.

[8] ?Theis, L., Oord, A. v. d., and Bethge, M. A note on the eval- uation of generative models. In International Conference on Learning

Representations (ICLR), 2016.](https://image.slidesharecdn.com/icmlrinko-180728035855/85/Icml2018-_overview-GANs-34-320.jpg)