Information-Theoretic Metric Learning

- 1. Informa(on-?®\Theore(c ?Metric ?Learning ? Jason ?V. ?Davis, ?Brian ?Kulis, ? ? Prateek ?Jain, ?Suvrit ?Sra, ?Inderjit ?S. ?Dhillon ? (ICML ?2007 ?best ?paper) suzukake weekend ?reading ?group ?#2 ? 2013/04/20 ? ? ?ĮBĮķš▀ ?: ?matsuda 1 13/04/20 ?17:42░µ

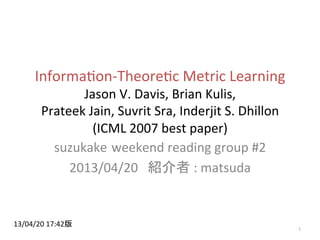

- 2. Metric ?Learningż╚żŽ║╬ż½ [1 ? ?0 ? ?0 ? ?1] [2 ? ?0 ? ?0 ? ?1] ó┘═¼ź»źķź╣ż╬╩┬└²ķgżŽĮ³żżż█ż”ż¼┴╝żż ? ó┌«Éź»źķź╣ż╬╩┬└²ķgżŽ▀hżżż█ż”ż¼┴╝żż ó┘ ó┌ źµ®`ź»źĻź├ź╔ŠÓļx ĘųŅɿʿõż╣żż(???) ŠÓļx┐šķgż“═ßżßżļ ź▐źŽźķź╬źėź╣ŠÓļx 2

- 3. äeż╬└²(Large ?Margin ?Nearest ?Neighbor) hYp://www.cse.wustl.edu/~kilian/code/page21/page21.html?żĶżĻ 3

- 4. å¢Ņ}įOČ© ?? ź▐źŽźķź╬źėź╣ŠÓļxż“č¦┴Ģż╣żļ ? ©C? ╠žÅš┴┐═¼╩┐ż╬ŠÓļxż“▒Ēż╣ąą┴ąż“č¦┴Ģż╣żļ ? ©C? ź½®`ź═źļżŪż╩żż╩┬ż╦ūóęŌŻ©ż┐ż└Ż¼ŽÓ╗źż╦ķvéSżŽżóżļ(īgżŽĄ╚ü²???)Ż® ? ?? ź½®`ź═źļ ?: ?ĪĖźŪ®`ź┐ķgĪ╣ż╬ŠÓļx ? ?? ź▐źŽźķź╬źėź╣ ?: ?ĪĖ╠žÅš┴┐ķgĪ╣ż╬ŠÓļx ? ?? ║╬ż╬ż┐żßż╦Ż┐ ? ©C? ÖCąĄč¦┴Ģż╬Ū░äI└Ēż╚żĘżŲĮMż▀▐zżÓ ? ?? Ąõą═Ą─ż╩└² ?: ?k-?®\NN ? ©C? semi-?®\supervised ?clustering ? ©C? ╠žÅš▀xÆkż╬ę╗░Ń╗»ż╚żŌčįż©żĮż” ? ?? ųžż▀ĖČż▒ + ?╠žÅš┴┐┐šķgżŪż╬╗ž▄× 4 Prasanta ?Chandra ?Mahalanobis ? 1893 1972

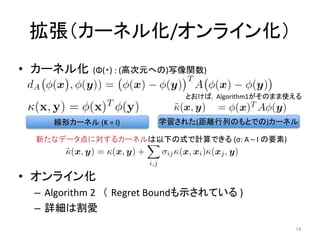

- 5. ▒Ššō╬─ż╬Contribu(on ?? Metric ?Learning ?ż“ ?LogDet ?Divergence ?ż╬ūŅ▀m╗» å¢Ņ}ż╚żĘżŲČ©╩Į╗» ? ©C? Bregman ?Projec(onż╚żżż”╩ųĘ©ż╦╗∙ż┼ż»ä┐┬╩Ą─ż╩źóźļ ź┤źĻź║źÓż“ī¦│÷ ? ©C? Ė▀╦┘ ( ?O(d2) ?d:┤╬į¬╩² ?)Ż¼ż¬ż¬żÓż═Ė▀Š½Č╚ ? ?? ź½®`ź═źļč¦┴Ģż╚ż╬ĮėŠA ? ©C? īgļHż╦żŽĄ╚ü²ż╩å¢Ņ}żŪżóżļż│ż╚ż“╩Šż╣ ? ?? ÆłÅł ?(Ģrķgż╬Č╝║Ž╔ŽŻ¼ż┴żńż├ż╚┤źżņżļż└ż▒) ? ©C? ź½®`ź═źļ╗» ? ©C? ź¬ź¾źķźżź¾╗» ? ?? Regret ?BoundżŌ╩ŠżĘżŲżżżļ 5

- 6. ź▐źŽźķź╬źėź╣ŠÓļxż╚żŽ x ? ?: ?źŪ®`ź┐ĄŃż“▒Ēż╣ź┘ź»ź╚źļ ? A ?: ?ź▐źŽźķź╬źėź╣ŠÓļxąą┴ąŻ©š²Č©éÄąą┴ąŻ® ? Aż¼ģg╬╗ąą┴ążŪżóżņżąŻ¼źµ®`ź»źĻź├ź╔ŠÓļxż╚ę╗ų┬ ? 1 ?0 ? 0 ?1 2 ?0 ? 0 ?1 2 ?1 ? 1 ?1 6

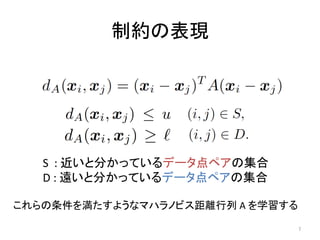

- 7. ųŲ╝sż╬▒Ē¼F S ? ?: ?Į³żżż╚Ęųż½ż├żŲżżżļźŪ®`ź┐ĄŃź┌źóż╬╝»║Ž ? D ?: ?▀hżżż╚Ęųż½ż├żŲżżżļźŪ®`ź┐ĄŃź┌źóż╬╝»║Ž ż│żņżķż╬╠§╝■ż“£║ż┐ż╣żĶż”ż╩ź▐źŽźķź╬źėź╣ŠÓļxąą┴ą ?A ?ż“č¦┴Ģż╣żļ 7

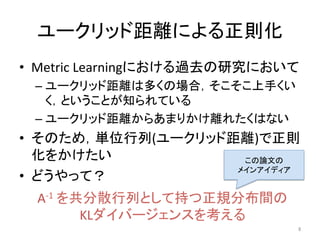

- 8. źµ®`ź»źĻź├ź╔ŠÓļxż╦żĶżļš²ät╗» ?? Metric ?Learningż╦ż¬ż▒żļ▀^╚źż╬蹊┐ż╦ż¬żżżŲ ? ©C?źµ®`ź»źĻź├ź╔ŠÓļxżŽČÓż»ż╬ł÷║ŽŻ¼żĮż│żĮż│╔Ž╩ųż»żż ż»Ż¼ż╚żżż”ż│ż╚ż¼ų¬żķżņżŲżżżļ ? ©C?źµ®`ź»źĻź├ź╔ŠÓļxż½żķżóż▐żĻż½ż▒ļxżņż┐ż»żŽż╩żż ? ?? żĮż╬ż┐żßŻ¼ģg╬╗ąą┴ą(źµ®`ź»źĻź├ź╔ŠÓļx)żŪš²ät ╗»ż“ż½ż▒ż┐żż ? ?? ż╔ż”żõż├żŲŻ┐ ? A-?®\1 ?ż“╣▓Ęų╔óąą┴ąż╚żĘżŲ│ųż─š²ęÄĘų▓╝ķgż╬ ? KLź└źżźą®`źĖź¦ź¾ź╣ż“┐╝ż©żļ ż│ż╬šō╬─ż╬ ? źßźżź¾źóźżźŪźŻźó 8

- 9. źµ®`ź»źĻź├ź╔ŠÓļxż╦żĶżļš²ät╗» p(x; ?A) ?: ?A-?®\1ż“╣▓Ęų╔óąą┴ąż╚żĘżŲ│ųż─š²ęÄĘų▓╝(ŲĮŠ∙żŽ┐╝ż©ż╩żż) ģg╬╗ąą┴ą ż╣żļż╚Ż¼ĮŌż»ż┘żŁūŅ▀m╗»å¢Ņ}żŽęįŽ┬ż╬żĶż”ż╦ż╩żļ 9

- 10. LogDet ?divergenceż╬ī¦╚ļ żĄżŁż█ż╔ż╬ūŅ▀m╗»å¢Ņ}żŽęįŽ┬ż╬żĶż”ż╦Ģ°ż▒żļ ųŲ╝sż“£║ż┐ż╣ĮŌż¼¤ożżł÷║ŽżŌżóżļ ? ?ŻĮŻŠ?ź╣źķź├ź»ēõ╩² ?”╬ ?ż“ī¦╚ļ ? ?: ?╩Į ?(4.5) ? n ?: ?ąą┴ąż╬źĄźżź║ ŲĮŠ∙ż¼Ą╚żĘżżČÓēõ┴┐š²ęÄĘų▓╝ķgż╬KLź└źżźą®`źĖź¦ź¾ź╣ : ?LogDet ?Divergence xTAx ?= ?tr(AxxT) ?żŪĢ°żŁōQż©żŲżļż└ż▒ 10

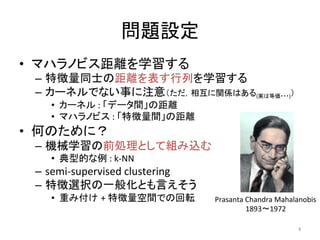

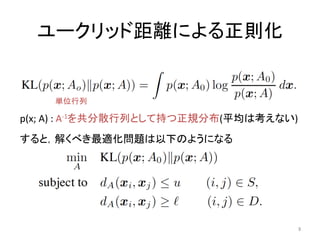

- 11. Bregman ?Projec(onż╦╗∙ż┼ż»č¦┴Ģ ?? [Kulis+, ?ICMLĪ»06]ż╦żĶżĻź½®`ź═źļč¦┴ĢżŪė├żżżķżņż┐╩ų Ę© ? ?? Algorithm ?1żŽź╣źķź├ź»ēõ╩²ż“┐╝æ]żĘżŲżżżļż┐żßč}ļj ż╦ęŖż©żļż¼,ęįŽ┬ż“└RżĻĘĄżĘżŲżżżļż└ż▒ ? 1.? ųŲ╝sż“ę╗éĆźįź├ź»źóź├źūż╣żļ ? 2.? ųŲ╝sż“£║ż┐ż╣żĶż”ż╦ŠÓļxąą┴ąż“ą▐š²ż╣żļ ? ėŗ╦Ń┴┐Ż║ ? ?żĮżņżŠżņż╬╔õė░ż╦ ?O(d2), ?céĆż╬ųŲ╝sż“ę╗č▓ż╣żļż╬ż╦żŽO(cd2) ? ?ķv▀B蹊┐żŪ▒žę¬ż╚żĄżņżŲżżż┐░ļš²Č©éÄėŗ╗Ł, ?╣╠ėąéÄĘųĮŌĄ╚ż“ż╚ż½ż╩ż»żŲ┴╝żż ? ?ģ¦╩°▒Żį^żŽż╩żĄżņżŲżżż╩żżż¼Ż¼īg“YĄ─ż╦żŽĖ▀╦┘(ßß╩÷) 11 ųŲ╝sż╬ĪĖĘĮŽ“Ī╣ Ė³ą┬Ę∙

- 12. Bregman ?Projec(on(źżźß®`źĖ) ųŲ╝s1 ? d(xi,xj) ?= ?u ųŲ╝s2 ? d(xi,xj) ?= ?l ”┬ ?Ż║ųŲ╝sż“£║ż┐ż╣ūŅąĪż╬Ė³ą┬Ę∙(ķ]żĖż┐ą╬żŪŪ¾ż▐żļ) ╔õė░ż“└RżĻĘĄż╣ż│ż╚żŪŻ¼ż╣ż┘żŲż╬ųŲ╝sż“£║ż┐ż╣Aż╦ģ¦╩°ż╣żļĪ∙ 12 ż│ż╬ćĒżŽŪÕ╦«żĄż¾ż╬ź╣źķźżź╔ hYp://www.r.dl.itc.u-?®\tokyo.ac.jp/study_ml/pukiwiki/index.php?schedule%2F2008-?®\07-?®\24 ?ż╦źżź¾ź╣źčźżźóżĄżņżŲżżż▐ż╣ ųŲ╝s1ż“£║ż┐ż╣ ┐šķg ųŲ╝s2ż“£║ż┐ż╣ ┐šķg Ī∙ųŲ╝sż¼╚²ż─ęį╔Žżóżļł÷║ŽżŽŻ¼ż╣ż┘żŲż╬ųŲ╝sż“£║ż┐ż╣ĄŃżŽę╗░Ńż╦żŽ┤µį┌żĘż╩żż(ź╣źķź├ź»ēõ╩²ż╬│÷Ę¼) ź│ź│żŪmin ?Dld(At,At+1)ż“ĄŻ▒Ż

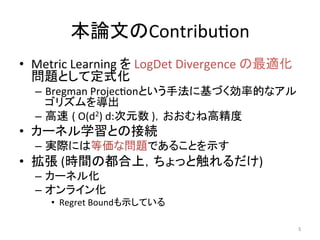

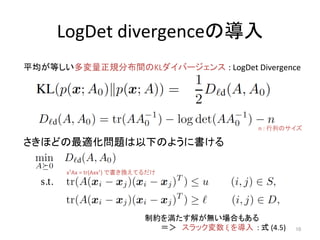

- 13. ź½®`ź═źļč¦┴Ģż╚ż╬ķv▀B X= ? x1 x2 x3 x4 d┤╬į¬ ŠÓļxąą┴ąA ®` ąą ┴ą K ż╚Ģ°ż▒żąŻ¼ęŖżļĘĮŽ“ż¼▀`ż”ż└ż▒żŪå¢Ņ}żŽĄ╚ü² Metric ?Learning Kernel ?Learning (Theorem ?1Ż║│§Ą╚Ą─ż╦į^├„żŪżŁżļ) üIš▀żŽĄ╚ü²ż╩ėŗ╦ŃżŪżóżļżµż©Ż║ ? Ė▀┤╬į¬╔┘╩┬└²(orĄ═┤╬į¬ČÓ╩┬└²) ? ż╬ł÷║ŽżŽ O(min{n,d}2) ?żŪėŗ╦Ń┐╔─▄ ? [Jain+ ?JMLR ?2012] ? ╩┬ └² ? 13

- 14. ÆłÅłŻ©ź½®`ź═źļ╗»/ź¬ź¾źķźżź¾╗»Ż® ?? ź½®`ź═źļ╗» (”Ą(?) ?: ?(Ė▀┤╬į¬żžż╬)ą┤Ž±ķv╩²) ? ?? ź¬ź¾źķźżź¾╗» ? ©C? Algorithm ?2?Ż© Regret ?BoundżŌ╩ŠżĄżņżŲżżżļ ?) ? ©C? įö╝ÜżŽĖŅÉ█ ? ŠĆą╬ź½®`ź═źļ ?(K ?= ?I) č¦┴ĢżĄżņż┐(ŠÓļxąą┴ąż╬żŌż╚żŪż╬)ź½®`ź═źļ ą┬ż┐ż╩źŪ®`ź┐ĄŃż╦īØż╣żļź½®`ź═źļżŽęįŽ┬ż╬╩ĮżŪėŗ╦ŃżŪżŁżļ ?(”ę: ?A ?©C ?I ?ż╬ę¬╦ž) 14 ż╚ż¬ż▒żąŻ¼Algorithm1ż¼żĮż╬ż▐ż▐╩╣ż©żļ

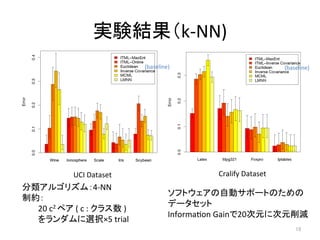

- 15. īg“YĮY╣¹Ż©k-?®\NN) UCI ?Dataset Cralify ?Dataset (baseline) (baseline) źĮźšź╚ź”ź¦źóż╬ūįäėźĄź▌®`ź╚ż╬ż┐żßż╬ ? źŪ®`ź┐ź╗ź├ź╚ ? Informa(on ?GainżŪ20┤╬į¬ż╦┤╬į¬Ž„£p ĘųŅÉźóźļź┤źĻź║źÓŻ║4-?®\NN ? ųŲ╝sŻ║ ? ? ?20 ?c2 ?ź┌źó ?( ?c ?: ?ź»źķź╣╩² ?) ? ?ż“źķź¾ź└źÓż╦▀xÆkĪ┴5 ?trial 15

- 16. īg“Y(╦┘Č╚, ?ź»źķź╣ź┐źĻź¾ź░) HMRF-?®\Kmeans ?: ?[Basu+ ?KDDĪ»04] ? ?Must-?®\link, ?Cannnot-?®\linkųŲ╝sż“ļLżņū┤æBż╚żĘżŲ│ųż─ź»źķź╣ź┐źĻź¾ź░ 16

- 17. ż▐ż╚żß / ?ĖąŽļ / ?╦ĮęŖ ?? Metric ?Learningż“Ż¼LogDetź└źżźą®`źĖź¦ź¾ź╣ż╬ūŅ▀m╗»ż╚żĘżŲČ©╩Į╗» ? ©C? ź½®`ź═źļč¦┴Ģż╚Ą╚ü²żŪżóżļż│ż╚ż“╩ŠżĘż┐Ż¼ÆłÅłŻ║ź½®`ź═źļ╗»Ż¼ź¬ź¾źķźżź¾╗» ? ?? ╩óżĻż└ż»żĄż¾ż╬─┌╚▌ŻĪ ? ©C? ź½®`ź═źļč¦┴Ģż╚ŠÓļxč¦┴Ģż╚żżż”Ż¼─«╚╗ż╚ķvéSżóżĻżĮż”ż╩żŌż╬ż“├„┤_ż╦ĮėŠAżĘżŲżżżŲ╦¼┐ņ ? ©C? ę¬╦ž╝╝ągżŽź½®`ź═źļč¦┴Ģ[Kulis+ ?ICMLĪ»06]żŪ╩╣ż’żņżŲżżżļżŌż╬ż╬╠żęuż╬żĶż”ż└ ? ?? ╦ĮęŖ(ķg▀`ż├żŲżżżļ┐╔─▄ąįĖ▀żĘŻĪ) ? ©C? ŠĆą╬ĘųļxżŪżŁż╩żżå¢Ņ}ż¼żŪżŁżļżĶż”ż╦ż╩żļż╬Ż┐? ? ?? Ī·?ģgż╩żļŠĆą╬ēõōQż╩ż╬żŪż╩żķż╩żżŻ« ▀mŪąż╦ź╣ź▒®`źĻź¾ź░żĄżņżŲż╩żżū┤ørżŪerror ?rateŽ┬ż▓żļä┐╣¹żŽżóżļż½żŌ ? ©C? Ū░äI└Ēż╗ż║SVMż╦ż½ż▒żļż╬ż╚ż╔ż├ż┴ż¼żżżżż╬Ż┐? ? ?? Ī·?ČÓż»ż╬ź▒®`ź╣żŪż└żżż┐żż═¼żĖż»żķżżżķżĘżż(k-?®\NNż¼«Éśöż╦ä┐ż»żĶż”ż╩ū┤ør│²ż») ?[ę¬│÷Ąõ] ? ©C? ź▐źŽźķź╬źėź╣ŠÓļxąą┴ąA ?ż╬ ĘŪīØĮŪę¬╦ž(╗ž▄×)ż╦żŽż╔ż¾ż╩ęŌ╬Čż¼żóżļż╬Ż┐? ? ?? Ī·?ż╔ż”ż╩ż¾żŪżĘżńż”????ź½®`ź═źļąą┴ąKż╬ĘŪīØĮŪę¬╦žż╦żŽ├„żķż½ż╦ęŌ╬Čż¼żóżļż╬żŪŻ¼┐╝ż©żņżąż’ż½żļż½żŌ ? ©C? żĮżŌżĮżŌĮ±żĄżķkNNż├żŲ???? ? ?? Ī·?ęŌ═Ōż╚ÅŖżżż├ż╣żĶŻ«źßźŌźĻż╦▌dżņżą+Į³░°╠Į╦„ż¼╦┘ż▒żņżą ? ©C? ż╔ż”żżż”Ģrż╦╩╣ż”Ż┐? ? ?? Ī·?Į╠ĤźŪ®`ź┐ż¼▓┐ĘųĄ─ż╦żĘż½¤ożżŻ¼č¦┴ĢżĄżņż┐MetricżĮż╬żŌż╬ż“╦¹ż╬ė├═Šż╦╩╣żżż┐żżū┤ørż╩ż╔ ? ©C? żĮżŌżĮżŌżĮżŌżĮżŌŻ¼ŠĆą╬ēõōQż¼ęŌ╬Čż“│ųż─ū┤ørż¼╦╝żżż─ż½ż╩żż??? ? ?? Ī·?ĘųŅÉŲ„ż¼ĘŪŠĆą╬ż╩ł÷║Ž(k-?®\NNż╩ż╔)żŽęŌ╬Čż¼żóżļżŽż║Ż«?ĘųŅÉŲ„ż¼ŠĆą╬ż╩ł÷║ŽżŽ???šlż½Į╠ż©żŲż»ż└żĄżżŻ« ?17

- 18. Further ?Reading ?? Ī░Metric ?and ?Kernel ?Learning ?Using ?a ?Linear ?Transforma(onĪ▒ ?[Jain+, ? ? JMLRĪ»12] ? ©C? ▒ŠčąŠ┐ż“║¼ż¾ż└źĖźŃ®`ź╩źļŻ¼żóż¾ż▐żĻšiż¾żŪż╩żż ? ?? Ī░Distance ?Metric ?Learning: ?A ?Comprehensive ?SurveyĪ▒ ?[Yang, ?2006] ? ©C? źĄ®`ź┘źżšō╬─Ż«ż┴żńż├ż╚╣┼żżż▒ż╔Ż¼╗∙▒ŠĄ─ż╩┐╝ż©ĘĮżŽĘųż½żĻżĮż” ? ?? Ī░Learning ?Low-?®\Rank ?Kernel ?MatricesĪ▒[Kulis+, ?ICMLĪ»06] ? ©C? ═¼ź┴®`źÓż╦żĶżļź½®`ź═źļč¦┴Ģż╬šō╬─Ż¼╗∙▒ŠĄ─ż╩źóźżźŪźŻźóżŽ═¼żĖ ? ©C? IBMŠ«│÷żĄż¾ż╦żĶżļĘųż½żĻżõż╣żżĮŌšhź╣źķźżź╔żóżĻ ? ?? ╚š▒ŠšZżŪšiżßżļżŌż╬ ? ©C? ŪÕ╦«żĄż¾ż╬ź╣źķźżź╔ ? ©C? źżź¾ź╚źĒĄ─ż╩ż╚ż│żĒżŽ╩ūČ╝┤¾ąĪŅ«Ž╚╔·ż╦żĶżļĮŌšhżŌżóżĻ ? ©C? Ī░ėŗ┴┐č¦┴Ģż“ė├żżż┐╗ŁŽ±Ś╩╦„ź©ź¾źĖź¾ż╚źóź╦źßŅåŅÉ╦ŲŚ╩╦„v3ż╦ż─żżżŲĪ▒ ? ?? ż½ż├ż│żżżżŻĪ ? ?? ūį╚╗čįšZäI└Ēżžż╬ÅĻė├└² ? ©C? ŅÉ┴xšZ½@Ą├ ?[Shimizu+, ?ColingĪ»08] ? ©C? Sen(ment ?Analysis ?ż╦ż¬ż▒żļ Domain ?Adapta(on ?[Dhillton+, ?ColingĪ»12] ? ©C? šZ┴xĢß├┴ąįĮŌŽ¹ ?[Sasaki ?and ?Shinnou, ?SEMAPROĪ»12][ū¶Ī®─Š,ą┬╝{, ?NLPĪ»11] 18

![Metric

?Learningż╚żŽ║╬ż½

[1

?

?0

?

?0

?

?1]

[2

?

?0

?

?0

?

?1]

ó┘═¼ź»źķź╣ż╬╩┬└²ķgżŽĮ³żżż█ż”ż¼┴╝żż

?

ó┌«Éź»źķź╣ż╬╩┬└²ķgżŽ▀hżżż█ż”ż¼┴╝żż

ó┘

ó┌

źµ®`ź»źĻź├ź╔ŠÓļx

ĘųŅɿʿõż╣żż(???)

ŠÓļx┐šķgż“═ßżßżļ

ź▐źŽźķź╬źėź╣ŠÓļx

2](https://image.slidesharecdn.com/itml-130420034613-phpapp01/85/Information-Theoretic-Metric-Learning-2-320.jpg)

![Bregman

?Projec(onż╦╗∙ż┼ż»č¦┴Ģ

?? [Kulis+,

?ICMLĪ»06]ż╦żĶżĻź½®`ź═źļč¦┴ĢżŪė├żżżķżņż┐╩ų

Ę©

?

?? Algorithm

?1żŽź╣źķź├ź»ēõ╩²ż“┐╝æ]żĘżŲżżżļż┐żßč}ļj

ż╦ęŖż©żļż¼,ęįŽ┬ż“└RżĻĘĄżĘżŲżżżļż└ż▒

?

1.? ųŲ╝sż“ę╗éĆźįź├ź»źóź├źūż╣żļ

?

2.? ųŲ╝sż“£║ż┐ż╣żĶż”ż╦ŠÓļxąą┴ąż“ą▐š²ż╣żļ

?

ėŗ╦Ń┴┐Ż║

?

?żĮżņżŠżņż╬╔õė░ż╦

?O(d2),

?céĆż╬ųŲ╝sż“ę╗č▓ż╣żļż╬ż╦żŽO(cd2)

?

?ķv▀B蹊┐żŪ▒žę¬ż╚żĄżņżŲżżż┐░ļš²Č©éÄėŗ╗Ł,

?╣╠ėąéÄĘųĮŌĄ╚ż“ż╚ż½ż╩ż»żŲ┴╝żż

?

?ģ¦╩°▒Żį^żŽż╩żĄżņżŲżżż╩żżż¼Ż¼īg“YĄ─ż╦żŽĖ▀╦┘(ßß╩÷)

11

ųŲ╝sż╬ĪĖĘĮŽ“Ī╣

Ė³ą┬Ę∙](https://image.slidesharecdn.com/itml-130420034613-phpapp01/85/Information-Theoretic-Metric-Learning-11-320.jpg)

![Bregman

?Projec(on(źżźß®`źĖ)

ųŲ╝s1

?

d(xi,xj)

?=

?u

ųŲ╝s2

?

d(xi,xj)

?=

?l

”┬

?Ż║ųŲ╝sż“£║ż┐ż╣ūŅąĪż╬Ė³ą┬Ę∙(ķ]żĖż┐ą╬żŪŪ¾ż▐żļ)

╔õė░ż“└RżĻĘĄż╣ż│ż╚żŪŻ¼ż╣ż┘żŲż╬ųŲ╝sż“£║ż┐ż╣Aż╦ģ¦╩°ż╣żļĪ∙

12

ż│ż╬ćĒżŽŪÕ╦«żĄż¾ż╬ź╣źķźżź╔ hYp://www.r.dl.itc.u-?®\tokyo.ac.jp/study_ml/pukiwiki/index.php?schedule%2F2008-?®\07-?®\24

?ż╦źżź¾ź╣źčźżźóżĄżņżŲżżż▐ż╣

ųŲ╝s1ż“£║ż┐ż╣

┐šķg

ųŲ╝s2ż“£║ż┐ż╣

┐šķg

Ī∙ųŲ╝sż¼╚²ż─ęį╔Žżóżļł÷║ŽżŽŻ¼ż╣ż┘żŲż╬ųŲ╝sż“£║ż┐ż╣ĄŃżŽę╗░Ńż╦żŽ┤µį┌żĘż╩żż(ź╣źķź├ź»ēõ╩²ż╬│÷Ę¼)

ź│ź│żŪmin

?Dld(At,At+1)ż“ĄŻ▒Ż](https://image.slidesharecdn.com/itml-130420034613-phpapp01/85/Information-Theoretic-Metric-Learning-12-320.jpg)

![ź½®`ź═źļč¦┴Ģż╚ż╬ķv▀B

X=

?

x1

x2

x3

x4

d┤╬į¬

ŠÓļxąą┴ąA

®`

ąą

┴ą

K

ż╚Ģ°ż▒żąŻ¼ęŖżļĘĮŽ“ż¼▀`ż”ż└ż▒żŪå¢Ņ}żŽĄ╚ü²

Metric

?Learning

Kernel

?Learning

(Theorem

?1Ż║│§Ą╚Ą─ż╦į^├„żŪżŁżļ)

üIš▀żŽĄ╚ü²ż╩ėŗ╦ŃżŪżóżļżµż©Ż║

?

Ė▀┤╬į¬╔┘╩┬└²(orĄ═┤╬į¬ČÓ╩┬└²)

?

ż╬ł÷║ŽżŽ O(min{n,d}2)

?żŪėŗ╦Ń┐╔─▄

?

[Jain+

?JMLR

?2012]

?

╩┬

└²

?

13](https://image.slidesharecdn.com/itml-130420034613-phpapp01/85/Information-Theoretic-Metric-Learning-13-320.jpg)

![īg“Y(╦┘Č╚,

?ź»źķź╣ź┐źĻź¾ź░)

HMRF-?®\Kmeans

?:

?[Basu+

?KDDĪ»04]

?

?Must-?®\link,

?Cannnot-?®\linkųŲ╝sż“ļLżņū┤æBż╚żĘżŲ│ųż─ź»źķź╣ź┐źĻź¾ź░

16](https://image.slidesharecdn.com/itml-130420034613-phpapp01/85/Information-Theoretic-Metric-Learning-16-320.jpg)

![ż▐ż╚żß /

?ĖąŽļ /

?╦ĮęŖ

?? Metric

?Learningż“Ż¼LogDetź└źżźą®`źĖź¦ź¾ź╣ż╬ūŅ▀m╗»ż╚żĘżŲČ©╩Į╗»

?

©C? ź½®`ź═źļč¦┴Ģż╚Ą╚ü²żŪżóżļż│ż╚ż“╩ŠżĘż┐Ż¼ÆłÅłŻ║ź½®`ź═źļ╗»Ż¼ź¬ź¾źķźżź¾╗»

?

?? ╩óżĻż└ż»żĄż¾ż╬─┌╚▌ŻĪ

?

©C? ź½®`ź═źļč¦┴Ģż╚ŠÓļxč¦┴Ģż╚żżż”Ż¼─«╚╗ż╚ķvéSżóżĻżĮż”ż╩żŌż╬ż“├„┤_ż╦ĮėŠAżĘżŲżżżŲ╦¼┐ņ

?

©C? ę¬╦ž╝╝ągżŽź½®`ź═źļč¦┴Ģ[Kulis+

?ICMLĪ»06]żŪ╩╣ż’żņżŲżżżļżŌż╬ż╬╠żęuż╬żĶż”ż└

?

?? ╦ĮęŖ(ķg▀`ż├żŲżżżļ┐╔─▄ąįĖ▀żĘŻĪ)

?

©C? ŠĆą╬ĘųļxżŪżŁż╩żżå¢Ņ}ż¼żŪżŁżļżĶż”ż╦ż╩żļż╬Ż┐?

?

?? Ī·?ģgż╩żļŠĆą╬ēõōQż╩ż╬żŪż╩żķż╩żżŻ« ▀mŪąż╦ź╣ź▒®`źĻź¾ź░żĄżņżŲż╩żżū┤ørżŪerror

?rateŽ┬ż▓żļä┐╣¹żŽżóżļż½żŌ

?

©C? Ū░äI└Ēż╗ż║SVMż╦ż½ż▒żļż╬ż╚ż╔ż├ż┴ż¼żżżżż╬Ż┐?

?

?? Ī·?ČÓż»ż╬ź▒®`ź╣żŪż└żżż┐żż═¼żĖż»żķżżżķżĘżż(k-?®\NNż¼«Éśöż╦ä┐ż»żĶż”ż╩ū┤ør│²ż»)

?[ę¬│÷Ąõ]

?

©C? ź▐źŽźķź╬źėź╣ŠÓļxąą┴ąA

?ż╬ ĘŪīØĮŪę¬╦ž(╗ž▄×)ż╦żŽż╔ż¾ż╩ęŌ╬Čż¼żóżļż╬Ż┐?

?

?? Ī·?ż╔ż”ż╩ż¾żŪżĘżńż”????ź½®`ź═źļąą┴ąKż╬ĘŪīØĮŪę¬╦žż╦żŽ├„żķż½ż╦ęŌ╬Čż¼żóżļż╬żŪŻ¼┐╝ż©żņżąż’ż½żļż½żŌ

?

©C? żĮżŌżĮżŌĮ±żĄżķkNNż├żŲ????

?

?? Ī·?ęŌ═Ōż╚ÅŖżżż├ż╣żĶŻ«źßźŌźĻż╦▌dżņżą+Į³░°╠Į╦„ż¼╦┘ż▒żņżą

?

©C? ż╔ż”żżż”Ģrż╦╩╣ż”Ż┐?

?

?? Ī·?Į╠ĤźŪ®`ź┐ż¼▓┐ĘųĄ─ż╦żĘż½¤ożżŻ¼č¦┴ĢżĄżņż┐MetricżĮż╬żŌż╬ż“╦¹ż╬ė├═Šż╦╩╣żżż┐żżū┤ørż╩ż╔

?

©C? żĮżŌżĮżŌżĮżŌżĮżŌŻ¼ŠĆą╬ēõōQż¼ęŌ╬Čż“│ųż─ū┤ørż¼╦╝żżż─ż½ż╩żż???

?

?? Ī·?ĘųŅÉŲ„ż¼ĘŪŠĆą╬ż╩ł÷║Ž(k-?®\NNż╩ż╔)żŽęŌ╬Čż¼żóżļżŽż║Ż«?ĘųŅÉŲ„ż¼ŠĆą╬ż╩ł÷║ŽżŽ???šlż½Į╠ż©żŲż»ż└żĄżżŻ«

?17](https://image.slidesharecdn.com/itml-130420034613-phpapp01/85/Information-Theoretic-Metric-Learning-17-320.jpg)

![Further

?Reading

?? Ī░Metric

?and

?Kernel

?Learning

?Using

?a

?Linear

?Transforma(onĪ▒

?[Jain+,

?

?

JMLRĪ»12]

?

©C? ▒ŠčąŠ┐ż“║¼ż¾ż└źĖźŃ®`ź╩źļŻ¼żóż¾ż▐żĻšiż¾żŪż╩żż

?

?? Ī░Distance

?Metric

?Learning:

?A

?Comprehensive

?SurveyĪ▒

?[Yang,

?2006]

?

©C? źĄ®`ź┘źżšō╬─Ż«ż┴żńż├ż╚╣┼żżż▒ż╔Ż¼╗∙▒ŠĄ─ż╩┐╝ż©ĘĮżŽĘųż½żĻżĮż”

?

?? Ī░Learning

?Low-?®\Rank

?Kernel

?MatricesĪ▒[Kulis+,

?ICMLĪ»06]

?

©C? ═¼ź┴®`źÓż╦żĶżļź½®`ź═źļč¦┴Ģż╬šō╬─Ż¼╗∙▒ŠĄ─ż╩źóźżźŪźŻźóżŽ═¼żĖ

?

©C? IBMŠ«│÷żĄż¾ż╦żĶżļĘųż½żĻżõż╣żżĮŌšhź╣źķźżź╔żóżĻ

?

?? ╚š▒ŠšZżŪšiżßżļżŌż╬

?

©C? ŪÕ╦«żĄż¾ż╬ź╣źķźżź╔

?

©C? źżź¾ź╚źĒĄ─ż╩ż╚ż│żĒżŽ╩ūČ╝┤¾ąĪŅ«Ž╚╔·ż╦żĶżļĮŌšhżŌżóżĻ

?

©C? Ī░ėŗ┴┐č¦┴Ģż“ė├żżż┐╗ŁŽ±Ś╩╦„ź©ź¾źĖź¾ż╚źóź╦źßŅåŅÉ╦ŲŚ╩╦„v3ż╦ż─żżżŲĪ▒

?

?? ż½ż├ż│żżżżŻĪ

?

?? ūį╚╗čįšZäI└Ēżžż╬ÅĻė├└²

?

©C? ŅÉ┴xšZ½@Ą├

?[Shimizu+,

?ColingĪ»08]

?

©C? Sen(ment

?Analysis

?ż╦ż¬ż▒żļ Domain

?Adapta(on

?[Dhillton+,

?ColingĪ»12]

?

©C? šZ┴xĢß├┴ąįĮŌŽ¹

?[Sasaki

?and

?Shinnou,

?SEMAPROĪ»12][ū¶Ī®─Š,ą┬╝{,

?NLPĪ»11]

18](https://image.slidesharecdn.com/itml-130420034613-phpapp01/85/Information-Theoretic-Metric-Learning-18-320.jpg)