Interactive perception(IP): ロボットの知覚に関する研究紹介

- 1. Interactive perception(IP): ロボットの知覚における興味深いアプローチ [1] Bohg, J., et al. "Interactive perception: Leveraging action in perception and perception in action", IEEE Transactions on Robotics, Vol.33, No.6, pp.1273-1291, 2017. [2] Atkeson, C. et al., "No falls, no resets: Reliable humanoid behaviour in the DARPA robotics challenge", 15th IEEE/RAS International Conference Humanoid Robots, pp. 623–630, 2015. [3] Johnson, M. et al., "Team IHMC’s lessons learned from the DARPA robotics challenge trials", Journal of Field Robotics, Vol. 32, No. 2, pp. 192–208, 2015. [4] Held, R. and Hein, A., "Movement-produced stimulation in the development of visually guided behaviour", J. Comparative Physiol. Psychol., Vol.56, pp.872–876, 1963. [5] Gibson, J. J., "The Senses Considered as Perceptual Systems", Houghton Mif?in, 1966. 発表者: 大阪大学石黒研究室 博士後期課程3年 浦井健次 Posture sensor ?(?) センサ情報 ?(?) 行動パラメータ 例)モータ出力等 ロボットが行動することで環境を操作し「予測」や「認識」に必要な情報を能動的に得る センサ情報(S(t))と行動 パラメータ(A(t))を組み 合わせ(S×A×t),予測や 認識を容易にする 論文調査発表会資料 前編 ~Physical human-robot interaction (pHRI)に関する重要な視点について考える~

- 2. ●生活空間では予測困難な接触が避けられない はじめに:生活の中の接触タスク 1/14 ① 環境との相互作用 による知覚 ② 外乱に対する多様 な接触応答 今回の内容 (IP) 次回の内容 (VSM) 環境との相互作用を考慮すると,そうでない場合と 比較して多様な入力表現が得られる → 知覚=環境との相互作用によって促進される → 認識の精度や速度が上がるなどの効果が期待

- 3. ● 人の生活空間でロボットが活動するためには高い柔軟性が必要(優位に働く) 避けられない「環境との物理的なインタラクション」 がロボットの動作に影響を与える 予期せぬ接触 生活空間 ② ハードウェアの柔軟性 : 多様な外乱に対応 できる構造?機構 → 例)VSM:次回 ① ソフトウェアの柔軟性 : 多様な環境に適応 する柔軟な制御システム → 例)IP:今回 はじめに:生活空間の中で活動するロボット 2/14

- 4. 概要: Interactive perception (IP): ① ロボットの知覚における近年注目されているア プローチのひとつ(Darpa Robotics Challenge 出場者らもIPを 活用することでより高い自律性を持たせることができると注目[2][3]) ② センサ情報(S(t))とアクチュエータ情報(A(t))を組 み合わせて(S×A×t), 予測や認識を容易にする IPの重要なアプリケーションの概要を説明 Interactive perception: Leveraging action in perception and perception in action[1](Bohg, J., et al. 2017) 3/14 [1] Bohg, J., et al. "Interactive perception: Leveraging action in perception and perception in action", IEEE Transactions on Robotics, Vol.33, No.6, pp.1273-1291, 2017. [2] Atkeson, C. et al., "No falls, no resets: Reliable humanoid behavior in the DARPA robotics challenge", 15th IEEE/RAS International Conference Humanoid Robots, pp. 623– 630, 2015.[3] Johnson, M. et al., "Team IHMC’s lessons learned from the DARPA robotics challenge trials", Journal of Field Robotics, Vol. 32, No. 2, pp. 192–208, 2015. Bohg, J., et al. “Interactive perception: Leveraging action in perception and perception in action”(2017). Posture sensor ?(?) センサ情報 ?(?) 行動パラメータ 例)モータ出力等

- 5. 概要: Interactive perception (IP): ① ロボットの知覚における近年注目されているア プローチのひとつ(Darpa Robotics Challenge 出場者らもIPを 活用することでより高い自律性を持たせることができると注目[2][3]) ② センサ情報(S(t))とアクチュエータ情報(A(t))を組 み合わせて(S×A×t), 予測や認識を容易にする IPの重要なアプリケーションの概要を説明 Interactive perception: Leveraging action in perception and perception in action[1](Bohg, J., et al. 2017) 3/14 [1] Bohg, J., et al. "Interactive perception: Leveraging action in perception and perception in action", IEEE Transactions on Robotics, Vol.33, No.6, pp.1273-1291, 2017. [2] Atkeson, C. et al., "No falls, no resets: Reliable humanoid behavior in the DARPA robotics challenge", 15th IEEE/RAS International Conference Humanoid Robots, pp. 623– 630, 2015.[3] Johnson, M. et al., "Team IHMC’s lessons learned from the DARPA robotics challenge trials", Journal of Field Robotics, Vol. 32, No. 2, pp. 192–208, 2015. Bohg, J., et al. “Interactive perception: Leveraging action in perception and perception in action”(2017). Posture sensor ?(?) センサ情報 ?(?) 行動パラメータ 例)モータ出力等 [2] Atkeson, C. et al. [3] Johnson, M. et al.

- 6. 人を含む動物の知覚?認識=IPのような,インタラクティブな探索的なプロセス 生物学的な知覚プロセス(1/2) [4](Held, R. & Hein, A., 1963) 4/14 [4] Held, R. and Hein, A., "Movement-produced stimulation in the development of visually guided behaviour", J. Comparative Physiol. Psychol., Vol.56, pp.872–876, 1963. Bohg, J., et al. “Interactive perception: Leveraging action in perception and perception in action”(2017). ゴンドラネコと自由移動ネコ Heldの実験 [4]: 条件)誕生時から暗闇の中で育てた同腹の子ネコ5対 (A,B)が歩けるようになるのを待ち特殊な視覚経験を与える ? Aは自分の足で歩いて空間内を移動(能動的) ? BはAの動きに応じて動くゴンドラに乗せ移動(受動的) ※経験する視覚刺激は同じ 結果)Bにも歩く能力があるにも関わらず「生存に不可欠な 視覚行動」が見られなかった→「見え」が形成されていない ※着地姿勢、視覚的崖回避、瞬目反射など →能動的に体を動かし環境とインタラクションする視 覚体験が必要(体の動きと「見え」の変化の因果) 認識において「自ら環境を変える動き(能動的な探 索行動)」から得られる情報こそ最も本質的な情報 図 (Yuji, I., 2017) A B

- 7. 人を含む動物の知覚?認識=IPのような,インタラクティブな探索的なプロセス 5/14 [5] Gibson, J. J., "The Senses Considered as Perceptual Systems", Houghton Mif?in, 1966. Bohg, J., et al. “Interactive perception: Leveraging action in perception and perception in action”(2017). 不規則な形状の物体の集合 Gibsonの実験 [5]: タスク)被験者らが右図のような不規則な形状の三次元 物体の集合の中から基準物体を見つける 結果) ? 画像のみ表示:平均精度49% ? 画像を回転可能:平均精度72% ? 物体を手で触ることが可能:平均精度99% →対象との物理的インタラクションが知覚処理を助長 生物学的な知覚プロセス(2/2) [5](Gibson, J. J., 1966) 基準物体の例 ●生物学的な知覚 → 「視覚的な認識」と「触覚による探索」の関係を経験的に理解し知覚 ●コンピュータビジョン → 事前知識や様々な仮定を利用し画像に意味付けを行う ※Pascal VOC ,ImageNet ,Microsoft COCO など、数十万の意味付けされた大量のデータセットで成功 ●ロボットビジョン → 環境内を移動して物理的に相互作用する知覚 → IP 触る行動で知覚が向上

- 8. インタラクティブ?パーセプション(IP): ロボット知覚における近年のアプローチを包含する概念 → 環境とのあらゆる種類の相互作用を活用し知覚を単純化?強化し堅牢な操作?行動を実現 ●相互作用:①エージェントの移動 ②環境との接触 例)脚式?車輪移動/ドアの開閉?物体を押す?磁力… ●IPのメリット: 1)多様な感覚入力信号の生成(Create Novel Signals :CNS) → 触覚?音声?視覚データ,オブジェクトの重さ?表面の材質?剛性… 2)センサ情報と行動パラメータを組み合わせた認識(Action Perception Regularity :APR) → 時間t?センサ情報S?行動パラメータAの結合空間(S×A×t)における規則性を学習 → ある環境下における行動とセンサ反応の因果関係を理解することに対応 → この知識を利用することにより「予測」と「認識」がより簡単かつ堅牢になる ロボットが環境を操作し「予測」や「認識」に必要な情報を能動的に得ることが主な目的 6/14 Bohg, J., et al. “Interactive perception: Leveraging action in perception and perception in action”(2017). インタラクティブ?パーセプション(IP):相互作用を活用した認識

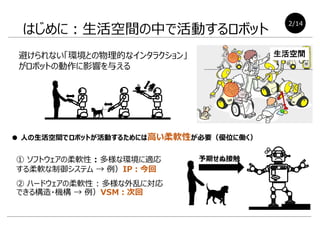

- 9. ① Sensorless Manipulation:センシングを必要としないアプローチ → 環境から受ける応答を考慮せずセンサからのフィードバックなしにオープンループで操作 ② Perception of Visual Data:静止画像?ビデオ?他の視覚データの解釈?認識 → コンピュータビジョンのアプローチの大部分は生物やロボットの認識の能動的な性質を完全に無視 ③ Active Perception:知覚?認識のためのデータ取得プロセスに知的な戦略を導入 → エージェントが「なぜそのデータが必要か」を知っており次に取得する知覚データを選択(不確実性減) → その知覚データをいつどこで取得するかを決定する能動的な知覚 ●APとIPの差異(IPには以下の性質がある) 1) 物理的相互作用により得られる情報を含む (重量?表面粗さ?硬度などの物体特性) 2) 見え方だけでなく環境そのものを変化させる ④ Active Haptic Perception: 環境との接触(触覚情報)を活用した認識 →形状認識?姿勢推定?表面粗さ認識など… →環境の変化自体が目的でないがIPの一部 IPと他の知覚アプローチの関連.Fは環境を操作する, ?Fは感覚装置のパラメータのみ操作するアクション 7/14 ロボット知覚におけるIPの位置づけ Bohg, J., et al. “Interactive perception: Leveraging action in perception and perception in action”(2017). S × A × t S × A × t S × t S A × t S × A × t

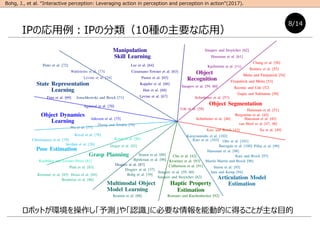

- 10. ロボットが環境を操作し「予測」や「認識」に必要な情報を能動的に得ることが主な目的 8/14 Bohg, J., et al. “Interactive perception: Leveraging action in perception and perception in action”(2017). IPの応用例:IPの分類(10種の主要な応用)

- 11. ロボットが環境を操作し「予測」や「認識」に必要な情報を能動的に得ることが主な目的 8/14 Bohg, J., et al. “Interactive perception: Leveraging action in perception and perception in action”(2017). IPの応用例:IPの分類(10種の主要な応用) ①オブジェクトセグメンテーション ②運動モデルの推定 ③ダイナミクス学習と物性推定

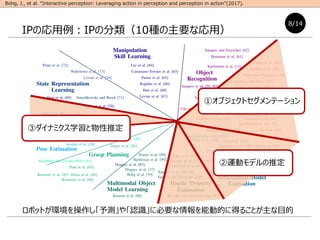

- 12. 9/14 Bohg, J., et al. “Interactive perception: Leveraging action in perception and perception in action”(2017). IPの応用例:①オブジェクトセグメンテーション ① 視点変更可能 ●オブジェクトセグメンテーション(Object Segmentation) → Computer Visionの分野では多くの場合単一のイメージで実行 問題設定)テーブルに固定された2つのレゴブロックの数をロボットが推定 ① 完全なパッシブオブザーバ:正確な数を推定することは困難 ② ロボットが環境とインタラクションする別のエージェントを観察:正しく推定可能 → 相互作用による多様な感覚シグナル(CNS)を如何にして作り出すかの例 ③ ロボットが自律的に必要な感覚情報を生成することが可能:正しく推定可能 → S×A×tの規則性についての推論(APR):推定の不確実性を低減 ②人が持ち上げる ③ロボットが干渉 Object Segmentationの例 ? 1つ?2つ? ! 2つだ! ! 2つだ!

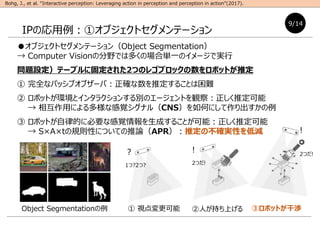

- 13. Bohg, J., et al. “Interactive perception: Leveraging action in perception and perception in action”(2017). IPの応用例:②運動モデルの推定 ① 視点変更可能 オブジェクトの運動モデルの推定:1)物体間の運動が拘束されているか否か 2)拘束 条件は何か(ヒンジジョイント?球面関節?など)を理解する必要がある 問題設定)テーブルに固定された2つのレゴブロックの運動モデルをロボットが推定 ① 完全なパッシブオブザーバ:構造の推定はほとんど不可能 ② ロボットが環境とインタラクションする別のエージェントを観察:「直動関節」と推定 → 相互作用による多様な感覚シグナル(CNS)が正確な情報でない例 ③ ロボットが自律的に必要な感覚情報を生成することが可能:正しいモデルを推定可能 → S×A×tの規則性についての推論(APR)により得られた知識によって,一定以上 の垂直力を加えることで自由運動する正しいモデルを得ることが可能 ②人が持ち上げる ③ロボットが干渉 拘束条件(関節の種類)の例 10/14 ? どう動く? 動かない? ! 直動! 直動関節だ!→ 誤り ! どんな 方向 にも 動く! 自由運動だ!

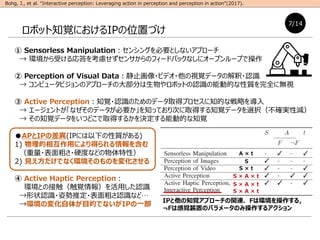

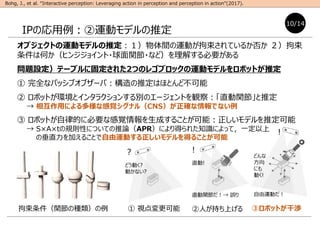

- 14. Bohg, J., et al. “Interactive perception: Leveraging action in perception and perception in action”(2017). IPの応用例:③ダイナミクス学習と物性推定 IPにより物体の触覚および慣性特性を推定するという課題にも大きな進展 ① 視点変更可能 ②人が押す ③ロボットが押す 問題設定)テーブルに置かれた球体重量をロボットが推定 ※ロボットが [押し込み力?球が移動した距離?球の重量] の関係を知っていると仮定(事前知識) ① 完全なパッシブオブザーバ:慣性特性の推定は不可能 ② ロボットが環境とインタラクションする別のエージェントを観察:不確かな推定値 → 相互作用による多様な感覚シグナル(CNS)だけでは推定できない例:押した力の情報の欠如 ③ ロボットが自律的に必要な感覚情報を生成することが可能:正しい慣性特性を推定可能 → S×A×tの規則性についての推論(APR)により得られた知識(ロボットが球体を押した 強さ)により,球体の慣性特性(重量)を推定することができる 剛体(RO)か?変形可能(DO)か? rigid objects deformable 11/14 ? 重い? 軽い? ? 押した力が分からないから なんともいえない??? ! これだけの力で押せばこれだけ移動 したのだから球の重さは決まりだ!

- 15. IPアプローチを特徴づける項目で,既存の手法を詳細に分類 Bohg, J., et al. “Interactive perception: Leveraging action in perception and perception in action”(2017). IPの分類 12/14

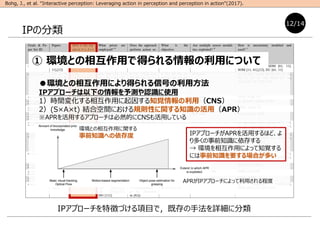

- 16. IPアプローチを特徴づける項目で,既存の手法を詳細に分類 Bohg, J., et al. “Interactive perception: Leveraging action in perception and perception in action”(2017). IPの分類 ●環境との相互作用により得られる信号の利用方法 IPアプローチは以下の情報を予測や認識に使用 1)時間変化する相互作用に起因する知覚情報の利用(CNS) 2)(S×A×t) 結合空間における規則性に関する知識の活用(APR) ※APRを活用するアプローチは必然的にCNSも活用している 12/14 APRがIPアプローチによって利用される程度 環境との相互作用に関する 事前知識への依存度 IPアプローチがAPRを活用するほど、よ り多くの事前知識に依存する → 環境を相互作用によって知覚する には事前知識を要する場合が多い ① 環境との相互作用で得られる情報の利用について

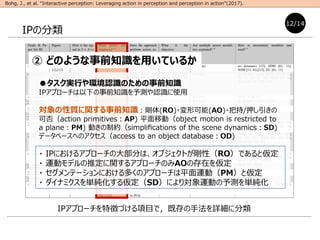

- 17. IPアプローチを特徴づける項目で,既存の手法を詳細に分類 Bohg, J., et al. “Interactive perception: Leveraging action in perception and perception in action”(2017). IPの分類 ●タスク実行や環境認識のための事前知識 IPアプローチは以下の事前知識を予測や認識に使用 対象の性質に関する事前知識:剛体(RO)?変形可能(AO)?把持/押し引きの 可否(action primitives:AP) 平面移動(object motion is restricted to a plane:PM) 動きの制約(simpli?cations of the scene dynamics:SD) データベースへのアクセス(access to an object database:OD) ? IPにおけるアプローチの大部分は、オブジェクトが剛性(RO)であると仮定 ? 運動モデルの推定に関するアプローチのみAOの存在を仮定 ? セグメンテーションにおける多くのアプローチは平面運動(PM)と仮定 ? ダイナミクスを単純化する仮定(SD)により対象運動の予測を単純化 12/14 ② どのような事前知識を用いているか

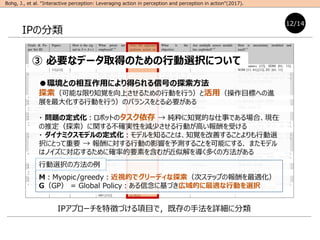

- 18. IPアプローチを特徴づける項目で,既存の手法を詳細に分類 Bohg, J., et al. “Interactive perception: Leveraging action in perception and perception in action”(2017). IPの分類 ●環境との相互作用により得られる信号の探索方法 探索(可能な限り知覚を向上させるための行動を行う)と活用(操作目標への進 展を最大化する行動を行う)のバランスをとる必要がある ? 問題の定式化:ロボットのタスク依存 → 純粋に知覚的な仕事である場合、現在 の推定(探索)に関する不確実性を減少させる行動が高い報酬を受ける ? ダイナミクスモデルの定式化:モデルを知ることは、知覚を改善することよりも行動選 択にとって重要 → 報酬に対する行動の影響を予測することを可能にする.またモデル はノイズに対応するために確率的要素を含むが近似解を導く多くの方法がある M:Myopic/greedy:近視的でグリーディな探索(次ステップの報酬を最適化) G(GP) = Global Policy:ある信念に基づき広域的に最適な行動を選択 12/14 ③ 必要なデータ取得のための行動選択について 行動選択の方法の例

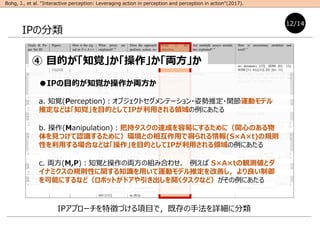

- 19. IPアプローチを特徴づける項目で,既存の手法を詳細に分類 Bohg, J., et al. “Interactive perception: Leveraging action in perception and perception in action”(2017). IPの分類 ●IPの目的が知覚か操作か両方か a. 知覚(Perception):オブジェクトセグメンテーション?姿勢推定?関節運動モデル 推定などは「知覚」を目的としてIPが利用される領域の例にあたる b. 操作(Manipulation):把持タスクの達成を容易にするために(関心のある物 体を見つけて認識するために)環境との相互作用で得られる情報(S×A×t)の規則 性を利用する場合などは「操作」を目的としてIPが利用される領域の例にあたる c. 両方(M,P):知覚と操作の両方の組み合わせ. 例えば S×A×tの観測値とダ イナミクスの規則性に関する知識を用いて運動モデル推定を改善し,より良い制御 を可能にするなど(ロボットがドアや引き出しを開くタスクなど)がその例にあたる 12/14 ④ 目的が「知覚」か「操作」か「両方」か

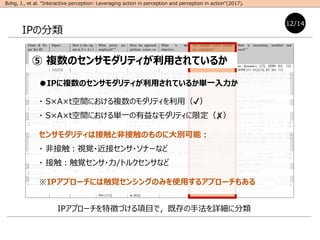

- 20. IPアプローチを特徴づける項目で,既存の手法を詳細に分類 Bohg, J., et al. “Interactive perception: Leveraging action in perception and perception in action”(2017). IPの分類 ●IPに複数のセンサモダリティが利用されているか単一入力か ? S×A×t空間における複数のモダリティを利用(?) ? S×A×t空間における単一の有益なモダリティに限定(?) センサモダリティは接触と非接触のものに大別可能: ? 非接触:視覚?近接センサ?ソナーなど ? 接触:触覚センサ?力/トルクセンサなど ※IPアプローチには触覚センシングのみを使用するアプローチもある 12/14 ⑤ 複数のセンサモダリティが利用されているか

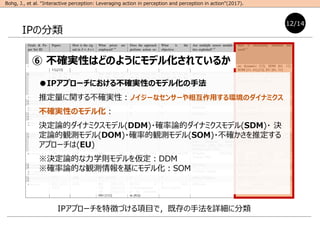

- 21. IPアプローチを特徴づける項目で,既存の手法を詳細に分類 Bohg, J., et al. “Interactive perception: Leveraging action in perception and perception in action”(2017). IPの分類 ●IPアプローチにおける不確実性のモデル化の手法 推定量に関する不確実性:ノイジーなセンサーや相互作用する環境のダイナミクス 不確実性のモデル化: 決定論的ダイナミクスモデル(DDM)?確率論的ダイナミクスモデル(SDM)? 決 定論的観測モデル(DOM)?確率的観測モデル(SOM)?不確かさを推定する アプローチは(EU) ※決定論的な力学則モデルを仮定:DDM ※確率論的な観測情報を基にモデル化:SOM 12/14 ⑥ 不確実性はどのようにモデル化されているか

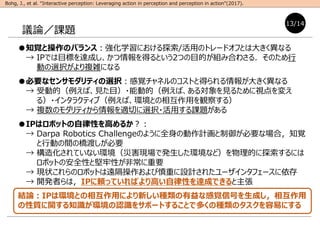

- 22. ●知覚と操作のバランス:強化学習における探索/活用のトレードオフとは大きく異なる → IPでは目標を達成し、かつ情報を得るという2つの目的が組み合わさる.そのため行 動の選択がより複雑になる ●必要なセンサモダリティの選択:感覚チャネルのコストと得られる情報が大きく異なる → 受動的(例えば、見た目)?能動的(例えば、ある対象を見るために視点を変え る)?インタラクティブ(例えば、環境との相互作用を観察する) → 複数のモダリティから情報を適切に選択?活用する課題がある ●IPはロボットの自律性を高めるか?: → Darpa Robotics Challengeのように全身の動作計画と制御が必要な場合,知覚 と行動の間の橋渡しが必要 → 構造化されていない環境(災害現場で発生した環境など)を物理的に探索するには ロボットの安全性と堅牢性が非常に重要 → 現状これらのロボットは遠隔操作および慎重に設計されたユーザインタフェースに依存 → 開発者らは,IPに頼っていればより高い自律性を達成できると主張 結論:IPは環境との相互作用により新しい種類の有益な感覚信号を生成し,相互作用 の性質に関する知識が環境の認識をサポートすることで多くの種類のタスクを容易にする Bohg, J., et al. “Interactive perception: Leveraging action in perception and perception in action”(2017). 議論/課題 13/14

- 23. ●生活空間では予測困難な接触が避けられない まとめ:生活の中の接触タスク 15/15 ① 環境との相互作用 による知覚 ② 外乱に対する多様 な接触応答 次回:可変剛性 →剛性制御 今回:IP

- 24. ●生活空間では予測困難な接触が避けられない まとめ:生活の中の接触タスク 15/15 ① 環境との相互作用 による知覚 ② 外乱に対する多様 な接触応答 次回:可変剛性 →剛性制御 今回:IP ① IPによる認識によるロボット制御の簡易化 世界のすべてを教え込み制御するのは現実的でない.物理的インタラクションを含 む知識による世界の認識が必須 ② 多様な外乱に適切に応答する剛性制御 予期せぬ外乱に対して適応的な剛性特性を実現(例えばSFR最適化を用いて)

![Interactive perception(IP): ロボットの知覚における興味深いアプローチ

[1] Bohg, J., et al. "Interactive perception: Leveraging action in perception and perception in action", IEEE Transactions on Robotics, Vol.33,

No.6, pp.1273-1291, 2017.

[2] Atkeson, C. et al., "No falls, no resets: Reliable humanoid behaviour in the DARPA robotics challenge", 15th IEEE/RAS International Conference Humanoid

Robots, pp. 623–630, 2015.

[3] Johnson, M. et al., "Team IHMC’s lessons learned from the DARPA robotics challenge trials", Journal of Field Robotics, Vol. 32, No. 2, pp. 192–208, 2015.

[4] Held, R. and Hein, A., "Movement-produced stimulation in the development of visually guided behaviour", J. Comparative Physiol. Psychol., Vol.56,

pp.872–876, 1963.

[5] Gibson, J. J., "The Senses Considered as Perceptual Systems", Houghton Mif?in, 1966.

発表者: 大阪大学石黒研究室 博士後期課程3年 浦井健次

Posture sensor ?(?)

センサ情報

?(?)

行動パラメータ

例)モータ出力等

ロボットが行動することで環境を操作し「予測」や「認識」に必要な情報を能動的に得る

センサ情報(S(t))と行動

パラメータ(A(t))を組み

合わせ(S×A×t),予測や

認識を容易にする

論文調査発表会資料 前編 ~Physical human-robot interaction (pHRI)に関する重要な視点について考える~](https://image.slidesharecdn.com/d3interactiveperception-220927090646-6a91c861/85/Interactive-perception-IP-1-320.jpg)

![概要:

Interactive perception (IP):

① ロボットの知覚における近年注目されているア

プローチのひとつ(Darpa Robotics Challenge 出場者らもIPを

活用することでより高い自律性を持たせることができると注目[2][3])

② センサ情報(S(t))とアクチュエータ情報(A(t))を組

み合わせて(S×A×t), 予測や認識を容易にする

IPの重要なアプリケーションの概要を説明

Interactive perception: Leveraging action in perception

and perception in action[1](Bohg, J., et al. 2017)

3/14

[1] Bohg, J., et al. "Interactive perception: Leveraging action in perception and perception in action", IEEE Transactions on Robotics, Vol.33, No.6, pp.1273-1291, 2017. [2]

Atkeson, C. et al., "No falls, no resets: Reliable humanoid behavior in the DARPA robotics challenge", 15th IEEE/RAS International Conference Humanoid Robots, pp. 623–

630, 2015.[3] Johnson, M. et al., "Team IHMC’s lessons learned from the DARPA robotics challenge trials", Journal of Field Robotics, Vol. 32, No. 2, pp. 192–208, 2015.

Bohg, J., et al. “Interactive perception: Leveraging action in perception and perception in action”(2017).

Posture sensor

?(?)

センサ情報

?(?)

行動パラメータ

例)モータ出力等](https://image.slidesharecdn.com/d3interactiveperception-220927090646-6a91c861/85/Interactive-perception-IP-4-320.jpg)

![概要:

Interactive perception (IP):

① ロボットの知覚における近年注目されているア

プローチのひとつ(Darpa Robotics Challenge 出場者らもIPを

活用することでより高い自律性を持たせることができると注目[2][3])

② センサ情報(S(t))とアクチュエータ情報(A(t))を組

み合わせて(S×A×t), 予測や認識を容易にする

IPの重要なアプリケーションの概要を説明

Interactive perception: Leveraging action in perception

and perception in action[1](Bohg, J., et al. 2017)

3/14

[1] Bohg, J., et al. "Interactive perception: Leveraging action in perception and perception in action", IEEE Transactions on Robotics, Vol.33, No.6, pp.1273-1291, 2017. [2]

Atkeson, C. et al., "No falls, no resets: Reliable humanoid behavior in the DARPA robotics challenge", 15th IEEE/RAS International Conference Humanoid Robots, pp. 623–

630, 2015.[3] Johnson, M. et al., "Team IHMC’s lessons learned from the DARPA robotics challenge trials", Journal of Field Robotics, Vol. 32, No. 2, pp. 192–208, 2015.

Bohg, J., et al. “Interactive perception: Leveraging action in perception and perception in action”(2017).

Posture sensor

?(?)

センサ情報

?(?)

行動パラメータ

例)モータ出力等

[2] Atkeson, C. et al. [3] Johnson, M. et al.](https://image.slidesharecdn.com/d3interactiveperception-220927090646-6a91c861/85/Interactive-perception-IP-5-320.jpg)

4/14

[4] Held, R. and Hein, A., "Movement-produced stimulation in the development of visually guided behaviour", J. Comparative Physiol. Psychol.,

Vol.56, pp.872–876, 1963.

Bohg, J., et al. “Interactive perception: Leveraging action in perception and perception in action”(2017).

ゴンドラネコと自由移動ネコ

Heldの実験 [4]:

条件)誕生時から暗闇の中で育てた同腹の子ネコ5対

(A,B)が歩けるようになるのを待ち特殊な視覚経験を与える

? Aは自分の足で歩いて空間内を移動(能動的)

? BはAの動きに応じて動くゴンドラに乗せ移動(受動的)

※経験する視覚刺激は同じ

結果)Bにも歩く能力があるにも関わらず「生存に不可欠な

視覚行動」が見られなかった→「見え」が形成されていない

※着地姿勢、視覚的崖回避、瞬目反射など

→能動的に体を動かし環境とインタラクションする視

覚体験が必要(体の動きと「見え」の変化の因果)

認識において「自ら環境を変える動き(能動的な探

索行動)」から得られる情報こそ最も本質的な情報

図 (Yuji, I., 2017)

A

B](https://image.slidesharecdn.com/d3interactiveperception-220927090646-6a91c861/85/Interactive-perception-IP-6-320.jpg)

![人を含む動物の知覚?認識=IPのような,インタラクティブな探索的なプロセス

5/14

[5] Gibson, J. J., "The Senses Considered as Perceptual Systems", Houghton Mif?in, 1966.

Bohg, J., et al. “Interactive perception: Leveraging action in perception and perception in action”(2017).

不規則な形状の物体の集合

Gibsonの実験 [5]:

タスク)被験者らが右図のような不規則な形状の三次元

物体の集合の中から基準物体を見つける

結果)

? 画像のみ表示:平均精度49%

? 画像を回転可能:平均精度72%

? 物体を手で触ることが可能:平均精度99%

→対象との物理的インタラクションが知覚処理を助長

生物学的な知覚プロセス(2/2) [5](Gibson, J. J., 1966)

基準物体の例

●生物学的な知覚 → 「視覚的な認識」と「触覚による探索」の関係を経験的に理解し知覚

●コンピュータビジョン → 事前知識や様々な仮定を利用し画像に意味付けを行う

※Pascal VOC ,ImageNet ,Microsoft COCO など、数十万の意味付けされた大量のデータセットで成功

●ロボットビジョン → 環境内を移動して物理的に相互作用する知覚 → IP

触る行動で知覚が向上](https://image.slidesharecdn.com/d3interactiveperception-220927090646-6a91c861/85/Interactive-perception-IP-7-320.jpg)

![Bohg, J., et al. “Interactive perception: Leveraging action in perception and perception in action”(2017).

IPの応用例:③ダイナミクス学習と物性推定

IPにより物体の触覚および慣性特性を推定するという課題にも大きな進展

① 視点変更可能 ②人が押す ③ロボットが押す

問題設定)テーブルに置かれた球体重量をロボットが推定

※ロボットが [押し込み力?球が移動した距離?球の重量] の関係を知っていると仮定(事前知識)

① 完全なパッシブオブザーバ:慣性特性の推定は不可能

② ロボットが環境とインタラクションする別のエージェントを観察:不確かな推定値

→ 相互作用による多様な感覚シグナル(CNS)だけでは推定できない例:押した力の情報の欠如

③ ロボットが自律的に必要な感覚情報を生成することが可能:正しい慣性特性を推定可能

→ S×A×tの規則性についての推論(APR)により得られた知識(ロボットが球体を押した

強さ)により,球体の慣性特性(重量)を推定することができる

剛体(RO)か?変形可能(DO)か?

rigid objects

deformable

11/14

?

重い?

軽い?

?

押した力が分からないから

なんともいえない???

!

これだけの力で押せばこれだけ移動

したのだから球の重さは決まりだ!](https://image.slidesharecdn.com/d3interactiveperception-220927090646-6a91c861/85/Interactive-perception-IP-14-320.jpg)