–¦–Β–Κ―Ü–Η―è ⳕ12 "–û–≥―Ä–Α–Ϋ–Η―΅–Β–Ϋ–Ϋ–Α―è –Φ–Α―à–Η–Ϋ–Α –ë–Ψ–Μ―¨―Ü–Φ–Α–Ϋ–Α"

- 1. –¦–Β–Κ―Ü–Η―è n2 Softmax ―¹–Μ–Ψ–Ι –û–≥―Ä–Α–Ϋ–Η―΅–Β–Ϋ–Ϋ–Α―è –Φ–Α―à–Η–Ϋ–Α –ë–Ψ–Μ―¨―Ü–Φ–Α–Ϋ–Α –ù–Β―¹―²–Β―Ä–Ψ–≤ –ü–Α–≤–Β–Μ 11 –¥–Β–Κ–Α–±―Ä―è 2014 –≥.

- 2. –ü–Μ–Α–Ϋ –Μ–Β–Κ―Ü–Η–Η –£―¹–Ω–Ψ–Φ–Η–Ϋ–Α–Β–Φ –Ω―Ä–Ψ―à–Μ―É―é –Μ–Β–Κ―Ü–Η―é Softmax ―¹–Μ–Ψ–Ι –û–±―É―΅–Β–Ϋ–Η–Β –±–Β–Ζ ―É―΅–Η―²–Β–Μ―è –û–≥―Ä–Α–Ϋ–Η―΅–Β–Ϋ–Ϋ–Α―è –Φ–Α―à–Η–Ϋ–Α –ë–Ψ–Μ―¨―Ü–Φ–Α–Ϋ–Α –ê–Μ–≥–Ψ―Ä–Η―²–Φ contrastive divergence –½–Α–Φ–Β―²–Κ–Η –Ω―Ä–Ψ RBM 1 / 60

- 3. –€–Ψ–¥–Η―³–Η―Ü–Η―Ä–Ψ–≤–Α–Ϋ–Ϋ–Α―è –Φ–Ψ–¥–Β–Μ―¨ –Ϋ–Β–Ι―Ä–Ψ–Ϋ–Α –€–Α–Κ–ö–Α–Μ–Μ–Ψ–Κ–Α-–ü–Η―²―²―¹–Α –†–Η―¹.: –Γ―Ö–Β–Φ–Α –Η―¹–Κ―É―¹―¹―²–≤–Β–Ϋ–Ϋ–Ψ–≥–Ψ –Ϋ–Β–Ι―Ä–Ψ–Ϋ–Α1 1Neural Networks and Learning Machines (3rd Edition), Simon O. Haykin 2 / 60

- 4. –€–Ϋ–Ψ–≥–Ψ―¹–Ϋ–Ψ–Ι–Ϋ–Α―è –Ϋ–Β–Ι―Ä–Ψ–Ϋ–Ϋ–Α―è ―¹–Β―²―¨ –Ω―Ä―è–Φ–Ψ–≥–Ψ ―Ä–Α―¹–Ω―Ä–Ψ―¹―²―Ä–Α–Ϋ–Β–Ϋ–Η―è –†–Η―¹.: –ê―Ä―Ö–Η―²–Β–Κ―²―É―Ä–Α ―¹–Β―²–Η ―¹ –¥–≤―É–Φ―è ―¹–Κ―Ä―΄―²―΄–Φ–Η ―¹–Μ–Ψ―è–Φ–Η2 2Neural Networks and Learning Machines (3rd Edition), Simon O. Haykin 3 / 60

- 5. –ê–Μ–≥–Ψ―Ä–Η―²–Φ –Ψ–±―Ä–Α―²–Ϋ–Ψ–≥–Ψ ―Ä–Α―¹–Ω―Ä–Ψ―¹―²―Ä–Α–Ϋ–Β–Ϋ–Η―è –Ψ―à–Η–±–Κ–Η –†–Η―¹.: –Γ―Ö–Β–Φ–Α –Ω―Ä―è–Φ–Ψ–≥–Ψ (–Ϋ–Β–Μ–Η–Ϋ–Β–Ι–Ϋ–Ψ–≥–Ψ) –Η –Ψ–±―Ä–Α―²–Ϋ–Ψ–≥–Ψ (–Μ–Η–Ϋ–Β–Ι–Ϋ–Ψ–≥–Ψ) ―Ä–Α―¹–Ω―Ä–Ψ―¹―²―Ä–Α–Ϋ–Β–Ϋ–Η―è ―¹–Η–≥–Ϋ–Α–Μ–Α –≤ ―¹–Β―²–Η 4 / 60

- 6. –ù–Β–Κ–Ψ―²–Ψ―Ä―΄–Β ―³―É–Ϋ–Κ―Ü–Η–Η ―¹―²–Ψ–Η–Φ–Ψ―¹―²–Η –Γ―Ä–Β–¥–Ϋ–Β–Κ–≤–Α–¥―Ä–Α―²–Η―΅–Ϋ–Α―è –Ψ―à–Η–±–Κ–Α: E = 1 2 iβààoutput (ti β࣠yi ) 2 βà²E βà²yi = yi β࣠ti –¦–Ψ–≥–Α―Ä–Η―³–Φ –Ω―Ä–Α–≤–¥–Ψ–Ω–Ψ–¥–Ψ–±–Η―è –ë–Β―Ä–Ϋ―É–Μ–Μ–Η: E = β࣠iβààoutput (ti log yi + (1 β࣠ti ) log (1 β࣠yi )) βà²E βà²yi = ti yi β࣠1 β࣠ti 1 β࣠yi –î–Μ―è –Κ–Α–Κ–Η―Ö –Ζ–Α–¥–Α―΅ –Φ–Α―à–Η–Ϋ–Ϋ–Ψ–≥–Ψ –Ψ–±―É―΅–Β–Ϋ–Η―è ―É–¥–Ψ–±–Ϋ―΄ ―ç―²–Η ―³―É–Ϋ–Κ―Ü–Η–Η? 5 / 60

- 7. –£―¹–Ω–Ψ–Φ–Η–Ϋ–Α–Β–Φ –Μ–Ψ–≥–Η―¹―²–Η―΅–Β―¹–Κ―É―é ―Ä–Β–≥―Ä–Β―¹―¹–Η―é, –¥–≤–Α –Κ–Μ–Α―¹―¹–Α D = {(xi , yi )}i=1...m , βàÄxi βàà Rn , βàÄyi βàà {0, 1} P(y = 1, x) = P(x|y) ¬Ζ P(y) P(x|y) ¬Ζ P(y) + P(x|y) ¬Ζ P(y) = 1 1 + exp P(x|y)¬ΖP(y) P(x|y)¬ΖP(y) = 1 1 + eβà£a = œÉ(a) –≥–¥–Β y ―ç―²–Ψ y = 0, –Α ―²–Α–Κ –Ε–Β P(y = 0) = 1 β࣠P(y = 1), a : h(w) = wT ¬Ζ x H(p, q) = β࣠i pi ¬Ζ log qi = βà£y ¬Ζ log ΥÜy β࣠(1 β࣠y) ¬Ζ log(1 β࣠ΥÜy) –Κ–Α–Κ–Ψ–Β ―Ä–Α―¹–Ω―Ä–Β–¥–Β–Μ–Β–Ϋ–Η–Β? 6 / 60

- 8. –¦–Ψ–≥–Η―¹―²–Η―΅–Β―¹–Κ–Α―è ―Ä–Β–≥―Ä–Β―¹―¹–Η―è, –Ψ–±–Ψ–±―â–Β–Ϋ–Η–Β –Ϋ–Α N –Κ–Μ–Α―¹―¹–Ψ–≤ D = {(xi , yi )}i=1...m , βàÄxi βàà Rn , βàÄyi βàà {0, 1, . . . , N} P(y = 1|x) = 1 1+eβà£a = eβà£a eβà£a+1 = 1 Z ¬Ζ eβà£a = 1 Z ¬Ζ ewT ¬Ζx Z - –Ϋ–Β–Κ–Ψ―²–Ψ―Ä–Α―è –Ϋ–Ψ―Ä–Φ–Α–Μ–Η–Ζ–Η―Ä―É―é―â–Α―è –Κ–Ψ–Ϋ―¹―²–Α–Ϋ―²–Α P(x) = 1 Z ¬Ζ eβà£E(x) - ―Ä–Α―¹–Ω―Ä–Β–¥–Β–Μ–Β–Ϋ–Η–Β –ë–Ψ–Μ―¨―Ü–Φ–Α–Ϋ–Α-–™–Η–±–±―¹–Α (–Ω–Ψ―΅―²–Η) –£–≤–Β–¥–Β–Φ –¥–Μ―è –Κ–Α–Ε–¥–Ψ–≥–Ψ –Κ–Μ–Α―¹―¹–Α ―¹–≤–Ψ–Ι –≤–Β–Κ―²–Ψ―Ä –≤–Β―¹–Ψ–≤, –Ω–Ψ–Μ―É―΅–Η–Φ: P(y = c|x) = 1 Z ¬Ζ ewT c ¬Ζx = ewT c ¬Ζx i ewT i ¬Ζx (1) c P(y = c|x) = c 1 Z ¬Ζ ewT c ¬Ζx = Z Z = 1 –Κ–Α–Κ –Ω―Ä–Β–¥―¹―²–Α–≤–Η―²―¨ –≤ –≤–Η–¥–Β –Ϋ–Β–Ι―Ä–Ψ―¹–Β―²–Η? 7 / 60

- 9. Softmax ―¹–Μ–Ψ–Ι z (n) j = Nnβà£1 i=0 w (n) ij x (n) i yj = softmax(zj ) = zj Z = zj k zk E(y, t) = β࣠Nnβà£1 j=1 tj ¬Ζ log yj βà²y (n) j βà²z (n) j = ??? 8 / 60

- 10. –î–Η―³―³–Β―Ä–Β–Ϋ―Ü–Η―Ä–Ψ–≤–Α–Ϋ–Η–Β softmax ―³―É–Ϋ–Κ―Ü–Η–Η βà²y (n) j βà²z (n) j = βಠβà²zj ezj Z = 1 Z2 ¬Ζ βà²ezj βà²zj ¬Ζ Z β࣠ezj ¬Ζ βà²Z βà²zj = 1 Z2 ¬Ζ ezj Z β࣠ezj βà²ezj βà²zj = ezj Z β࣠(ezj ) 2 Z2 = ezj Z β࣠ezj Z 2 = yj β࣠y2 j = yj ¬Ζ (1 β࣠yj ) 9 / 60

- 11. –£―¹–Ω–Ψ–Φ–Ϋ–Η–Φ backprop βà²E βà²w (n) ij = βà²E βà²z (n) j βà²z (n) j βà²w (n) ij βà²z (n) j βà²w (n) ij = i βà²w (n) ij x (nβà£1) i βà²w (n) ij = x (nβà£1) i –£ –Η―²–Ψ–≥–Β –Ω–Ψ–Μ―É―΅–Η–Φ: βà²E βà²w (n) ij = x (nβà£1) i βà²E βà²z (n) j (2) –ü―Ä–Ψ–¥–Ψ–Μ–Ε–Η–Φ ―¹ ―ç―²–Ψ–≥–Ψ –Φ–Ψ–Φ–Β–Ϋ―²–Α, ―¹ ―É―΅–Β―²–Ψ–Φ ―²–Ψ–≥–Ψ, ―΅―²–Ψ ―³―É–Ϋ–Κ―Ü–Η–Β–Ι ―¹―²–Ψ–Η–Φ–Ψ―¹―²–Η ―è–≤–Μ―è–Β―²―¹―è –Ω–Β―Ä–Β–Κ―Ä–Β―¹―²–Ϋ–Α―è ―ç–Ϋ―²―Ä–Ψ–Ω–Η―è (–Ψ–Ω―É―¹―²–Η–Φ –Η–Ϋ–¥–Β–Κ―¹ ―¹–Μ–Ψ―è –¥–Μ―è –Ϋ–Α–≥–Μ―è–¥–Ϋ–Ψ―¹―²–Η): E(y (z) , t) = β࣠Nnβà£1 j=1 tj ¬Ζ log yj (zj ) βà²E βà²zj = ??? 10 / 60

- 12. –î–Η―³―³–Β―Ä–Β–Ϋ―Ü–Η―Ä–Ψ–≤–Α–Ϋ–Η–Β –Ω–Β―Ä–Β–Κ―Ä–Β―¹―²–Ϋ–Ψ–Ι ―ç–Ϋ―²―Ä–Ψ–Ω–Η–Η, #1 –†–Α–Ϋ―¨―à–Β –±―΄–Μ–Ψ ―²–Α–Κ (–¥–Μ―è –≤―΄―Ö–Ψ–¥–Ϋ–Ψ–≥–Ψ ―¹–Μ–Ψ―è): βà²E βà²zj = βà²E βà²yj βà²yj βà²zj –Δ–Β–Ω–Β―Ä―¨ ―¹―²–Α–Μ–Ψ ―²–Α–Κ: βà²E βà²zj = Nn i=1 βà²E βà²yi ¬Ζ βà²yi βà²zj –Ω–Ψ―΅–Β–Φ―É ―²–Α–Κ? 11 / 60

- 13. –î–Η―³―³–Β―Ä–Β–Ϋ―Ü–Η―Ä–Ψ–≤–Α–Ϋ–Η–Β –Ω–Β―Ä–Β–Κ―Ä–Β―¹―²–Ϋ–Ψ–Ι ―ç–Ϋ―²―Ä–Ψ–Ω–Η–Η, #2 βà²E βà²zj = Nn i=1 βà²E βà²yi ¬Ζ βà²yi βà²zj βà²E βà²yi ??? 12 / 60

- 14. –î–Η―³―³–Β―Ä–Β–Ϋ―Ü–Η―Ä–Ψ–≤–Α–Ϋ–Η–Β –Ω–Β―Ä–Β–Κ―Ä–Β―¹―²–Ϋ–Ψ–Ι ―ç–Ϋ―²―Ä–Ψ–Ω–Η–Η, #2 βà²E βà²zj = Nn i=1 βà²E βà²yi ¬Ζ βà²yi βà²zj βà²E βà²yi = β࣠βಠβà²yi Nn k tk ¬Ζ log yk = β࣠βಠβà²yi (ti ¬Ζ log yi ) = β࣠ti yi 13 / 60

- 15. –î–Η―³―³–Β―Ä–Β–Ϋ―Ü–Η―Ä–Ψ–≤–Α–Ϋ–Η–Β –Ω–Β―Ä–Β–Κ―Ä–Β―¹―²–Ϋ–Ψ–Ι ―ç–Ϋ―²―Ä–Ψ–Ω–Η–Η, #3 βà²E βà²zj = Nn i=1 βà²E βà²yi ¬Ζ βà²yi βà²zj βà²E βà²yi = β࣠ti yi βà²yi βà²zj ??? 14 / 60

- 16. –î–Η―³―³–Β―Ä–Β–Ϋ―Ü–Η―Ä–Ψ–≤–Α–Ϋ–Η–Β –Ω–Β―Ä–Β–Κ―Ä–Β―¹―²–Ϋ–Ψ–Ι ―ç–Ϋ―²―Ä–Ψ–Ω–Η–Η, #4 βà²E βà²zj = Nn i=1 βà²E βà²yi ¬Ζ βà²yi βà²zj βà²E βà²yi = β࣠ti yi βà²yi βà²zj = yj (1 β࣠yj ) , i = j ???, i = j 15 / 60

- 17. –î–Η―³―³–Β―Ä–Β–Ϋ―Ü–Η―Ä–Ψ–≤–Α–Ϋ–Η–Β –Ω–Β―Ä–Β–Κ―Ä–Β―¹―²–Ϋ–Ψ–Ι ―ç–Ϋ―²―Ä–Ψ–Ω–Η–Η, #5 βà²E βà²zj = Nn i=1 βà²E βà²yi ¬Ζ βà²yi βà²zj βà²E βà²yi = β࣠ti yi βà²yi βà²zj = yj (1βà£yj ),i=j ???,i=j βà²y (n) i βà²z (n) j = 1 Z2 ¬Ζ βà²ezi βà²zj ¬Ζ Z β࣠ezi ¬Ζ βà²Z βà²zj = 1 Z2 (0 β࣠ezi ¬Ζ ezj ) = βà£yi ¬Ζ yj 16 / 60

- 18. –î–Η―³―³–Β―Ä–Β–Ϋ―Ü–Η―Ä–Ψ–≤–Α–Ϋ–Η–Β –Ω–Β―Ä–Β–Κ―Ä–Β―¹―²–Ϋ–Ψ–Ι ―ç–Ϋ―²―Ä–Ψ–Ω–Η–Η, #6 βà²E βà²zj = Nn i=1 βà²E βà²yi ¬Ζ βà²yi βà²zj βà²E βà²yi = β࣠ti yi βà²yi βà²zj = yj (1βà£yj ),i=j βà£yi yj ,i=j βà²E βà²yi ¬Ζ βà²yi βà²zj = βà£tj (1βà£yj ),i=j yj ti ,i=j ―¹–Ψ–±–Η―Ä–Α–Β–Φ –≤―¹–Β –≤–Φ–Β―¹―²–Β 17 / 60

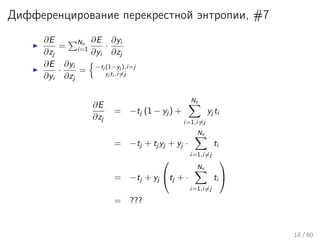

- 19. –î–Η―³―³–Β―Ä–Β–Ϋ―Ü–Η―Ä–Ψ–≤–Α–Ϋ–Η–Β –Ω–Β―Ä–Β–Κ―Ä–Β―¹―²–Ϋ–Ψ–Ι ―ç–Ϋ―²―Ä–Ψ–Ω–Η–Η, #7 βà²E βà²zj = Nn i=1 βà²E βà²yi ¬Ζ βà²yi βà²zj βà²E βà²yi ¬Ζ βà²yi βà²zj = βà£tj (1βà£yj ),i=j yj ti ,i=j βà²E βà²zj = βà£tj (1 β࣠yj ) + Nn i=1,i=j yj ti = βà£tj + tj yj + yj ¬Ζ Nn i=1,i=j ti = βà£tj + yj οΘΪ οΘ≠tj + ¬Ζ Nn i=1,i=j ti οΘΕ οΘΗ = ??? 18 / 60

- 20. –î–Η―³―³–Β―Ä–Β–Ϋ―Ü–Η―Ä–Ψ–≤–Α–Ϋ–Η–Β –Ω–Β―Ä–Β–Κ―Ä–Β―¹―²–Ϋ–Ψ–Ι ―ç–Ϋ―²―Ä–Ψ–Ω–Η–Η, #8 βà²E βà²zj = Nn i=1 βà²E βà²yi ¬Ζ βà²yi βà²zj βà²E βà²yi ¬Ζ βà²yi βà²zj = βà£tj (1βà£yj ),i=j yj ti ,i=j βà²E βà²zj = βà£tj (1 β࣠yj ) + Nn i=1,i=j yj ti = βà£tj + tj yj + yj ¬Ζ Nn i=1,i=j ti = βà£tj + yj οΘΪ οΘ≠tj + ¬Ζ Nn i=1,i=j ti οΘΕ οΘΗ = yj β࣠tj 19 / 60

- 21. Softmax ―¹–Μ–Ψ–Ι, –≤―΄–≤–Ψ–¥―΄ 20 / 60

- 22. –û–±―É―΅–Β–Ϋ–Η–Β –±–Β–Ζ ―É―΅–Η―²–Β–Μ―è When weβÄôre learning to see, nobodyβÄôs telling us what the right answers are βÄî we just look. Every so often, your mother says βÄ€thatβÄôs a dogβÄù, but thatβÄôs very little information. YouβÄôd be lucky if you got a few bits of information βÄî even one bit per second βÄî that way. The brainβÄôs visual system has 1014 neural connections. And you only live for 109 seconds. So itβÄôs no use learning one bit per second. You need more like 105 bits per second. And thereβÄôs only one place you can get that much information: from the input itself.3 3Geoο§Ärey Hinton, 1996 (quoted in (Gorder 2006)) 21 / 60

- 23. –Γ―²–Α―²–Η―¹―²–Η―΅–Β―¹–Κ–Α―è –Φ–Β―Ö–Α–Ϋ–Η–Κ–Α, #1 –ü―Ä–Β–¥―¹―²–Α–≤–Η–Φ –Ϋ–Β–Κ–Ψ―²–Ψ―Ä―É―é ―³–Η–Ζ–Η―΅–Β―¹–Κ―É―é ―¹–Η―¹―²–Β–Φ―É ―¹ –Φ–Ϋ–Ψ–Ε–Β―¹―²–≤–Ψ–Φ ―¹―²–Β–Ω–Β–Ϋ–Β–Ι ―¹–≤–Ψ–±–Ψ–¥―΄, –Κ–Ψ―²–Ψ―Ä–Α―è –Φ–Ψ–Ε–Β―² –Ϋ–Α―Ö–Ψ–¥–Η―²―¹―è –≤ –Ψ–¥–Ϋ–Ψ–Φ –Η–Ζ –Φ–Ϋ–Ψ–Ε–Β―¹―²–≤–Α ―¹–Ψ―¹―²–Ψ―è–Ϋ–Η–Ι ―¹ –Ϋ–Β–Κ–Ψ―²–Ψ―Ä–Ψ–Ι –≤–Β―Ä–Ψ―è―²–Ϋ–Ψ―¹―²―¨―é, –Α –Κ–Α–Ε–¥–Ψ–Φ―É ―²–Α–Κ–Ψ–Φ―É ―¹–Ψ―¹―²–Ψ―è–Ϋ–Η―é ―¹–Ψ―¹―²–Ψ―è–Ϋ–Η―é ―¹–Ψ–Ψ―²–≤–Β―²―¹―²–≤―É–Β―² –Ϋ–Β–Κ–Ψ―²–Ψ―Ä–Α―è ―ç–Ϋ–Β―Ä–≥–Η―è –≤―¹–Β–Ι ―¹–Η―¹―²–Β–Φ―΄: pi βâΞ 0 - –≤–Β―Ä–Ψ―è―²–Ϋ–Ψ―¹―²―¨ ―¹–Ψ―¹―²–Ψ―è–Ϋ–Η―è i i pi = 1 Ei - ―ç–Ϋ–Β―Ä–≥–Η―è ―¹–Η―¹―²–Β–Φ―΄ –≤ ―¹–Ψ―¹―²–Ψ―è–Ϋ–Η–Η i –Δ–Ψ–≥–¥–Α –≤–Β―Ä–Ψ―è―²–Ϋ–Ψ―¹―²―¨ ―¹–Ψ―¹―²–Ψ―è–Ϋ–Η―è i –±―É–¥–Β―² –Ψ–Ω–Η―¹―΄–≤–Α―²―¨―¹―è ―Ä–Α―¹–Ω―Ä–Β–¥–Β–Μ–Β–Ϋ–Η–Β–Φ –ë–Ψ–Μ―¨―Ü–Φ–Α–Ϋ–Α-–™–Η–±–±―¹–Α, –Ω―Ä–Η ―É―¹–Μ–Ψ–≤–Η–Η ―²–Β―Ä–Φ–Ψ–¥–Η–Ϋ–Α–Φ–Η―΅–Β―¹–Κ–Ψ–≥–Ψ ―Ä–Α–≤–Ϋ–Ψ–≤–Β―¹–Η―è –Φ–Β–Ε–¥―É ―¹–Η―¹―²–Β–Φ–Ψ–Ι –Η –Ψ–Κ―Ä―É–Ε–Α―é―â–Β–Ι ―¹―Ä–Β–¥–Ψ–Ι: pi = 1 Z exp β࣠Ei kB ¬Ζ T (3) –≥–¥–Β T - –Α–±―¹–Ψ–Μ―é―²–Ϋ–Α―è ―²–Β–Φ–Ω–Β―Ä–Α―²―É―Ä–Α (–ö) kB - –Κ–Ψ–Ϋ―¹―²–Α–Ϋ―²–Α –ë–Ψ–Μ―¨―Ü–Φ–Α–Ϋ–Α (–î–Ε/–ö) Z = i exp β࣠Ei kB ¬ΖT - –Ϋ–Ψ―Ä–Φ–Α–Μ–Η–Ζ–Η―Ä―É―é―â–Α―è –Κ–Ψ–Ϋ―¹―²–Α–Ϋ―²–Α (partition function, Zustadsumme, ―¹―²–Α―²―¹―É–Φ–Φ–Α) 22 / 60

- 24. –Γ―²–Α―²–Η―¹―²–Η―΅–Β―¹–Κ–Α―è –Φ–Β―Ö–Α–Ϋ–Η–Κ–Α, #2 –î–≤–Α –≤–Α–Ε–Ϋ―΄―Ö –≤―΄–≤–Ψ–¥–Α: 1. ―¹–Ψ―¹―²–Ψ―è–Ϋ–Η―è ―¹ –Ϋ–Η–Ζ–Κ–Ψ–Ι ―ç–Ϋ–Β―Ä–≥–Η–Β–Ι –Η–Φ–Β―é―² –±–Ψ–Μ―¨―à–Β ―à–Α–Ϋ―¹–Ψ–≤ –≤–Ψ–Ζ–Ϋ–Η–Κ–Ϋ―É―²―¨ ―΅–Β–Φ ―¹–Ψ―¹―²–Ψ―è–Ϋ–Η―è ―¹ –≤―΄―¹–Ψ–Κ–Ψ–Ι ―ç–Ϋ–Β―Ä–≥–Η–Β–Ι; 2. –Ω―Ä–Η –Ω–Ψ–Ϋ–Η–Ε–Β–Ϋ–Η–Η ―²–Β–Φ–Ω–Β―Ä–Α―²―É―Ä―΄, ―΅–Α―â–Β –≤―¹–Β–≥–Ψ –±―É–¥―É―² –≤–Ψ–Ζ–Ϋ–Η–Κ–Α―²―¨ ―¹–Ψ―¹―²–Ψ―è–Ϋ–Η―è –Η–Ζ –Ϋ–Β–±–Ψ–Μ―¨―à–Ψ–≥–Ψ –Ω–Ψ–¥–Φ–Ϋ–Ψ–Ε–Β―¹―²–≤–Α ―¹–Ψ―¹―²–Ψ―è–Ϋ–Η–Ι ―¹ –Ϋ–Η–Ζ–Κ–Ψ–Ι ―ç–Ϋ–Β―Ä–≥–Η–Β–Ι. 23 / 60

- 25. –ù–Β–Ι―Ä–Ψ―¹–Β―²―¨ –Ξ–Ψ–Ω―³–Η–Μ–¥–Α –Ψ–±―Ä–Α―²–Ϋ–Α―è ―¹–≤―è–Ζ―¨ –Ω–Ψ―Ä–Ψ–≥–Ψ–≤–Α―è ―³―É–Ϋ–Κ―Ü–Η―è –Α–Κ―²–Η–≤–Α―Ü–Η–Η –Δ–Α–Κ–Α―è ―¹–Β―²―¨ (―Ä–Β–Κ―É―Ä―Ä–Β–Ϋ―²–Ϋ–Α―è –Ϋ–Β–Ι―Ä–Ψ–Ϋ–Ϋ–Α―è ―¹–Β―²―¨) –Φ–Ψ–Ε–Β―² –Ϋ–Α―Ö–Ψ–¥–Η―²―¹―è –Κ–Α–Κ –≤ ―¹―²–Α–±–Η–Μ―¨–Ϋ–Ψ–Φ ―¹–Ψ―¹―²–Ψ―è–Ϋ–Η–Η, –Ψ―¹―Ü–Η–Μ–Μ–Η―Ä–Ψ–≤–Α―²―¨, –Η–Μ–Η –¥–Α–Ε–Β –Ω―Ä–Ψ―è–≤–Μ―è―²―¨ –Ω―Ä–Η–Ζ–Ϋ–Α–Κ–Η –¥–Β―²–Β―Ä–Φ–Η–Ϋ–Η―Ä–Ψ–≤–Α–Ϋ–Ϋ–Ψ–≥–Ψ ―Ö–Α–Ψ―¹–Α. –Ξ–Ψ–Ω―³–Η–Μ–¥ –Ω–Ψ–Κ–Α–Ζ–Α–Μ, ―΅―²–Ψ –Ω―Ä–Η ―¹–Η–Φ–Φ–Β―²―Ä–Η―΅–Ϋ–Ψ–Ι –Φ–Α―²―Ä–Η―Ü–Β –≤–Β―¹–Ψ–≤, ―¹―É―â–Β―¹―²–≤―É–Β―² ―²–Α–Κ–Α―è ―³―É–Ϋ–Κ―Ü–Η―è ―ç–Ϋ–Β―Ä–≥–Η–Η –±–Η–Ϋ–Α―Ä–Ϋ―΄―Ö ―¹–Ψ―¹―²–Ψ―è–Ϋ–Η–Ι ―¹–Η―¹―²–Β–Φ―΄, ―΅―²–Ψ –Ω―Ä–Η ―¹–Η–Φ―É–Μ―è―Ü–Η–Η ―¹–Η―¹―²–Β–Φ–Α ―ç–≤–Ψ–Μ―é―Ü–Η–Ψ–Ϋ–Η―Ä―É–Β―² –≤ –Ψ–¥–Ϋ–Ψ –Η–Ζ –Ϋ–Η–Ζ–Κ–Ψ-―ç–Ϋ–Β―Ä–≥–Β―²–Η―΅–Β―¹–Κ–Η―Ö ―¹–Ψ―¹―²–Ψ―è–Ϋ–Η–Ι. 24 / 60

- 26. –ù–Β–Ι―Ä–Ψ―¹–Β―²―¨ –Ξ–Ψ–Ω―³–Η–Μ–¥–Α, ―ç–Ϋ–Β―Ä–≥–Η―è ―¹–Η―¹―²–Β–Φ―΄, #1 E = β࣠i si bi β࣠i<j si sj wij (4) si - ―¹–Ψ―¹―²–Ψ―è–Ϋ–Η–Β –Ϋ–Β–Ι―Ä–Ψ–Ϋ–Α i bi - ―¹–Φ–Β―â–Β–Ϋ–Η–Β –Ϋ–Β–Ι―Ä–Ψ–Ϋ–Α i wij - –≤–Β―¹ –Φ–Β–Ε–¥―É –Ϋ–Β–Ι―Ä–Ψ–Ϋ–Ψ–Φ i –Η j –†–Η―¹.: –ü–Ψ–≤–Β―Ä―Ö–Ϋ–Ψ―¹―²―¨ –Ψ–Ω–Η―¹―΄–≤–Α–Β–Φ–Α―è ―ç–Ϋ–Β―Ä–≥–Η–Β–Ι ―¹–Β―²–Η –Ξ–Ψ–Ω―³–Η–Μ–¥–Α 25 / 60

- 27. –ù–Β–Ι―Ä–Ψ―¹–Β―²―¨ –Ξ–Ψ–Ω―³–Η–Μ–¥–Α, ―ç–Ϋ–Β―Ä–≥–Η―è ―¹–Η―¹―²–Β–Φ―΄, #2 –†–Η―¹.: –ü–Ψ–≤–Β―Ä―Ö–Ϋ–Ψ―¹―²―¨ –Ψ–Ω–Η―¹―΄–≤–Α–Β–Φ–Α―è ―ç–Ϋ–Β―Ä–≥–Η–Β–Ι ―¹–Β―²–Η –Ξ–Ψ–Ω―³–Η–Μ–¥–Α, –¥–≤–Α ―¹―²–Α–±–Η–Μ―¨–Ϋ―΄―Ö ―¹–Ψ―¹―²–Ψ―è–Ϋ–Η―è4 4Neural Networks and Learning Machines (3rd Edition), Simon O. Haykin 26 / 60

- 28. –ù–Β–Ι―Ä–Ψ―¹–Β―²―¨ –Ξ–Ψ–Ω―³–Η–Μ–¥–Α, –Κ–Α–Κ –Α―¹―¹–Ψ―Ü–Η–Α―²–Η–≤–Ϋ–Α―è –Ω–Α–Φ―è―²―¨ a - –Ϋ–Β―² –Ψ–±―Ä–Α–Ζ–Ψ–≤ –≤ –Ω–Α–Φ―è―²–Η b - –¥–≤–Α –Ψ–±―Ä–Α–Ζ–Α –¥–Α–Μ–Β–Κ–Ψ –¥―Ä―É–≥ –Ψ―² –¥―Ä―É–≥–Α c - –¥–≤–Α –Ψ–±―Ä–Α–Ζ–Α –Ϋ–Α–Κ–Μ–Α–¥―΄–≤–Α―é―²―¹―è –¥―Ä―É–≥ –Ϋ–Α –¥―Ä―É–≥–Α –£–Φ–Β―¹―²–Η–Φ–Ψ―¹―²―¨ 0.15 ¬Ζ N –Ϋ–Α N –Ϋ–Β–Ι―Ä–Ψ–Ϋ–Ψ–≤. 27 / 60

- 29. –ù–Β–Ι―Ä–Ψ―¹–Β―²―¨ –Ξ–Ψ–Ω―³–Η–Μ–¥–Α, –Α–Μ–≥–Ψ―Ä–Η―²–Φ –Ψ–±―É―΅–Β–Ϋ–Η―è –û–±―É―΅–Β–Ϋ–Η–Β ―¹–Β―²–Η –Ξ–Ψ–Ω―³–Η–Μ–¥–Α –Ω―Ä–Ψ–Η―¹―Ö–Ψ–¥–Η―² –≤ –Ψ–¥–Η–Ϋ –Ω―Ä–Ψ–≥–Ψ–Ϋ –Ω–Ψ –Φ–Ϋ–Ψ–Ε–Β―¹―²–≤―É –¥–Α–Ϋ–Ϋ―΄―Ö –Ω–Ψ ―¹–Μ–Β–¥―É―é―â–Β–Φ―É –Ω―Ä–Α–≤–Η–Μ―É: βàÜwij = 1 n n i=1 si sj , βàÄk : sk βàà {βà£1, 1} (5) –≠―²–Ψ –≤ ―²–Ψ―΅–Ϋ–Ψ―¹―²–Η –Ω–Β―Ä–≤–Ψ–Β –Ω―Ä–Α–≤–Η–Μ–Ψ –Ξ–Β–±–±–Α: –Β―¹–Μ–Η –¥–≤–Α –Ϋ–Β–Ι―Ä–Ψ–Ϋ–Α –Ω–Ψ ―Ä–Α–Ζ–Ϋ―΄–Β ―¹―²–Ψ―Ä–Ψ–Ϋ―΄ –Ψ―² ―¹–Η–Ϋ–Α–Ω―¹–Ψ–≤ –Α–Κ―²–Η–≤–Η―Ä―É―é―²―¹―è ―¹–Η–Ϋ―Ö―Ä–Ψ–Ϋ–Ϋ–Ψ, ―²–Ψ "–≤–Β―¹"―¹–Η–Ϋ–Α–Ω―¹–Α ―¹–Μ–Β–≥–Κ–Α –≤–Ψ–Ζ―Ä–Α―¹―²–Α–Β―² 28 / 60

- 30. –€–Α―à–Η–Ϋ–Α –ë–Ψ–Μ―¨―Ü–Φ–Α–Ϋ–Α - ―¹―²–Ψ―Ö–Α―¹―²–Η―΅–Β―¹–Κ–Η–Ι –≥–Β–Ϋ–Β―Ä–Α―²–Η–≤–Ϋ―΄–Ι –≤–Α―Ä–Η–Α–Ϋ―² ―¹–Β―²–Η –Ξ–Ψ–Ω―³–Η–Μ–¥–Α ―ç–Ϋ–Β―Ä–≥–Η―è –Ϋ–Β –Η–Ζ–Φ–Β–Ϋ–Η–Μ–Α―¹―¨: E = β࣠i si bi β࣠i<j si sj wij ―¹–Η–Φ–Φ–Β―²―Ä–Η―΅–Ϋ–Α―è –Φ–Α―²―Ä–Η―Ü–Α –≤–Β―¹–Ψ–≤ wij = wji , –Ϋ–Ψ –Ϋ–Β―² –Ψ–±―Ä–Α―²–Ϋ―΄―Ö ―¹–≤―è–Ζ–Β–Ι: wii = 0 –Ω–Ψ―è–≤–Η–Μ–Η―¹―¨ ―¹–Κ―Ä―΄―²―΄–Β ―¹–Ψ―¹―²–Ψ―è–Ϋ–Η―è (―¹–Η―¹―²–Β–Φ–Α –Η―â–Β―² ―²–Α–Κ―É―é –Κ–Ψ–Ϋ―³–Η–≥―É―Ä–Α―Ü–Η―é ―¹–Κ―Ä―΄―²―΄―Ö ―¹–Ψ―¹―²–Ψ―è–Ϋ–Η–Ι –Κ–Ψ―²–Ψ―Ä–Α―è –Μ―É―΅―à–Η–Φ –Ψ–±―Ä–Α–Ζ–Ψ–Φ –Ψ–Ω–Η―¹―΄–≤–Α–Β―² –≤–Η–¥–Η–Φ―΄–Β ―¹–Ψ―¹―²–Ψ―è–Ϋ–Η―è) βàÄi : si βàà {0, 1} ―¹―²–Ψ―Ö–Α―¹―²–Η―΅–Β―¹–Κ–Η–Ι –Ϋ–Β–Ι―Ä–Ψ–Ϋ 29 / 60

- 32. –‰–Φ–Η―²–Α―Ü–Η―è –Ψ―²–Ε–Η–≥–Α, –Η–¥–Β―è, #1 31 / 60

- 33. –‰–Φ–Η―²–Α―Ü–Η―è –Ψ―²–Ε–Η–≥–Α, –Η–¥–Β―è, #2 –†–Η―¹.: –£–Μ–Η―è–Ϋ–Η–Β ―²–Β–Φ–Ω–Β―Ä–Α―²―É―Ä―΄ –Ϋ–Α –≤–Β―Ä–Ψ―è―²–Ϋ–Ψ―¹―²–Η –Ω–Β―Ä–Β―Ö–Ψ–¥–Ψ–≤5 SimulatedAnnealing.gif 5https://class.coursera.org/neuralnets-2012-001/lecture 32 / 60

- 34. –‰–Φ–Η―²–Α―Ü–Η―è –Ψ―²–Ε–Η–≥–Α βàÜEi = bi + j wij sj pi = 1 Z exp β࣠Ei kB ¬ΖT pi=1 pi=0 = exp β࣠Ei=0 β࣠Ei=1 kB T = exp βàÜEi kB T β΅£ βàÜEi T = ln(pi=1) β࣠ln(pi=0) = ln(pi=1) β࣠ln(1 β࣠pi=1) = ln pi=1 1 β࣠pi=1 β΅£ β࣠βàÜEi T = ln 1 β࣠pi=1 pi=1 = ln 1 pi=1 β࣠1 β΅£ exp β࣠βàÜEi T = 1 pi=1 β࣠1 β΅£ pi=1 = 1 1 + exp βà£βàÜEi T 33 / 60

- 35. –€–Α―à–Η–Ϋ–Α –ë–Ψ–Μ―¨―Ü–Φ–Α–Ϋ–Α - –≤―΄–≤–Ψ–¥―΄ –Δ–Β–Ψ―Ä–Β―²–Η―΅–Β―¹–Κ–Η ―²–Α–Κ–Α―è –Φ–Ψ–¥–Β–Μ―¨ –Φ–Ψ–Ε–Β―² –≤―¹–Β (–Κ–Α–Κ –Ψ–±―΄―΅–Ϋ–Ψ –≤ –Ϋ–Β–Ι―Ä–Ψ―¹–Β―²―è―Ö), –Ϋ–Ψ –≤―Ä–Β–Φ―è ―²―Ä–Β–±―É–Β–Φ–Ψ–Β –¥–Μ―è –Ψ–±―É―΅–Β–Ϋ–Η―è ―²–Α–Κ–Ψ–Ι –Φ–Ψ–¥–Β–Μ–Η ―ç–Κ―¹–Ω–Ψ–Ϋ–Β–Ϋ―Ü–Η–Α–Μ―¨–Ϋ–Ψ –Ζ–Α–≤–Η―¹–Η―² –Ψ―² ―Ä–Α–Ζ–Φ–Β―Ä–Α –Φ–Α―à–Η–Ϋ―΄ –Ω–Ψ ―ç―²–Ψ–Ι –Ε–Β –Ω―Ä–Η―΅–Η–Ϋ–Β –Ϋ–Β―² –≤–Ψ–Ζ–Φ–Ψ–Ε–Ϋ–Ψ―¹―²–Η –≤―΄―΅–Η―¹–Μ–Η―²―¨ Z ―²–Α–Κ –Ε–Β –Ω―Ä–Η―Ö–Ψ–¥–Η―²―¹―è –Η―¹–Ω–Ψ–Μ―¨–Ζ–Ψ–≤–Α―²―¨ ―¹–Β–Φ–Ω–Μ–Η―Ä–Ψ–≤–Α–Ϋ–Η–Β –™–Η–±–±―¹–Α6 , –≤ ―¹–≤―è–Ζ–Η ―¹ ―²–Ψ–Ω–Ψ–Μ–Ψ–≥–Η–Β–Ι ―¹–Β―²–Η (–Ω–Ψ―΅–Β–Φ―É?) 6–Γ–Β–Φ–Ω–Μ–Η―Ä–Ψ–≤–Α–Ϋ–Η–Β –Ω–Ψ –™–Η–±–±―¹―É –Ϋ–Β ―²―Ä–Β–±―É–Β―²―¹―è ―è–≤–Ϋ–Ψ –≤―΄―Ä–Α–Ε–Β–Ϋ–Ϋ–Ψ–Β ―¹–Ψ–≤–Φ–Β―¹―²–Ϋ–Ψ–Β ―Ä–Α―¹–Ω―Ä–Β–¥–Β–Μ–Β–Ϋ–Η–Β, –Α –Ϋ―É–Ε–Ϋ―΄ –Μ–Η―à―¨ ―É―¹–Μ–Ψ–≤–Ϋ―΄–Β –≤–Β―Ä–Ψ―è―²–Ϋ–Ψ―¹―²–Η –¥–Μ―è –Κ–Α–Ε–¥–Ψ–Ι –Ω–Β―Ä–Β–Φ–Β–Ϋ–Ϋ–Ψ–Ι, –≤―Ö–Ψ–¥―è―â–Β–Ι –≤ ―Ä–Α―¹–Ω―Ä–Β–¥–Β–Μ–Β–Ϋ–Η–Β. –ê–Μ–≥–Ψ―Ä–Η―²–Φ –Ϋ–Α –Κ–Α–Ε–¥–Ψ–Φ ―à–Α–≥–Β –±–Β―Ä–Β―² –Ψ–¥–Ϋ―É ―¹–Μ―É―΅–Α–Ι–Ϋ―É―é –≤–Β–Μ–Η―΅–Η–Ϋ―É –Η –≤―΄–±–Η―Ä–Α–Β―² –Β–Β –Ζ–Ϋ–Α―΅–Β–Ϋ–Η–Β –Ω―Ä–Η ―É―¹–Μ–Ψ–≤–Η–Η ―³–Η–Κ―¹–Η―Ä–Ψ–≤–Α–Ϋ–Ϋ―΄―Ö –Ψ―¹―²–Α–Μ―¨–Ϋ―΄―Ö. –€–Ψ–Ε–Ϋ–Ψ –Ω–Ψ–Κ–Α–Ζ–Α―²―¨, ―΅―²–Ψ –Ω–Ψ―¹–Μ–Β–¥–Ψ–≤–Α―²–Β–Μ―¨–Ϋ–Ψ―¹―²―¨ –Ω–Ψ–Μ―É―΅–Α–Β–Φ―΄―Ö –Ζ–Ϋ–Α―΅–Β–Ϋ–Η–Ι –Ψ–±―Ä–Α–Ζ―É―é―² –≤–Ψ–Ζ–≤―Ä–Α―²–Ϋ―É―é ―Ü–Β–Ω―¨ –€–Α―Ä–Κ–Ψ–≤–Α, ―É―¹―²–Ψ–Ι―΅–Η–≤–Ψ–Β ―Ä–Α―¹–Ω―Ä–Β–¥–Β–Μ–Β–Ϋ–Η–Β –Κ–Ψ―²–Ψ―Ä–Ψ–Ι ―è–≤–Μ―è–Β―²―¹―è –Κ–Α–Κ ―Ä–Α–Ζ –Η―¹–Κ–Ψ–Φ―΄–Φ ―¹–Ψ–≤–Φ–Β―¹―²–Ϋ―΄–Φ ―Ä–Α―¹–Ω―Ä–Β–¥–Β–Μ–Β–Ϋ–Η–Β–Φ. 34 / 60

- 36. –û–≥―Ä–Α–Ϋ–Η―΅–Β–Ϋ–Ϋ–Α―è –Φ–Α―à–Η–Ϋ–Α –ë–Ψ–Μ―¨―Ü–Φ–Α–Ϋ–Α ―É–±–Η―Ä–Α–Β–Φ ―²–Β–Φ–Ω–Β―Ä–Α―²―É―Ä―É –≤–≤–Ψ–¥–Η–Φ –Ψ–≥―Ä–Α–Ϋ–Η―΅–Β–Ϋ–Η–Β –Ϋ–Α ―²–Ψ–Ω–Ψ–Μ–Ψ–≥–Η―é 35 / 60

- 37. –£–Η–¥―΄ RBM –£ –Ζ–Α–≤–Η―¹–Η–Φ–Ψ―¹―²–Η –Ψ―² –Α–Ω―Ä–Η―Ä–Ϋ–Ψ–≥–Ψ ―Ä–Α―¹–Ω―Ä–Β–¥–Β–Μ–Β–Ϋ–Η―è –Α―¹―¹–Ψ―Ü–Η–Η―Ä–Ψ–≤–Α–Ϋ–Ϋ–Ψ–≥–Ψ ―¹ –≤–Η–¥–Η–Φ―΄–Φ –Η ―¹–Κ―Ä―΄―²―΄–Φ ―¹–Μ–Ψ―è–Φ–Η, ―Ä–Α–Ζ–Μ–Η―΅–Α―é―² –Ϋ–Β―¹–Κ–Ψ–Μ―¨–Κ–Ψ –≤–Η–¥–Ψ–≤ RBM: Bernoulli-Bernoulli (binary-binary) Gaussian-Bernoulli Gaussian-Gaussian Poisson-Bernoulli –Η ―².–¥. –ë–Η–Ϋ–Α―Ä–Ϋ―΄–Β (Bernoulli-Bernoulli, binary-binary) RBM –Η–≥―Ä–Α―é―² –≤–Α–Ε–Ϋ―É―é ―Ä–Ψ–Μ―¨ –≤ –≥–Μ―É–±–Ψ–Κ–Ψ–Φ –Ψ–±―É―΅–Β–Ϋ–Η–Η, –Ω–Ψ –Α–Ϋ–Α–Μ–Ψ–≥–Η–Η ―¹ –≤―΄–≤–Ψ–¥–Ψ–Φ –Α–Μ–≥–Ψ―Ä–Η―²–Φ–Α –Ψ–±―É―΅–Β–Ϋ–Η―è –¥–Μ―è –±–Η–Ϋ–Α―Ä–Ϋ–Ψ–Ι –Ψ–≥―Ä–Α–Ϋ–Η―΅–Β–Ϋ–Ϋ–Ψ–Ι –Φ–Α―à–Η–Ϋ―΄ –ë–Ψ–Μ―¨―Ü–Φ–Α–Ϋ–Α, –Φ–Ψ–Ε–Ϋ–Ψ –≤―΄–≤–Β―¹―²–Η –Α–Ϋ–Α–Μ–Ψ–≥–Η―΅–Ϋ―΄–Β –Ω―Ä–Α–≤–Η–Μ–Α –¥–Μ―è –Ψ―¹―²–Α–Μ―¨–Ϋ―΄―Ö ―²–Η–Ω–Ψ–≤ –Φ–Ψ–¥–Β–Μ–Β–Ι. 36 / 60

- 38. RBM, –Ψ–±–Ψ–Ζ–Ϋ–Α―΅–Β–Ϋ–Η―è D = {xi }i=1...N - –Φ–Ϋ–Ψ–Ε–Β―¹―²–≤–Ψ –¥–Α–Ϋ–Ϋ―΄―Ö; v, h - –Ζ–Ϋ–Α―΅–Β–Ϋ–Η―è –≤–Η–¥–Η–Φ―΄―Ö –Η ―¹–Κ―Ä―΄―²―΄―Ö –Ϋ–Β–Ι―Ä–Ψ–Ϋ–Ψ–≤; a, b, W - ―¹–Φ–Β―â–Β–Ϋ–Η―è –≤–Η–¥–Η–Φ―΄―Ö –Η ―¹–Κ―Ä―΄―²―΄―Ö –Ϋ–Β–Ι―Ä–Ψ–Ϋ–Ψ–≤, –Η –Φ–Α―²―Ä–Η―Ü–Α –≤–Β―¹–Ψ–≤; n, m - –Κ–Ψ–Μ–Η―΅–Β―¹―²–≤–Ψ –≤–Η–¥–Η–Φ―΄―Ö –Η ―¹–Κ―Ä―΄―²―΄―Ö –Ϋ–Β–Ι―Ä–Ψ–Ϋ–Ψ–≤; E(v, h) = β࣠n i=1 ai vi β࣠m j=1 bj hj β࣠n i=1 m j=1 wij vi hj = βà£vT a β࣠hT b β࣠vT W b p(v, h) = 1 Z eβà£E(v,h) Z = N r M t eβà£E(v(r) ,h(t) ) P(v) = M t P(v, h(t) ) = 1 Z M t eβà£E(v,h(t) ) –î–Α–Μ–Β–Β –Ζ–Ϋ–Α―΅–Κ–Η –≤–Β–Κ―²–Ψ―Ä–Α x –±―É–¥―É―² –Ψ–Ω―É―¹–Κ–Α―²―¨―¹―è –¥–Μ―è –Ω―Ä–Ψ―¹―²–Ψ―²―΄. 37 / 60

- 39. RBM, ―³―É–Ϋ–Κ―Ü–Η―è –Α–Κ―²–Η–≤–Α―Ü–Η–Η –ê–Ϋ–Α–Μ–Ψ–≥–Η―΅–Ϋ–Ψ –Ψ–±―΄―΅–Ϋ–Ψ–Ι –Φ–Α―à–Η–Ϋ–Β –ë–Ψ–Μ―¨―Ü–Φ–Α–Ϋ–Α, ―Ä–Α―¹―¹–Φ–Ψ―²―Ä–Η–Φ ―²–Ψ–Μ―¨–Κ–Ψ –¥–Μ―è ―¹–Κ―Ä―΄―²–Ψ–≥–Ψ ―¹–Μ–Ψ―è: P(hk = 1|v) = eβà£E1 eβà£E1 + eβà£E0 = 1 1 + eE1βà£E0 = 1 1 + eβà£bk β࣠n i vi wik = œÉ bk + n i=1 vi wik –£–Ψ–Ω―Ä–Ψ―¹: P(h|v) = ??? 38 / 60

- 40. RBM, –Ϋ–Β–Ζ–Α–≤–Η―¹–Η–Φ–Ψ―¹―²―¨ P(h|v) = m j=1 P(hj |v) P(v|h) = n i=1 P(vi |h) 39 / 60

- 41. RBM, ―Ü–Β–Μ–Β–≤–Α―è ―³―É–Ϋ–Κ―Ü–Η―è E(v, h) = β࣠n i=1 ai vi β࣠m j=1 bj hj β࣠n i=1 m j=1 wij vi hj (6) P(v) = 1 Z M t eβà£E(v,h(t) ) (7) –Φ–Α–Κ―¹–Η–Φ–Η–Ζ–Η―Ä–Ψ–≤–Α―²―¨ –≤–Β―Ä–Ψ―è―²–Ϋ–Ψ―¹―²―¨ –¥–Α–Ϋ–Ϋ―΄―Ö –Ω―Ä–Η –Ζ–Α–¥–Α–Ϋ–Ϋ–Ψ–Ι –≥–Β–Ϋ–Β―Ä–Α―²–Η–≤–Ϋ–Ψ–Ι –Φ–Ψ–¥–Β–Μ–Η ―΅―²–Ψ –±―É–¥–Β–Φ –¥–Β–Μ–Α―²―¨? 40 / 60

- 42. RBM, –¥–Η―³―³–Β―Ä–Β–Ϋ―Ü–Η―Ä–Ψ–≤–Α–Ϋ–Η–Β P(v), #1 E(v, h) = β࣠n i=1 ai vi β࣠m j=1 bj hj β࣠n i=1 m j=1 wij vi hj βà²E(v, h) βà²wij = ? βà²E(v, h) βà²ai = ? βà²E(v, h) βà²bj = ? βà²eβà£E(v,h) βà²wij = ? βà²eβà£E(v,h) βà²ai = ? βà²eβà£E(v,h) βà²bj = ? 41 / 60

- 43. RBM, –¥–Η―³―³–Β―Ä–Β–Ϋ―Ü–Η―Ä–Ψ–≤–Α–Ϋ–Η–Β P(v), #2 E(v, h) = β࣠n i=1 ai vi β࣠m j=1 bj hj β࣠n i=1 m j=1 wij vi hj βà²E(v, h) βà²wij = βà£vi hj βà²E(v, h) βà²ai = βà£vi βà²E(v, h) βà²bj = βà£hj βà²eβà£E(v,h) βà²wij = vi hj eβà£E(v,h) βà²eβà£E(v,h) βà²ai = vi eβà£E(v,h) βà²eβà£E(v,h) βà²bj = hj eβà£E(v,h) 42 / 60

- 44. RBM, –¥–Η―³―³–Β―Ä–Β–Ϋ―Ü–Η―Ä–Ψ–≤–Α–Ϋ–Η–Β P(v), #3 Z = N r M t eβà£E(v(r) ,h(t) ) βà²Z βà²wij = ? βà²Z βà²ai = ? βà²Z βà²bj = ? 43 / 60

- 45. RBM, –¥–Η―³―³–Β―Ä–Β–Ϋ―Ü–Η―Ä–Ψ–≤–Α–Ϋ–Η–Β P(v), #4 Z = N r M t eβà£E(v(r) ,h(t) ) βà²Z βà²wij = N r M t v (r) i h (t) j eβà£E(v(r) ,h(t) ) βà²Z βà²ai = N r M t v (r) i eβà£E(v(r) ,h(t) ) βà²Z βà²bj = N r M t h (t) j eβà£E(v(r) ,h(t) ) 44 / 60

- 46. RBM, –¥–Η―³―³–Β―Ä–Β–Ϋ―Ü–Η―Ä–Ψ–≤–Α–Ϋ–Η–Β P(v), #5 βà²P v(k) βà²wij = 1 Z2 Z M t v (k) i h (k) j eβà£E(v(r) ,h(t) ) β࣠M t eβà£E(v(r) ,h(t) ) N r M t v (r) i h (t) j eβà£E(v(r) ,h(t) ) βಠln P v(k) βà²wij = 1 P v(k) βà²P v(k) βà²wij 45 / 60

- 47. RBM, –¥–Η―³―³–Β―Ä–Β–Ϋ―Ü–Η―Ä–Ψ–≤–Α–Ϋ–Η–Β P(v), #6 βಠln P v(k) βà²wij = v (k) i M t h (t) j P h(t) |v(k) β࣠N r M t v (r) i h (t) j P h(t) , v(k) = ??? 46 / 60

- 48. RBM, –¥–Η―³―³–Β―Ä–Β–Ϋ―Ü–Η―Ä–Ψ–≤–Α–Ϋ–Η–Β P(v), #7 βಠln P v(k) βà²wij = M t v (k) i h (t) j P h(t) |v(k) β࣠N r M t v (r) i h (t) j P h(t) , v(k) = M v (k) i hj data β࣠M [vi hj ]model βಠln P v(k) βà²ai = v (k) i β࣠M [vi ]model βಠln P v(k) βà²bj = M [hj ]data β࣠M [hj ]model 47 / 60

- 49. RBM, –Ω―Ä–Α–≤–Η–Μ–Α –Ψ–±–Ϋ–Ψ–≤–Μ–Β–Ϋ–Η―è βàÜwij = ΈΖ M v (k) i hj data β࣠M [vi hj ]model βàÜai = ΈΖ v (k) i β࣠M [vi ]model βàÜbj = ΈΖ M [hj ]data β࣠M [hj ]model 48 / 60

- 50. –ê–Μ–≥–Ψ―Ä–Η―²–Φ Contrastive Divergence –Π–Β–Μ―¨: ―¹–Ψ–±―Ä–Α―²―¨ –¥–Ψ―¹―²–Α―²–Ψ―΅–Ϋ―É―é ―¹―²–Α―²–Η―¹―²–Η–Κ―É –¥–Μ―è –Ψ―Ü–Β–Ϋ–Κ–Η M[¬Ζ ¬Ζ ¬Ζ ]data –Η M[¬Ζ ¬Ζ ¬Ζ ]model –†–Η―¹.: –ü―Ä–Ψ―Ü–Β―¹―¹ ―¹–±–Ψ―Ä–Α –¥–Ψ―¹―²–Α―²–Ψ―΅–Ϋ–Ψ–Ι ―¹―²–Α―²–Η―¹―²–Η–Κ–Η7 βàÜwij = ΈΖ M v (k) i hj (0) β࣠M [vi hj ] (βàû) M [¬Ζ ¬Ζ ¬Ζ ] (0) - –Ω–Ψ–Ζ–Η―²–Η–≤–Ϋ–Α―è ―³–Α–Ζ–Α M [¬Ζ ¬Ζ ¬Ζ ] (βàû) - –Ϋ–Β–≥–Α―²–Η–≤–Ϋ–Α―è ―³–Α–Ζ–Α 7https://class.coursera.org/neuralnets-2012-001/lecture 49 / 60

- 51. –ü―Ä–Α–Κ―²–Η―΅–Β―¹–Κ–Η–Β ―¹–Ψ–≤–Β―²―΄ –Ϋ–Β ―¹–Β–Φ–Ω–Μ–Η―Ä–Ψ–≤–Α―²―¨ –≤–Η–¥–Η–Φ―΄–Ι ―¹–Μ–Ψ–Ι (―¹–Β–Φ–Ω–Μ–Η―Ä–Ψ–≤–Α–Ϋ–Η–Β –Ζ–Α–Φ–Β–¥–Μ―è–Β―² ―¹―Ö–Ψ–¥–Η–Φ–Ψ―¹―²―¨, –Ϋ–Ψ –Φ–Α―²–Β–Φ–Α―²–Η―΅–Β―¹–Κ–Η ―ç―²–Ψ –±–Ψ–Μ–Β–Β –Κ–Ψ―Ä―Ä–Β–Κ―²–Ϋ–Ψ); –Ϋ–Β ―¹–Β–Φ–Ω–Μ–Η―Ä–Ψ–≤–Α―²―¨ –Ζ–Ϋ–Α―΅–Β–Ϋ–Η―è ―¹–Κ―Ä―΄―²–Ψ–≥–Ψ ―¹–Μ–Ψ―è –Ω―Ä–Η –≤―΄–≤–Ψ–¥–Β –Η–Ζ –≤–Ψ―¹―¹―²–Α–Ϋ–Ψ–≤–Μ–Β–Ϋ–Ϋ–Ψ–≥–Ψ –Ψ–±―Ä–Α–Ζ–Α; CD-k, ―É–Ε–Β –Ω―Ä–Η k = 1 –Κ–Α―΅–Β―¹―²–≤–Ψ –Ϋ–Β ―¹–Η–Μ―¨–Ϋ–Ψ ―É―¹―²―É–Ω–Α–Β―² –±–Ψ–Μ―¨―à–Η–Φ –Ζ–Ϋ–Α―΅–Β–Ϋ–Η―è–Φ, –Ϋ–Ψ –≤―΄–Η–≥―Ä―΄―à –≤ ―¹–Κ–Ψ―Ä–Ψ―¹―²–Η –Ζ–Ϋ–Α―΅–Η―²–Β–Μ―¨–Ϋ―΄–Ι; ―Ä–Α–Ζ–Φ–Β―Ä –Φ–Η–Ϋ–Η–±–Α―²―΅–Α 10-100 ―ç–Κ–Ζ–Β–Φ–Ω–Μ―è―Ä–Ψ–≤ (–Ω–Ψ―΅–Β–Φ―É?); –Κ―Ä–Ψ―¹―¹–≤–Α–Μ–Η–¥–Α―Ü–Η –≤–Ψ―¹―¹―²–Α–Ϋ–Ψ–≤–Μ–Β–Ϋ–Ϋ―΄―Ö –Ψ–±―Ä–Α–Ζ–Ψ–≤; –Η―¹–Ω–Ψ–Μ―¨–Ζ–Ψ–≤–Α–Ϋ–Η–Β –Φ–Ψ–Φ–Β–Ϋ―²–Α ―¹–Κ–Α–Ζ―΄–≤–Α–Β―²―¹―è –Κ―Ä–Α–Ι–Ϋ–Β –Ω–Ψ–Μ–Ψ–Ε–Η―²–Β–Μ―¨–Ϋ–Ψ –Ϋ–Α ―¹–Κ–Ψ―Ä–Ψ―¹―²–Η ―¹―Ö–Ψ–¥–Η–Φ–Ψ―¹―²–Η; http://www.cs.toronto.edu/ hinton/absps/guideTR.pdf 50 / 60

- 54. –£–Η–Ζ―É–Α–Μ–Η–Ζ–Α―Ü–Η―è –Ω―Ä–Η–Ζ–Ϋ–Α–Κ–Ψ–≤, #2 –†–Η―¹.: –ü―Ä–Η–Ζ–Ϋ–Α–Κ–Η –Ϋ–Α –Φ–Ϋ–Ψ–Ε–Β―¹―²–≤–Β ―Ä―É–Κ–Ψ–Ω–Η―¹–Ϋ―΄―Ö ―Ü–Η―³―Ä MNIST8 8http://deeplearning.net/ 53 / 60

- 56. –£–Η–Ζ―É–Α–Μ–Η–Ζ–Α―Ü–Η―è –Ω―Ä–Η–Ζ–Ϋ–Α–Κ–Ψ–≤, #4 –†–Η―¹.: RBM –Κ–Α–Κ –±–Α–Ζ–Η―¹9 9http://cs.stanford.edu/ 55 / 60

- 57. –†–Β–≥―É–Μ―è―Ä–Η–Ζ–Α―Ü–Η―è –≤ RBM, #1 (a) RBM, no reg (b) RBM, L2 reg –†–Η―¹.: –‰–Μ–Μ―é―¹―²―Ä–Α―Ü–Η―è ―ç―³―³–Β–Κ―²–Α ―Ä–Β–≥―É–Μ―è―Ä–Η–Ζ–Α―Ü–Η–Η 56 / 60

- 58. –†–Β–≥―É–Μ―è―Ä–Η–Ζ–Α―Ü–Η―è –≤ RBM, #2 (a) RBM, L2 reg (b) RBM, L1 reg –†–Η―¹.: –‰–Μ–Μ―é―¹―²―Ä–Α―Ü–Η―è ―ç―³―³–Β–Κ―²–Α ―Ä–Β–≥―É–Μ―è―Ä–Η–Ζ–Α―Ü–Η–Η 57 / 60

- 60. –ß―²–Ψ –¥–Α–Μ―¨―à–Β? –†–Η―¹.: –™–Μ―É–±–Ψ–Κ–Α―è –Ϋ–Β–Ι―Ä–Ψ–Ϋ–Ϋ–Α―è ―¹–Β―²―¨10 10–‰–Ζ –Ω―Ä–Β–¥–Β–Ϋ―²–Α―Ü–Η–Η Scale Deep Learning, Jeο§Ä Dean 59 / 60

- 61. –£–Ψ–Ω―Ä–Ψ―¹―΄

![RBM, –¥–Η―³―³–Β―Ä–Β–Ϋ―Ü–Η―Ä–Ψ–≤–Α–Ϋ–Η–Β P(v), #7

βಠln P v(k)

βà²wij

=

M

t

v

(k)

i h

(t)

j P h(t)

|v(k)

βà£

N

r

M

t

v

(r)

i h

(t)

j P h(t)

, v(k)

= M v

(k)

i hj

data

β࣠M [vi hj ]model

βಠln P v(k)

βà²ai

= v

(k)

i β࣠M [vi ]model

βಠln P v(k)

βà²bj

= M [hj ]data β࣠M [hj ]model

47 / 60](https://image.slidesharecdn.com/lecture11-150417051141-conversion-gate02/85/12-48-320.jpg)

![RBM, –Ω―Ä–Α–≤–Η–Μ–Α –Ψ–±–Ϋ–Ψ–≤–Μ–Β–Ϋ–Η―è

βàÜwij = ΈΖ M v

(k)

i hj

data

β࣠M [vi hj ]model

βàÜai = ΈΖ v

(k)

i β࣠M [vi ]model

βàÜbj = ΈΖ M [hj ]data β࣠M [hj ]model

48 / 60](https://image.slidesharecdn.com/lecture11-150417051141-conversion-gate02/85/12-49-320.jpg)

![–ê–Μ–≥–Ψ―Ä–Η―²–Φ Contrastive Divergence

–Π–Β–Μ―¨: ―¹–Ψ–±―Ä–Α―²―¨ –¥–Ψ―¹―²–Α―²–Ψ―΅–Ϋ―É―é ―¹―²–Α―²–Η―¹―²–Η–Κ―É –¥–Μ―è –Ψ―Ü–Β–Ϋ–Κ–Η M[¬Ζ ¬Ζ ¬Ζ ]data –Η

M[¬Ζ ¬Ζ ¬Ζ ]model

–†–Η―¹.: –ü―Ä–Ψ―Ü–Β―¹―¹ ―¹–±–Ψ―Ä–Α –¥–Ψ―¹―²–Α―²–Ψ―΅–Ϋ–Ψ–Ι ―¹―²–Α―²–Η―¹―²–Η–Κ–Η7

βàÜwij = ΈΖ M v

(k)

i hj

(0)

β࣠M [vi hj ]

(βàû)

M [¬Ζ ¬Ζ ¬Ζ ]

(0)

- –Ω–Ψ–Ζ–Η―²–Η–≤–Ϋ–Α―è ―³–Α–Ζ–Α

M [¬Ζ ¬Ζ ¬Ζ ]

(βàû)

- –Ϋ–Β–≥–Α―²–Η–≤–Ϋ–Α―è ―³–Α–Ζ–Α

7https://class.coursera.org/neuralnets-2012-001/lecture

49 / 60](https://image.slidesharecdn.com/lecture11-150417051141-conversion-gate02/85/12-50-320.jpg)