–Ы–µ–Ї—Ж–Є—П 2

- 1. –Ы–µ–Ї—Ж–Є—П 2 . –Ю–і–љ–Њ—Б–ї–Њ–є–љ—Л–µ –Э–°.

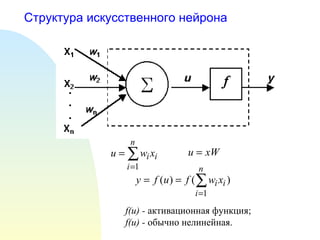

- 2. –°—В—А—Г–Ї—В—Г—А–∞ –Є—Б–Ї—Г—Б—Б—В–≤–µ–љ–љ–Њ–≥–Њ –љ–µ–є—А–Њ–љ–∞ f(u) - –∞–Ї—В–Є–≤–∞—Ж–Є–Њ–љ–љ–∞—П —Д—Г–љ–Ї—Ж–Є—П; f(u) - –Њ–±—Л—З–љ–Њ –љ–µ–ї–Є–љ–µ–є–љ–∞—П.

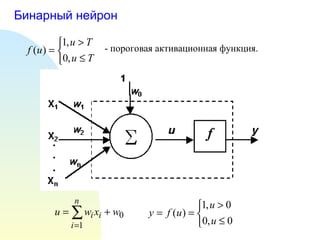

- 3. –С–Є–љ–∞—А–љ—Л–є –љ–µ–є—А–Њ–љ - –њ–Њ—А–Њ–≥–Њ–≤–∞—П –∞–Ї—В–Є–≤–∞—Ж–Є–Њ–љ–љ–∞—П —Д—Г–љ–Ї—Ж–Є—П.

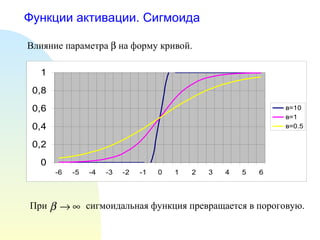

- 4. –§—Г–љ–Ї—Ж–Є–Є –∞–Ї—В–Є–≤–∞—Ж–Є–Є. –°–Є–≥–Љ–Њ–Є–і–∞ –°–Є–≥–Љ–Њ–Є–і–∞–ї—М–љ–∞—П ( S- –Њ–±—А–∞–Ј–љ–∞—П) —Д—Г–љ–Ї—Ж–Є—П: –њ–∞—А–∞–Љ–µ—В—А пБҐ –≤—Л–±–Є—А–∞–µ—В—Б—П –њ–Њ–ї—М–Ј–Њ–≤–∞—В–µ–ї–µ–Љ.

- 5. –§—Г–љ–Ї—Ж–Є–Є –∞–Ї—В–Є–≤–∞—Ж–Є–Є. –°–Є–≥–Љ–Њ–Є–і–∞ –Т–ї–Є—П–љ–Є–µ –њ–∞—А–∞–Љ–µ—В—А–∞ пБҐ –љ–∞ —Д–Њ—А–Љ—Г –Ї—А–Є–≤–Њ–є. —Б–Є–≥–Љ–Њ–Є–і–∞–ї—М–љ–∞—П —Д—Г–љ–Ї—Ж–Є—П –њ—А–µ–≤—А–∞—Й–∞–µ—В—Б—П –≤ –њ–Њ—А–Њ–≥–Њ–≤—Г—О. –Я—А–Є

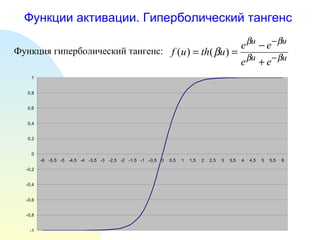

- 6. –§—Г–љ–Ї—Ж–Є–Є –∞–Ї—В–Є–≤–∞—Ж–Є–Є. –У–Є–њ–µ—А–±–Њ–ї–Є—З–µ—Б–Ї–Є–є —В–∞–љ–≥–µ–љ—Б –§—Г–љ–Ї—Ж–Є—П –≥–Є–њ–µ—А–±–Њ–ї–Є—З–µ—Б–Ї–Є–є —В–∞–љ–≥–µ–љ—Б:

- 7. –†–µ–ґ–Є–Љ—Л —А–∞–±–Њ—В—Л –Э–°. –Ю–±—Г—З–µ–љ–Є–µ –¶–µ–ї—М –Њ–±—Г—З–µ–љ–Є–µ - –≤—Л—З–Є—Б–ї–µ–љ–Є–µ –≤–µ—Б–Њ–≤ —Б–Є–љ–∞–њ—В–Є—З–µ—Б–Ї–Є—Е —Б–≤—П–Ј–µ–є —Б–µ—В–Є. –Ю–±—Г—З–µ–љ–Є–µ –њ—А–Њ–≤–Њ–і–Є—В—Б—П –љ–∞ –њ—А–Є–Љ–µ—А–∞—Е. –Ю–±—Г—З–∞—О—Й–∞—П –≤—Л–±–Њ—А–Ї–∞: S={(x i ,d i )|i=1,2,вА¶,N} . x i вАУ –≤—Е–Њ–і–љ–Њ–є –≤–µ–Ї—В–Њ—А ; d i - –≤–µ–Ї—В–Њ—А, –Њ–њ—А–µ–і–µ–ї—П—О—Й–Є–є –Ї–ї–∞—Б—Б –≤—Е–Њ–і–љ–Њ–≥–Њ –≤–µ–Ї—В–Њ—А–∞ . –Я—А–Њ—Ж–µ—Б—Б –Њ–±—Г—З–µ–љ–Є—П –Ј–∞–Ї–ї—О—З–∞–µ—В—Б—П –≤ –њ–Њ—Б–ї–µ–і–Њ–≤–∞—В–µ–ї—М–љ–Њ–Љ –њ—А–Є–Љ–µ–љ–µ–љ–Є–Є –Э–° –Ї –≤–µ–Ї—В–Њ—А–∞–Љ –Є–Ј –Њ–±—Г—З–∞—О—Й–µ–є –≤—Л–±–Њ—А–Ї–Є —Б –Њ–і–љ–Њ–≤—А–µ–Љ–µ–љ–љ–Њ–є –Ї–Њ—А—А–µ–Ї—Ж–Є–µ–є –≤–µ—Б–Њ–≤ —Б–Є–љ–∞–њ—В–Є—З–µ—Б–Ї–Є—Е —Б–≤—П–Ј–µ–є. –Я—А–Њ—Ж–µ—Б—Б –Њ–±—Г—З–µ–љ–Є—П —Б–Њ—Б—В–Њ–Є—В –Є–Ј –љ–∞–±–Њ—А–∞ –Є—В–µ—А–∞—Ж–Є–є, –≤ —А–∞–Љ–Ї–∞—Е –Ї–∞–ґ–і–Њ–є –Є–Ј –љ–Є—Е —Б–µ—В—М –Њ–±—Г—З–∞–µ—В—Б—П –љ–∞ –≤—Б–µ—Е –њ—А–Є–Љ–µ—А–∞—Е –Є–Ј –Њ–±—Г—З–∞—О—Й–µ–є –≤—Л–±–Њ—А–Ї–Є.

- 8. –†–µ–ґ–Є–Љ—Л —А–∞–±–Њ—В—Л –Э–°. –Ю–±—Г—З–µ–љ–Є–µ –Я—Г—Б—В—М g i - –≤—Л—Е–Њ–і –Э–° –і–ї—П –≤—Е–Њ–і–љ–Њ–≥–Њ –≤–µ–Ї—В–Њ—А–∞ x i . –°–Љ—Л—Б–ї–Њ–Љ –∞–ї–≥–Њ—А–Є—В–Љ–∞ –Њ–±—Г—З–µ–љ–Є—П —П–≤–ї—П–µ—В—Б—П —Б—А–∞–≤–љ–µ–љ–Є–µ –ґ–µ–ї–∞–µ–Љ–Њ–≥–Њ ( d i ) –Є —А–µ–∞–ї—М–љ–Њ–≥–Њ ( g i ) –≤—Л—Е–Њ–і–Њ–≤ –Є –Ї–Њ—А—А–µ–Ї—В–Є—А–Њ–≤–Ї–∞ –≤—Б–µ—Е –≤–µ—Б–Њ–≤ –≤ —Б–µ—В–Є —В–∞–Ї–Є–Љ –Њ–±—А–∞–Ј–Њ–Љ, —З—В–Њ–±—Л –љ–Њ–≤—Л–є –≤—Л—Е–Њ–і–љ–Њ–є –≤–µ–Ї—В–Њ—А –і–ї—П —Н—В–Њ–≥–Њ –ґ–µ –≤—Е–Њ–і–љ–Њ–≥–Њ –≤–µ–Ї—В–Њ—А–∞ –±—Л–ї ¬Ђ–±–ї–Є–ґ–µ¬ї –Ї –ґ–µ–ї–∞–µ–Љ–Њ–Љ—Г, —З–µ–Љ –њ—А–µ–і—Л–і—Г—Й–Є–є. –Ъ—А–Є—В–µ—А–Є–є –Њ–Ї–Њ–љ—З–∞–љ–Є—П –њ—А–Њ—Ж–µ—Б—Б–∞ –Њ–±—Г—З–µ–љ–Є—П - —Б—Г–Љ–Љ–∞—А–љ–∞—П –Њ—И–Є–±–Ї–∞ –љ–∞ –≤—Б–µ—Е –њ—А–Є–Љ–µ—А–∞—Е –Њ–±—Г—З–∞—О—Й–µ–є –≤—Л–±–Њ—А–Ї–Є –і–Њ–ї–ґ–љ–∞ –±—Л—В—М –Љ–µ–љ—М—И–µ –Ј–∞–і–∞–љ–љ–Њ–≥–Њ –њ–Њ—А–Њ–≥–∞. –Я—А–Њ–±–ї–µ–Љ—Л, –≤–Њ–Ј–љ–Є–Ї–∞—О—Й–Є–µ –љ–∞ —Н—В–∞–њ–µ –Њ–±—Г—З–µ–љ–Є—П: 1. –Т—Л–±–Њ—А –∞–ї–≥–Њ—А–Є—В–Љ–∞ –Њ–±—Г—З–µ–љ–Є—П. 2. –Я–Њ—Б—В—А–Њ–µ–љ–Є–µ –Њ–±—Г—З–∞—О—Й–µ–є –≤—Л–±–Њ—А–Ї–Є. 3. –Э–∞—З–∞–ї—М–љ–∞—П –Є–љ–Є—Ж–Є–∞–ї–Є–Ј–∞—Ж–Є—П –≤–µ—Б–Њ–≤. 4. –Ю–њ—А–µ–і–µ–ї–µ–љ–Є–µ –Љ–Њ–Љ–µ–љ—В–∞ –Њ–Ї–Њ–љ—З–∞–љ–Є—П –њ—А–Њ—Ж–µ—Б—Б–∞ –Њ–±—Г—З–µ–љ–Є—П.

- 9. –†–µ–ґ–Є–Љ—Л —А–∞–±–Њ—В—Л –Э–°. –§—Г–љ–Ї—Ж–Є–Њ–љ–Є—А–Њ–≤–∞–љ–Є–µ –Э–° –Т—Е–Њ–і –Э–°: –≤–µ–Ї—В–Њ—А –љ–µ–Є–Ј–≤–µ—Б—В–љ–Њ–≥–Њ –Ї–ї–∞—Б—Б–∞. –Я—А–Њ–≤–µ–і–µ–љ–Є–µ –≤—Л—З–Є—Б–ї–µ–љ–Є–є –≤ –љ–µ–є—А–Њ–љ–∞—Е –≤–љ—Г—В—А–µ–љ–љ–Є—Е —Б–ї–Њ–µ–≤. –Т—Л—Е–Њ–і –Э–°: –≤–µ–Ї—В–Њ—А g , —Е–∞—А–∞–Ї—В–µ—А–Є–Ј—Г—О—Й–Є–є –Ї–ї–∞—Б—Б –≤—Е–Њ–і–љ–Њ–≥–Њ –≤–µ–Ї—В–Њ—А–∞.

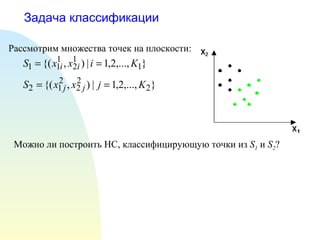

- 10. –Ч–∞–і–∞—З–∞ –Ї–ї–∞—Б—Б–Є—Д–Є–Ї–∞—Ж–Є–Є –†–∞—Б—Б–Љ–Њ—В—А–Є–Љ –Љ–љ–Њ–ґ–µ—Б—В–≤–∞ —В–Њ—З–µ–Ї –љ–∞ –њ–ї–Њ—Б–Ї–Њ—Б—В–Є: –Ь–Њ–ґ–љ–Њ –ї–Є –њ–Њ—Б—В—А–Њ–Є—В—М –Э–°, –Ї–ї–∞—Б—Б–Є—Д–Є—Ж–Є—А—Г—О—Й—Г—О —В–Њ—З–Ї–Є –Є–Ј S 1 –Є S 2 ?

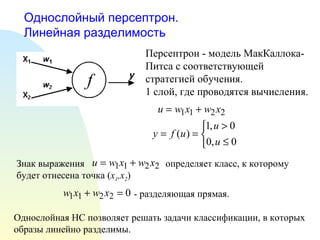

- 11. –Ю–і–љ–Њ—Б–ї–Њ–є–љ—Л–є –њ–µ—А—Б–µ–њ—В—А–Њ–љ. –Ы–Є–љ–µ–є–љ–∞—П —А–∞–Ј–і–µ–ї–Є–Љ–Њ—Б—В—М –Ю–і–љ–Њ—Б–ї–Њ–є–љ–∞—П –Э–° –њ–Њ–Ј–≤–Њ–ї—П–µ—В —А–µ—И–∞—В—М –Ј–∞–і–∞—З–Є –Ї–ї–∞—Б—Б–Є—Д–Є–Ї–∞—Ж–Є–Є, –≤ –Ї–Њ—В–Њ—А—Л—Е –Њ–±—А–∞–Ј—Л –ї–Є–љ–µ–є–љ–Њ —А–∞–Ј–і–µ–ї–Є–Љ—Л. –Я–µ—А—Б–µ–њ—В—А–Њ–љ - –Љ–Њ–і–µ–ї—М –Ь–∞–Ї–Ъ–∞–ї–ї–Њ–Ї–∞-–Я–Є—В—Б–∞ —Б —Б–Њ–Њ—В–≤–µ—В—Б—В–≤—Г—О—Й–µ–є —Б—В—А–∞—В–µ–≥–Є–µ–є –Њ–±—Г—З–µ–љ–Є—П. 1 —Б–ї–Њ–є, –≥–і–µ –њ—А–Њ–≤–Њ–і—П—В—Б—П –≤—Л—З–Є—Б–ї–µ–љ–Є—П. –Ч–љ–∞–Ї –≤—Л—А–∞–ґ–µ–љ–Є—П –Њ–њ—А–µ–і–µ–ї—П–µ—В –Ї–ї–∞—Б—Б, –Ї –Ї–Њ—В–Њ—А–Њ–Љ—Г –±—Г–і–µ—В –Њ—В–љ–µ—Б–µ–љ–∞ —В–Њ—З–Ї–∞ ( x 1 ,x 2 ) - —А–∞–Ј–і–µ–ї—П—О—Й–∞—П –њ—А—П–Љ–∞—П.

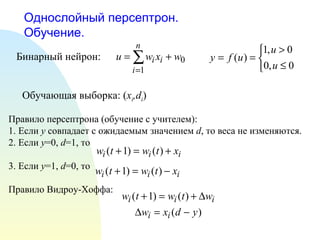

- 12. –Ю–і–љ–Њ—Б–ї–Њ–є–љ—Л–є –њ–µ—А—Б–µ–њ—В—А–Њ–љ. –Ю–±—Г—З–µ–љ–Є–µ. –С–Є–љ–∞—А–љ—Л–є –љ–µ–є—А–Њ–љ: –Ю–±—Г—З–∞—О—Й–∞—П –≤—Л–±–Њ—А–Ї–∞: ( x i ,d i ) –Я—А–∞–≤–Є–ї–Њ –њ–µ—А—Б–µ–њ—В—А–Њ–љ–∞ (–Њ–±—Г—З–µ–љ–Є–µ —Б —Г—З–Є—В–µ–ї–µ–Љ): 1. –Х—Б–ї–Є y —Б–Њ–≤–њ–∞–і–∞–µ—В —Б –Њ–ґ–Є–і–∞–µ–Љ—Л–Љ –Ј–љ–∞—З–µ–љ–Є–µ–Љ d , —В–Њ –≤–µ—Б–∞ –љ–µ –Є–Ј–Љ–µ–љ—П—О—В—Б—П. 2. –Х—Б–ї–Є y =0, d =1, —В–Њ 3. –Х—Б–ї–Є y =1, d =0, —В–Њ –Я—А–∞–≤–Є–ї–Њ –Т–Є–і—А–Њ—Г-–•–Њ—Д—Д–∞:

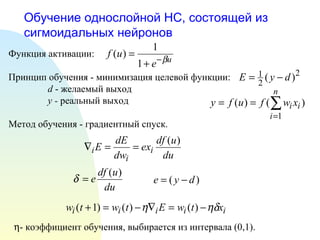

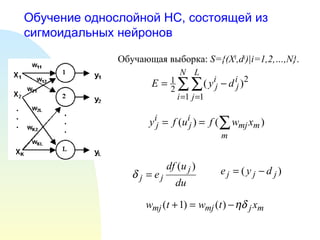

- 13. –Ю–±—Г—З–µ–љ–Є–µ –Њ–і–љ–Њ—Б–ї–Њ–є–љ–Њ–є –Э–°, —Б–Њ—Б—В–Њ—П—Й–µ–є –Є–Ј —Б–Є–≥–Љ–Њ–Є–і–∞–ї—М–љ—Л—Е –љ–µ–є—А–Њ–љ–Њ–≤ –§—Г–љ–Ї—Ж–Є—П –∞–Ї—В–Є–≤–∞—Ж–Є–Є: –Я—А–Є–љ—Ж–Є–њ –Њ–±—Г—З–µ–љ–Є—П - –Љ–Є–љ–Є–Љ–Є–Ј–∞—Ж–Є—П —Ж–µ–ї–µ–≤–Њ–є —Д—Г–љ–Ї—Ж–Є–Є: d - –ґ–µ–ї–∞–µ–Љ—Л–є –≤—Л—Е–Њ–і y - —А–µ–∞–ї—М–љ—Л–є –≤—Л—Е–Њ–і –Ь–µ—В–Њ–і –Њ–±—Г—З–µ–љ–Є—П - –≥—А–∞–і–Є–µ–љ—В–љ—Л–є —Б–њ—Г—Б–Ї. пБ® - –Ї–Њ—Н—Д—Д–Є—Ж–Є–µ–љ—В –Њ–±—Г—З–µ–љ–Є—П, –≤—Л–±–Є—А–∞–µ—В—Б—П –Є–Ј –Є–љ—В–µ—А–≤–∞–ї–∞ (0,1).

- 14. –Ю–±—Г—З–µ–љ–Є–µ –Њ–і–љ–Њ—Б–ї–Њ–є–љ–Њ–є –Э–°, —Б–Њ—Б—В–Њ—П—Й–µ–є –Є–Ј —Б–Є–≥–Љ–Њ–Є–і–∞–ї—М–љ—Л—Е –љ–µ–є—А–Њ–љ–Њ–≤ –Ю–±—Г—З–∞—О—Й–∞—П –≤—Л–±–Њ—А–Ї–∞: S={(X i ,d i )|i=1,2,вА¶,N} .

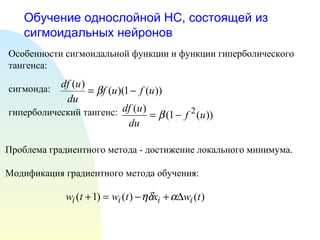

- 15. –Ю–±—Г—З–µ–љ–Є–µ –Њ–і–љ–Њ—Б–ї–Њ–є–љ–Њ–є –Э–°, —Б–Њ—Б—В–Њ—П—Й–µ–є –Є–Ј —Б–Є–≥–Љ–Њ–Є–і–∞–ї—М–љ—Л—Е –љ–µ–є—А–Њ–љ–Њ–≤ –Ю—Б–Њ–±–µ–љ–љ–Њ—Б—В–Є —Б–Є–≥–Љ–Њ–Є–і–∞–ї—М–љ–Њ–є —Д—Г–љ–Ї—Ж–Є–Є –Є —Д—Г–љ–Ї—Ж–Є–Є –≥–Є–њ–µ—А–±–Њ–ї–Є—З–µ—Б–Ї–Њ–≥–Њ —В–∞–љ–≥–µ–љ—Б–∞: —Б–Є–≥–Љ–Њ–Є–і–∞: –≥–Є–њ–µ—А–±–Њ–ї–Є—З–µ—Б–Ї–Є–є —В–∞–љ–≥–µ–љ—Б: –Я—А–Њ–±–ї–µ–Љ–∞ –≥—А–∞–і–Є–µ–љ—В–љ–Њ–≥–Њ –Љ–µ—В–Њ–і–∞ - –і–Њ—Б—В–Є–ґ–µ–љ–Є–µ –ї–Њ–Ї–∞–ї—М–љ–Њ–≥–Њ –Љ–Є–љ–Є–Љ—Г–Љ–∞. –Ь–Њ–і–Є—Д–Є–Ї–∞—Ж–Є—П –≥—А–∞–і–Є–µ–љ—В–љ–Њ–≥–Њ –Љ–µ—В–Њ–і–∞ –Њ–±—Г—З–µ–љ–Є—П:

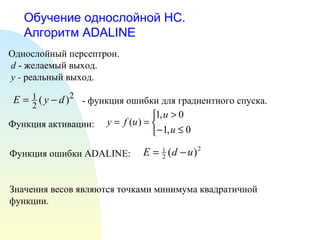

- 16. –Ю–±—Г—З–µ–љ–Є–µ –Њ–і–љ–Њ—Б–ї–Њ–є–љ–Њ–є –Э–°. –Р–ї–≥–Њ—А–Є—В–Љ ADALINE –Ю–і–љ–Њ—Б–ї–Њ–є–љ—Л–є –њ–µ—А—Б–µ–њ—В—А–Њ–љ. d - –ґ–µ–ї–∞–µ–Љ—Л–є –≤—Л—Е–Њ–і. y - —А–µ–∞–ї—М–љ—Л–є –≤—Л—Е–Њ–і. - —Д—Г–љ–Ї—Ж–Є—П –Њ—И–Є–±–Ї–Є –і–ї—П –≥—А–∞–і–Є–µ–љ—В–љ–Њ–≥–Њ —Б–њ—Г—Б–Ї–∞. –§—Г–љ–Ї—Ж–Є—П –∞–Ї—В–Є–≤–∞—Ж–Є–Є: –§—Г–љ–Ї—Ж–Є—П –Њ—И–Є–±–Ї–Є ADALINE: –Ч–љ–∞—З–µ–љ–Є—П –≤–µ—Б–Њ–≤ —П–≤–ї—П—О—В—Б—П —В–Њ—З–Ї–∞–Љ–Є –Љ–Є–љ–Є–Љ—Г–Љ–∞ –Ї–≤–∞–і—А–∞—В–Є—З–љ–Њ–є —Д—Г–љ–Ї—Ж–Є–Є.

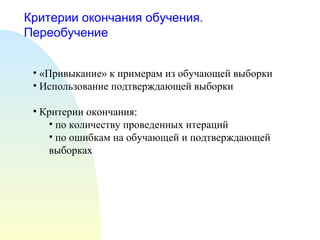

- 17. –Ъ—А–Є—В–µ—А–Є–Є –Њ–Ї–Њ–љ—З–∞–љ–Є—П –Њ–±—Г—З–µ–љ–Є—П. –Я–µ—А–µ–Њ–±—Г—З–µ–љ–Є–µ ¬Ђ–Я—А–Є–≤—Л–Ї–∞–љ–Є–µ¬ї –Ї –њ—А–Є–Љ–µ—А–∞–Љ –Є–Ј –Њ–±—Г—З–∞—О—Й–µ–є –≤—Л–±–Њ—А–Ї–Є –Ш—Б–њ–Њ–ї—М–Ј–Њ–≤–∞–љ–Є–µ –њ–Њ–і—В–≤–µ—А–ґ–і–∞—О—Й–µ–є –≤—Л–±–Њ—А–Ї–Є –Ъ—А–Є—В–µ—А–Є–Є –Њ–Ї–Њ–љ—З–∞–љ–Є—П: –њ–Њ –Ї–Њ–ї–Є—З–µ—Б—В–≤—Г –њ—А–Њ–≤–µ–і–µ–љ–љ—Л—Е –Є—В–µ—А–∞—Ж–Є–є –њ–Њ –Њ—И–Є–±–Ї–∞–Љ –љ–∞ –Њ–±—Г—З–∞—О—Й–µ–є –Є –њ–Њ–і—В–≤–µ—А–ґ–і–∞—О—Й–µ–є –≤—Л–±–Њ—А–Ї–∞—Е

Editor's Notes

- #5: –§–Њ—А–Љ–∞ —Д—Г–љ–Ї—Ж–Є–Є —А–µ–≥—Г–ї–Є—А—Г–µ—В —Б—В–µ–њ–µ–љ—М —Г—Б–Є–ї–µ–љ–Є—П —Б–Є–≥–љ–∞–ї–∞.

- #15: –Ю–±—Й–∞—П —Б—Е–µ–Љ–∞ –∞–ї–≥–Њ—А–Є—В–Љ–∞ –Њ–±—Г—З–µ–љ–Є—П

- #16: –Я—А–Њ–±–ї–µ–Љ—Л —Б –∞–ї–≥–Њ—А–Є—В–Љ–Њ–Љ –Њ–±—Г—З–µ–љ–Є—П –њ–µ—А—Б–µ–њ—В—А–Њ–љ–∞: –Э–µ–Њ–±—Е–Њ–і–Є–Љ–Њ—Б—В—М –ї–Є–љ–µ–є–љ–Њ–є —А–∞–Ј–і–µ–ї–Є–Љ–Њ—Б—В–Є –Р–ї–≥–Њ—А–Є—В–Љ —Б–Њ–є–і–µ—В—Б—П –Ј–∞ –Ї–Њ–љ–µ—З–љ–Њ–µ –≤—А–µ–Љ—П –Э–µ –і–Њ–Ї–∞–Ј–∞–љ–Њ, —З—В–Њ –Њ–љ –±—Л—Б—В—А–µ–µ –њ–Њ–ї–љ–Њ–≥–Њ –њ–µ—А–µ–±–Њ—А–∞