机械学习を用いた东西日本の境界线决定

- 2. 本研究の流れ 1. 自己紹介 2. はじめに 3. 実験方法 4. 結果およびまとめ 5. 参考文献?参考資料 2

- 3. 自己紹介 ? gamma ? 群馬県出身 ? 慶應→東大院(M1) ? 研究分野:セキュリティ ? SecCap 受講中 ? twitter: @ngkry 3

- 4. はじめに 4

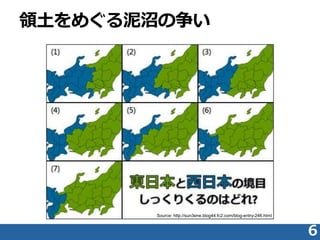

- 5. 本研究の動機付け ? 東日本と西日本 ? 文化や言葉が大きく相違 ? 一方でその境界は曖昧 ? 困難な境界線の決定 ? 膨大な判断基準 ? 出身地ごとのバイアス ? 多種多様な情報から 客観的判断を下せる主体の不在 5 機械学習によって東西日本の境界線を決定しよう!

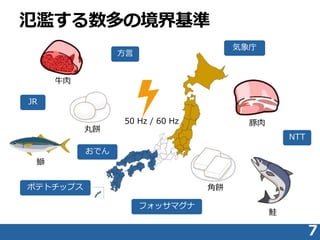

- 7. 氾濫する数多の境界基準 7 牛肉 豚肉 丸餅 角餅 50 Hz / 60 Hz フォッサマグナ ポテトチップス 気象庁 方言 NTT JR おでん 鮭 鰤

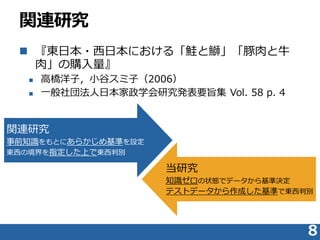

- 8. 関連研究 ? 『東日本?西日本における「鮭と鰤」「豚肉と牛 肉」の購入量』 ? 高橋洋子,小谷スミ子(2006) ? 一般社団法人日本家政学会研究発表要旨集 Vol. 58 p. 4 8 関連研究 事前知識をもとにあらかじめ基準を設定 東西の境界を指定した上で東西判別 当研究 知識ゼロの状態でデータから基準決定 テストデータから作成した基準で東西判別

- 9. 実験方法 9

- 10. 実験概要 ? 実験対象 ? テストデータ(9県) ? 富山,石川,福井,山梨,長野,岐阜,静岡,愛知,三重 ? 訓練データ(その他38都道府県) ? 使用したデータ ? e-Stat(政府統計の総合窓口)から選別 ? 246変数+フラグ(東日本/西日本) ? e.g. 面積,人口,農産物,漁獲量... ? 実験環境 ? RStudio version 0.98.1103 ? OS X Yosemite version 10.10.4 (4GB, 1.6GHz i5) 10

- 11. 実験で用いた手法 ? 線形判別分析(lda) ? k 近傍法 ? 決定木 ? ニューラルネットワーク ? サポートベクターマシン(SVM) ? バギング ? ブースティング ? ランダムフォレスト 11

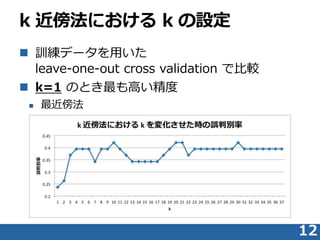

- 12. k 近傍法における k の設定 ? 訓練データを用いた leave-one-out cross validation で比較 ? k=1 のとき最も高い精度 ? 最近傍法 12

- 13. 結果およびまとめ 13

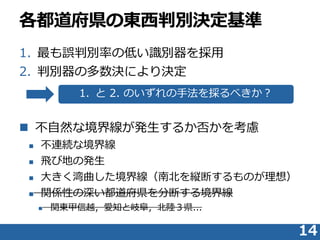

- 14. 各都道府県の東西判別決定基準 1. 最も誤判別率の低い識別器を採用 2. 判別器の多数決により決定 ? 不自然な境界線が発生するか否かを考慮 ? 不連続な境界線 ? 飛び地の発生 ? 大きく湾曲した境界線(南北を縦断するものが理想) ? 関係性の深い都道府県を分断する境界線 ? 関東甲信越,愛知と岐阜,北陸3県... 14 1. と 2. のいずれの手法を採るべきか?

- 15. 各判別器の交差確認 ? 訓練データを用いた 各判別器の leave-one-out cross validation ? SVM の完全勝利 15

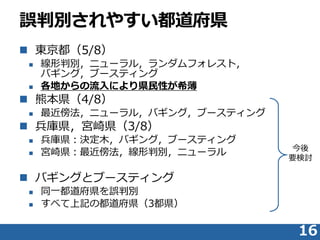

- 16. 誤判別されやすい都道府県 ? 東京都(5/8) ? 線形判別,ニューラル,ランダムフォレスト, バギング,ブースティング ? 各地からの流入により県民性が希薄 ? 熊本県(4/8) ? 最近傍法,ニューラル,バギング,ブースティング ? 兵庫県,宮崎県(3/8) ? 兵庫県:決定木,バギング,ブースティング ? 宮崎県:最近傍法,線形判別,ニューラル ? バギングとブースティング ? 同一都道府県を誤判別 ? すべて上記の都道府県(3都県) 16 今後 要検討

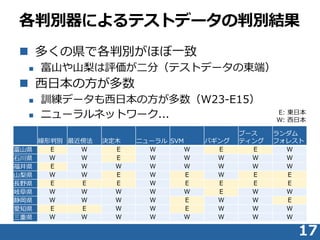

- 17. ? 多くの県で各判別がほぼ一致 ? 富山や山梨は評価が二分(テストデータの東端) ? 西日本の方が多数 ? 訓練データも西日本の方が多数(W23-E15) ? ニューラルネットワーク... 17 各判別器によるテストデータの判別結果 線形判別 最近傍法 決定木 ニューラル SVM バギング ブース ティング ランダム フォレスト 富山県 E W E W W E E W 石川県 W W E W W W W W 福井県 E W W W W W W W 山梨県 W W E W E W E E 長野県 E E E W E E E E 岐阜県 W W W W W E W W 静岡県 W W W W E W W E 愛知県 E E W W E W W W 三重県 W W W W W W W W E: 東日本 W: 西日本

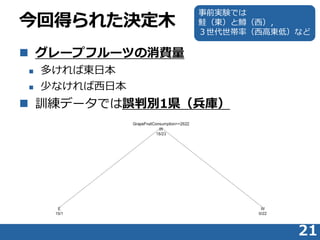

- 21. 今回得られた決定木 ? グレープフルーツの消費量 ? 多ければ東日本 ? 少なければ西日本 ? 訓練データでは誤判別1県(兵庫) 21 事前実験では 鮭(東)と鱒(西), 3世代世帯率(西高東低)など

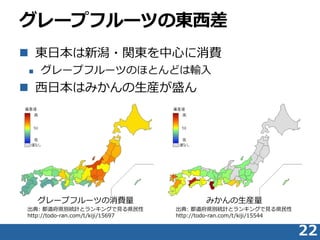

- 22. グレープフルーツの東西差 ? 東日本は新潟?関東を中心に消費 ? グレープフルーツのほとんどは輸入 ? 西日本はみかんの生産が盛ん 22 出典: 都道府県別統計とランキングで見る県民性 http://todo-ran.com/t/kiji/15697 グレープフルーツの消費量 出典: 都道府県別統計とランキングで見る県民性 http://todo-ran.com/t/kiji/15544 みかんの生産量

- 24. SVM による東西判別結果 24

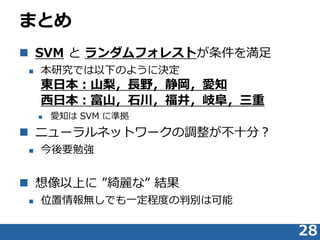

- 28. まとめ ? SVM と ランダムフォレストが条件を満足 ? 本研究では以下のように決定 東日本:山梨,長野,静岡,愛知 西日本:富山,石川,福井,岐阜,三重 ? 愛知は SVM に準拠 ? ニューラルネットワークの調整が不十分? ? 今後要勉強 ? 想像以上に ”綺麗な” 結果 ? 位置情報無しでも一定程度の判別は可能 28

- 29. 参考文献?参考資料 ? 参考文献 ? 『Rによるデータサイエンス データ解析の基礎から最新手法まで』 ? 金明哲(2007) ? 森北出版 320 pp. ? 参考資料 ? e-Stat 政府統計の総合窓口 ? http://www.e-stat.go.jp/SG1/estat/eStatTopPortal.do ? 都道府県別統計とランキングで見る県民性 ? http://todo-ran.com/ ? 出身地鑑定!! 方言チャート(東京女子大学篠崎ゼミ×ジャパンナ レッジ) ? http://ssl.japanknowledge.jp/hougen/ ? 栃木県出身と判別されました ? 白地図ぬりぬり ? 結果の日本地図を作成しました ? http://n.freemap.jp 29

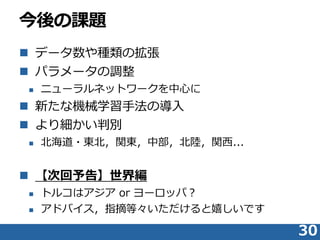

- 30. 今後の課題 ? データ数や種類の拡張 ? パラメータの調整 ? ニューラルネットワークを中心に ? 新たな機械学習手法の導入 ? より細かい判別 ? 北海道?東北,関東,中部,北陸,関西... ? 【次回予告】世界編 ? トルコはアジア or ヨーロッパ? ? アドバイス,指摘等々いただけると嬉しいです 30

Editor's Notes

- #22: 事前実験?の説明