ニューラルネットワーク勉强会2

- 3. 本日の予定 ? 3層ニューラルネットワークによるXOR問題を解き ます。 ? ニューラルネットワークの基礎を知る ? Chainerによるネットワークの実装を知る 簡単なニューラルネットワークを Chainer上で実装できるようになる!

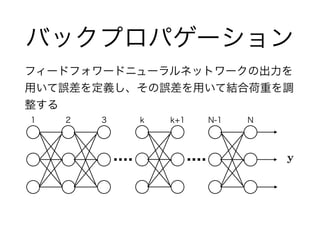

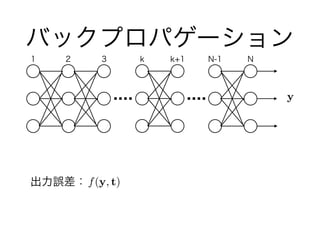

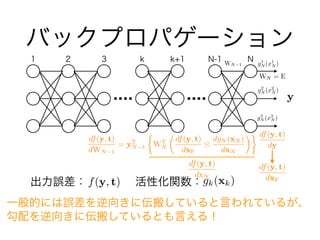

- 10. バックプロパゲーション 出力誤差:f(y, t) y 1 2 3 k k+1 N-1 N

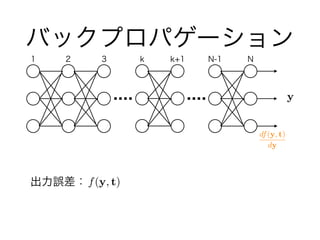

- 11. バックプロパゲーション 出力誤差:f(y, t) y 1 2 3 k k+1 N-1 N df(y, t) dy

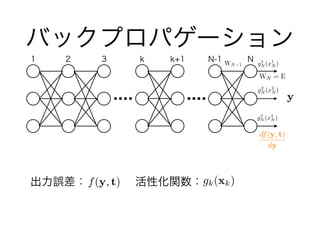

- 12. バックプロパゲーション 出力誤差:??? ?活性化関数:f(y, t) y 1 2 3 k k+1 N-1 N df(y, t) dy g1 N (x1 N ) g2 N (x2 N ) g3 N (x3 N ) WN 1 WN = E gk(xk)

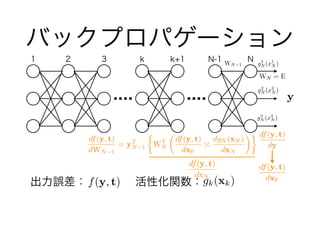

- 13. 出力誤差:??? ?活性化関数: バックプロパゲーション f(y, t) y 1 2 3 k k+1 N-1 N df(y, t) dy g1 N (x1 N ) g2 N (x2 N ) g3 N (x3 N ) WN 1 WN = E df(y, t) dxN df(y, t) dWN 1 = yT N 1 ? WT N ? df(y, t) dxF ? dgN (xN ) dxN ◆ df(y, t) dxFgk(xk)

- 14. gk(xk)出力誤差:??? ?活性化関数: バックプロパゲーション f(y, t) y 1 2 3 k k+1 N-1 N df(y, t) dy g1 N (x1 N ) g2 N (x2 N ) g3 N (x3 N ) WN 1 WN = E df(y, t) dxN df(y, t) dWN 1 = yT N 1 ? WT N ? df(y, t) dxF ? dgN (xN ) dxN ◆ df(y, t) dxF 一般的には誤差を逆向きに伝搬していると言われているが、 勾配を逆向きに伝搬しているとも言える!

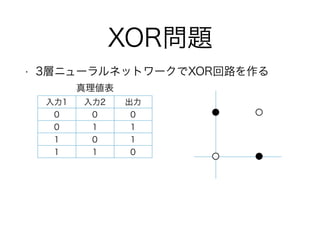

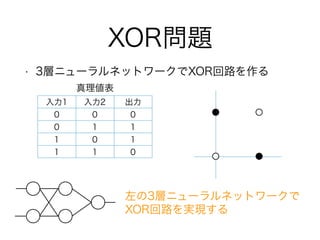

- 20. XOR問題 ? 3層ニューラルネットワークでXOR回路を作る 入力1 入力2 出力 0 0 0 0 1 1 1 0 1 1 1 0 真理値表

- 21. XOR問題 ? 3層ニューラルネットワークでXOR回路を作る 入力1 入力2 出力 0 0 0 0 1 1 1 0 1 1 1 0 真理値表 左の3層ニューラルネットワークで XOR回路を実現する

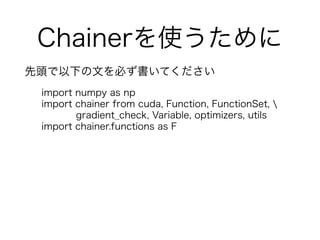

- 26. Chainerを使うために 先頭で以下の文を必ず書いてください import numpy as np import chainer from cuda, Function, FunctionSet, gradient_check, Variable, optimizers, utils import chainer.functions as F

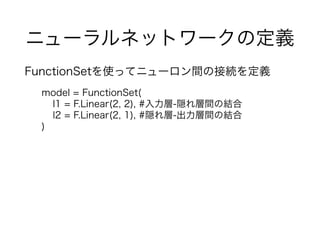

- 27. ニューラルネットワークの定義 FunctionSetを使ってニューロン間の接続を定義 model = FunctionSet( l1 = F.Linear(2, 2), #入力層-隠れ層間の結合 l2 = F.Linear(2, 1), #隠れ層-出力層間の結合 )

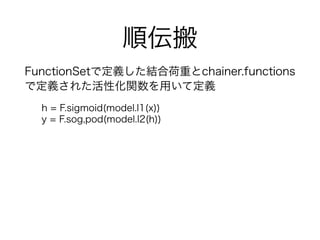

- 28. 順伝搬 FunctionSetで定義した結合荷重とchainer.functions で定義された活性化関数を用いて定義 h = F.sigmoid(model.l1(x)) y = F.sog,pod(model.l2(h))

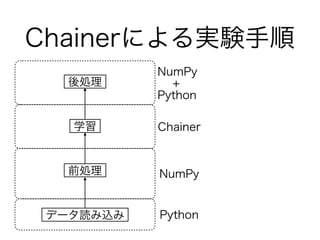

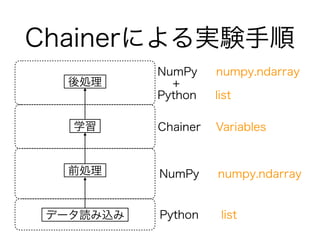

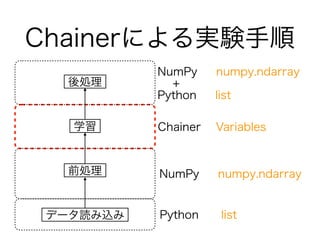

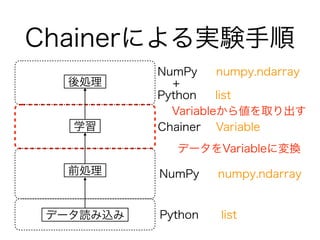

- 33. Chainerによる実験手順 Python list NumPy numpy.ndarray Chainer Variables NumPy numpy.ndarray + Python list データ読み込み 前処理 学習 後処理 Chainerによる実験手順

- 34. Chainerによる実験手順 Python list NumPy numpy.ndarray Chainer Variables NumPy numpy.ndarray + Python list データ読み込み 前処理 学習 後処理 Chainerによる実験手順

- 35. Chainerによる実験手順 Python list NumPy numpy.ndarray Chainer Variable NumPy numpy.ndarray + Python list データ読み込み 前処理 学習 後処理 Chainerによる実験手順 データをVariableに変換 Variableから値を取り出す

- 36. トレーニングデータ 入力データはリストで管理 Numpyを使うのでデータは行列をイメージ train = [[0, 0], [0, 1], [1, 0], [1,1]] label = [[0], [1], [1], [0]]

- 37. numpy.ndarrayへの変換 Chainerを使うためにnumpy.ndarrayに変換 ここでは、ランダムにデータを選ぶバッチ学習 Chainerではnp.?oat32を基本的に利用 #実装例 x = np.array(train, dtype=np.?oat32) y = np.array(label, dtype=np.?oat32) indexes = np.random.permutation(len(train)) for i in range(0, len(train), batchsize): x_batch = np.asarray(x[indexes[i:i+batchsize]]) y_batch = np.asarray(y[indexes[i:i+batchsize]])

- 38. Variableへの変換 numpy.ndarrayからVariableに変換 Chainerが用意した関数はVariableのみを受付 np.ndarrayをラッピングしているイメージ x = Variable(x_batch) t = Variable(y_batch)

- 40. 齿翱搁问题の実装

![トレーニングデータ

入力データはリストで管理

Numpyを使うのでデータは行列をイメージ

train = [[0, 0], [0, 1], [1, 0], [1,1]]

label = [[0], [1], [1], [0]]](https://image.slidesharecdn.com/nn2-151021043427-lva1-app6891/85/2-36-320.jpg)

![numpy.ndarrayへの変換

Chainerを使うためにnumpy.ndarrayに変換

ここでは、ランダムにデータを選ぶバッチ学習

Chainerではnp.?oat32を基本的に利用

#実装例

x = np.array(train, dtype=np.?oat32)

y = np.array(label, dtype=np.?oat32)

indexes = np.random.permutation(len(train))

for i in range(0, len(train), batchsize):

x_batch = np.asarray(x[indexes[i:i+batchsize]])

y_batch = np.asarray(y[indexes[i:i+batchsize]])](https://image.slidesharecdn.com/nn2-151021043427-lva1-app6891/85/2-37-320.jpg)