Ceph TÃỳrkiye 2.meetup ÄḞstanbul

- 1. Dr. HÃỳseyin ÃOTUK 11.10.2017 ÄḞstanbul Ceph TÃỳrkiye Meetup Ceph YapÄḟtaÅlarÄḟ, Ceph Mimarisi ve Ceph Ãzerinde Veri ġÛḟŵḞùḟôḟŵÅẅḟġẅẅḟ

- 2. GÃỳndem âḃ Ceph YapÄḟtaÅlarÄḟ âḃ Ceph Mimarisi âḃ Ceph Ãzerinde Veri ġÛḟŵḞùḟôḟŵÅẅḟġẅẅḟ â CRUSH AlgoritmasÄḟ â CRUSH MAP âḃ OpenStack Entegrasyonu âḃ Soru/Cevap

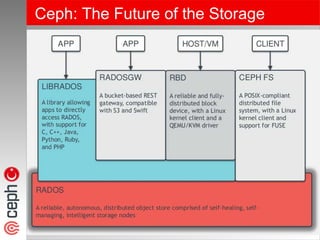

- 3. Ceph: The Future of the Storage

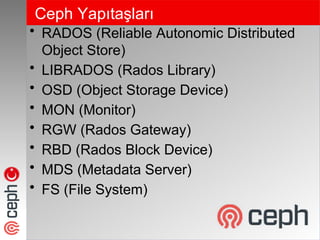

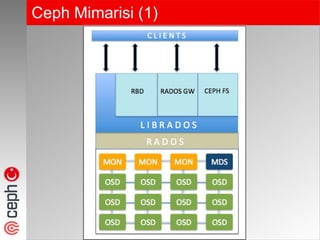

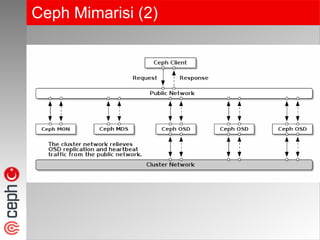

- 4. Ceph YapÄḟtaÅlarÄḟ âḃ RADOS (Reliable Autonomic Distributed Object Store) âḃ LIBRADOS (Rados Library) âḃ OSD (Object Storage Device) âḃ MON (Monitor) âḃ RGW (Rados Gateway) âḃ RBD (Rados Block Device) âḃ MDS (Metadata Server) âḃ FS (File System)

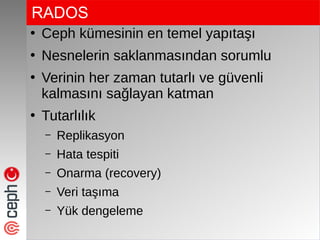

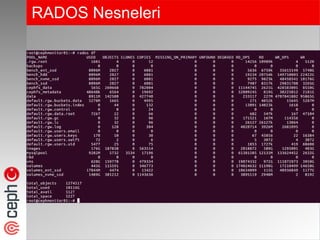

- 5. RADOS â Ceph kÃỳmesinin en temel yapÄḟtaÅÄḟ â Nesnelerin saklanmasÄḟndan sorumlu â Verinin her zaman tutarlÄḟ ve gÃỳvenli kalmasÄḟnÄḟ saÄlayan katman â TutarlÄḟlÄḟk â Replikasyon â Hata tespiti â Onarma (recovery) â Veri taÅÄḟma â YÃỳk dengeleme

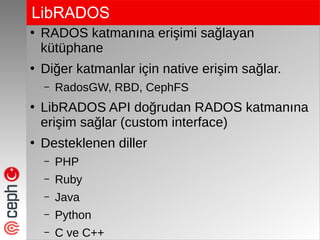

- 7. LibRADOS â RADOS katmanÄḟna eriÅimi saÄlayan kÃỳtÃỳphane â DiÄer katmanlar için native eriÅim saÄlar. â RadosGW, RBD, CephFS â LibRADOS API doÄrudan RADOS katmanÄḟna eriÅim saÄlar (custom interface) â Desteklenen diller â PHP â Ruby â Java â Python â C ve C++

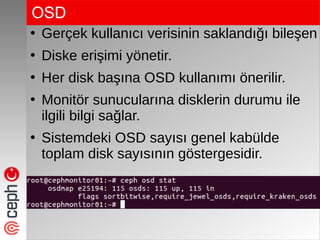

- 8. OSD â Gerçek kullanÄḟcÄḟ verisinin saklandÄḟÄÄḟ bileÅen â Diske eriÅimi yönetir. â Her disk baÅÄḟna OSD kullanÄḟmÄḟ önerilir. â Monitör sunucularÄḟna disklerin durumu ile ilgili bilgi saÄlar. â Sistemdeki OSD sayÄḟsÄḟ genel kabÃỳlde toplam disk sayÄḟsÄḟnÄḟn göstergesidir.

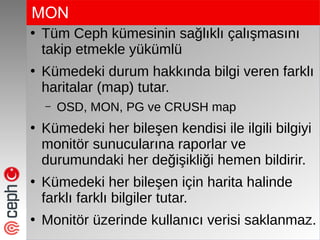

- 9. MON â TÃỳm Ceph kÃỳmesinin saÄlÄḟklÄḟ çalÄḟÅmasÄḟnÄḟ takip etmekle yÃỳkÃỳmlÃỳ â KÃỳmedeki durum hakkÄḟnda bilgi veren farklÄḟ haritalar (map) tutar. â OSD, MON, PG ve CRUSH map â KÃỳmedeki her bileÅen kendisi ile ilgili bilgiyi monitör sunucularÄḟna raporlar ve durumundaki her deÄiÅikliÄi hemen bildirir. â KÃỳmedeki her bileÅen için harita halinde farklÄḟ farklÄḟ bilgiler tutar. â Monitör Ãỳzerinde kullanÄḟcÄḟ verisi saklanmaz.

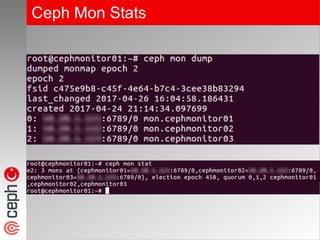

- 10. Ceph Mon Stats

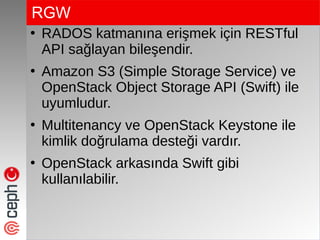

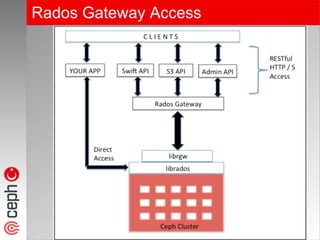

- 11. RGW â RADOS katmanÄḟna eriÅmek için RESTful API saÄlayan bileÅendir. â Amazon S3 (Simple Storage Service) ve OpenStack Object Storage API (Swift) ile uyumludur. â Multitenancy ve OpenStack Keystone ile kimlik doÄrulama desteÄi vardÄḟr. â OpenStack arkasÄḟnda Swift gibi kullanÄḟlabilir.

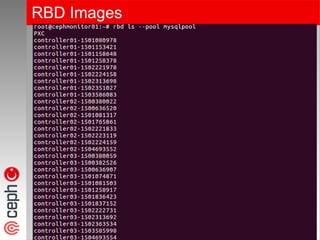

- 13. RBD â Fiziksel ve sanal sunucularda kullanÄḟlmak Ãỳzere blok aygÄḟt desteÄi saÄlayan bileÅendir. â Sunucudaki herhangi bir disk gibi map edilerek istenilen dosya sistemi ile formatlanÄḟp mount edilerek kullanÄḟlabilir. â Ticari ÃỳrÃỳnlerde bulunan thin provisioning ve snapshot gibi özellikleri destekler. â OpenStack, CloudStack, Proxmox desteÄi mevcuttur.

- 14. RBD Images

- 15. MDS â Dosya hiyerarÅisini izleyerek sadece CephFS için metadata bilgisini tutmakla yÃỳkÃỳmlÃỳdÃỳr. â Ceph RBD ve RadosGW metadata kullanÄḟmÄḟ gerektirmez. â FS kullanÄḟmÄḟna baÄlÄḟ opsiyonel olarak sisteme eklenir. â ÄḞstemciler ile etkileÅimi olmadÄḟÄÄḟ için diÄer daÄÄḟtÄḟk sistemlerdeki SPOF problemi, RBD ve Rados eriÅimi için ortadan kaldÄḟrÄḟlmÄḟÅtÄḟr.

- 16. FS â Her boyutta, POSIX-uyumlu daÄÄḟtÄḟk dosya sistemi desteÄi saÄlayan bileÅendir. â Dosya hiyerarÅisini takip edebilmek amacÄḟyla Ceph MDSâe ihtiyaç duyar. â Uzun sÃỳreli denemeler sonrasÄḟ 2016 ilk çeyreÄinde Jewel sÃỳrÃỳmÃỳ ile production ortamlarÄḟnda kullanÄḟma sunulmuÅtur. â Kernel mount veya FUSE â OpenStack Manila ile kullanÄḟldÄḟÄÄḟnda dosya sistemine birden fazla sanal sunucu Ãỳzerinden eÅ zamanlÄḟ eriÅim saÄlar.

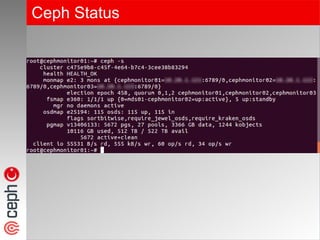

- 17. Ceph Status

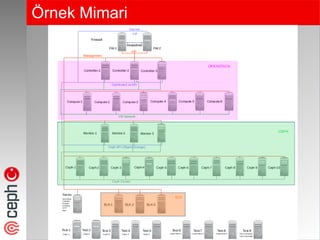

- 20. Ãrnek Mimari

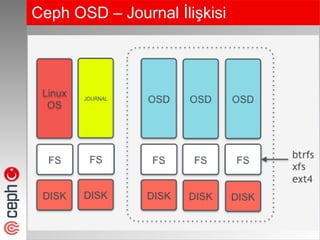

- 21. Ceph OSD â Journal ÄḞliÅkisi

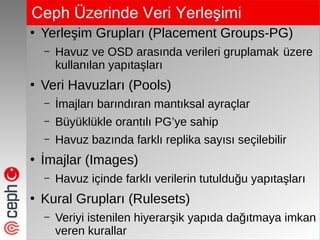

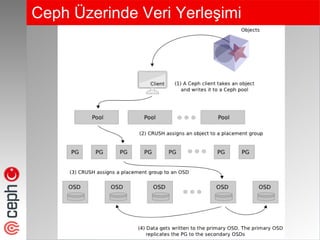

- 22. Ceph Ãzerinde Veri ġÛḟŵḞùḟôḟŵÅẅḟġẅẅḟ â YerleÅim GruplarÄḟ (Placement Groups-PG) â Havuz ve OSD arasÄḟnda verileri gruplamak Ãỳzere kullanÄḟlan yapÄḟtaÅlarÄḟ â Veri HavuzlarÄḟ (Pools) â ÄḞmajlarÄḟ barÄḟndÄḟran mantÄḟksal ayraçlar â BÃỳyÃỳklÃỳkle orantÄḟlÄḟ PGâye sahip â Havuz bazÄḟnda farklÄḟ replika sayÄḟsÄḟ seçilebilir â ÄḞmajlar (Images) â Havuz içinde farklÄḟ verilerin tutulduÄu yapÄḟtaÅlarÄḟ â Kural GruplarÄḟ (Rulesets) â Veriyi istenilen hiyerarÅik yapÄḟda daÄÄḟtmaya imkan veren kurallar

- 23. Ceph Ãzerinde Veri ġÛḟŵḞùḟôḟŵÅẅḟġẅẅḟ

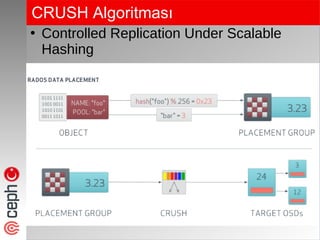

- 24. CRUSH AlgoritmasÄḟ â Controlled Replication Under Scalable Hashing

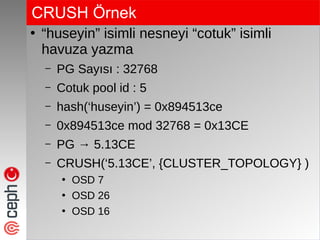

- 25. CRUSH Ãrnek â âhuseyinâ isimli nesneyi âcotukâ isimli havuza yazma â PG SayÄḟsÄḟ : 32768 â Cotuk pool id : 5 â hash(âhuseyinâ) = 0x894513ce â 0x894513ce mod 32768 = 0x13CE â PG â 5.13CE â CRUSH(â5.13CEâ, {CLUSTER_TOPOLOGY} ) â OSD 7 â OSD 26 â OSD 16

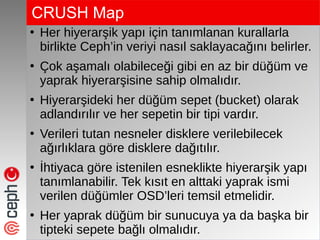

- 26. CRUSH Map â Her hiyerarÅik yapÄḟ için tanÄḟmlanan kurallarla birlikte Cephâin veriyi nasÄḟl saklayacaÄÄḟnÄḟ belirler. â Ãok aÅamalÄḟ olabileceÄi gibi en az bir dÃỳÄÃỳm ve yaprak hiyerarÅisine sahip olmalÄḟdÄḟr. â HiyerarÅideki her dÃỳÄÃỳm sepet (bucket) olarak adlandÄḟrÄḟlÄḟr ve her sepetin bir tipi vardÄḟr. â Verileri tutan nesneler disklere verilebilecek aÄÄḟrlÄḟklara göre disklere daÄÄḟtÄḟlÄḟr. â ÄḞhtiyaca göre istenilen esneklikte hiyerarÅik yapÄḟ tanÄḟmlanabilir. Tek kÄḟsÄḟt en alttaki yaprak ismi verilen dÃỳÄÃỳmler OSDâleri temsil etmelidir. â Her yaprak dÃỳÄÃỳm bir sunucuya ya da baÅka bir tipteki sepete baÄlÄḟ olmalÄḟdÄḟr.

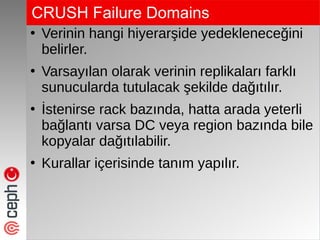

- 28. CRUSH Failure Domains â Verinin hangi hiyerarÅide yedekleneceÄini belirler. â VarsayÄḟlan olarak verinin replikalarÄḟ farklÄḟ sunucularda tutulacak Åekilde daÄÄḟtÄḟlÄḟr. â ÄḞstenirse rack bazÄḟnda, hatta arada yeterli baÄlantÄḟ varsa DC veya region bazÄḟnda bile kopyalar daÄÄḟtÄḟlabilir. â Kurallar içerisinde tanÄḟm yapÄḟlÄḟr.

- 29. Ceph Rules

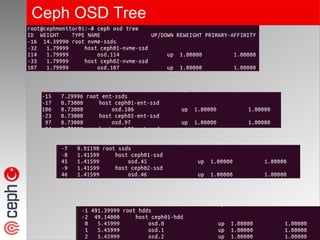

- 30. Ceph OSD Tree

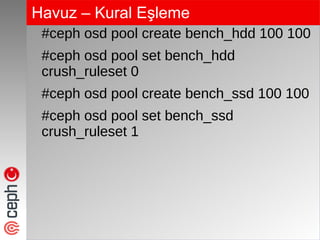

- 31. Havuz â Kural EÅleme #ceph osd pool create bench_hdd 100 100 #ceph osd pool set bench_hdd crush_ruleset 0 #ceph osd pool create bench_ssd 100 100 #ceph osd pool set bench_ssd crush_ruleset 1

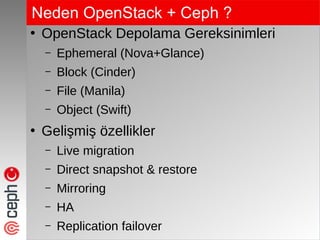

- 32. Neden OpenStack + Ceph ? â OpenStack Depolama Gereksinimleri â Ephemeral (Nova+Glance) â Block (Cinder) â File (Manila) â Object (Swift) â GeliÅmiŠözellikler â Live migration â Direct snapshot & restore â Mirroring â HA â Replication failover

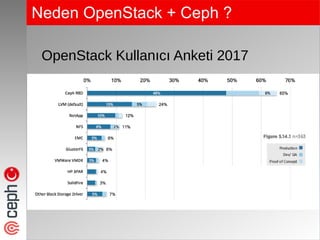

- 33. Neden OpenStack + Ceph ? OpenStack KullanÄḟcÄḟ Anketi 2017

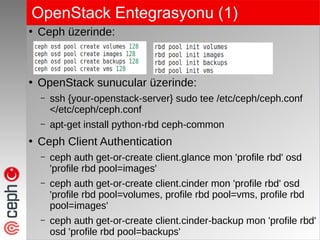

- 34. OpenStack Entegrasyonu (1) â Ceph Ãỳzerinde: â OpenStack sunucular Ãỳzerinde: â ssh {your-openstack-server} sudo tee /etc/ceph/ceph.conf </etc/ceph/ceph.conf â apt-get install python-rbd ceph-common â Ceph Client Authentication â ceph auth get-or-create client.glance mon 'profile rbd' osd 'profile rbd pool=images' â ceph auth get-or-create client.cinder mon 'profile rbd' osd 'profile rbd pool=volumes, profile rbd pool=vms, profile rbd pool=images' â ceph auth get-or-create client.cinder-backup mon 'profile rbd' osd 'profile rbd pool=backups'

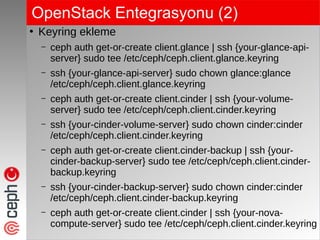

- 35. OpenStack Entegrasyonu (2) â Keyring ekleme â ceph auth get-or-create client.glance | ssh {your-glance-api- server} sudo tee /etc/ceph/ceph.client.glance.keyring â ssh {your-glance-api-server} sudo chown glance:glance /etc/ceph/ceph.client.glance.keyring â ceph auth get-or-create client.cinder | ssh {your-volume- server} sudo tee /etc/ceph/ceph.client.cinder.keyring â ssh {your-cinder-volume-server} sudo chown cinder:cinder /etc/ceph/ceph.client.cinder.keyring â ceph auth get-or-create client.cinder-backup | ssh {your- cinder-backup-server} sudo tee /etc/ceph/ceph.client.cinder- backup.keyring â ssh {your-cinder-backup-server} sudo chown cinder:cinder /etc/ceph/ceph.client.cinder-backup.keyring â ceph auth get-or-create client.cinder | ssh {your-nova- compute-server} sudo tee /etc/ceph/ceph.client.cinder.keyring

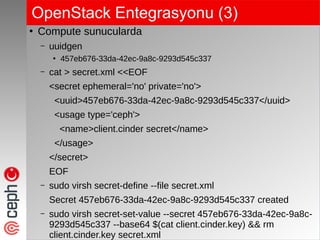

- 36. OpenStack Entegrasyonu (3) â Compute sunucularda â uuidgen â 457eb676-33da-42ec-9a8c-9293d545c337 â cat > secret.xml <<EOF <secret ephemeral='no' private='no'> <uuid>457eb676-33da-42ec-9a8c-9293d545c337</uuid> <usage type='ceph'> <name>client.cinder secret</name> </usage> </secret> EOF â sudo virsh secret-define --file secret.xml Secret 457eb676-33da-42ec-9a8c-9293d545c337 created â sudo virsh secret-set-value --secret 457eb676-33da-42ec-9a8c- 9293d545c337 --base64 $(cat client.cinder.key) && rm client.cinder.key secret.xml

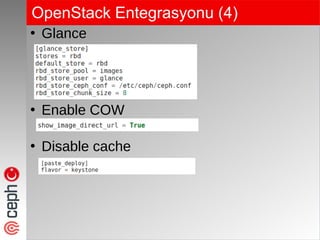

- 37. OpenStack Entegrasyonu (4) â Glance â Enable COW â Disable cache

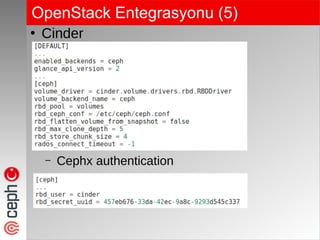

- 38. OpenStack Entegrasyonu (5) â Cinder â Cephx authentication

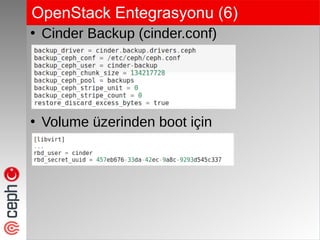

- 39. OpenStack Entegrasyonu (6) â Cinder Backup (cinder.conf) â Volume Ãỳzerinden boot için

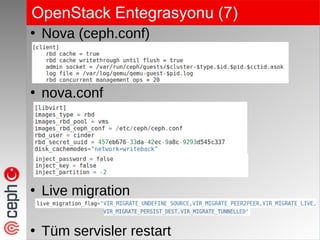

- 40. OpenStack Entegrasyonu (7) â Nova (ceph.conf) â nova.conf â Live migration â TÃỳm servisler restart

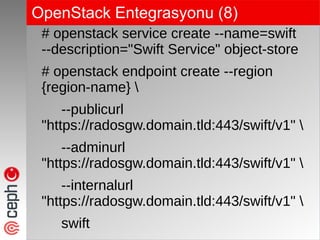

- 41. OpenStack Entegrasyonu (8) # openstack service create --name=swift --description="Swift Service" object-store # openstack endpoint create --region {region-name} --publicurl "https://radosgw.domain.tld:443/swift/v1" --adminurl "https://radosgw.domain.tld:443/swift/v1" --internalurl "https://radosgw.domain.tld:443/swift/v1" swift

- 42. OpenStack Entegrasyonu (9) â Keystone kimlik doÄrulama (ceph.conf) [client.radosgw.*] rgw_cache_enabled = true rgw_cache_lru_size = 100000 rgw_thread_pool_size = 256 rgw_enable_ops_log = false rgw_frontends = civetweb port=80 [client.rgw.cephmonitor01] rgw_frontends = "civetweb port=443s ssl_certificate=/etc/ssl/private/radosgw.domain.tld" #rgw dns name = radosgw.domain.tld rgw_keystone_url = http://controller:35357 rgw_keystone_admin_user = ceph rgw_keystone_admin_password = {openstack_ceph_user_password} rgw_keystone_admin_project = admin rgw_keystone_admin_domain = default rgw_keystone_api_version = 3 rgw_keystone_accepted_roles = admin, user rgw_s3_auth_use_keystone = true rgw_keystone_make_new_tenants = true

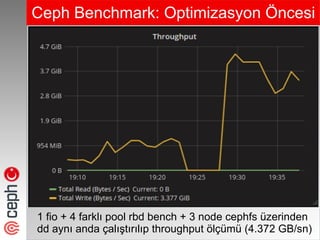

- 44. Ceph Benchmark: Optimizasyon Ãncesi 1 fio + 4 farklÄḟ pool rbd bench + 3 node cephfs Ãỳzerinden dd aynÄḟ anda çalÄḟÅtÄḟrÄḟlÄḟp throughput ölçÃỳmÃỳ (4.372 GB/sn)

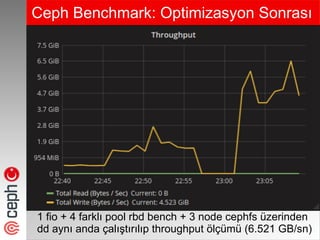

- 45. Ceph Benchmark: Optimizasyon SonrasÄḟ 1 fio + 4 farklÄḟ pool rbd bench + 3 node cephfs Ãỳzerinden dd aynÄḟ anda çalÄḟÅtÄḟrÄḟlÄḟp throughput ölçÃỳmÃỳ (6.521 GB/sn)

- 46. Ceph TÃỳrkiye 1. Meetup Ankara â Video kaydÄḟ ve sunum için: â http://huseyincotuk.com/index.php/2017/10/07/ ceph-turkiye-1-meetup-ankara-ilk-bakista-ceph/

- 47. Soru / Cevap â TeÅekkÃỳrler â Dr. HÃỳseyin ÃOTUK â http://www.huseyincotuk.com â huseyin@huseyincotuk.com â https://twitter.com/huseyin_cotuk â Sorular

![OpenStack Entegrasyonu (9)

â

Keystone kimlik doÄrulama (ceph.conf)

[client.radosgw.*]

rgw_cache_enabled = true

rgw_cache_lru_size = 100000

rgw_thread_pool_size = 256

rgw_enable_ops_log = false

rgw_frontends = civetweb port=80

[client.rgw.cephmonitor01]

rgw_frontends = "civetweb port=443s ssl_certificate=/etc/ssl/private/radosgw.domain.tld"

#rgw dns name = radosgw.domain.tld

rgw_keystone_url = http://controller:35357

rgw_keystone_admin_user = ceph

rgw_keystone_admin_password = {openstack_ceph_user_password}

rgw_keystone_admin_project = admin

rgw_keystone_admin_domain = default

rgw_keystone_api_version = 3

rgw_keystone_accepted_roles = admin, user

rgw_s3_auth_use_keystone = true

rgw_keystone_make_new_tenants = true](https://image.slidesharecdn.com/istanbul2-171015120620/85/Ceph-Turkiye-2-meetup-Istanbul-42-320.jpg)