深层自己符号化器+混合ガウスモデルによる教师なし异常検知

- 1. Bo Zong, Qi Song, Martin Renqiang Min, Wei Cheng, Cristian Lumezanu, Daeki Cho, Haifeng Chen. Deep Autoencoding Gaussian Mixture Model for Unsupervised Anomaly Detection. International Conference on Learning Representations, 2018. 2018年5月26日 三原 千尋 ICLR2018 論文紹介 深層自己符号化器+混合ガウスモデル による教師なし異常検知 出典 https://openreview.net /forum?id=BJJLHbb0 -

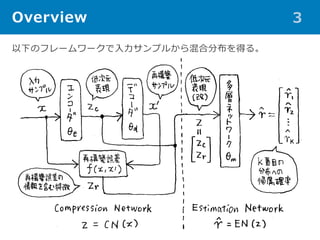

- 2. 概要 2 ? 多次元データから(教師なしに)異常検知するには次元削減してから 密度推定するのが常套手段(Cf. 次元の呪い)。 → この種の既存手法には以下の欠点が。 ‐ 次元削減と密度推定が別々に学習されるために局所最適解に陥る。 ‐ 次元削減と密度推定を同時に学習する手法もあるが、次元削減が 線形だったり密度推定のモデルが単純すぎたりで表現力が乏しい。 ‐ 次元削減における再構築誤差が考慮されていない(このサンプル はエンコードしづらい、というのはそれはそれで情報なはず)。 → そこで、 ‐ 深層自己符号化器によって次元削減し、 ‐ それに再構築エラーをconcatして「低次元の特徴」を得て、 ‐ 低次元空間でサンプルが混合ガウス分布のどの山に帰属するかを ニューラルネットで推定する(その割り当ての下で尤度最大のパ ラメータを混合ガウス分布のパラメータとして採用する)。深層 自己符号化器とこのニューラルネットの学習を同時に行う。 = Deep Autoencoding Gaussian Mixture Model: DAGMM

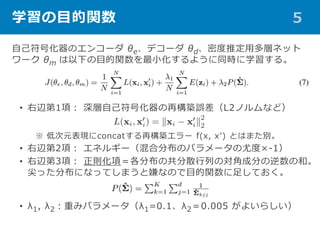

- 5. 学習の目的関数 5 自己符号化器のエンコーダ θe、デコーダ θd、密度推定用多層ネット ワーク θm は以下の目的関数を最小化するように同時に学習する。 ? 右辺第1項: 深層自己符号化器の再構築誤差(L2ノルムなど) ※ 低次元表現にconcatする再構築エラー f(x, x’) とはまた別。 ? 右辺第2項: エネルギー(混合分布のパラメータの尤度×-1) ? 右辺第3項: 正則化項=各分布の共分散行列の対角成分の逆数の和。 尖った分布になってしまうと嫌なので目的関数に足しておく。 ? λ1, λ2:重みパラメータ(λ1=0.1、λ2=0.005 がよいらしい)

- 6. 先行手法 6 多次元データに対する異常検知の先行手法は3タイプに分類される。 1. 「異常サンプルは低次元に圧縮しにくいだろう」という考えのもと、 次元削減を試行して再構築誤差をみるタイプ。 ? PCAに基づく手法 [Jolliffe1986] やDAEに基づく手法 [Zhai2016]。 ? 再構築誤差の一面からのみで異常を判定している点に限界? 2. (特徴空間に写像した後に)孤立サンプルや少数クラスタを異常と 判定するタイプ。 ? 次元削減と密度推定が分離している点に限界? 3. (特徴空間に写像した後に)一定割合の外れ値を除いた正常データ を囲む境界面を求めるタイプ(=One Class SVM [Chen2001] )。 また、必ずしも異常検知用途ではないが、次元削減と密度推定を結合 して学習させる方法の研究もなされてきた。 ? 線形な次元削減とGMM [Yang2014] や、如何に事前学習するかの研究など。 → 今回の提案手法 DAGMM の異常検知性能をこれらの手法と比較する。

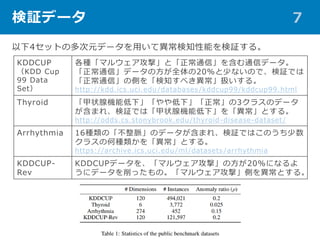

- 7. 検証データ 7 KDDCUP (KDD Cup 99 Data Set) 各種「マルウェア攻撃」と「正常通信」を含む通信データ。 「正常通信」データの方が全体の20%と少ないので、検証では 「正常通信」の側を「検知すべき異常」扱いする。 http://kdd.ics.uci.edu/databases/kddcup99/kddcup99.html Thyroid 「甲状腺機能低下」「やや低下」「正常」の3クラスのデータ が含まれ、検証では「甲状腺機能低下」を「異常」とする。 http://odds.cs.stonybrook.edu/thyroid-disease-dataset/ Arrhythmia 16種類の「不整脈」のデータが含まれ、検証ではこのうち少数 クラスの何種類かを「異常」とする。 https://archive.ics.uci.edu/ml/datasets/arrhythmia KDDCUP- Rev KDDCUPデータを、「マルウェア攻撃」の方が20%になるよ うにデータを削ったもの。「マルウェア攻撃」側を異常とする。 以下4セットの多次元データを用いて異常検知性能を検証する。

- 8. 比較対象手法 8 以下の state-of-the-art な4モデルと比較する。 OC-SVM One Class SVM によるアプローチ [Chen2001]。 DSEBM-e Deep Structured Energy Based Model によるアプローチ [Zhai2016]。-e はエネルギーで、-r は再構築エラーで異常検知。 DSEBM-r DCN Deep Clustering Network [Yang2017]。(深層ではない)自 己符号化器の学習を後段の k-means で制御。 GMM-EN 学習時のみ低次元の特徴から「再構築エラー」部分を除去。 PAE 深層自己符号化器のみ(再構築エラーで異常検知)。事前学習有。 E2E-AE 深層自己符号化器のみ(再構築エラーで異常検知)。事前学習無。 PAE-GMM- EM 事前学習済みの深層自己符号化器を先に学習してから、EMアルゴ リズムによってGMMのパラメータを推定。 PAE-GMM 1つ上と同様だが、GMM のパラメータはネットワークで推定。 DAGMM-p まず Compression Net を学習、次にモデル全体を学習。 DAGMM-NVI エネルギー関数を Neural Variational Inference で置き換え。 加えて、DAGMM の各要素の検証のため、variant な7モデルとも比較する。

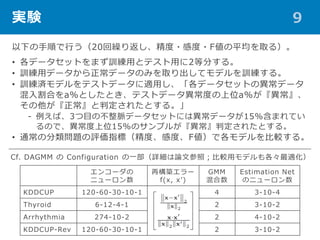

- 9. 実験 9 以下の手順で行う(20回繰り返し、精度?感度?F値の平均を取る)。 ? 各データセットをまず訓練用とテスト用に2等分する。 ? 訓練用データから正常データのみを取り出してモデルを訓練する。 ? 訓練済モデルをテストデータに適用し、「各データセットの異常データ 混入割合をa%としたとき、テストデータ異常度の上位a%が『異常』、 その他が『正常』と判定されたとする。」 ‐ 例えば、3つ目の不整脈データセットには異常データが15%含まれてい るので、異常度上位15%のサンプルが『異常』判定されたとする。 ? 通常の分類問題の評価指標(精度、感度、F値)で各モデルを比較する。 エンコーダの ニューロン数 再構築エラー f(x, x’) GMM 混合数 Estimation Net のニューロン数 KDDCUP 120-60-30-10-1 4 3-10-4 Thyroid 6-12-4-1 2 3-10-2 Arrhythmia 274-10-2 2 4-10-2 KDDCUP-Rev 120-60-30-10-1 2 3-10-2 Cf. DAGMM の Configuration の一部(詳細は論文参照;比較用モデルも各々最適化)

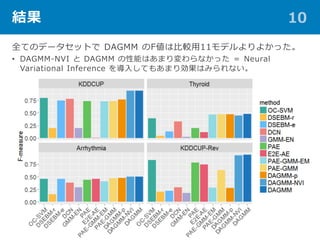

- 10. 結果 10 全てのデータセットで DAGMM のF値は比較用11モデルよりよかった。 ? DAGMM-NVI と DAGMM の性能はあまり変わらなかった = Neural Variational Inference を導入してもあまり効果はみられない。

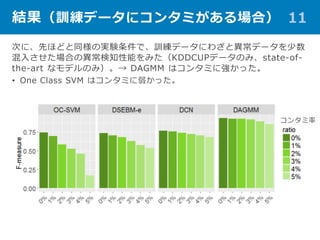

- 11. 結果(訓練データにコンタミがある場合) 11 次に、先ほどと同様の実験条件で、訓練データにわざと異常データを少数 混入させた場合の異常検知性能をみた(KDDCUPデータのみ、state-of- the-art なモデルのみ)。→ DAGMM はコンタミに強かった。 ? One Class SVM はコンタミに弱かった。 コンタミ率

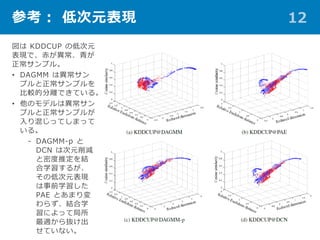

- 12. 参考: 低次元表現 12 図は KDDCUP の低次元 表現で、赤が異常、青が 正常サンプル。 ? DAGMM は異常サン プルと正常サンプルを 比較的分離できている。 ? 他のモデルは異常サン プルと正常サンプルが 入り混じってしまって いる。 ‐ DAGMM-p と DCN は次元削減 と密度推定を結 合学習するが、 その低次元表現 は事前学習した PAE とあまり変 わらず、結合学 習によって局所 最適から抜け出 せていない。

- 13. 結論 13 ? 多次元データから(教師なしに)異常検知するモデルとして、Deep Autoencoding Gaussian Mixture Model: DAGMM を考案した。 ‐ 深層自己符号化器によって次元削減し、 ‐ それに再構築エラーをconcatして「低次元の特徴」を得て、 ‐ 低次元空間でサンプルが混合ガウス分布のどの山に帰属するかを ニューラルネットで推定する(その割り当ての下で尤度最大のパ ラメータを混合ガウス分布のパラメータとして採用する)。深層 自己符号化器とこのニューラルネットの学習を同時に行う。 ? 学習では正則化項付きの目的関数を最小化する。 ベンチマークデータで、先行手法よりよい異常検知性能を得た。

![先行手法 6

多次元データに対する異常検知の先行手法は3タイプに分類される。

1. 「異常サンプルは低次元に圧縮しにくいだろう」という考えのもと、

次元削減を試行して再構築誤差をみるタイプ。

? PCAに基づく手法 [Jolliffe1986] やDAEに基づく手法 [Zhai2016]。

? 再構築誤差の一面からのみで異常を判定している点に限界?

2. (特徴空間に写像した後に)孤立サンプルや少数クラスタを異常と

判定するタイプ。

? 次元削減と密度推定が分離している点に限界?

3. (特徴空間に写像した後に)一定割合の外れ値を除いた正常データ

を囲む境界面を求めるタイプ(=One Class SVM [Chen2001] )。

また、必ずしも異常検知用途ではないが、次元削減と密度推定を結合

して学習させる方法の研究もなされてきた。

? 線形な次元削減とGMM [Yang2014] や、如何に事前学習するかの研究など。

→ 今回の提案手法 DAGMM の異常検知性能をこれらの手法と比較する。](https://image.slidesharecdn.com/dagmm-180526024453/85/-6-320.jpg)

![比較対象手法 8

以下の state-of-the-art な4モデルと比較する。

OC-SVM One Class SVM によるアプローチ [Chen2001]。

DSEBM-e Deep Structured Energy Based Model によるアプローチ

[Zhai2016]。-e はエネルギーで、-r は再構築エラーで異常検知。

DSEBM-r

DCN Deep Clustering Network [Yang2017]。(深層ではない)自

己符号化器の学習を後段の k-means で制御。

GMM-EN 学習時のみ低次元の特徴から「再構築エラー」部分を除去。

PAE 深層自己符号化器のみ(再構築エラーで異常検知)。事前学習有。

E2E-AE 深層自己符号化器のみ(再構築エラーで異常検知)。事前学習無。

PAE-GMM-

EM

事前学習済みの深層自己符号化器を先に学習してから、EMアルゴ

リズムによってGMMのパラメータを推定。

PAE-GMM 1つ上と同様だが、GMM のパラメータはネットワークで推定。

DAGMM-p まず Compression Net を学習、次にモデル全体を学習。

DAGMM-NVI エネルギー関数を Neural Variational Inference で置き換え。

加えて、DAGMM の各要素の検証のため、variant な7モデルとも比較する。](https://image.slidesharecdn.com/dagmm-180526024453/85/-8-320.jpg)