м—¬лҹ¬ м»ЁліјлЈЁм…ҳ л Ҳмқҙм–ҙ н…ҢнҒ¬лӢүкіј кІҪлҹүнҷ” кё°лІ•л“Ө

- 1. Dongyi Kim Ajou University Dept. of Computer Engineering waps12b@ajou.ac.kr Survey on Convolution Layers лӢӨм–‘н•ң нҳ•нғңмқҳ м»ЁліјлЈЁм…ҳ л Ҳмқҙм–ҙмҷҖ кІҪлҹүнҷ” кё°лІ•

- 2. Convolution (2D) Layer мҳҒмғҒм—җ лҢҖн•ң вҖң2D Spatial FeatureвҖқлҘј 추м¶ңн•ҳлҠ” н•„н„°л“ӨлЎң кө¬м„ұлҗҳм–ҙ мһҲлӢӨ. вҖў x, y л°©н–ҘмңјлЎң мқём ‘н•ң н”Ҫм…Җл“Өм—җ лҢҖн•ң н•„н„°лҘј н•ҷмҠөн•ңлӢӨ. вҖў к°ҷмқҖ мң„м№ҳм—җ н•ҙлӢ№н•ҳлҠ” лӘЁл“ мұ„л„җм—җ лҢҖн•ҙ к°ҖмӨ‘м№ҳлҘј к°Җ진лӢӨ. н•ҳлӮҳмқҳ м»Өл„җмқҖ мһ…л Ҙ мҳҒмғҒмқҳ к°Ғ мң„м№ҳ лі„ л°ҳмқ‘м№ҳлҘј кі„мӮ°н•ҳм—¬ 2D Response Mapмқ„ м¶ңл Ҙн•ңлӢӨ. вҖў к°Ғ мң„м№ҳлі„лЎң лӘЁл“ мұ„л„җмқҳ н”Ҫм…Җл“Өм—җ лҢҖн•ң Linear Combinationмқ„ мҲҳн–үн•ңлӢӨ. Various types of Convolution layers P.2

- 3. Memory & Time Cost м—°мӮ°лҹүмқҖ рқ‘Җрқ‘Ӣрқ‘Ңрқҗҫ2 рқ‘Ғк°Җ лҗҳкі нҢҢлқјлҜён„°мқҳ мҲҳлҠ” N(рқ‘Җрқҗҫ2 + 1)к°ңк°Җ лҗңлӢӨ. вҖў MлҠ” мһ…л Ҙ мұ„л„җ мҲҳ, (X, Y)лҠ” мһ…л Ҙ мҳҒмғҒмқҳ нҒ¬кё°, (K, K)лҠ” н•„н„° м»Өл„җмқҳ нҒ¬кё°, NмқҖ н•„н„°мқҳ мҲҳ(м¶ңл Ҙ мұ„л„җ) мҳҒмғҒмқҳ нҒ¬кё° лҝҗл§Ң м•„лӢҲлқј л§ҺмқҖ мҡ”мҶҢл“Өм—җ мқҳн•ҙ м—°мӮ°лҹүкіј нҢҢлқјлҜён„° мҲҳк°Җ мҰқк°Җн•ңлӢӨ. вҖў мһ…л Ҙ мұ„л„җмқҳ мҲҳ вҖў н•„н„°мқҳ мҲҳ вҖў м»Өл„җмқҳ нҒ¬кё° Various types of Convolution layers P.3

- 4. Problem #1 вҖ“ Expensive Cost л„ӨнҠёмӣҢнҒ¬лҠ” м җм җ к№Ҡм–ҙм§Җкі , мұ„л„җмқҳ мҲҳлҠ” мҰқк°Җн•ңлӢӨ. пғі м—°мӮ°лҹүлҸ„ к°ҖмӨ‘м№ҳлҸ„ 비лЎҖн•ҙм„ң мҰқк°Җн•ңлӢӨ. Various types of Convolution layers P.4https://towardsdatascience.com/neural-network-architectures-156e5bad51ba

- 5. Problem #1 вҖ“ Expensive Cost мқјл°ҳм ҒмңјлЎң нҒ° Feature Mapмқ„ м»ЁліјлЈЁм…ҳмқҳ мһ…л ҘмңјлЎң к°Җм§ҖлҠ” кІғмқҙ мң лҰ¬н•ҳм§Җл§Ң, лҢҖл¶Җ분мқҳ CNNм—җм„ңлҠ” мҪ”мҠӨнҠёлҘј кі л Өн•ҙ Sub-samplingмқ„ мҲҳн–үн•ңлӢӨ. Various types of Convolution layers P.5 https://saitoxu.io/2017/01/01/convolution-and-pooling.html

- 6. Problem #1 вҖ“ Expensive Cost мұ„л„җмқҳ мҲҳлҘј лҠҳлҰҙмҲҳлЎқ лҚ” л§ҺмқҖ FilterлҘј н•ҷмҠөн• мҲҳ мһҲлӢӨ. н•ҳм§Җл§Ң л„Ҳл¬ҙ л§ҺмқҖ мұ„л„җмқҖ мҳӨнһҲл Ө 비мҡ©мқ„ мҰқк°ҖмӢңнӮЁлӢӨ вҖў нҢҢлқјлҜён„°мқҳ мҲҳ мҰқк°Җ вҖў н•ҷмҠө мҶҚлҸ„ н•ҳлқҪ вҖў Overfitting вҖў вҖҰ Various types of Convolution layers P.6 https://saitoxu.io/2017/01/01/convolution-and-pooling.html

- 7. Problem #2 вҖ“ Dead Channels мӢ кІҪл§қмқҳ н•ҷмҠө кіјм •м—җм„ң, м¶ңл Ҙ кІ°кіјм—җ мҳҒн–Ҙмқ„ кұ°мқҳ мЈјм§Җ м•ҠлҠ” к°„м„ (нҳ№мқҖ м •м җ)мқҙ лӮҳнғҖлӮңлӢӨ. вҖў мқјл°ҳм ҒмңјлЎң Pruningмқ„ нҶөн•ҙ мӢ кІҪл§қмқҳ м—°мӮ°лҹүкіј нҢҢлқјлҜён„° мҲҳлҘј кІҪлҹүнҷ” н• мҲҳ мһҲлӢӨ. вҖў Edge Pruningмқҙ Neuron Pruningм—җ 비н•ҙ мғҒлҢҖм ҒмңјлЎң к°„лӢЁн•ҳлӢӨ. Various types of Convolution layers P.7

- 8. Problem #2 вҖ“ Dead Channels л§Ҳм°¬к°Җм§ҖлЎң, мқҙлҹ° л¬ём ңл“Өмқҙ мұ„л„җ лӢЁмң„м—җм„ң л°ңмғқн• мҲҳ лҸ„ мһҲлӢӨ. вҖў мўҒкІҢлҠ” н•ҳлӮҳмқҳ н•„н„°м—җм„ң, л„“кІҢлҠ” м „мІҙ мӢ кІҪл§қм—җм„ң л¶Ҳн•„мҡ”н•ң мұ„л„җмқҙ л°ңмғқн• мҲҳ мһҲлӢӨ. вҖў мқјмў…мқҳ Neuron PruningмңјлЎң ліј мҲҳ мһҲмңјл©°, м ңкұ° м—¬л¶ҖлҘј нҢҗлӢЁн•ҳкё°лҸ„ м–ҙл өлӢӨ. мұ„л„җмқҳ мҲҳлҠ” кі§ нҢҢлқјлҜён„° мҲҳмҷҖ м—°мӮ°лҹүм—җ м§ҒкІ°лҗҳкё° л•Ңл¬ём—җ, мғҒлӢ№н•ң мһҗмӣҗ лӮӯ비к°Җ лҗ мҲҳ мһҲлӢӨ. вҖў лӢ№м—°нһҲ мұ„л„җмқҳ мҲҳлҠ” Hyper Parameterмқҙкё° л•Ңл¬ём—җ мөңм Ғмқҳ мҲҳлҘј м°ҫлҠ” кІғлҸ„ н•ңкі„к°Җ мһҲлӢӨ. Various types of Convolution layers P.8 л¶Ҳн•„мҡ”н•ң мұ„л„җмқјм§ҖлқјлҸ„ к°ҖмӨ‘м№ҳлҘј к°Җм§Җкі , кі„мӮ° мӢңк°„мқ„ мҶҢмҡ”н•ңлӢӨ

- 9. Problem #3 вҖ“ Low Correlation between channels к°Ғ н•„н„°лҠ” мһ…л Ҙ мҳҒмғҒмқҳ лӘЁл“ мұ„л„җмқ„ мӮ¬мҡ©н•ҳм§Җл§Ң, лӘЁл“ мұ„л„җ-н•„н„° мҢҚмқҙ лҶ’мқҖ Correlationмқ„ к°Җм§Ҳ мҲҳ л§ҢмқҖ м—ҶлӢӨ. Various types of Convolution layers P.9

- 10. Problem #3 вҖ“ Low Correlation between channels кІ°кіјм ҒмңјлЎң Sparseн•ң Correlation MatrixлҘј ліҙмқј мҲҳ мһҲлӢӨ. мқҙлЎң мқён•ҙ лӢӨмқҢкіј к°ҷмқҖ л¬ём ңм җмқҙ мғқкёҙлӢӨ вҖў н•ҷмҠө мҲҳл ҙ мҶҚлҸ„ м Җн•ҳ вҖў мқјмў…мқҳ NoiseмІҳлҹј мһ‘мҡ© вҖў л¶Ҳн•„мҡ”н•ң к°ҖмӨ‘м№ҳмҷҖ м—°мӮ°мқҳ мЎҙмһ¬ Various types of Convolution layers P.10 https://blog.yani.io/filter-group-tutorial/https://blog.yani.io/filter-group-tutorial/

- 11. Abstract мҡ”м•Ҫн•ҳмһҗл©ҙ, Convolution Layerм—җлҠ” нҒ¬кІҢ лӢӨмқҢкіј к°ҷмқҖ м„ё к°Җм§Җ л¬ём ңм җмқҙ мЎҙмһ¬н•ңлӢӨ. вҖў Expensive Cost вҖў Dead Channels вҖў Low Correlation between channels ліё л°ңн‘ңм—җм„ңлҠ” мқҙлҹ° л¬ём ңм җл“Өмқ„ н•ҙкІ°н•ҳкё° мң„н•ң лӢӨм–‘н•ң кҙҖм җмқҳ м ‘к·ј л°©лІ•л“Өкіј кҙҖл Ё л…јл¬ёл“Өмқҳ м•„мқҙл””м–ҙм—җ лҢҖн•ҙм„ң м•Ңм•„ліёлӢӨ. 1. Dilated Convolution 2. Point-wise Convolution 3. Grouped Convolution 4. Depth-wise (Separable) Convolution Various types of Convolution layers P.11

- 12. Various types of Convolution layers P.12 Dilated Convolution

- 13. Contextual Information & Receptive Fields мҳҒмғҒ лӮҙмқҳ Objectsм—җ лҢҖн•ң м •нҷ•н•ң нҢҗлӢЁмқ„ мң„н•ҙм„ңлҠ” Contextual Informationмқҙ мӨ‘мҡ”н•ҳлӢӨ вҖў к°қмІҙ мЈјліҖмқҳ л°°кІҪмқҖ м–ҙл–Ө нҷҳкІҪмқёк°Җ? вҖў к°қмІҙ мЈјліҖмқҳ лӢӨлҘё к°қмІҙл“ӨмқҖ м–ҙл–Ө мў…лҘҳмқёк°Җ? 충분н•ң Contextual Informationмқ„ нҷ•ліҙн•ҳкё° мң„н•ҙм„ң, мғҒлҢҖм ҒмңјлЎң л„“мқҖ Receptive FieldлҘј кі л Өн• н•„мҡ”к°Җ мһҲлӢӨ. Various types of Convolution layers P.13

- 14. Contextual Information & Receptive Fields мқјл°ҳм ҒмңјлЎң CNNм—җм„ң Receptive FieldлҘј нҷ•мһҘн•ҳкё° мң„н•ҙм„ңлҠ” лӢӨмқҢмқ„ кі л Өн•ҙліј мҲҳ мһҲлӢӨ. вҖў м»Өл„җ нҒ¬кё°мқҳ нҷ•мһҘ вҖў лҚ” л§ҺмқҖ м»ЁліјлЈЁм…ҳ л Ҳмқҙм–ҙмқҳ м Ғмёө н•ҳм§Җл§Ң л‘җ л°©лІ• лӘЁл‘җ м—°мӮ°лҹүмқ„ нҒ¬кІҢ мҰқк°ҖмӢңнӮЁлӢӨ. Various types of Convolution layers P.14 https://blog.yani.io/filter-group-tutorial/ https://medium.com/@TalPerry/convolutional-methods-for-text-d5260fd5675f

- 15. Dilated Convolution Dilated Convolution[1]мқҖ Convolution filterмқҳ мҲҳмҡ© н”Ҫм…ҖмӮ¬мқҙм—җ к°„кІ©мқ„ л‘” нҳ•нғң мһ…л Ҙ н”Ҫм…Җмқҳ мҲҳлҠ” лҸҷмқјн•ҳм§Җл§Ң, лҚ” л„“мқҖ лІ”мң„м—җ лҢҖн•ң мһ…л Ҙмқ„ мҲҳмҡ©н• мҲҳ мһҲкІҢ лҗңлӢӨ. Various types of Convolution layers P.15 https://mlblr.com/includes/mlai/index.html

- 16. Dilated Convolution мӢӨм ң Receptive Field мғҒмқҳ лӘЁл“ м •ліҙлҘј мһ…л Ҙ л°ӣм§Җ лҠ” м•ҠлҠ”лӢӨ. н•ҳм§Җл§Ң, к°ҷмқҖ мҲҳмқҳ нҢҢлқјлҜён„°лҘј нҶөн•ҙ мғҒлҢҖм ҒмңјлЎң л„“мқҖ мҳҒм—ӯмқҳ м •ліҙл“Өмқ„ мҲҳмҡ©н• мҲҳ мһҲлӢӨ. вҖў Segmentation, Object Detectionкіј к°ҷмқҙ мғҒлҢҖм ҒмңјлЎң Contextual Informationмқҙ мӨ‘мҡ”н•ң 분야м—җ м Ғмҡ©н•ҳкё° мң лҰ¬н•ҳлӢӨ. вҖў к°„кІ©мқ„ мЎ°м Ҳн•ҳм—¬ лӢӨм–‘н•ң Scaleм—җ лҢҖн•ң лҢҖмқ‘мқҙ к°ҖлҠҘн•ҳлӢӨ. Various types of Convolution layers P.16

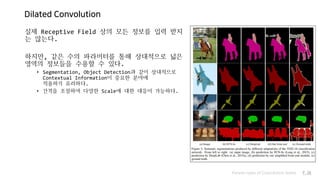

- 17. Various types of Convolution layers P.17 Point-wise Convolution Convolution Layer with a 1x1 kernels

- 18. Point-wise Convolution (1 by 1 Convolution) Point-wise ConvolutionмқҖ м»Өл„җ нҒ¬кё°к°Җ 1x1лЎң кі м •лҗң Convolution LayerлҘј л§җн•ңлӢӨ. м—°мӮ°лҹүмқҖ рқ‘Җрқ‘Ӣрқ‘Ңрқ‘Ғк°Җ лҗҳкі нҢҢлқјлҜён„°мқҳ мҲҳлҠ” N(рқ‘Җ + 1)к°ңк°Җ лҗңлӢӨ. вҖў MлҠ” мһ…л Ҙ мұ„л„җ мҲҳ, (X, Y)лҠ” мһ…л Ҙ мҳҒмғҒмқҳ нҒ¬кё°, (K, K)лҠ” н•„н„° м»Өл„җмқҳ нҒ¬кё°, NмқҖ н•„н„°мқҳ мҲҳ(м¶ңл Ҙ мұ„л„җ) мһ…л Ҙ мҳҒмғҒм—җ лҢҖн•ң Spatial FeatureлҠ” 추м¶ңн•ҳм§Җ м•ҠмқҖ мғҒнғңлЎң, к°Ғ мұ„л„җл“Өм—җ лҢҖн•ң м—°мӮ°л§Ңмқ„ мҲҳн–үн•ңлӢӨ. вҖў м¶ңл Ҙ мҳҒмғҒмқҳ нҒ¬кё°лҠ” ліҖн•ҳм§Җ м•Ҡмңјл©°, мұ„л„җмқҳ мҲҳлҘј мһҗмң лЎӯкІҢ мЎ°м •н• мҲҳ мһҲлӢӨ. Various types of Convolution layers P.18

- 19. Point-wise Convolution (1 by 1 Convolution) кІ°көӯ н•ҳлӮҳмқҳ н•„н„°лҠ” мұ„л„җ лі„лЎң CoefficientлҘј к°Җм§ҖлҠ” Linear Combinationмқ„ н‘ңнҳ„н•ңлӢӨ. вҖў н•„н„°мқҳ мұ„л„җ лі„ нҢҢлқјлҜён„°(1x1)к°Җ лӘЁл“ мң„м№ҳм—җ лҸҷмқјн•ҳкІҢ м Ғмҡ©лҗҳлҜҖлЎң мұ„л„җм—җ лҢҖн•ң Scalar CoefficientмІҳлҹј мғқк°Ғн• мҲҳ мһҲлӢӨ. мҰү, мұ„л„җ лӢЁмң„мқҳ Linear Combinationмқ„ нҶөн•ң мұ„л„җ мҲҳмқҳ ліҖнҷ”к°Җ к°ҖлҠҘн•ҳлӢӨ. Various types of Convolution layers P.19

- 20. Point-wise Convolution мқјл°ҳм ҒмңјлЎң Point-wise Convolutionмқҳ кІҪмҡ° м¶ңл Ҙ мҳҒмғҒмқҳ мұ„л„җ мҲҳлҘј мӨ„м—¬ мӮ¬мҡ©н•ңлӢӨ. мқҙлҘј мқјмў…мқҳ Dimensionality ReductionмңјлЎң мқҙн•ҙн• мҲҳ мһҲлӢӨ. мҰү, лӢӨмұ„л„җ мһ…л Ҙ мҳҒмғҒмқ„ лҚ” м ҒмқҖ мұ„л„җмқҳ мҳҒмғҒ(Low dimension)мңјлЎңмқҳ Embeddingн•ҳлҠ” н•ҳлҠ” кІғмңјлЎң мқҙн•ҙн• мҲҳ мһҲлӢӨ. вҖў м¶ңл Ҙ мұ„л„җ мҲҳлҘј мӨ„мһ„мңјлЎңмҚЁ, лӢӨмқҢ л Ҳмқҙм–ҙмқҳ кі„мӮ° мҪ”мҠӨнҠёмҷҖ нҢҢлқјлҜён„° мҲҳлҘј мӨ„мқј мҲҳ мһҲлӢӨ. Various types of Convolution layers P.20

- 21. Point-wise Convolution (1 by 1 Convolution) мұ„л„җм—җ лҢҖн•ң Linear Combinationмқ„ мҲҳн–үн• мӢң, л¶Ҳн•„мҡ”н•ң мұ„л„җл“Өмқҙ лӮ®мқҖ CoefficientлҘј к°Җм§Җл©° м—°мӮ° кІ°кіјм—җм„ң нқ¬м„қлҗ мҲҳ мһҲлӢӨ. Various types of Convolution layers P.21

- 22. Point-wise Convolution - Experiments Various types of Convolution layers P.22 Squeeze Net[2] м—¬лҹ¬ кө¬мЎ°м—җм„ң м Ғмҡ©лҗҳм–ҙ кІҪлҹүнҷ”мҷҖ м„ұлҠҘ к°ңм„ мқҙ к°ҖлҠҘн•Ёмқҙ мӢӨн—ҳм ҒмңјлЎң мҰқлӘ…лҗҳм—ҲлӢӨ. вҖў Inception вҖў Xception вҖў Squeeze-Net вҖў Mobile-Net вҖў вҖҰ Inception Network [3]

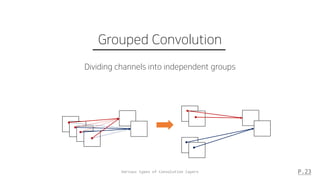

- 23. Various types of Convolution layers P.23 Grouped Convolution Dividing channels into independent groups

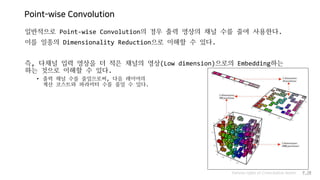

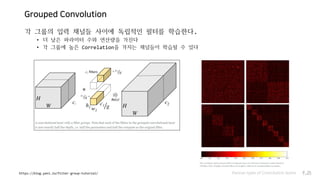

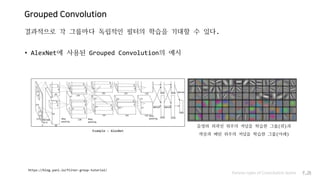

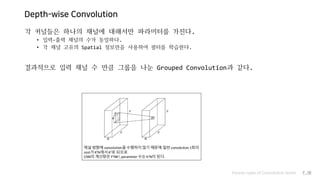

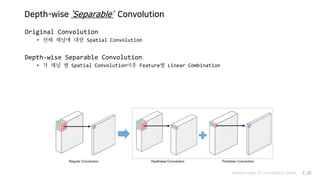

- 24. Grouped Convolution мһ…л Ҙ мҳҒмғҒмқҳ мұ„л„җл“Өмқ„ м—¬лҹ¬ к°ңмқҳ к·ёлЈ№мңјлЎң лӮҳлҲ„м–ҙ лҸ…лҰҪм Ғмқё м»ЁліјлЈЁм…ҳмқ„ мҲҳн–үн•ҳлҠ” л°©мӢқ вҖў м•„мқҙл””м–ҙмҷҖ кө¬нҳ„ л°©лІ•мқҙ к°„лӢЁн•ҳлӢӨ вҖў лі‘л ¬мІҳлҰ¬м—җ мң лҰ¬н•ҳлӢӨ Various types of Convolution layers P.24 def grouped_convolution(input, n_groups): input_groups = tf.split(input, n_groups, axis = -1) output_groups = [ tf.layers.conv2d(input_groups[i], """ some params """) for i in range(n_groups) ] output = tf.concat(output_groups, axis = -1) return output

- 25. Grouped Convolution к°Ғ к·ёлЈ№мқҳ мһ…л Ҙ мұ„л„җл“Ө мӮ¬мқҙм—җ лҸ…лҰҪм Ғмқё н•„н„°лҘј н•ҷмҠөн•ңлӢӨ. вҖў лҚ” лӮ®мқҖ нҢҢлқјлҜён„° мҲҳмҷҖ м—°мӮ°лҹүмқ„ к°Җ진лӢӨ вҖў к°Ғ к·ёлЈ№м—җ лҶ’мқҖ Correlationмқ„ к°Җм§ҖлҠ” мұ„л„җл“Өмқҙ н•ҷмҠөлҗ мҲҳ мһҲлӢӨ Various types of Convolution layers P.25https://blog.yani.io/filter-group-tutorial/

- 26. Grouped Convolution кІ°кіјм ҒмңјлЎң к°Ғ к·ёлЈ№л§ҲлӢӨ лҸ…лҰҪм Ғмқё н•„н„°мқҳ н•ҷмҠөмқ„ кё°лҢҖн• мҲҳ мһҲлӢӨ. вҖў AlexNetм—җ мӮ¬мҡ©лҗң Grouped Convolutionмқҳ мҳҲмӢң Various types of Convolution layers P.26 https://blog.yani.io/filter-group-tutorial/ Example : AlexNet мқҢмҳҒмҷҖ мҷёкіҪм„ мң„мЈјмқҳ м»Өл„җмқ„ н•ҷмҠөн•ң к·ёлЈ№(мң„)кіј мғүмғҒкіј нҢЁн„ҙ мң„мЈјмқҳ м»Өл„җмқ„ н•ҷмҠөн•ң к·ёлЈ№(м•„лһҳ)

- 27. Grouped Convolution к·ёлЈ№ мҲҳлҘј мЎ°м •н•ҙ лҸ…лҰҪм Ғмқё н•„н„° к·ёлЈ№мқ„ мЎ°м •н• мҲҳ мһҲлӢӨ. вҖў к·ёлЈ№мқҳ мҲҳлҘј лҠҳлҰ¬л©ҙ нҢҢлқјлҜён„°мқҳ мҲҳлҠ” мӨ„л©ҙм„ңлҸ„, м„ұлҠҘ н–ҘмғҒмқҙ мқјм–ҙлӮҳлҠ” кІҪмҡ°к°Җ мһҲлӢӨ. к·ёлЈ№мқҳ мҲҳлҠ” Hyper ParameterлқјлҠ” лӢЁм җмқҙ мһҲлӢӨ. вҖў л„Ҳл¬ҙ л§ҺмқҖ к·ёлЈ№мңјлЎңмқҳ л¶„н• мқҖ мҳӨнһҲл Ө м„ұлҠҘмқҙ н•ҳлқҪн• мҲҳ мһҲлӢӨ. Various types of Convolution layers P.27 мқҢмҳҒмҷҖ мҷёкіҪм„ мң„мЈјмқҳ м»Өл„җмқ„ н•ҷмҠөн•ң к·ёлЈ№(мң„)кіј мғүмғҒкіј нҢЁн„ҙ мң„мЈјмқҳ м»Өл„җмқ„ н•ҷмҠөн•ң к·ёлЈ№(м•„лһҳ) AlexNet к·ёлЈ№ мҲҳм—җ л”°лҘё м„ұлҠҘ ліҖнҷ” https://blog.yani.io/filter-group-tutorial/

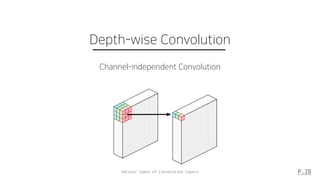

- 28. Various types of Convolution layers P.28 Depth-wise Convolution Channel-independent Convolution

- 29. Depth-wise Convolution мқјл°ҳм Ғмқё Convolution FilterлҠ” мһ…л Ҙ мҳҒмғҒмқҳ лӘЁл“ мұ„л„җмқҳ мҳҒн–Ҙмқ„ л°ӣкІҢ лҗҳлҜҖлЎң, мҷ„лІҪнһҲ нҠ№м • мұ„л„җл§Ңмқҳ Spatial FeatureлҘј 추м¶ңн•ҳлҠ” кІғмқҙ л¶Ҳк°ҖлҠҘн•ҳлӢӨ. вҖў лӢӨлҘё мұ„л„җмқҳ м •ліҙк°Җ кҙҖм—¬н•ҳлҠ” кІғмқҙ л¶Ҳк°Җн”јн•ҳлҜҖлЎң Depth-wise ConvolutionмқҖ к°Ғ лӢЁмқј мұ„л„җм—җ лҢҖн•ҙм„ңл§Ң мҲҳн–үлҗҳлҠ” н•„н„°л“Өмқ„ мӮ¬мҡ©н•ңлӢӨ. вҖў к·ёл Үкё°м—җ н•„н„° мҲҳлҠ” мһ…л Ҙ мұ„л„җмқҳ мҲҳмҷҖ к°ҷлӢӨ. Various types of Convolution layers P.29

- 30. Depth-wise Convolution к°Ғ м»Өл„җл“ӨмқҖ н•ҳлӮҳмқҳ мұ„л„җм—җ лҢҖн•ҙм„ңл§Ң нҢҢлқјлҜён„°лҘј к°Җ진лӢӨ. вҖў мһ…л Ҙ-м¶ңл Ҙ мұ„л„җмқҳ мҲҳк°Җ лҸҷмқјн•ҳлӢӨ. вҖў к°Ғ мұ„л„җ кі мң мқҳ Spatial м •ліҙл§Ңмқ„ мӮ¬мҡ©н•ҳм—¬ н•„н„°лҘј н•ҷмҠөн•ңлӢӨ. кІ°кіјм ҒмңјлЎң мһ…л Ҙ мұ„л„җ мҲҳ л§ҢнҒј к·ёлЈ№мқ„ лӮҳлҲҲ Grouped Convolutionкіј к°ҷлӢӨ. Various types of Convolution layers P.30

- 31. Various types of Convolution layers P.31 Depth-wise Separable Convolution Pointwise Convolution after Depthwise Convolution

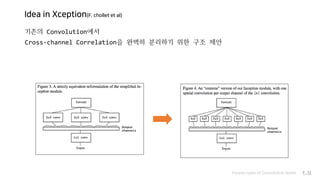

- 32. Idea in Xception(F. chollet et al) кё°мЎҙмқҳ Convolutionм—җм„ң Cross-channel Correlationмқ„ мҷ„лІҪнһҲ 분лҰ¬н•ҳкё° мң„н•ң кө¬мЎ° м ңм•Ҳ Various types of Convolution layers P.32

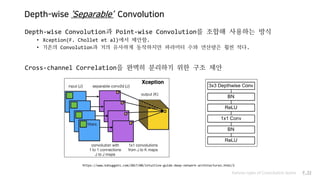

- 33. Depth-wise вҖҳSeparableвҖҷ Convolution Depth-wise Convolutionкіј Point-wise ConvolutionлҘј мЎ°н•©н•ҙ мӮ¬мҡ©н•ҳлҠ” л°©мӢқ вҖў Xception(F. Chollet et al)м—җм„ң м ңм•Ҳн•Ё. вҖў кё°мЎҙмқҳ Convolutionкіј кұ°мқҳ мң мӮ¬н•ҳкІҢ лҸҷмһ‘н•ҳм§Җл§Ң нҢҢлқјлҜён„° мҲҳмҷҖ м—°мӮ°лҹүмқҖ нӣЁм”¬ м ҒлӢӨ. Cross-channel Correlationмқ„ мҷ„лІҪнһҲ 분лҰ¬н•ҳкё° мң„н•ң кө¬мЎ° м ңм•Ҳ Various types of Convolution layers P.33 https://www.kdnuggets.com/2017/08/intuitive-guide-deep-network-architectures.html/2

- 34. Depth-wise вҖҳSeparableвҖҷ Convolution Original Convolution вҖў м „мІҙ мұ„л„җм—җ лҢҖн•ң Spatial Convolution Depth-wise Separable Convolution вҖў к°Ғ мұ„л„җ лі„ Spatial Convolutionмқҙнӣ„ Featureлі„ Linear Combination Various types of Convolution layers P.34

- 35. Depth-wise вҖҳSeparableвҖҷ Convolution Various types of Convolution layers P.35 Baseline (Original Convolution) Proposed (Depth-wise Separable Convolution) # of params. N рқҗ¶рқҗҫ2 + 1 = рқ‘Ғрқҗ¶рқҗҫ2 + рқ‘Ғ рқҗ¶ рқҗҫ2 + 1 + N рқҗ¶ + 1 = рқҗ¶рқҗҫ2 + рқ‘Ғрқҗ¶ + рқҗ¶ + рқ‘Ғ # of operations. Cрқҗ»рқ‘Ҡрқҗҫ2 рқ‘Ғ Cрқҗ»рқ‘Ҡрқҗҫ2 + Cрқҗ»рқ‘Ҡрқ‘Ғ = рқҗ¶рқҗ»рқ‘Ҡ(рқҗҫ2 + рқ‘Ғ) Spatial Featureкіј Channel-wise FeatureлҘј лӘЁл‘җ кі л Өн•ҳлҠ” кІҪлҹүнҷ”лҗң лӘЁлҚё м ңм•Ҳ

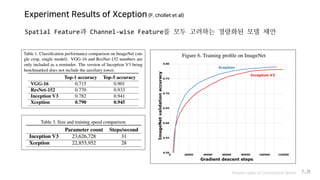

- 36. Experiment Results of Xception (F. chollet et al) Various types of Convolution layers P.36 Spatial Featureкіј Channel-wise FeatureлҘј лӘЁл‘җ кі л Өн•ҳлҠ” кІҪлҹүнҷ”лҗң лӘЁлҚё м ңм•Ҳ

- 37. Various types of Convolution layers P.37 Related Works Squeeze Net, Mobile Net, Shuffle Net

- 38. Squeeze Net (F. N. Iandola et al) Various types of Convolution layers P.38 лӢӨмқҢ л‘җ к°Җм§Җ м•„мқҙл””м–ҙлҘј мӮ¬мҡ©н•ң л„ӨнҠёмӣҢнҒ¬ м„Өкі„лІ• м ңм•Ҳ 1. лҚ” нҒ° Feature Mapмқ„ мӮ¬мҡ©н•ҳлҠ” кІғмқҙ м„ұлҠҘ н–ҘмғҒм—җ мң лҰ¬н•ҳлӢӨ 1. Sub-samplingмқ„ мөңлҢҖн•ң нӣ„л°ҳл¶Җм—җ л°°м№ҳн•ҳм—¬ Feature Mapмқҳ нҒ¬кё°лҘј мң м§Җ 2. л„Ҳл¬ҙ л§ҺмқҖ мұ„л„җмқҖ м»ЁліјлЈЁм…ҳ м—°мӮ°мқҳ 비мҡ©мқ„ мҰқк°ҖмӢңнӮЁлӢӨ 1. Point-wise Convolutionмқ„ мӮ¬мҡ©н•ҙ Channel Reduction

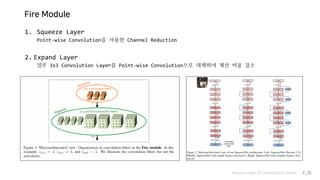

- 39. Fire Module Various types of Convolution layers P.39 1. Squeeze Layer Point-wise Convolutionмқ„ мӮ¬мҡ©н•ң Channel Reduction 2. Expand Layer мқјл¶Җ 3x3 Convolution LayerлҘј Point-wise ConvolutionмңјлЎң лҢҖмІҙн•ҳм—¬ кі„мӮ° 비мҡ© к°җмҶҢ

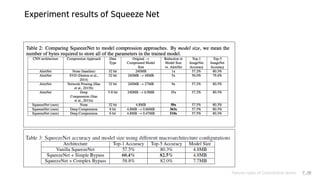

- 40. Experiment results of Squeeze Net Various types of Convolution layers P.40

- 41. Mobile Net (A. G. Howard et al) Various types of Convolution layers P.41 1. Point-wise Convolutionмқҳ м Ғк·№ нҷңмҡ© Scalar-Matrix MultiplicationмңјлЎң кі„мӮ°лҗҳкё°м—җ GEMMмқ„ мӮ¬мҡ©н•ң лӘЁлҚё к°ҖмҶҚнҷ” мҡ©мқҙ 2. Depth-wise Separable Convolutionмқҳ мӮ¬мҡ© мқјл°ҳм Ғмқё Convolution Layerм—җ 비н•ҙ мўӢмқҖ кі„мӮ°/л©”лӘЁлҰ¬ нҡЁмңЁ 3. Resolutionкіј Channel Size ліҙм •мқ„ нҶөн•ң лӘЁлҚё кІҪлҹүнҷ”

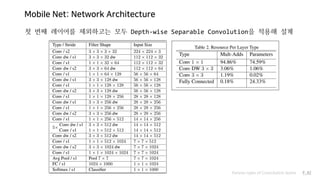

- 42. Mobile Net: Network Architecture Various types of Convolution layers P.42 мІ« лІҲм§ё л Ҳмқҙм–ҙлҘј м ңмҷён•ҳкі лҠ” лӘЁл‘җ Depth-wise Separable Convolutionмқ„ м Ғмҡ©н•ҙ м„Өкі„

- 43. Mobile Net: Width Multiplier / Resolution Multiplier Various types of Convolution layers P.43 추к°Җм Ғмқё лӘЁлҚё кІҪлҹүнҷ”лҘј мң„н•ң л‘җ к°Җм§Җ Hyper Parameter м„Өм • 1. Width Multiplier рқӣј к°Ғ л Ҳмқҙм–ҙмқҳ мһ…м¶ңл Ҙ мұ„л„җмқҳ мҲҳлҘј к°җмҶҢмӢңнӮӨлҠ” нҢҢлқјлҜён„° 2. Resolution Multiplier рқңҢ к°Ғ л Ҳмқҙм–ҙмқҳ мһ…л Ҙ н•ҙмғҒлҸ„лҘј к°җмҶҢмӢңнӮӨлҠ” нҢҢлқјлҜён„°

- 44. Mobile Net: Experiment Result Various types of Convolution layers P.44

- 45. Mobile Net (A. G. Howard et al) Various types of Convolution layers P.45 1. Point-wise Convolutionмқҳ м Ғк·№ нҷңмҡ© Scalar-Matrix MultiplicationмңјлЎң кі„мӮ°лҗҳкё°м—җ GEMMмқ„ мӮ¬мҡ©н•ң лӘЁлҚё к°ҖмҶҚнҷ” мҡ©мқҙ 2. Depth-wise Separable Convolutionмқҳ мӮ¬мҡ© мқјл°ҳм Ғмқё Convolution Layerм—җ 비н•ҙ мўӢмқҖ кі„мӮ°/л©”лӘЁлҰ¬ нҡЁмңЁ 3. Resolutionкіј Channel Size ліҙм •мқ„ нҶөн•ң лӘЁлҚё кІҪлҹүнҷ”

- 46. Mobile Net V2 Various types of Convolution layers P.46 Residual Connetionкіј 추к°Җм Ғмқё Point-wise Convolutionмқ„ мӮ¬мҡ© вҖў мұ„л„җ мҲҳм—җ мқҳн•ң кі„мӮ° 비мҡ© м Ҳк°җ вҖў л§ҺмқҖ мұ„л„җмқҳ Featureмқ„ Low Channel-SpaceлЎң Embeddingмң лҸ„

- 47. Shuffle Net (X. Zhang et al) Various types of Convolution layers P.47 л‘җ к°Җм§Җ л°©мӢқмқҳ л¬ём ңм җмқ„ н•ҙкІ°н•ҳкё° мң„н•ң м•„мқҙл””м–ҙ м ңм•Ҳ 1. Depth-wise Separable Convolution м—¬м „нһҲ Sparse Correlation MatrixлЎң мқён•ң л¬ём ңлҘј к°Җм§Җкі мһҲмқҢ 2. Grouped Convolution Grouped Convolutionмқ„ м Ғмёө н• мӢң м—¬лҹ¬ лҸ…лҰҪм Ғмқё л„ӨнҠёмӣҢнҒ¬мІҳлҹј кІҪлЎңк°Җ л¶„н• н•ҳлӮҳмқҳ л„ӨнҠёмӣҢнҒ¬к°Җ EnsembleмІҳлҹј лҸҷмһ‘н•ҙлІ„лҰ¬лҠ” л¬ём ң л°ңмғқ

- 48. Shuffle Net: Channel Shuffle Various types of Convolution layers P.48 Grouped Convolutionмқ„ л°ҳліөн•ҳлҠ” мӮ¬мқҙм—җ к·ёлЈ№к°„ мқјл¶Җ мұ„л„җмқ„ Shuffle. вҖў к°„лӢЁн•ң кө¬нҳ„мңјлЎң к·ёлЈ№к°„ Independency н•ҙкІ° вҖў Grouped ConvolutionмңјлЎң Sparse Correlation Matrix л¬ём ң н•ҙкІ°

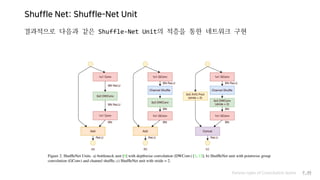

- 49. Shuffle Net: Shuffle-Net Unit Various types of Convolution layers P.49 кІ°кіјм ҒмңјлЎң лӢӨмқҢкіј к°ҷмқҖ Shuffle-Net Unitмқҳ м Ғмёөмқ„ нҶөн•ң л„ӨнҠёмӣҢнҒ¬ кө¬нҳ„

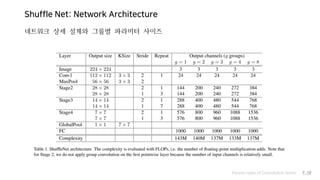

- 50. Shuffle Net: Network Architecture Various types of Convolution layers P.50 л„ӨнҠёмӣҢнҒ¬ мғҒм„ё м„Өкі„мҷҖ к·ёлЈ№лі„ нҢҢлқјлҜён„° мӮ¬мқҙмҰҲ

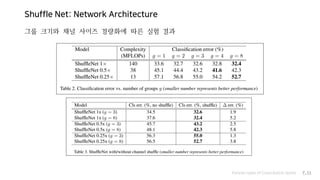

- 51. Shuffle Net: Network Architecture Various types of Convolution layers P.51 к·ёлЈ№ нҒ¬кё°мҷҖ мұ„л„җ мӮ¬мқҙмҰҲ кІҪлҹүнҷ”м—җ л”°лҘё мӢӨн—ҳ кІ°кіј

- 52. References [1] Multi-Scale Context Aggregation by Dilated Convolutions (F. Yu et al) [2] SqueezeNet: AlexNet-level accuracy with 50x fewer parameters and <0.5MB model size (F. N. Iandola et al) [3] Xception: Deep Learning with Depthwise Separable Convolutions (François Chollet) [4] MobileNets: Efficient Convolutional Neural Networks for Mobile Vision Applications (A. G. Howard et al) [5] MobileNetV2: Inverted Residuals and Linear Bottlenecks (M. Sandler et al) [6] ShuffleNet: An Extremely Efficient Convolutional Neural Network for Mobile Devices (X. Zhang et al) Various types of Convolution layers P.52

- 53. Fin. к°җмӮ¬н•©лӢҲлӢӨ. * мқҙ PPTлҠ” л„ӨмқҙлІ„м—җм„ң м ңкіөн•ң лӮҳлҲ”кёҖкјҙкіј м•„лӘЁл ҲнҚјмӢңн”Ҫмқҳ м•„лҰ¬л”°л¶ҖлҰ¬ нҸ°нҠёлҘј мӮ¬мҡ©н•ҳкі мһҲмҠөлӢҲлӢӨ. Various types of Convolution layers P.53

![Dilated Convolution

Dilated Convolution[1]мқҖ Convolution filterмқҳ мҲҳмҡ© н”Ҫм…ҖмӮ¬мқҙм—җ к°„кІ©мқ„ л‘” нҳ•нғң

мһ…л Ҙ н”Ҫм…Җмқҳ мҲҳлҠ” лҸҷмқјн•ҳм§Җл§Ң, лҚ” л„“мқҖ лІ”мң„м—җ лҢҖн•ң мһ…л Ҙмқ„ мҲҳмҡ©н• мҲҳ мһҲкІҢ лҗңлӢӨ.

Various types of Convolution layers P.15

https://mlblr.com/includes/mlai/index.html](https://image.slidesharecdn.com/aboutconvolutions-180719231603/85/-15-320.jpg)

![Point-wise Convolution - Experiments

Various types of Convolution layers P.22

Squeeze Net[2]

м—¬лҹ¬ кө¬мЎ°м—җм„ң м Ғмҡ©лҗҳм–ҙ кІҪлҹүнҷ”мҷҖ м„ұлҠҘ к°ңм„ мқҙ

к°ҖлҠҘн•Ёмқҙ мӢӨн—ҳм ҒмңјлЎң мҰқлӘ…лҗҳм—ҲлӢӨ.

вҖў Inception

вҖў Xception

вҖў Squeeze-Net

вҖў Mobile-Net

вҖў вҖҰ

Inception Network [3]](https://image.slidesharecdn.com/aboutconvolutions-180719231603/85/-22-320.jpg)

![Grouped Convolution

мһ…л Ҙ мҳҒмғҒмқҳ мұ„л„җл“Өмқ„ м—¬лҹ¬ к°ңмқҳ к·ёлЈ№мңјлЎң лӮҳлҲ„м–ҙ лҸ…лҰҪм Ғмқё м»ЁліјлЈЁм…ҳмқ„ мҲҳн–үн•ҳлҠ” л°©мӢқ

вҖў м•„мқҙл””м–ҙмҷҖ кө¬нҳ„ л°©лІ•мқҙ к°„лӢЁн•ҳлӢӨ

вҖў лі‘л ¬мІҳлҰ¬м—җ мң лҰ¬н•ҳлӢӨ

Various types of Convolution layers P.24

def grouped_convolution(input, n_groups):

input_groups = tf.split(input, n_groups, axis = -1)

output_groups = [

tf.layers.conv2d(input_groups[i], """ some params """)

for i in range(n_groups)

]

output = tf.concat(output_groups, axis = -1)

return output](https://image.slidesharecdn.com/aboutconvolutions-180719231603/85/-24-320.jpg)

![References

[1] Multi-Scale Context Aggregation by Dilated Convolutions (F. Yu et al)

[2] SqueezeNet: AlexNet-level accuracy with 50x fewer parameters

and <0.5MB model size (F. N. Iandola et al)

[3] Xception: Deep Learning with

Depthwise Separable Convolutions (François Chollet)

[4] MobileNets: Efficient Convolutional Neural Networks for

Mobile Vision Applications (A. G. Howard et al)

[5] MobileNetV2: Inverted Residuals and

Linear Bottlenecks (M. Sandler et al)

[6] ShuffleNet: An Extremely Efficient Convolutional Neural Network

for Mobile Devices (X. Zhang et al)

Various types of Convolution layers P.52](https://image.slidesharecdn.com/aboutconvolutions-180719231603/85/-52-320.jpg)