–Ы–µ–Ї—Ж–Є—П 6

Download as ppt, pdf1 like991 views

–Ф–Њ–Ї—Г–Љ–µ–љ—В –Њ—Е–≤–∞—В—Л–≤–∞–µ—В —А–∞–Ј–ї–Є—З–љ—Л–µ —В–Є–њ—Л —А–µ–Ї—Г—А—А–µ–љ—В–љ—Л—Е –љ–µ–є—А–Њ–љ–љ—Л—Е —Б–µ—В–µ–є, –≤–Ї–ї—О—З–∞—П —Б–µ—В–Є –•–Њ–њ—Д–Є–ї–і–∞, –•–µ–Љ–Љ–Є–љ–≥–∞ –Є RMLP, –∞ —В–∞–Ї–ґ–µ –Є—Е –∞–ї–≥–Њ—А–Є—В–Љ—Л –Њ–±—Г—З–µ–љ–Є—П –Є –њ—А–Є–Љ–µ–љ–µ–љ–Є—П. –Ю–њ–Є—Б—Л–≤–∞—О—В—Б—П –Љ–µ—В–Њ–і—Л –Є –њ—А–Є–љ—Ж–Є–њ—Л —А–∞–±–Њ—В—Л –∞—Б—Б–Њ—Ж–Є–∞—В–Є–≤–љ–Њ–є –њ–∞–Љ—П—В–Є, —Д—Г–љ–Ї—Ж–Є–Є –Њ—И–Є–±–Ї–Є –Є –Њ–±—Г—З–µ–љ–Є–µ –Љ–µ—В–Њ–і–Њ–Љ –•–µ–±–±–∞. –°—А–∞–≤–љ–Є–≤–∞—О—В—Б—П –і–Њ—Б—В–Њ–Є–љ—Б—В–≤–∞ –Є –љ–µ–і–Њ—Б—В–∞—В–Ї–Є —Б–µ—В–µ–є, –≤–Ї–ї—О—З–∞—П —Н—Д—Д–µ–Ї—В–Є–≤–љ–Њ—Б—В—М –Є –Њ–≥—А–∞–љ–Є—З–µ–љ–Є—П –≤ –Ї–Њ–љ—В–µ–Ї—Б—В–µ —А–∞—Б–њ–Њ–Ј–љ–∞–≤–∞–љ–Є—П –Њ–±—А–∞–Ј–Њ–≤ –Є –Ї–ї–∞—Б—В–µ—А–Є–Ј–∞—Ж–Є–Є.

1 of 24

Downloaded 24 times

![–°–µ—В—М –≠–ї—М–Љ–∞–љ–∞ : –∞–ї–≥–Њ—А–Є—В–Љ –Њ–±—Г—З–µ–љ–Є—П –Ь–µ—В–Њ–і –љ–∞–Є—Б–Ї–Њ—А–µ–є—И–µ–≥–Њ —Б–њ—Г—Б–Ї–∞, online —А–µ–ґ–Є–Љ –§—Г–љ–Ї—Ж–Є—П –Њ—И–Є–±–Ї–Є: –°–ї—Г—З–∞–є–љ–∞—П –Є–љ–Є—Ж–Є–∞–ї–Є–Ј–∞—Ж–Є—П –≤–µ—Б–Њ–≤, —А–∞–≤–љ–Њ–Љ–µ—А–љ–Њ–µ –Є–Ј [-1,1] –Ф–ї—П –Љ–Њ–Љ–µ–љ—В–∞ –≤—А–µ–Љ–µ–љ–Є t —Б—Д–Њ—А–Љ–Є—А–Њ–≤–∞—В—М –≤—Е–Њ–і–љ–Њ–є –≤–µ–Ї—В–Њ—А x(t) –Т—Л—З–Є—Б–ї–Є—В—М –≤–µ–Ї—В–Њ—А –≥—А–∞–і–Є–µ–љ—В–∞ –Ш–Ј–Љ–µ–љ–Є—В—М –≤–µ—Б–∞ –Я–µ—А–µ–є—В–Є –љ–∞ —И–∞–≥ 2.](https://image.slidesharecdn.com/lec6-111222191300-phpapp01/85/6-5-320.jpg)

![RTRN вАУ –∞–ї–≥–Њ—А–Є—В–Љ –Њ–±—Г—З–µ–љ–Є—П –Ь–µ—В–Њ–і –љ–∞–Є—Б–Ї–Њ—А–µ–є—И–µ–≥–Њ —Б–њ—Г—Б–Ї–∞, online —А–µ–ґ–Є–Љ –°–ї—Г—З–∞–є–љ–∞—П –Є–љ–Є—Ж–Є–∞–ї–Є–Ј–∞—Ж–Є—П –≤–µ—Б–Њ–≤, —А–∞–≤–љ–Њ–Љ–µ—А–љ–Њ–µ –Є–Ј [-1,1] –Ф–ї—П –Љ–Њ–Љ–µ–љ—В–∞ –≤—А–µ–Љ–µ–љ–Є t —Б—Д–Њ—А–Љ–Є—А–Њ–≤–∞—В—М –≤—Е–Њ–і–љ–Њ–є –≤–µ–Ї—В–Њ—А x(t) –Т—Л—З–Є—Б–ї–Є—В—М –≤–µ–Ї—В–Њ—А –≥—А–∞–і–Є–µ–љ—В–∞ –Ш–Ј–Љ–µ–љ–Є—В—М –≤–µ—Б–∞ –Я–µ—А–µ–є—В–Є –љ–∞ —И–∞–≥ 2.](https://image.slidesharecdn.com/lec6-111222191300-phpapp01/85/6-7-320.jpg)

Ad

Recommended

—Б–µ—В–Є —Н–≤–Љ –Є —Б—А–µ–і—Б—В–≤–∞ —В–µ–ї–µ–Ї–Њ–Љ–Љ—Г–љ–Є–Ї–∞—Ж–Є–є

—Б–µ—В–Є —Н–≤–Љ –Є —Б—А–µ–і—Б—В–≤–∞ —В–µ–ї–µ–Ї–Њ–Љ–Љ—Г–љ–Є–Ї–∞—Ж–Є–єstudent_kai

ћэ

–Ф–Њ–Ї—Г–Љ–µ–љ—В –Њ–њ–Є—Б—Л–≤–∞–µ—В –Ї—Г—А—Б–Њ–≤–Њ–µ –њ—А–Њ–µ–Ї—В–Є—А–Њ–≤–∞–љ–Є–µ –њ–Њ –і–Є—Б—Ж–Є–њ–ї–Є–љ–µ ¬Ђ—Б–µ—В–Є –≠–Т–Ь –Є —Б—А–µ–і—Б—В–≤–∞ —В–µ–ї–µ–Ї–Њ–Љ–Љ—Г–љ–Є–Ї–∞—Ж–Є–є¬ї, –≤–Ї–ї—О—З–∞—П –њ—А–Є–Љ–Є—В–Є–≤—Л —Г—А–Њ–≤–љ—П –Є —Б—Е–µ–Љ—Л –Ї–Њ–ї–ї–Є–Ј–Є–є. –†–∞—Б—Б–Љ–∞—В—А–Є–≤–∞—О—В—Б—П —А–∞–Ј–ї–Є—З–љ—Л–µ —Б—В–∞–љ–і–∞—А—В—Л Ethernet, —В–∞–Ї–Є–µ –Ї–∞–Ї 10base-2 –Є 10base-T, –∞ —В–∞–Ї–ґ–µ –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В—Б—П —А–∞—Б—З–µ—В –Ј–љ–∞—З–µ–љ–Є–є PDV –Є PVV –і–ї—П —А–∞–Ј–љ—Л—Е —Б–µ–≥–Љ–µ–љ—В–Њ–≤ —Б–µ—В–Є. –†–∞—Б—Б—З–Є—В–∞–љ–љ—Л–µ –Ј–љ–∞—З–µ–љ–Є—П –њ–Њ–Ї–∞–Ј—Л–≤–∞—О—В –≤–Ј–∞–Є–Љ–Њ–і–µ–є—Б—В–≤–Є–µ –Љ–µ–ґ–і—Г —Н–ї–µ–Љ–µ–љ—В–∞–Љ–Є —Б–µ—В–Є –Є —Б–Њ–Њ—В–≤–µ—В—Б—В–≤–Є–µ –њ—А–µ–і–µ–ї—М–љ—Л–Љ –Ј–љ–∞—З–µ–љ–Є—П–Љ.–°–≤–µ—А—В–Њ—З–љ—Л–µ –љ–µ–є—А–Њ–љ–љ—Л–µ —Б–µ—В–Є

–°–≤–µ—А—В–Њ—З–љ—Л–µ –љ–µ–є—А–Њ–љ–љ—Л–µ —Б–µ—В–ЄIvan Kavalerov

ћэ

–Ф–Њ–Ї—Г–Љ–µ–љ—В —Б–Њ–і–µ—А–ґ–Є—В –њ–Њ–і—А–Њ–±–љ–Њ–µ –Њ–њ–Є—Б–∞–љ–Є–µ –Љ–µ—В–Њ–і–Њ–≤ –Љ–∞—И–Є–љ–љ–Њ–≥–Њ –Њ–±—Г—З–µ–љ–Є—П –Є –≥–ї—Г–±–Њ–Ї–Њ–≥–Њ –Њ–±—Г—З–µ–љ–Є—П, –≤–Ї–ї—О—З–∞—П —Б–≤–µ—А—В–Њ—З–љ—Л–µ –љ–µ–є—А–Њ–љ–љ—Л–µ —Б–µ—В–Є –Є –Є—Е –њ—А–Є–Љ–µ–љ–µ–љ–Є–µ –≤ –Ј–∞–і–∞—З–∞—Е –Ї–ї–∞—Б—Б–Є—Д–Є–Ї–∞—Ж–Є–Є. –Ю—Б–љ–Њ–≤–љ–Њ–µ –≤–љ–Є–Љ–∞–љ–Є–µ —Г–і–µ–ї—П–µ—В—Б—П –њ—А–Њ–±–ї–µ–Љ–∞–Љ –њ—А–µ–і—Б—В–∞–≤–ї–µ–љ–Є—П –і–∞–љ–љ—Л—Е, –Њ–±—Г—З–µ–љ–Є—О –љ–µ–є—А–Њ—Б–µ—В–µ–є —Б –њ–Њ–Љ–Њ—Й—М—О –Љ–µ—В–Њ–і–Њ–≤ –≥—А–∞–і–Є–µ–љ—В–љ–Њ–≥–Њ —Б–њ—Г—Б–Ї–∞ –Є –Њ–±—А–∞—В–љ–Њ–≥–Њ —А–∞—Б–њ—А–Њ—Б—В—А–∞–љ–µ–љ–Є—П –Њ—И–Є–±–Ї–Є, –∞ —В–∞–Ї–ґ–µ –Љ–µ—В–Њ–і–∞–Љ —А–µ–≥—Г–ї—П—А–Є–Ј–∞—Ж–Є–Є –Є —Г–Љ–µ–љ—М—И–µ–љ–Є—П —А–∞–Ј—А—П–і–љ–Њ—Б—В–Є –њ–∞—А–∞–Љ–µ—В—А–Њ–≤. –Т –і–Њ–Ї—Г–Љ–µ–љ—В–µ —В–∞–Ї–ґ–µ –њ—А–µ–і—Б—В–∞–≤–ї–µ–љ—Л —А–µ—Б—Г—А—Б—Л –і–ї—П –і–∞–ї—М–љ–µ–є—И–µ–≥–Њ –Є–Ј—Г—З–µ–љ–Є—П –Є –њ—А–Њ–µ–Ї—В—Л –і–ї—П –њ—А–∞–Ї—В–Є—З–µ—Б–Ї–Њ–є —А–µ–∞–ї–Є–Ј–∞—Ж–Є–Є –љ–µ–є—А–Њ–љ–љ—Л—Е —Б–µ—В–µ–є.–Ъ–ї–∞—Б—Б–Є—Д–Є–Ї–∞—Ж–Є—П –Є–Ј–Њ–±—А–∞–ґ–µ–љ–Є–є —Б –њ–Њ–Љ–Њ—Й—М—О –љ–µ–є—А–Њ–љ–љ—Л—Е —Б–µ—В–µ–є. –°–ґ–∞—В–Є–µ –Є —Г—Б–Ї–Њ—А–µ–љ–Є–µ –Њ–±—Г—З–µ...

–Ъ–ї–∞—Б—Б–Є—Д–Є–Ї–∞—Ж–Є—П –Є–Ј–Њ–±—А–∞–ґ–µ–љ–Є–є —Б –њ–Њ–Љ–Њ—Й—М—О –љ–µ–є—А–Њ–љ–љ—Л—Е —Б–µ—В–µ–є. –°–ґ–∞—В–Є–µ –Є —Г—Б–Ї–Њ—А–µ–љ–Є–µ –Њ–±—Г—З–µ...Yandex

ћэ

–Ф–Њ–Ї—Г–Љ–µ–љ—В –Њ–±—Б—Г–ґ–і–∞–µ—В –Ї–ї–∞—Б—Б–Є—Д–Є–Ї–∞—Ж–Є—О –Є–Ј–Њ–±—А–∞–ґ–µ–љ–Є–є —Б –њ–Њ–Љ–Њ—Й—М—О –љ–µ–є—А–Њ–љ–љ—Л—Е —Б–µ—В–µ–є, –∞–Ї—Ж–µ–љ—В–Є—А—Г—П –≤–љ–Є–Љ–∞–љ–Є–µ –љ–∞ —Б–≤—С—А—В–Њ—З–љ—Л—Е —Б–µ—В—П—Е –Є –Є—Е –∞—А—Е–Є—В–µ–Ї—В—Г—А–µ. –Ю–љ –Њ–њ–Є—Б—Л–≤–∞–µ—В –њ—А–Њ—Ж–µ—Б—Б –Њ–±—Г—З–µ–љ–Є—П –Љ–Њ–і–µ–ї–µ–є, –∞ —В–∞–Ї–ґ–µ –њ—А–Є–Љ–µ–љ–µ–љ–Є–µ –њ—А–µ–і–Њ–±—Г—З–µ–љ–љ—Л—Е —Б–µ—В–µ–є –і–ї—П —А–µ—И–µ–љ–Є—П —Б–њ–µ—Ж–Є—Д–Є—З–љ—Л—Е –Ј–∞–і–∞—З –Ї–ї–∞—Б—Б–Є—Д–Є–Ї–∞—Ж–Є–Є. –Ъ—А–Њ–Љ–µ —В–Њ–≥–Њ, —А–∞—Б—Б–Љ–∞—В—А–Є–≤–∞—О—В—Б—П –Љ–µ—В–Њ–і—Л —Б–ґ–∞—В–Є—П –Є —Г—Б–Ї–Њ—А–µ–љ–Є—П –Њ–±—Г—З–µ–љ–љ—Л—Е –Љ–Њ–і–µ–ї–µ–є, —З—В–Њ —Г–ї—Г—З—И–∞–µ—В –Є—Е –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї—М–љ–Њ—Б—В—М –±–µ–Ј –Ј–љ–∞—З–Є—В–µ–ї—М–љ–Њ–є –њ–Њ—В–µ—А–Є —В–Њ—З–љ–Њ—Б—В–Є.–Ы–µ–Ї—Ж–Є—П вДЦ13 "–У–ї—Г–±–Њ–Ї–Є–µ –љ–µ–є—А–Њ–љ–љ—Л–µ —Б–µ—В–Є"

–Ы–µ–Ї—Ж–Є—П вДЦ13 "–У–ї—Г–±–Њ–Ї–Є–µ –љ–µ–є—А–Њ–љ–љ—Л–µ —Б–µ—В–Є" Technosphere1

ћэ

–Ы–µ–Ї—Ж–Є—П –њ–Њ—Б–≤—П—Й–µ–љ–∞ –≥–ї—Г–±–Њ–Ї–Є–Љ –љ–µ–є—А–Њ–љ–љ—Л–Љ —Б–µ—В—П–Љ –Є –Є—Е —Б—В—А—Г–Ї—В—Г—А–µ, —А–∞—Б—Б–Љ–∞—В—А–Є–≤–∞—О—В—Б—П –њ—А–Њ–±–ї–µ–Љ—Л –∞–ї–≥–Њ—А–Є—В–Љ–∞ –Њ–±—А–∞—В–љ–Њ–≥–Њ —А–∞—Б–њ—А–Њ—Б—В—А–∞–љ–µ–љ–Є—П –Њ—И–Є–±–Ї–Є –Є –Љ–µ—В–Њ–і—Л –њ—А–µ–і–Њ–±—Г—З–µ–љ–Є—П. –Ю–±—Б—Г–ґ–і–∞—О—В—Б—П —А–∞–Ј–ї–Є—З–љ—Л–µ –≤–Є–і—Л –≥–ї—Г–±–Њ–Ї–Є—Е —Б–µ—В–µ–є, –≤–Ї–ї—О—З–∞—П –Њ–≥—А–∞–љ–Є—З–µ–љ–љ—Л–µ –Љ–∞—И–Є–љ—Л –С–Њ–ї—Ж–Љ–∞–љ–∞ –Є –∞–≤—В–Њ—Н–љ–Ї–Њ–і–µ—А—Л, –∞ —В–∞–Ї–ґ–µ –њ—А–∞–Ї—В–Є—З–µ—Б–Ї–Є–µ –њ—А–Є–Љ–µ–љ–µ–љ–Є—П –≥–ї—Г–±–Њ–Ї–Є—Е –љ–µ–є—А–Њ–љ–љ—Л—Е —Б–µ—В–µ–є. –†–∞—Б—Б–Љ–∞—В—А–Є–≤–∞—О—В—Б—П –њ—А–Њ–±–ї–µ–Љ—Л –Ј–∞—В—Г—Е–∞–љ–Є—П –≥—А–∞–і–Є–µ–љ—В–∞ –Є –њ–∞—А–∞–ї–Є—З–∞ —Б–µ—В–Є, –∞ —В–∞–Ї–ґ–µ —Б–њ–Њ—Б–Њ–±—Л –Є—Е —А–µ—И–µ–љ–Є—П.–°–µ—А–≥–µ–є –У–µ—А–∞—Б–Є–Љ–Њ–≤ (–Т–Ь–Ъ –Ь–У–£), –Р–ї–µ–Ї—Б–∞–љ–і—А –Ь–µ—Й–µ—А—П–Ї–Њ–≤ (–Ш–љ—Б—В–Є—В—Г—В –Ї–Њ—Б–Љ–Є—З–µ—Б–Ї–Є—Е –Є—Б—Б–ї–µ–і–Њ...

–°–µ—А–≥–µ–є –У–µ—А–∞—Б–Є–Љ–Њ–≤ (–Т–Ь–Ъ –Ь–У–£), –Р–ї–µ–Ї—Б–∞–љ–і—А –Ь–µ—Й–µ—А—П–Ї–Њ–≤ (–Ш–љ—Б—В–Є—В—Г—В –Ї–Њ—Б–Љ–Є—З–µ—Б–Ї–Є—Е –Є—Б—Б–ї–µ–і–Њ...Mail.ru Group

ћэ

–Ф–Њ–Ї–ї–∞–і –њ–Њ—Б–≤—П—Й–µ–љ –Ј–∞–і–∞—З–∞–Љ –∞–љ–∞–ї–Є–Ј–∞ –і–∞–љ–љ—Л—Е –≤ –∞—Б—В—А–Њ—Д–Є–Ј–Є–Ї–µ, –≤–Ї–ї—О—З–∞—П –≤–∞–ґ–љ—Л–µ –≤–Њ–њ—А–Њ—Б—Л –љ–∞–±–ї—О–і–∞—В–µ–ї—М–љ–Њ–є –Ї–Њ—Б–Љ–Њ–ї–Њ–≥–Є–Є, —В–∞–Ї–Є–µ –Ї–∞–Ї –њ—А–Є—А–Њ–і–∞ —В–µ–Љ–љ–Њ–є –Љ–∞—В–µ—А–Є–Є –Є —Н–љ–µ—А–≥–Є–Є. –Ю–±—Б—Г–ґ–і–∞–µ—В—Б—П –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞–љ–Є–µ –Љ–∞—И–Є–љ–љ–Њ–≥–Њ –Њ–±—Г—З–µ–љ–Є—П –і–ї—П –Њ–±—А–∞–±–Њ—В–Ї–Є –±–Њ–ї—М—И–Є—Е –і–∞–љ–љ—Л—Е –Є –Ї–ї–∞—Б—Б–Є—Д–Є–Ї–∞—Ж–Є–Є –љ–µ–±–µ—Б–љ—Л—Е –Њ–±—К–µ–Ї—В–Њ–≤, –∞ —В–∞–Ї–ґ–µ –±—Г–і—Г—Й–Є–µ –њ—А–Њ–µ–Ї—В—Л, –љ–∞–њ—А–Є–Љ–µ—А, LSST. –Ю—Б–љ–Њ–≤–љ—Л–Љ –∞–Ї—Ж–µ–љ—В–Њ–Љ —П–≤–ї—П–µ—В—Б—П –њ–Њ–≤—Л—И–µ–љ–Є–µ —В–Њ—З–љ–Њ—Б—В–Є –њ—А–Њ–≥–љ–Њ–Ј–Њ–≤ –Є –Ї–ї–∞—Б—Б–Є—Д–Є–Ї–∞—Ж–Є–Є —З–µ—А–µ–Ј —Г–љ–Є—Д–Є—Ж–Є—А–Њ–≤–∞–љ–љ—Г—О –Њ–±—А–∞–±–Њ—В–Ї—Г –Љ–љ–Њ–≥–Њ–≤–Њ–ї–љ–Њ–≤—Л—Е –і–∞–љ–љ—Л—Е.–°–µ–Љ–Є–љ–∞—А 7. –Ь–љ–Њ–≥–Њ–њ–Њ—В–Њ—З–љ–Њ–µ –њ—А–Њ–≥—А–∞–Љ–Љ–Є—А–Њ–≤–∞–љ–Є–µ –љ–∞ OpenMP (—З–∞—Б—В—М 7)

–°–µ–Љ–Є–љ–∞—А 7. –Ь–љ–Њ–≥–Њ–њ–Њ—В–Њ—З–љ–Њ–µ –њ—А–Њ–≥—А–∞–Љ–Љ–Є—А–Њ–≤–∞–љ–Є–µ –љ–∞ OpenMP (—З–∞—Б—В—М 7)Mikhail Kurnosov

ћэ

–Ф–Њ–Ї—Г–Љ–µ–љ—В –њ—А–µ–і—Б—В–∞–≤–ї—П–µ—В —Б–Њ–±–Њ–є —Б–µ–Љ–Є–љ–∞—А –њ–Њ —Б—В–∞–љ–і–∞—А—В—Г OpenMP –Є –њ–∞—А–∞–ї–ї–µ–ї—М–љ–Њ–Љ—Г –њ—А–Њ–≥—А–∞–Љ–Љ–Є—А–Њ–≤–∞–љ–Є—О, –Њ–њ–Є—Б—Л–≤–∞—П —А–∞–Ј–ї–Є—З–љ—Л–µ –Љ–µ—В–Њ–і—Л —А–µ–Ї—Г—А—Б–Є–≤–љ–Њ–≥–Њ —Б—Г–Љ–Љ–Є—А–Њ–≤–∞–љ–Є—П –Є –њ–∞—А–∞–ї–ї–µ–ї–Є–Ј–Љ–∞ –Ј–∞–і–∞—З. –Т –љ–µ–Љ –њ—А–Є–≤–Њ–і—П—В—Б—П –њ—А–Є–Љ–µ—А—Л –Ї–Њ–і–∞, –≤–Ї–ї—О—З–∞—П –Њ–њ–µ—А–∞—Ж–Є–Є —Б –Љ–∞—Б—Б–Є–≤–∞–Љ–Є –Є —З–Є—Б–ї–µ–љ–љ—Л–Љ –Є–љ—В–µ–≥—А–Є—А–Њ–≤–∞–љ–Є–µ–Љ, –∞ —В–∞–Ї–ґ–µ —А–µ–∞–ї–Є–Ј–∞—Ж–Є—П –Љ–љ–Њ–≥–Њ–њ–Њ—В–Њ—З–љ–Њ–є –±—Л—Б—В—А–Њ–є —Б–Њ—А—В–Є—А–Њ–≤–Ї–Є. –Ъ—А–Њ–Љ–µ —В–Њ–≥–Њ, —А–∞—Б—Б–Љ–∞—В—А–Є–≤–∞–µ—В—Б—П –њ—А–Є–Љ–µ–љ–µ–љ–Є–µ OpenMP –і–ї—П –њ–Њ–≤—Л—И–µ–љ–Є—П –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї—М–љ–Њ—Б—В–Є –њ—А–Є –≤—Л–њ–Њ–ї–љ–µ–љ–Є–Є —А–∞–Ј–ї–Є—З–љ—Л—Е –њ–∞—А–∞–ї–ї–µ–ї—М–љ—Л—Е –≤—Л—З–Є—Б–ї–µ–љ–Є–є.–°–µ–Љ–Є–љ–∞—А 3. –Ь–љ–Њ–≥–Њ–њ–Њ—В–Њ—З–љ–Њ–µ –њ—А–Њ–≥—А–∞–Љ–Љ–Є—А–Њ–≤–∞–љ–Є–µ –љ–∞ OpenMP (—З–∞—Б—В—М 3)

–°–µ–Љ–Є–љ–∞—А 3. –Ь–љ–Њ–≥–Њ–њ–Њ—В–Њ—З–љ–Њ–µ –њ—А–Њ–≥—А–∞–Љ–Љ–Є—А–Њ–≤–∞–љ–Є–µ –љ–∞ OpenMP (—З–∞—Б—В—М 3)Mikhail Kurnosov

ћэ

–Ф–Њ–Ї—Г–Љ–µ–љ—В –њ—А–µ–і—Б—В–∞–≤–ї—П–µ—В —Б–Њ–±–Њ–є —Б–µ–Љ–Є–љ–∞—А –њ–Њ –Љ–µ—В–Њ–і–∞–Љ –њ–∞—А–∞–ї–ї–µ–ї—М–љ–Њ–≥–Њ –њ—А–Њ–≥—А–∞–Љ–Љ–Є—А–Њ–≤–∞–љ–Є—П —Б –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞–љ–Є–µ–Љ OpenMP, –≤–Ї–ї—О—З–∞—П —З–Є—Б–ї–µ–љ–љ–Њ–µ –Є–љ—В–µ–≥—А–Є—А–Њ–≤–∞–љ–Є–µ –Є –њ–Њ–і—Б—З–µ—В –њ—А–Њ—Б—В—Л—Е —З–Є—Б–µ–ї. –Ю—Б–љ–Њ–≤–љ–Њ–µ –≤–љ–Є–Љ–∞–љ–Є–µ —Г–і–µ–ї—П–µ—В—Б—П –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞–љ–Є—О –њ–∞—А–∞–ї–ї–µ–ї—М–љ—Л—Е –∞–ї–≥–Њ—А–Є—В–Љ–Њ–≤ –і–ї—П –њ–Њ–≤—Л—И–µ–љ–Є—П –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї—М–љ–Њ—Б—В–Є –Є —Г—Б—В—А–∞–љ–µ–љ–Є—П –љ–µ—А–∞–≤–љ–Њ–Љ–µ—А–љ–Њ–є –Ј–∞–≥—А—Г–Ј–Ї–Є –њ–Њ—В–Њ–Ї–Њ–≤. –Т –і–Њ–Ї—Г–Љ–µ–љ—В–µ –њ—А–Є–≤–µ–і–µ–љ—Л –њ—А–Є–Љ–µ—А—Л –Ї–Њ–і–∞ –Є –Њ–±—Б—Г–ґ–і–∞—О—В—Б—П —А–∞–Ј–ї–Є—З–љ—Л–µ —Б—В—А–∞—В–µ–≥–Є–Є —А–∞—Б–њ—А–µ–і–µ–ї–µ–љ–Є—П –Є—В–µ—А–∞—Ж–Є–є –Љ–µ–ґ–і—Г –њ–Њ—В–Њ–Ї–∞–Љ–Є.–Ф–Љ–Є—В—А–Є–є –Ъ—А–Њ–њ–Њ—В–Њ–≤, –Т–Ь–Ъ –Ь–У–£, –У—А—Г–њ–њ–∞ –С–∞–є–µ—Б–Њ–≤—Б–Ї–Є—Е –Ь–µ—В–Њ–і–Њ–≤, ¬Ђ–Ь–µ—В–Њ–і—Л –Њ–њ—В–Є–Љ–Є–Ј–∞—Ж–Є–Є –±–Њ...

–Ф–Љ–Є—В—А–Є–є –Ъ—А–Њ–њ–Њ—В–Њ–≤, –Т–Ь–Ъ –Ь–У–£, –У—А—Г–њ–њ–∞ –С–∞–є–µ—Б–Њ–≤—Б–Ї–Є—Е –Ь–µ—В–Њ–і–Њ–≤, ¬Ђ–Ь–µ—В–Њ–і—Л –Њ–њ—В–Є–Љ–Є–Ј–∞—Ж–Є–Є –±–Њ...Mail.ru Group

ћэ

–Ф–Њ–Ї—Г–Љ–µ–љ—В –Њ–њ–Є—Б—Л–≤–∞–µ—В –Љ–µ—В–Њ–і—Л –Њ–њ—В–Є–Љ–Є–Ј–∞—Ж–Є–Є –±–Њ–ї—М—И–Є—Е —Б—Г–Љ–Љ —Д—Г–љ–Ї—Ж–Є–є, –≤–Ї–ї—О—З–∞—П –≥—А–∞–і–Є–µ–љ—В–љ—Л–є —Б–њ—Г—Б–Ї, —Б—В–Њ—Е–∞—Б—В–Є—З–µ—Б–Ї–Є–є –≥—А–∞–і–Є–µ–љ—В–љ—Л–є —Б–њ—Г—Б–Ї –Є —Б—В–Њ—Е–∞—Б—В–Є—З–µ—Б–Ї–Є–є —Г—Б—А–µ–і–љ—С–љ–љ—Л–є –≥—А–∞–і–Є–µ–љ—В. –†–∞—Б—Б–Љ–∞—В—А–Є–≤–∞—О—В—Б—П –Є—Е —Б–≤–Њ–є—Б—В–≤–∞, —В–∞–Ї–Є–µ –Ї–∞–Ї —Б–Ї–Њ—А–Њ—Б—В—М —Б—Е–Њ–і–Є–Љ–Њ—Б—В–Є –Є —В—А–µ–±–Њ–≤–∞–љ–Є—П –њ–Њ –њ–∞–Љ—П—В–Є, –∞ —В–∞–Ї–ґ–µ –њ—А–µ–і—Б—В–∞–≤–ї–µ–љ—Л –љ–Њ–≤—Л–µ –њ–Њ–і—Е–Њ–і—Л, —В–∞–Ї–Є–µ –Ї–∞–Ї SAG –Є SVRG, –Ї–Њ—В–Њ—А—Л–µ –њ—А–µ–і–ї–∞–≥–∞—О—В –∞–і–∞–њ—В–Є–≤–љ—Л–µ —Б—В—А–∞—В–µ–≥–Є–Є –і–ї—П —Г–ї—Г—З—И–µ–љ–Є—П —Н—Д—Д–µ–Ї—В–Є–≤–љ–Њ—Б—В–Є. –Ю—Б–љ–Њ–≤–љ–Њ–µ –≤–љ–Є–Љ–∞–љ–Є–µ —Г–і–µ–ї—П–µ—В—Б—П —Г–Љ–µ–љ—М—И–µ–љ–Є—О –≤—Л—З–Є—Б–ї–Є—В–µ–ї—М–љ—Л—Е –Ј–∞—В—А–∞—В –Є –њ–∞–Љ—П—В–Є, —Б–Њ—Е—А–∞–љ—П—П –њ—А–Є —Н—В–Њ–Љ –≤—Л—Б–Њ–Ї—Г—О —Б—В–µ–њ–µ–љ—М —Б—Е–Њ–і–Є–Љ–Њ—Б—В–Є –Є —Н—Д—Д–µ–Ї—В–Є–≤–љ–Њ—Б—В—М –Љ–µ—В–Њ–і–Њ–≤.–љ–µ–є—А–Њ–љ–љ—Л–µ —Б–µ—В–Є

–љ–µ–є—А–Њ–љ–љ—Л–µ —Б–µ—В–Єhudvin

ћэ

–Ф–Њ–Ї—Г–Љ–µ–љ—В –њ—А–µ–і—Б—В–∞–≤–ї—П–µ—В —Б–Њ–±–Њ–є –Њ–±–Ј–Њ—А –Є—Б—В–Њ—А–Є–Є –Є —А–∞–Ј–≤–Є—В–Є—П –Є—Б–Ї—Г—Б—Б—В–≤–µ–љ–љ—Л—Е –љ–µ–є—А–Њ–љ–љ—Л—Е —Б–µ—В–µ–є, –љ–∞—З–Є–љ–∞—П —Б —А–∞–±–Њ—В –£–Њ—А—А–µ–љ–∞ –Ь–∞–Ї–Ї–∞–ї–ї–Њ–Ї–∞ –Є –£–Њ–ї—В–µ—А–∞ –Я–Є—В—В—Б–∞ –≤ 1943 –≥–Њ–і—Г –Є –Ј–∞–Ї–∞–љ—З–Є–≤–∞—П —А–µ–≤–Њ–ї—О—Ж–Є–Њ–љ–љ—Л–Љ–Є –Њ—В–Ї—А—Л—В–Є—П–Љ–Є 1986 –≥–Њ–і–∞, —Б–≤—П–Ј–∞–љ–љ—Л–Љ–Є —Б –Љ–µ—В–Њ–і–Њ–Љ –Њ–±—А–∞—В–љ–Њ–≥–Њ —А–∞—Б–њ—А–Њ—Б—В—А–∞–љ–µ–љ–Є—П –Њ—И–Є–±–Ї–Є. –Ґ–∞–Ї–ґ–µ –Њ–±—Б—Г–ґ–і–∞—О—В—Б—П —А–∞–Ј–ї–Є—З–љ—Л–µ –≤–Є–і—Л –љ–µ–є—А–Њ–љ–љ—Л—Е —Б–µ—В–µ–є, —В–∞–Ї–Є–µ –Ї–∞–Ї —Б–µ—В–Є –•–Њ–њ—Д–Є–ї–і–∞ –Є —Б–µ—В–Є –Ъ–Њ—Е–Њ–љ–µ–љ–∞, –Є —Г–њ–Њ–Љ–Є–љ–∞–µ—В—Б—П –Є—Е —Б–њ–Њ—Б–Њ–±–љ–Њ—Б—В—М –Є–Љ–Є—В–Є—А–Њ–≤–∞—В—М –љ–µ–њ—А–µ—А—Л–≤–љ—Л–µ —Д—Г–љ–Ї—Ж–Є–Є. –Т –і–Њ–Ї—Г–Љ–µ–љ—В–µ –њ–Њ–і—З–µ—А–Ї–Є–≤–∞–µ—В—Б—П –≤–∞–ґ–љ–Њ—Б—В—М –µ—Б—В–µ—Б—В–≤–µ–љ–љ–Њ–≥–Њ –Є–љ—В–µ–ї–ї–µ–Ї—В–∞ –і–ї—П –Є–Ј—Г—З–µ–љ–Є—П –Є—Б–Ї—Г—Б—Б—В–≤–µ–љ–љ–Њ–≥–Њ –Є–љ—В–µ–ї–ї–µ–Ї—В–∞.–Ы–µ–Ї—Ж–Є—П вДЦ12 "–Ю–≥—А–∞–љ–Є—З–µ–љ–љ–∞—П –Љ–∞—И–Є–љ–∞ –С–Њ–ї—М—Ж–Љ–∞–љ–∞"

–Ы–µ–Ї—Ж–Є—П вДЦ12 "–Ю–≥—А–∞–љ–Є—З–µ–љ–љ–∞—П –Љ–∞—И–Є–љ–∞ –С–Њ–ї—М—Ж–Љ–∞–љ–∞" Technosphere1

ћэ

–Ф–Њ–Ї—Г–Љ–µ–љ—В —Б–Њ–і–µ—А–ґ–Є—В –ї–µ–Ї—Ж–Є—О –Њ softmax —Б–ї–Њ–µ –Є –Њ–≥—А–∞–љ–Є—З–µ–љ–љ–Њ–є –Љ–∞—И–Є–љ–µ –С–Њ–ї—М—Ж–Љ–∞–љ–∞, –≤–Ї–ї—О—З–∞—П –Њ–±—Б—Г–ґ–і–µ–љ–Є–µ –∞–ї–≥–Њ—А–Є—В–Љ–Њ–≤ –Њ–±—Г—З–µ–љ–Є—П –Є —Б—В–∞—В–Є—Б—В–Є—З–µ—Б–Ї–Є—Е –Ї–Њ–љ—Ж–µ–њ—Ж–Є–є. –†–∞—Б—Б–Љ–∞—В—А–Є–≤–∞—О—В—Б—П —А–∞–Ј–ї–Є—З–љ—Л–µ —Д—Г–љ–Ї—Ж–Є–Є —Б—В–Њ–Є–Љ–Њ—Б—В–Є, —В–∞–Ї–Є–µ –Ї–∞–Ї —Б—А–µ–і–љ–µ–Ї–≤–∞–і—А–∞—В–Є—З–љ–∞—П –Њ—И–Є–±–Ї–∞ –Є –њ–µ—А–µ–Ї—А–µ—Б—В–љ–∞—П —Н–љ—В—А–Њ–њ–Є—П, –∞ —В–∞–Ї–ґ–µ –Є—Б–њ–Њ–ї—М–Ј—Г—О—В—Б—П –Љ–µ—В–Њ–і—Л, —Б–≤—П–Ј–∞–љ–љ—Л–µ —Б –ї–Њ–≥–Є—Б—В–Є—З–µ—Б–Ї–Њ–є —А–µ–≥—А–µ—Б—Б–Є–µ–є –Є –љ–µ–є—А–Њ—Б–µ—В—П–Љ–Є. –Т –Ї–Њ–љ—Ж–µ –ї–µ–Ї—Ж–Є–Є –Њ–±—Б—Г–ґ–і–∞—О—В—Б—П –Ї–Њ–љ—Ж–µ–њ—Ж–Є–Є, —Б–≤—П–Ј–∞–љ–љ—Л–µ —Б –Њ–±—Г—З–µ–љ–Є–µ–Љ –±–µ–Ј —Г—З–Є—В–µ–ї—П –Є —Б—В–∞—В–Є—Б—В–Є—З–µ—Б–Ї–Њ–є –Љ–µ—Е–∞–љ–Є–Ї–Њ–є.CV2015. –Ы–µ–Ї—Ж–Є—П 6. –Э–µ–є—А–Њ—Б–µ—В–µ–≤—Л–µ –∞–ї–≥–Њ—А–Є—В–Љ—Л.

CV2015. –Ы–µ–Ї—Ж–Є—П 6. –Э–µ–є—А–Њ—Б–µ—В–µ–≤—Л–µ –∞–ї–≥–Њ—А–Є—В–Љ—Л.Anton Konushin

ћэ

–Ф–Њ–Ї—Г–Љ–µ–љ—В –њ—А–µ–і—Б—В–∞–≤–ї—П–µ—В —Б–Њ–±–Њ–є –ї–µ–Ї—Ж–Є—О –Њ –љ–µ–є—А–Њ—Б–µ—В–µ–≤—Л—Е –∞–ї–≥–Њ—А–Є—В–Љ–∞—Е, –Њ–њ–Є—Б—Л–≤–∞—О—Й—Г—О –Љ–∞—В–µ–Љ–∞—В–Є—З–µ—Б–Ї–Є–µ –Љ–Њ–і–µ–ї–Є –љ–µ–є—А–Њ–љ–Њ–≤, –Љ–µ—В–Њ–і—Л –Њ–±—Г—З–µ–љ–Є—П –Є –∞—А—Е–Є—В–µ–Ї—В—Г—А—Г –љ–µ–є—А–Њ—Б–µ—В–µ–є. –Ю—Б–љ–Њ–≤–љ–Њ–µ –≤–љ–Є–Љ–∞–љ–Є–µ —Г–і–µ–ї—П–µ—В—Б—П —Б–≤—С—А—В–Њ—З–љ—Л–Љ –љ–µ–є—А–Њ—Б–µ—В—П–Љ, –Є—Е —Н—Д—Д–µ–Ї—В–Є–≤–љ–Њ—Б—В–Є –≤ —А–∞—Б–њ–Њ–Ј–љ–∞–≤–∞–љ–Є–Є –Є–Ј–Њ–±—А–∞–ґ–µ–љ–Є–є –Є —Н–≤–Њ–ї—О—Ж–Є–Є –њ–Њ–і—Е–Њ–і–Њ–≤ –Ї –Њ–±—Г—З–µ–љ–Є—О. –Ґ–∞–Ї–ґ–µ —А–∞—Б—Б–Љ–∞—В—А–Є–≤–∞—О—В—Б—П –±–Є–Њ–ї–Њ–≥–Є—З–µ—Б–Ї–Є –≤–і–Њ—Е–љ–Њ–≤–ї—С–љ–љ—Л–µ –Љ–µ—В–Њ–і—Л, —Н–≤—А–Є—Б—В–Є–Ї–Є –Є –∞—А—Е–Є—В–µ–Ї—В—Г—А—Л, –Є—Б–њ–Њ–ї—М–Ј—Г–µ–Љ—Л–µ –і–ї—П —Г–њ—А–∞–≤–ї–µ–љ–Є—П –њ–∞—А–∞–Љ–µ—В—А–∞–Љ–Є –Є —А–∞—Б–њ–Њ–Ј–љ–∞–≤–∞–љ–Є–µ–Љ –Њ–±—К–µ–Ї—В–Њ–≤.–†–Х–Р–Ы–Ш–Ч–Р–¶–Ш–ѓ –†–Р–Ф–Ш–Р–Ы–ђ–Э–Ю-–С–Р–Ч–Ш–°–Э–Ю–Щ –Э–Х–Щ–†–Ю–Э–Э–Ю–Щ –°–Х–Ґ–Ш –Э–Р –Ь–Р–°–°–Ш–Т–Э–Ю-–Я–Р–†–Р–Ы–Ы–Х–Ы–ђ–Э–Ю–Щ –Р–†–•–Ш–Ґ–Х–Ъ...

–†–Х–Р–Ы–Ш–Ч–Р–¶–Ш–ѓ –†–Р–Ф–Ш–Р–Ы–ђ–Э–Ю-–С–Р–Ч–Ш–°–Э–Ю–Щ –Э–Х–Щ–†–Ю–Э–Э–Ю–Щ –°–Х–Ґ–Ш –Э–Р –Ь–Р–°–°–Ш–Т–Э–Ю-–Я–Р–†–Р–Ы–Ы–Х–Ы–ђ–Э–Ю–Щ –Р–†–•–Ш–Ґ–Х–Ъ...ITMO University

ћэ

–Ф–Њ–Ї—Г–Љ–µ–љ—В –Њ–њ–Є—Б—Л–≤–∞–µ—В —А–µ–∞–ї–Є–Ј–∞—Ж–Є—О —А–∞–і–Є–∞–ї—М–љ–Њ-–±–∞–Ј–Є—Б–љ–Њ–є –љ–µ–є—А–Њ–љ–љ–Њ–є —Б–µ—В–Є (RBFNN) –љ–∞ –∞—А—Е–Є—В–µ–Ї—В—Г—А–µ –≥—А–∞—Д–Є—З–µ—Б–Ї–Њ–≥–Њ –њ—А–Њ—Ж–µ—Б—Б–Њ—А–∞ —Б –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞–љ–Є–µ–Љ —В–µ—Е–љ–Њ–ї–Њ–≥–Є–Є CUDA –і–ї—П —А–µ—И–µ–љ–Є—П –Ї—А–∞–µ–≤—Л—Е –Ј–∞–і–∞—З –Љ–∞—В–µ–Љ–∞—В–Є—З–µ—Б–Ї–Њ–є —Д–Є–Ј–Є–Ї–Є. –Р–≤—В–Њ—А –њ—А–Є–≤–Њ–і–Є—В —А–µ–Ј—Г–ї—М—В–∞—В—Л —Б—А–∞–≤–љ–Є—В–µ–ї—М–љ–Њ–≥–Њ –∞–љ–∞–ї–Є–Ј–∞ –≤—А–µ–Љ–µ–љ–Є –Њ–±—Г—З–µ–љ–Є—П RBFNN –љ–∞ —Ж–µ–љ—В—А–∞–ї—М–љ—Л—Е –Є –≥—А–∞—Д–Є—З–µ—Б–Ї–Є—Е –њ—А–Њ—Ж–µ—Б—Б–Њ—А–∞—Е, –і–µ–Љ–Њ–љ—Б—В—А–Є—А—Г—П –Ј–љ–∞—З–Є—В–µ–ї—М–љ–Њ–µ —Б–Њ–Ї—А–∞—Й–µ–љ–Є–µ –≤—А–µ–Љ–µ–љ–Є –≤—Л—З–Є—Б–ї–µ–љ–Є–є –њ—А–Є —А–∞—Б–њ–∞—А–∞–ї–ї–µ–ї–Є–≤–∞–љ–Є–Є. –Ю—Б–љ–Њ–≤–љ–Њ–µ –≤–љ–Є–Љ–∞–љ–Є–µ —Г–і–µ–ї—П–µ—В—Б—П —Н—Д—Д–µ–Ї—В–Є–≤–љ–Њ—Б—В–Є –∞–ї–≥–Њ—А–Є—В–Љ–Њ–≤ –љ–∞—Б—В—А–Њ–є–Ї–Є –њ–∞—А–∞–Љ–µ—В—А–Њ–≤ —Б–µ—В–Є –Є –µ–Ї—Б–њ–µ—А–Є–Љ–µ–љ—В–∞–ї—М–љ—Л–Љ –і–∞–љ–љ—Л–Љ, –њ–Њ–і—В–≤–µ—А–ґ–і–∞—О—Й–Є–Љ –њ—А–µ–Є–Љ—Г—Й–µ—Б—В–≤–Њ GPU –≤ –≤—Л—З–Є—Б–ї–µ–љ–Є—П—Е.–Ы–µ–Ї—Ж–Є—П вДЦ11 "–Ю—Б–љ–Њ–≤—Л –љ–µ–є—А–Њ–љ–љ—Л—Е —Б–µ—В–µ–є"

–Ы–µ–Ї—Ж–Є—П вДЦ11 "–Ю—Б–љ–Њ–≤—Л –љ–µ–є—А–Њ–љ–љ—Л—Е —Б–µ—В–µ–є" Technosphere1

ћэ

–Ы–µ–Ї—Ж–Є—П –Њ—Е–≤–∞—В—Л–≤–∞–µ—В –Њ—Б–љ–Њ–≤—Л –љ–µ–є—А–Њ–љ–љ—Л—Е —Б–µ—В–µ–є, –≤–Ї–ї—О—З–∞—П –Є—Б—В–Њ—А–Є—О –Є—Е —В–µ–Њ—А–Є–Є –Є –Ї–ї—О—З–µ–≤—Л–µ –Ї–Њ–љ—Ж–µ–њ—Ж–Є–Є, —В–∞–Ї–Є–µ –Ї–∞–Ї –Љ–љ–Њ–≥–Њ—Б–ї–Њ–є–љ—Л–µ –љ–µ–є—А–Њ–љ–љ—Л–µ —Б–µ—В–Є –Є –∞–ї–≥–Њ—А–Є—В–Љ—Л –Њ–±—А–∞—В–љ–Њ–≥–Њ —А–∞—Б–њ—А–Њ—Б—В—А–∞–љ–µ–љ–Є—П –Њ—И–Є–±–Ї–Є. –Ю–±—Б—Г–ґ–і–∞—О—В—Б—П —А–∞–Ј–ї–Є—З–љ—Л–µ –Љ–Њ–і–µ–ї–Є –љ–µ–є—А–Њ–љ–Њ–≤ –Є –Ї–ї–∞—Б—Б—Л –∞–ї–≥–Њ—А–Є—В–Љ–Њ–≤, –∞ —В–∞–Ї–ґ–µ –≤–µ–Ї—В–Њ—А–љ—Л–µ –њ—А–µ–і—Б—В–∞–≤–ї–µ–љ–Є—П –Є –Љ–µ—Е–∞–љ–Є–Ј–Љ—Л –Њ–±—Г—З–µ–љ–Є—П, –≤–Ї–ї—О—З–∞—П –њ—А–∞–≤–Є–ї–∞ –•–µ–±–±–∞. –Ы–µ–Ї—Ж–Є—П —В–∞–Ї–ґ–µ –Њ—Б–≤–µ—Й–∞–µ—В –і–Њ—Б—В–Є–ґ–µ–љ–Є—П –≤ –љ–µ–є—А–Њ–±–Є–Њ–ї–Њ–≥–Є–Є –Є —Б—А–∞–≤–љ–Є–≤–∞–µ—В —А–∞–±–Њ—В—Г –Љ–Њ–Ј–≥–∞ —Б —Б–Њ–≤—А–µ–Љ–µ–љ–љ—Л–Љ–Є –Ї–Њ–Љ–њ—М—О—В–µ—А–љ—Л–Љ–Є —Б–Є—Б—В–µ–Љ–∞–Љ–Є.–Т–≤–µ–і–µ–љ–Є–µ –≤ Deep Learning

–Т–≤–µ–і–µ–љ–Є–µ –≤ Deep LearningGrigory Sapunov

ћэ

–Ф–Њ–Ї—Г–Љ–µ–љ—В —А–∞—Б—Б–Љ–∞—В—А–Є–≤–∞–µ—В —А–∞–Ј–ї–Є—З–Є—П –Є —Б—Е–Њ–і—Б—В–≤–∞ –Љ–µ–ґ–і—Г –≥–ї—Г–±–Њ–Ї–Є–Љ –Њ–±—Г—З–µ–љ–Є–µ–Љ –Є –Љ–∞—И–Є–љ–љ—Л–Љ –Њ–±—Г—З–µ–љ–Є–µ–Љ, –∞ —В–∞–Ї–ґ–µ –Њ—Б–≤–µ—Й–∞–µ—В —В—А–µ–љ–і—Л, —В–∞–Ї–Є–µ –Ї–∞–Ї —А–Њ—Б—В —В–Њ—З–љ–Њ—Б—В–Є –Є —Б–ї–Њ–ґ–љ–Њ—Б—В–Є –љ–µ–є—А–Њ—Б–µ—В–µ–є –Є —Г–≤–µ–ї–Є—З–µ–љ–Є–µ –Њ–±—К–µ–Љ–Њ–≤ –і–∞–љ–љ—Л—Е. –У–ї—Г–±–Њ–Ї–Є–µ –љ–µ–є—А–Њ—Б–µ—В–Є, –≤ —В–Њ–Љ —З–Є—Б–ї–µ —Б–≤–µ—А—В–Њ—З–љ—Л–µ –Є –њ–Њ–ї–љ–Њ—Б–≤—П–Ј–љ—Л–µ, –Њ–њ–Є—Б—Л–≤–∞—О—В—Б—П —Б –∞–Ї—Ж–µ–љ—В–Њ–Љ –љ–∞ –Є—Е —Б—В—А—Г–Ї—В—Г—А—Г, —Д—Г–љ–Ї—Ж–Є–Є –∞–Ї—В–Є–≤–∞—Ж–Є–Є, –Љ–µ—Е–∞–љ–Є–Ј–Љ—Л –Њ–±—Г—З–µ–љ–Є—П –Є –∞–ї–≥–Њ—А–Є—В–Љ—Л –Њ–њ—В–Є–Љ–Є–Ј–∞—Ж–Є–Є, —В–∞–Ї–Є–µ –Ї–∞–Ї –≥—А–∞–і–Є–µ–љ—В–љ—Л–є —Б–њ—Г—Б–Ї –Є –Њ–±—А–∞—В–љ–Њ–µ —А–∞—Б–њ—А–Њ—Б—В—А–∞–љ–µ–љ–Є–µ –Њ—И–Є–±–Ї–Є. –Ґ–∞–Ї–ґ–µ –Њ–±—Б—Г–ґ–і–∞—О—В—Б—П —А–∞–Ј–ї–Є—З–љ—Л–µ –∞—А—Е–Є—В–µ–Ї—В—Г—А—Л –Є –∞–ї–≥–Њ—А–Є—В–Љ—Л, –≤–Ї–ї—О—З–∞—П –∞–≤—В–Њ—Н–љ–Ї–Њ–і–µ—А—Л –Є –Њ–≥—А–∞–љ–Є—З–µ–љ–љ—Л–µ –±–Њ–ї—Ж–Љ–∞–љ–Њ–≤—Б–Ї–Є–µ –Љ–∞—И–Є–љ—Л.–Ы–µ–Ї—Ж–Є—П 2

–Ы–µ–Ї—Ж–Є—П 2Ivan Stolyarov

ћэ

–Ф–Њ–Ї—Г–Љ–µ–љ—В –Њ–њ–Є—Б—Л–≤–∞–µ—В –њ—А–Є–љ—Ж–Є–њ—Л —А–∞–±–Њ—В—Л –Њ–і–љ–Њ—Б–ї–Њ–є–љ—Л—Е –љ–µ–є—А–Њ–љ–љ—Л—Е —Б–µ—В–µ–є (–Э–°), –≤–Ї–ї—О—З–∞—П —Б—В—А—Г–Ї—В—Г—А—Г –љ–µ–є—А–Њ–љ–∞, –∞–Ї—В–Є–≤–∞—Ж–Є–Њ–љ–љ—Л–µ —Д—Г–љ–Ї—Ж–Є–Є, —В–∞–Ї–Є–µ –Ї–∞–Ї —Б–Є–≥–Љ–Њ–Є–і–∞ –Є –≥–Є–њ–µ—А–±–Њ–ї–Є—З–µ—Б–Ї–Є–є —В–∞–љ–≥–µ–љ—Б, –∞ —В–∞–Ї–ґ–µ –∞–ї–≥–Њ—А–Є—В–Љ—Л –Њ–±—Г—З–µ–љ–Є—П, –Њ—Б–љ–Њ–≤–∞–љ–љ—Л–µ –љ–∞ –Ї–Њ—А—А–µ–Ї—Ж–Є–Є –≤–µ—Б–Њ–≤ —Б–Є–љ–∞–њ—В–Є—З–µ—Б–Ї–Є—Е —Б–≤—П–Ј–µ–є. –†–∞—Б—Б–Љ–∞—В—А–Є–≤–∞—О—В—Б—П –њ—А–Њ–±–ї–µ–Љ—Л, –≤–Њ–Ј–љ–Є–Ї–∞—О—Й–Є–µ –љ–∞ —Н—В–∞–њ–µ –Њ–±—Г—З–µ–љ–Є—П, —В–∞–Ї–Є–µ –Ї–∞–Ї –≤—Л–±–Њ—А –∞–ї–≥–Њ—А–Є—В–Љ–∞ –Є –љ–∞—З–∞–ї—М–љ–∞—П –Є–љ–Є—Ж–Є–∞–ї–Є–Ј–∞—Ж–Є—П –≤–µ—Б–Њ–≤, –∞ —В–∞–Ї–ґ–µ –Ј–∞–і–∞—З–∞ –Ї–ї–∞—Б—Б–Є—Д–Є–Ї–∞—Ж–Є–Є —Б –њ–Њ–Љ–Њ—Й—М—О –Њ–і–љ–Њ—Б–ї–Њ–є–љ–Њ–≥–Њ –њ–µ—А—Б–µ–њ—В—А–Њ–љ–∞. –Ф–Њ–Ї—Г–Љ–µ–љ—В —В–∞–Ї–ґ–µ –Ј–∞—В—А–∞–≥–Є–≤–∞–µ—В –Љ–µ—В–Њ–і—Л –Љ–Є–љ–Є–Љ–Є–Ј–∞—Ж–Є–Є –Њ—И–Є–±–Ї–Є –Є –Ї—А–Є—В–µ—А–Є–Є –Њ–Ї–Њ–љ—З–∞–љ–Є—П –Њ–±—Г—З–µ–љ–Є—П, –≤–Ї–ї—О—З–∞—П –њ–µ—А–µ–Њ–±—Г—З–µ–љ–Є–µ.–Ш–ї—М—П –Ґ—А–Њ—Д–Є–Љ–Њ–≤ - –Љ–∞—И–Є–љ–љ–Њ–µ –Њ–±—Г—З–µ–љ–Є–µ —Б –њ–Њ–Љ–Њ—Й—М—О vw

–Ш–ї—М—П –Ґ—А–Њ—Д–Є–Љ–Њ–≤ - –Љ–∞—И–Є–љ–љ–Њ–µ –Њ–±—Г—З–µ–љ–Є–µ —Б –њ–Њ–Љ–Њ—Й—М—О vwPavel Mezentsev

ћэ

–Ф–Њ–Ї—Г–Љ–µ–љ—В –Њ–њ–Є—Б—Л–≤–∞–µ—В –њ—А–Њ–µ–Ї—В Vowpal Wabbit, –Ї–Њ—В–Њ—А—Л–є –њ—А–µ–і—Б—В–∞–≤–ї—П–µ—В —Б–Њ–±–Њ–є –±—Л—Б—В—А–Њ–µ –Њ–±—Г—З–µ–љ–Є–µ –ї–Є–љ–µ–є–љ—Л—Е —Д—Г–љ–Ї—Ж–Є–є, —А–∞–Ј—А–∞–±–Њ—В–∞–љ–љ–Њ–µ –≤ Yahoo Research –Є —Б–µ–є—З–∞—Б –њ–Њ–і–і–µ—А–ґ–Є–≤–∞–µ–Љ–Њ–µ Microsoft Research. –Ю–љ –њ–Њ–і–і–µ—А–ґ–Є–≤–∞–µ—В –Љ–љ–Њ–ґ–µ—Б—В–≤–Њ –Љ–µ—В–Њ–і–Њ–≤ –Њ–њ—В–Є–Љ–Є–Ј–∞—Ж–Є–Є –Є –Њ–±—Г—З–µ–љ–Є–µ –љ–∞ —А–∞—Б–њ—А–µ–і–µ–ї–µ–љ–љ—Л—Е —Б–Є—Б—В–µ–Љ–∞—Е, —В–∞–Ї–Є—Е –Ї–∞–Ї Hadoop, –±–µ–Ј –љ–µ–Њ–±—Е–Њ–і–Є–Љ–Њ—Б—В–Є –≤ –Ї–ї–∞—Б—В–µ—А–µ. –Я—А–Њ–µ–Ї—В —П–≤–ї—П–µ—В—Б—П –Њ—В–Ї—А—Л—В—Л–Љ –Є—Б—Е–Њ–і–љ—Л–Љ –Ї–Њ–і–Њ–Љ –Є –њ—А–µ–і–ї–∞–≥–∞–µ—В –њ–ї–∞—В—Д–Њ—А–Љ—Г –і–ї—П –Є—Б—Б–ї–µ–і–Њ–≤–∞–љ–Є–є –≤ –Њ–±–ї–∞—Б—В–Є –Љ–∞—И–Є–љ–љ–Њ–≥–Њ –Њ–±—Г—З–µ–љ–Є—П.2012.11.06 –Љ–∞—И–Є–љ–љ–Њ–µ –Њ–±—Г—З–µ–љ–Є–µ —Б –њ–Њ–Љ–Њ—Й—М—О vw

2012.11.06 –Љ–∞—И–Є–љ–љ–Њ–µ –Њ–±—Г—З–µ–љ–Є–µ —Б –њ–Њ–Љ–Њ—Й—М—О vw–Ш–ї—М—П –Ґ—А–Њ—Д–Є–Љ–Њ–≤

ћэ

–Ф–Њ–Ї—Г–Љ–µ–љ—В –Њ–њ–Є—Б—Л–≤–∞–µ—В –њ—А–Њ–µ–Ї—В Vowpal Wabbit, –ї–Є–љ–µ–є–љ—Г—О –Њ–±—Г—З–∞—О—Й—Г—О —Б–Є—Б—В–µ–Љ—Г —Б –Њ—В–Ї—А—Л—В—Л–Љ –Є—Б—Е–Њ–і–љ—Л–Љ –Ї–Њ–і–Њ–Љ, —А–∞–Ј—А–∞–±–Њ—В–∞–љ–љ—Г—О –і–ї—П –Њ–±—А–∞–±–Њ—В–Ї–Є –±–Њ–ї—М—И–Є—Е –і–∞–љ–љ—Л—Е –Є –Њ–њ—В–Є–Љ–Є–Ј–∞—Ж–Є–Є –∞–ї–≥–Њ—А–Є—В–Љ–Њ–≤ –Њ–±—Г—З–µ–љ–Є—П. –Я—А–Њ–≥—А–∞–Љ–Љ–∞ –њ–Њ–і–і–µ—А–ґ–Є–≤–∞–µ—В –Љ–љ–Њ–ґ–µ—Б—В–≤–Њ —Д—Г–љ–Ї—Ж–Є–є –њ–Њ—В–µ—А—М –Є –Љ–µ—В–Њ–і–Њ–≤ –Њ–њ—В–Є–Љ–Є–Ј–∞—Ж–Є–Є, —В–∞–Ї–Є—Е –Ї–∞–Ї SGD –Є L-BFGS, –Є –љ–µ —В—А–µ–±—Г–µ—В –і–ї—П —А–∞–±–Њ—В—Л Hadoop-–Ї–ї–∞—Б—В–µ—А–∞, —Е–Њ—В—П –Љ–Њ–ґ–µ—В –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞—В—М –µ–≥–Њ –і–ї—П —А–∞—Б–њ—А–µ–і–µ–ї–µ–љ–љ–Њ–≥–Њ –Њ–±—Г—З–µ–љ–Є—П. –≠—В–Њ —А–µ—И–µ–љ–Є–µ –њ–Њ–і—Е–Њ–і–Є—В –і–ї—П –Ј–∞–і–∞—З, —Б–≤—П–Ј–∞–љ–љ—Л—Е —Б –∞–љ–∞–ї–Є–Ј–Њ–Љ –њ–Њ–ї—М–Ј–Њ–≤–∞—В–µ–ї—М—Б–Ї–Є—Е –ї–Њ–≥–Њ–≤ –Є –њ—А–µ–і—Б–Ї–∞–Ј–∞–љ–Є–µ–Љ —А–µ–Ј—Г–ї—М—В–∞—В–Њ–≤ –≤ —А–∞–Ј–ї–Є—З–љ—Л—Е –Њ–±–ї–∞—Б—В—П—Е, –≤–Ї–ї—О—З–∞—П —А–µ–Ї–ї–∞–Љ—Г –Є –≥–µ–љ–µ—В–Є–Ї—Г.–Ы–µ–Ї—Ж–Є—П 5

–Ы–µ–Ї—Ж–Є—П 5Ivan Stolyarov

ћэ

–Ф–Њ–Ї—Г–Љ–µ–љ—В —Б–Њ–і–µ—А–ґ–Є—В —А–µ–Ї–Њ–Љ–µ–љ–і–∞—Ж–Є–Є –њ–Њ –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞–љ–Є—О –∞–ї–≥–Њ—А–Є—В–Љ–∞ –Њ–±—А–∞—В–љ–Њ–≥–Њ —А–∞—Б–њ—А–Њ—Б—В—А–∞–љ–µ–љ–Є—П –Њ—И–Є–±–Ї–Є –≤ –Њ–±—Г—З–µ–љ–Є–Є –љ–µ–є—А–Њ–љ–љ—Л—Е —Б–µ—В–µ–є, –Њ–њ–Є—Б—Л–≤–∞—П —А–µ–ґ–Є–Љ—Л –Њ–±—Г—З–µ–љ–Є—П, —В–∞–Ї–Є–µ –Ї–∞–Ї –њ–Њ—Б–ї–µ–і–Њ–≤–∞—В–µ–ї—М–љ—Л–є –Є –њ–∞–Ї–µ—В–љ—Л–є. –†–∞—Б—Б–Љ–∞—В—А–Є–≤–∞—О—В—Б—П –∞—Б–њ–µ–Ї—В—Л –Њ–њ—В–Є–Љ–Є–Ј–∞—Ж–Є–Є –≤—Л–±–Њ—А–Ї–Є –і–∞–љ–љ—Л—Е, –≤–Ї–ї—О—З–∞—П –њ–µ—А–µ–Ї—А–µ—Б—В–љ—Г—О –њ—А–Њ–≤–µ—А–Ї—Г, —А–∞–љ–љ—О—О –Њ—Б—В–∞–љ–Њ–≤–Ї—Г –Є –Є–љ–Є—Ж–Є–∞–ї–Є–Ј–∞—Ж–Є—О –≤–µ—Б–Њ–≤. –Ґ–∞–Ї–ґ–µ —Г–њ–Њ–Љ–Є–љ–∞–µ—В—Б—П –≤–∞–ґ–љ–Њ—Б—В—М –љ–Њ—А–Љ–Є—А–Њ–≤–Ї–Є –≤—Е–Њ–і–Њ–≤ –Є –≤—Л–±–Њ—А–∞ —Ж–µ–ї–µ–≤—Л—Е –Ј–љ–∞—З–µ–љ–Є–є –і–ї—П –њ—А–∞–≤–Є–ї—М–љ–Њ–є —А–∞–±–Њ—В—Л —Д—Г–љ–Ї—Ж–Є–є –∞–Ї—В–Є–≤–∞—Ж–Є–Є.NVIDIA Deep Learning.

NVIDIA Deep Learning. Skolkovo Robotics Center

ћэ

–Ф–Љ–Є—В—А–Є–є –Ъ–Њ—А–Њ–±—З–µ–љ–Ї–Њ, –Є–љ–ґ–µ–љ–µ—А –≤ –Њ–±–ї–∞—Б—В–Є –≥–ї—Г–±–Њ–Ї–Њ–≥–Њ –Њ–±—Г—З–µ–љ–Є—П –≤ NVIDIA, –Њ–њ–Є—Б—Л–≤–∞–µ—В –Љ–µ—В–Њ–і—Л –Є –∞—А—Е–Є—В–µ–Ї—В—Г—А—Л –≥–ї—Г–±–Њ–Ї–Є—Е –љ–µ–є—А–Њ–љ–љ—Л—Е —Б–µ—В–µ–є, –≤–Ї–ї—О—З–∞—П –Њ–±—Г—З–µ–љ–Є–µ —Б —Г—З–Є—В–µ–ї–µ–Љ –Є –±–µ–Ј —Г—З–Є—В–µ–ї—П. –Ю—Б–љ–Њ–≤–љ—Л–µ —В–µ–Љ—Л –≤–Ї–ї—О—З–∞—О—В –≥—А–∞–і–Є–µ–љ—В–љ—Л–є —Б–њ—Г—Б–Ї, —Б–≤—С—А—В–Њ—З–љ—Л–µ –љ–µ–є—А–Њ–љ–љ—Л–µ —Б–µ—В–Є, —А–µ–Ї—Г—А—А–µ–љ—В–љ—Л–µ –љ–µ–є—А–Њ–љ–љ—Л–µ —Б–µ—В–Є –Є –Є—Е –њ—А–Є–Љ–µ–љ–µ–љ–Є–µ –≤ –Ј–∞–і–∞—З–∞—Е –Ї–Њ–Љ–њ—М—О—В–µ—А–љ–Њ–≥–Њ –Ј—А–µ–љ–Є—П –Є –Њ–±—А–∞–±–Њ—В–Ї–Є –µ—Б—В–µ—Б—В–≤–µ–љ–љ–Њ–≥–Њ —П–Ј—Л–Ї–∞. –Ф–Њ–Ї—Г–Љ–µ–љ—В —В–∞–Ї–ґ–µ –Ј–∞—В—А–∞–≥–Є–≤–∞–µ—В —Б–ї–Њ–ґ–љ–Њ—Б—В–Є –Њ–±—А–∞–±–Њ—В–Ї–Є –љ–µ—Б—В—А—Г–Ї—В—Г—А–Є—А–Њ–≤–∞–љ–љ—Л—Е –і–∞–љ–љ—Л—Е –Є —Б–Њ–≤—А–µ–Љ–µ–љ–љ—Л–µ –њ—А–Є–ї–Њ–ґ–µ–љ–Є—П –≥–ї—Г–±–Њ–Ї–Њ–≥–Њ –Њ–±—Г—З–µ–љ–Є—П –≤ —А–∞–Ј–ї–Є—З–љ—Л—Е –Њ–±–ї–∞—Б—В—П—Е.–Ы–µ–Ї—Ж–Є—П 9

–Ы–µ–Ї—Ж–Є—П 9Ivan Stolyarov

ћэ

–Ф–Њ–Ї—Г–Љ–µ–љ—В –Њ–њ–Є—Б—Л–≤–∞–µ—В –Ї–Њ–љ—Ж–µ–њ—Ж–Є—О –Є–Ј–≤–ї–µ—З–µ–љ–Є—П –Ј–љ–∞–љ–Є–є (data mining) –Є–Ј –љ–µ–є—А–Њ–љ–љ—Л—Е —Б–µ—В–µ–є, –∞–Ї—Ж–µ–љ—В–Є—А—Г—П –≤–љ–Є–Љ–∞–љ–Є–µ –љ–∞ –њ–Њ–Є—Б–Ї –Ј–∞–Ї–Њ–љ–Њ–Љ–µ—А–љ–Њ—Б—В–µ–є –Є –≤–Ј–∞–Є–Љ–Њ—Б–≤—П–Ј–µ–є –≤ –±–Њ–ї—М—И–Є—Е –Њ–±—К–µ–Љ–∞—Е –і–∞–љ–љ—Л—Е. –Ю–љ –і–µ–ї–Є—В –Ј–∞–і–∞—З–Є data mining –љ–∞ –і–≤–µ –Ї–∞—В–µ–≥–Њ—А–Є–Є: —А–∞–Ј—А–∞–±–Њ—В–Ї—Г –њ—А–Є–ї–Њ–ґ–µ–љ–Є–є –і–ї—П –љ–µ–є—А–Њ–љ–љ—Л—Е —Б–µ—В–µ–є –Є –њ–Њ–і–і–µ—А–ґ–Ї—Г –њ—А–Є–љ—П—В–Є—П —А–µ—И–µ–љ–Є–є, –≤–Ї–ї—О—З–∞—П –Њ–±—Г—З–µ–љ–Є–µ –Є –Є–Ј–≤–ї–µ—З–µ–љ–Є–µ –Љ–Њ–і–µ–ї–Є. –Ґ–∞–Ї–ґ–µ —А–∞—Б—Б–Љ–∞—В—А–Є–≤–∞—О—В—Б—П —А–∞–Ј–ї–Є—З–љ—Л–µ –њ–Њ–і—Е–Њ–і—Л –Ї –Є–Ј–≤–ї–µ—З–µ–љ–Є—О –Ј–љ–∞–љ–Є–є, —В–∞–Ї–Є–µ –Ї–∞–Ї –∞–љ–∞–ї–Є–Ј —А–µ–∞–Ї—Ж–Є–Є —Б–µ—В–Є, –≤–Є–Ј—Г–∞–ї–Є–Ј–∞—Ж–Є—П –Є –њ–Њ—Б—В—А–Њ–µ–љ–Є–µ –њ—А–∞–≤–Є–ї –Ї–ї–∞—Б—Б–Є—Д–Є–Ї–∞—Ж–Є–Є —Б –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞–љ–Є–µ–Љ –∞–ї–≥–Њ—А–Є—В–Љ–Њ–≤.–Ы–µ–Ї—Ж–Є—П 8

–Ы–µ–Ї—Ж–Є—П 8Ivan Stolyarov

ћэ

–Ф–Њ–Ї—Г–Љ–µ–љ—В –Њ–±—Б—Г–ґ–і–∞–µ—В –њ—А–Є–Љ–µ–љ–µ–љ–Є–µ –љ–µ–є—А–Њ–љ–љ—Л—Е —Б–µ—В–µ–є (–Э–°) –і–ї—П –Ј–∞–і–∞—З –Ї–ї–∞—Б—Б–Є—Д–Є–Ї–∞—Ж–Є–Є –Њ–±—А–∞–Ј–Њ–≤, –≤–Ї–ї—О—З–∞—П —А–∞—Б–њ–Њ–Ј–љ–∞–≤–∞–љ–Є–µ –ї–Є—Ж –Є –і—А—Г–≥–Є–µ –њ—А–Є–Љ–µ—А—Л, —В–∞–Ї–Є–µ –Ї–∞–Ї –Љ–µ–і–Є—Ж–Є–љ—Б–Ї–Є–µ –Є–Ј–Њ–±—А–∞–ґ–µ–љ–Є—П –Є –Є–і–µ–љ—В–Є—Д–Є–Ї–∞—Ж–Є—П –ї–Є—З–љ–Њ—Б—В–Є. –†–∞—Б—Б–Љ–∞—В—А–Є–≤–∞—О—В—Б—П –њ—А–µ–Є–Љ—Г—Й–µ—Б—В–≤–∞ –Є –љ–µ–і–Њ—Б—В–∞—В–Ї–Є –Э–°, –Є—Е –∞–і–∞–њ—В–Є–≤–љ–Њ—Б—В—М –Є –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ—Б—В—М —В–Њ—З–љ–Њ–є –∞–њ–њ—А–Њ–Ї—Б–Є–Љ–∞—Ж–Є–Є, –∞ —В–∞–Ї–ґ–µ –њ—А–Њ–±–ї–µ–Љ—Л —Б–Њ–Ј–і–∞–љ–Є—П –Њ–±—Г—З–∞—О—Й–Є—Е –≤—Л–±–Њ—А–Њ–Ї. –Т–љ–µ–і—А—П—О—В—Б—П —А–∞–Ј–ї–Є—З–љ—Л–µ –∞—А—Е–Є—В–µ–Ї—В—Г—А—Л –љ–µ–є—А–Њ–љ–љ—Л—Е —Б–µ—В–µ–є, –≤–Ї–ї—О—З–∞—П —Б—В—А—Г–Ї—В—Г—А—Л, –Є–љ–≤–∞—А–Є–∞–љ—В–љ—Л–µ –Ї –≤—А–∞—Й–µ–љ–Є—О, –Є —Б–≤–µ—А—В–Њ—З–љ—Л–µ —Б–µ—В–Є, —Б –≤—Л–≤–Њ–і–∞–Љ–Є –Њ–± –Є—Е —Н—Д—Д–µ–Ї—В–Є–≤–љ–Њ—Б—В–Є –њ—А–Є –і–µ—В–µ–Ї—В–Є—А–Њ–≤–∞–љ–Є–Є –ї–Є—Ж –Є –і—А—Г–≥–Є—Е –Ј–∞–і–∞—З–∞—Е.–Ы–µ–Ї—Ж–Є—П 7

–Ы–µ–Ї—Ж–Є—П 7Ivan Stolyarov

ћэ

–Ф–Њ–Ї—Г–Љ–µ–љ—В –Њ–±—Б—Г–ґ–і–∞–µ—В —Б–µ—В—М –Ъ–Њ—Е–Њ–љ–µ–љ–∞, —Б–Њ—Б—А–µ–і–Њ—В–∞—З–Є–≤–∞—П—Б—М –љ–∞ —Б–∞–Љ–Њ–Њ—А–≥–∞–љ–Є–Ј–∞—Ж–Є–Є –Є –Є–Ј–Љ–µ–љ–µ–љ–Є–Є –≤–µ—Б–Њ–≤ –њ–Њ –њ—А–∞–≤–Є–ї—Г –Ъ–Њ—Е–Њ–љ–µ–љ–∞, –∞ —В–∞–Ї–ґ–µ –Љ–µ—В–Њ–і–∞—Е –љ–Њ—А–Љ–∞–ї–Є–Ј–∞—Ж–Є–Є –Є —А–µ—И–µ–љ–Є—П –њ—А–Њ–±–ї–µ–Љ—Л –Љ–µ—А—В–≤—Л—Е –љ–µ–є—А–Њ–љ–Њ–≤. –Ю–±—Б—Г–ґ–і–∞—О—В—Б—П –∞–ї–≥–Њ—А–Є—В–Љ—Л –Њ–±—Г—З–µ–љ–Є—П, –Є—Е —Б—А–∞–≤–љ–µ–љ–Є–µ –Є –њ—А–Є–Љ–µ–љ–µ–љ–Є–µ —Б–µ—В–Є –і–ї—П –Ї–Њ–Љ–њ—А–µ—Б—Б–Є–Є –і–∞–љ–љ—Л—Е, –і–Є–∞–≥–љ–Њ—Б—В–Є–Ї–Є –љ–µ–Є—Б–њ—А–∞–≤–љ–Њ—Б—В–µ–є –Є –≤–Є–Ј—Г–∞–ї–Є–Ј–∞—Ж–Є–Є –Љ–љ–Њ–≥–Њ–Љ–µ—А–љ–Њ–є –Є–љ—Д–Њ—А–Љ–∞—Ж–Є–Є. –Т –Ј–∞–Ї–ї—О—З–µ–љ–Є–µ –њ—А–Є–≤–Њ–і—П—В—Б—П –і–Њ—Б—В–Њ–Є–љ—Б—В–≤–∞ –Є –љ–µ–і–Њ—Б—В–∞—В–Ї–Є —Б–µ—В–Є –Ъ–Њ—Е–Њ–љ–µ–љ–∞.–Ы–µ–Ї—Ж–Є—П 4

–Ы–µ–Ї—Ж–Є—П 4Ivan Stolyarov

ћэ

–Ф–Њ–Ї—Г–Љ–µ–љ—В –њ—А–µ–і—Б—В–∞–≤–ї—П–µ—В –ї–µ–Ї—Ж–Є—О –њ–Њ –∞–ї–≥–Њ—А–Є—В–Љ—Г –Њ–±—А–∞—В–љ–Њ–≥–Њ —А–∞—Б–њ—А–Њ—Б—В—А–∞–љ–µ–љ–Є—П –Њ—И–Є–±–Ї–Є –≤ –љ–µ–є—А–Њ–љ–љ—Л—Е —Б–µ—В—П—Е –Є —А–∞–Ј–ї–Є—З–љ—Л–Љ –Љ–µ—В–Њ–і–∞–Љ –Њ–±—Г—З–µ–љ–Є—П, –≤–Ї–ї—О—З–∞—П –Њ–±—Г—З–µ–љ–Є–µ —Б —Г—З–Є—В–µ–ї–µ–Љ –Є –±–µ–Ј —Г—З–Є—В–µ–ї—П. –Ю–њ–Є—Б—Л–≤–∞—О—В—Б—П –Њ—Б–љ–Њ–≤–љ—Л–µ —И–∞–≥–Є –∞–ї–≥–Њ—А–Є—В–Љ–∞, –њ—А–Њ–±–ї–µ–Љ—Л, —В–∞–Ї–Є–µ –Ї–∞–Ї –њ–∞—А–∞–ї–Є—З —Б–µ—В–Є –Є –ї–Њ–Ї–∞–ї—М–љ—Л–µ –Љ–Є–љ–Є–Љ—Г–Љ—Л, –∞ —В–∞–Ї–ґ–µ –Љ–µ—В–Њ–і—Л –Њ–њ—В–Є–Љ–Є–Ј–∞—Ж–Є–Є, —В–∞–Ї–Є–µ –Ї–∞–Ї –≥—А–∞–і–Є–µ–љ—В–љ—Л–є —Б–њ—Г—Б–Ї –Є –Є–Љ–Є—В–∞—Ж–Є—П –Њ—В–ґ–Є–≥–∞. –Ы–µ–Ї—Ж–Є—П –Њ—Е–≤–∞—В—Л–≤–∞–µ—В —В–∞–Ї–ґ–µ —В–µ—Е–љ–Є–Ї–Є, –љ–∞–њ—А–∞–≤–ї–µ–љ–љ—Л–µ –љ–∞ —Г–ї—Г—З—И–µ–љ–Є–µ —Б—Е–Њ–і–Є–Љ–Њ—Б—В–Є –Є —Г–Љ–µ–љ—М—И–µ–љ–Є–µ —А–Є—Б–Ї–∞ –њ–µ—А–µ–Њ–±—Г—З–µ–љ–Є—П.–Ы–µ–Ї—Ж–Є—П 3

–Ы–µ–Ї—Ж–Є—П 3Ivan Stolyarov

ћэ

–Ф–Њ–Ї—Г–Љ–µ–љ—В —А–∞—Б—Б–Љ–∞—В—А–Є–≤–∞–µ—В –њ—А–Њ–±–ї–µ–Љ—Л –њ–Њ—Б—В—А–Њ–µ–љ–Є—П –љ–µ–є—А–Њ–љ–љ—Л—Е —Б–µ—В–µ–є, –≤ —З–∞—Б—В–љ–Њ—Б—В–Є, –Њ–і–љ–Њ—Б–ї–Њ–є–љ—Л—Е –њ–µ—А—Б–µ–њ—В—А–Њ–љ–Њ–≤ –і–ї—П —А–µ—И–µ–љ–Є—П –Ј–∞–і–∞—З–Є '–Є—Б–Ї–ї—О—З–∞—О—Й–µ–≥–Њ –Є–ї–Є' (XOR), —Г—В–≤–µ—А–ґ–і–∞—П, —З—В–Њ —В–∞–Ї–Є–µ —Б–µ—В–Є –љ–µ –Љ–Њ–≥—Г—В —А–µ–∞–ї–Є–Ј–Њ–≤–∞—В—М —Н—В—Г —Д—Г–љ–Ї—Ж–Є—О –±–µ–Ј –њ—А–µ–і–Њ–±—А–∞–±–Њ—В–Ї–Є –і–∞–љ–љ—Л—Е. –Ґ–∞–Ї–ґ–µ –Њ–±—Б—Г–ґ–і–∞—О—В—Б—П –Љ–љ–Њ–≥–Њ—Б–ї–Њ–є–љ—Л–µ –њ–µ—А—Б–µ–њ—В—А–Њ–љ—Л –Є –Є—Е –њ—А–µ–Є–Љ—Г—Й–µ—Б—В–≤–∞ –≤ —Г–≤–µ–ї–Є—З–µ–љ–Є–Є —В–Њ—З–љ–Њ—Б—В–Є —А–∞–Ј–і–µ–ї–µ–љ–Є—П –Њ–±—А–∞–Ј–Њ–≤ –Ј–∞ —Б—З–µ—В –і–Њ–±–∞–≤–ї–µ–љ–Є—П –љ–µ–є—А–Њ–љ–Њ–≤ –Є —Б–ї–Њ–µ–≤, –∞ —В–∞–Ї–ґ–µ —В–µ–Њ—А–µ–Љ—Л –Њ–± —Г–љ–Є–≤–µ—А—Б–∞–ї—М–љ–Њ–є –∞–њ–њ—А–Њ–Ї—Б–Є–Љ–∞—Ж–Є–Є, –њ–Њ–і—З–µ—А–Ї–Є–≤–∞—О—Й–Є–µ —Б–њ–Њ—Б–Њ–±–љ–Њ—Б—В—М –Љ–љ–Њ–≥–Њ—Б–ї–Њ–є–љ—Л—Е —Б–µ—В–µ–є –∞–њ–њ—А–Њ–Ї—Б–Є–Љ–Є—А–Њ–≤–∞—В—М –ї—О–±—Л–µ —Д—Г–љ–Ї—Ж–Є–Є. –Т –≤—Л–≤–Њ–і–∞—Е –њ–Њ–і—З–µ—А–Ї–Є–≤–∞–µ—В—Б—П –≤–∞–ґ–љ–Њ—Б—В—М –∞—А—Е–Є—В–µ–Ї—В—Г—А—Л –љ–µ–є—А–Њ–љ–љ–Њ–є —Б–µ—В–Є –і–ї—П –µ–µ —Д—Г–љ–Ї—Ж–Є–Њ–љ–∞–ї—М–љ–Њ—Б—В–Є –Є –Ї–ї–∞—Б—Б–Є—Д–Є–Ї–∞—Ж–Є–Є –Њ–±—А–∞–Ј–Њ–≤.–Ы–µ–Ї—Ж–Є—П 1

–Ы–µ–Ї—Ж–Є—П 1Ivan Stolyarov

ћэ

–Ы–µ–Ї—Ж–Є—П –њ–Њ—Б–≤—П—Й–µ–љ–∞ –Њ—Б–љ–Њ–≤–∞–Љ –љ–µ–є—А–Њ–љ–љ—Л—Е —Б–µ—В–µ–є (–Э–°), –Є—Е —Б—В—А—Г–Ї—В—Г—А–µ –Є –Љ–µ—В–Њ–і–∞–Љ –Њ–±—Г—З–µ–љ–Є—П, –≤–Ї–ї—О—З–∞—П –Є—Б—В–Њ—А–Є—З–µ—Б–Ї–Є–µ –і–Њ—Б—В–Є–ґ–µ–љ–Є—П –≤ —Н—В–Њ–є –Њ–±–ї–∞—Б—В–Є. –Ю–±—Б—Г–ґ–і–∞—О—В—Б—П —А–∞–Ј–ї–Є—З–љ—Л–µ –Ї–ї–∞—Б—Б–Є—Д–Є–Ї–∞—Ж–Є–Є –Э–°, –Њ–±–ї–∞—Б—В–Є –Є—Е –њ—А–Є–Љ–µ–љ–µ–љ–Є—П, —В–∞–Ї–Є–µ –Ї–∞–Ї —А–∞—Б–њ–Њ–Ј–љ–∞–≤–∞–љ–Є–µ –Њ–±—А–∞–Ј–Њ–≤, –њ—А–Њ–≥–љ–Њ–Ј–Є—А–Њ–≤–∞–љ–Є–µ –Є –Њ–њ—В–Є–Љ–Є–Ј–∞—Ж–Є—П, –∞ —В–∞–Ї–ґ–µ –њ—А–Є–Љ–µ—А—Л –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞–љ–Є—П –Э–° –≤ —А–∞–Ј–ї–Є—З–љ—Л—Е —Б–Є—Б—В–µ–Љ–∞—Е. –£–њ–Њ–Љ–Є–љ–∞—О—В—Б—П –Ї–Њ–љ–Ї—А–µ—В–љ—Л–µ –Ј–∞–і–∞—З–Є –Є –њ—А–Є–Љ–µ—А—Л —Б–Є—Б—В–µ–Љ, –і–µ–Љ–Њ–љ—Б—В—А–Є—А—Г—О—Й–Є–µ –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ—Б—В–Є –Є —Н—Д—Д–µ–Ї—В–Є–≤–љ–Њ—Б—В—М –љ–µ–є—А–Њ–љ–љ—Л—Е —Б–µ—В–µ–є.More Related Content

Similar to –Ы–µ–Ї—Ж–Є—П 6 (11)

–љ–µ–є—А–Њ–љ–љ—Л–µ —Б–µ—В–Є

–љ–µ–є—А–Њ–љ–љ—Л–µ —Б–µ—В–Єhudvin

ћэ

–Ф–Њ–Ї—Г–Љ–µ–љ—В –њ—А–µ–і—Б—В–∞–≤–ї—П–µ—В —Б–Њ–±–Њ–є –Њ–±–Ј–Њ—А –Є—Б—В–Њ—А–Є–Є –Є —А–∞–Ј–≤–Є—В–Є—П –Є—Б–Ї—Г—Б—Б—В–≤–µ–љ–љ—Л—Е –љ–µ–є—А–Њ–љ–љ—Л—Е —Б–µ—В–µ–є, –љ–∞—З–Є–љ–∞—П —Б —А–∞–±–Њ—В –£–Њ—А—А–µ–љ–∞ –Ь–∞–Ї–Ї–∞–ї–ї–Њ–Ї–∞ –Є –£–Њ–ї—В–µ—А–∞ –Я–Є—В—В—Б–∞ –≤ 1943 –≥–Њ–і—Г –Є –Ј–∞–Ї–∞–љ—З–Є–≤–∞—П —А–µ–≤–Њ–ї—О—Ж–Є–Њ–љ–љ—Л–Љ–Є –Њ—В–Ї—А—Л—В–Є—П–Љ–Є 1986 –≥–Њ–і–∞, —Б–≤—П–Ј–∞–љ–љ—Л–Љ–Є —Б –Љ–µ—В–Њ–і–Њ–Љ –Њ–±—А–∞—В–љ–Њ–≥–Њ —А–∞—Б–њ—А–Њ—Б—В—А–∞–љ–µ–љ–Є—П –Њ—И–Є–±–Ї–Є. –Ґ–∞–Ї–ґ–µ –Њ–±—Б—Г–ґ–і–∞—О—В—Б—П —А–∞–Ј–ї–Є—З–љ—Л–µ –≤–Є–і—Л –љ–µ–є—А–Њ–љ–љ—Л—Е —Б–µ—В–µ–є, —В–∞–Ї–Є–µ –Ї–∞–Ї —Б–µ—В–Є –•–Њ–њ—Д–Є–ї–і–∞ –Є —Б–µ—В–Є –Ъ–Њ—Е–Њ–љ–µ–љ–∞, –Є —Г–њ–Њ–Љ–Є–љ–∞–µ—В—Б—П –Є—Е —Б–њ–Њ—Б–Њ–±–љ–Њ—Б—В—М –Є–Љ–Є—В–Є—А–Њ–≤–∞—В—М –љ–µ–њ—А–µ—А—Л–≤–љ—Л–µ —Д—Г–љ–Ї—Ж–Є–Є. –Т –і–Њ–Ї—Г–Љ–µ–љ—В–µ –њ–Њ–і—З–µ—А–Ї–Є–≤–∞–µ—В—Б—П –≤–∞–ґ–љ–Њ—Б—В—М –µ—Б—В–µ—Б—В–≤–µ–љ–љ–Њ–≥–Њ –Є–љ—В–µ–ї–ї–µ–Ї—В–∞ –і–ї—П –Є–Ј—Г—З–µ–љ–Є—П –Є—Б–Ї—Г—Б—Б—В–≤–µ–љ–љ–Њ–≥–Њ –Є–љ—В–µ–ї–ї–µ–Ї—В–∞.–Ы–µ–Ї—Ж–Є—П вДЦ12 "–Ю–≥—А–∞–љ–Є—З–µ–љ–љ–∞—П –Љ–∞—И–Є–љ–∞ –С–Њ–ї—М—Ж–Љ–∞–љ–∞"

–Ы–µ–Ї—Ж–Є—П вДЦ12 "–Ю–≥—А–∞–љ–Є—З–µ–љ–љ–∞—П –Љ–∞—И–Є–љ–∞ –С–Њ–ї—М—Ж–Љ–∞–љ–∞" Technosphere1

ћэ

–Ф–Њ–Ї—Г–Љ–µ–љ—В —Б–Њ–і–µ—А–ґ–Є—В –ї–µ–Ї—Ж–Є—О –Њ softmax —Б–ї–Њ–µ –Є –Њ–≥—А–∞–љ–Є—З–µ–љ–љ–Њ–є –Љ–∞—И–Є–љ–µ –С–Њ–ї—М—Ж–Љ–∞–љ–∞, –≤–Ї–ї—О—З–∞—П –Њ–±—Б—Г–ґ–і–µ–љ–Є–µ –∞–ї–≥–Њ—А–Є—В–Љ–Њ–≤ –Њ–±—Г—З–µ–љ–Є—П –Є —Б—В–∞—В–Є—Б—В–Є—З–µ—Б–Ї–Є—Е –Ї–Њ–љ—Ж–µ–њ—Ж–Є–є. –†–∞—Б—Б–Љ–∞—В—А–Є–≤–∞—О—В—Б—П —А–∞–Ј–ї–Є—З–љ—Л–µ —Д—Г–љ–Ї—Ж–Є–Є —Б—В–Њ–Є–Љ–Њ—Б—В–Є, —В–∞–Ї–Є–µ –Ї–∞–Ї —Б—А–µ–і–љ–µ–Ї–≤–∞–і—А–∞—В–Є—З–љ–∞—П –Њ—И–Є–±–Ї–∞ –Є –њ–µ—А–µ–Ї—А–µ—Б—В–љ–∞—П —Н–љ—В—А–Њ–њ–Є—П, –∞ —В–∞–Ї–ґ–µ –Є—Б–њ–Њ–ї—М–Ј—Г—О—В—Б—П –Љ–µ—В–Њ–і—Л, —Б–≤—П–Ј–∞–љ–љ—Л–µ —Б –ї–Њ–≥–Є—Б—В–Є—З–µ—Б–Ї–Њ–є —А–µ–≥—А–µ—Б—Б–Є–µ–є –Є –љ–µ–є—А–Њ—Б–µ—В—П–Љ–Є. –Т –Ї–Њ–љ—Ж–µ –ї–µ–Ї—Ж–Є–Є –Њ–±—Б—Г–ґ–і–∞—О—В—Б—П –Ї–Њ–љ—Ж–µ–њ—Ж–Є–Є, —Б–≤—П–Ј–∞–љ–љ—Л–µ —Б –Њ–±—Г—З–µ–љ–Є–µ–Љ –±–µ–Ј —Г—З–Є—В–µ–ї—П –Є —Б—В–∞—В–Є—Б—В–Є—З–µ—Б–Ї–Њ–є –Љ–µ—Е–∞–љ–Є–Ї–Њ–є.CV2015. –Ы–µ–Ї—Ж–Є—П 6. –Э–µ–є—А–Њ—Б–µ—В–µ–≤—Л–µ –∞–ї–≥–Њ—А–Є—В–Љ—Л.

CV2015. –Ы–µ–Ї—Ж–Є—П 6. –Э–µ–є—А–Њ—Б–µ—В–µ–≤—Л–µ –∞–ї–≥–Њ—А–Є—В–Љ—Л.Anton Konushin

ћэ

–Ф–Њ–Ї—Г–Љ–µ–љ—В –њ—А–µ–і—Б—В–∞–≤–ї—П–µ—В —Б–Њ–±–Њ–є –ї–µ–Ї—Ж–Є—О –Њ –љ–µ–є—А–Њ—Б–µ—В–µ–≤—Л—Е –∞–ї–≥–Њ—А–Є—В–Љ–∞—Е, –Њ–њ–Є—Б—Л–≤–∞—О—Й—Г—О –Љ–∞—В–µ–Љ–∞—В–Є—З–µ—Б–Ї–Є–µ –Љ–Њ–і–µ–ї–Є –љ–µ–є—А–Њ–љ–Њ–≤, –Љ–µ—В–Њ–і—Л –Њ–±—Г—З–µ–љ–Є—П –Є –∞—А—Е–Є—В–µ–Ї—В—Г—А—Г –љ–µ–є—А–Њ—Б–µ—В–µ–є. –Ю—Б–љ–Њ–≤–љ–Њ–µ –≤–љ–Є–Љ–∞–љ–Є–µ —Г–і–µ–ї—П–µ—В—Б—П —Б–≤—С—А—В–Њ—З–љ—Л–Љ –љ–µ–є—А–Њ—Б–µ—В—П–Љ, –Є—Е —Н—Д—Д–µ–Ї—В–Є–≤–љ–Њ—Б—В–Є –≤ —А–∞—Б–њ–Њ–Ј–љ–∞–≤–∞–љ–Є–Є –Є–Ј–Њ–±—А–∞–ґ–µ–љ–Є–є –Є —Н–≤–Њ–ї—О—Ж–Є–Є –њ–Њ–і—Е–Њ–і–Њ–≤ –Ї –Њ–±—Г—З–µ–љ–Є—О. –Ґ–∞–Ї–ґ–µ —А–∞—Б—Б–Љ–∞—В—А–Є–≤–∞—О—В—Б—П –±–Є–Њ–ї–Њ–≥–Є—З–µ—Б–Ї–Є –≤–і–Њ—Е–љ–Њ–≤–ї—С–љ–љ—Л–µ –Љ–µ—В–Њ–і—Л, —Н–≤—А–Є—Б—В–Є–Ї–Є –Є –∞—А—Е–Є—В–µ–Ї—В—Г—А—Л, –Є—Б–њ–Њ–ї—М–Ј—Г–µ–Љ—Л–µ –і–ї—П —Г–њ—А–∞–≤–ї–µ–љ–Є—П –њ–∞—А–∞–Љ–µ—В—А–∞–Љ–Є –Є —А–∞—Б–њ–Њ–Ј–љ–∞–≤–∞–љ–Є–µ–Љ –Њ–±—К–µ–Ї—В–Њ–≤.–†–Х–Р–Ы–Ш–Ч–Р–¶–Ш–ѓ –†–Р–Ф–Ш–Р–Ы–ђ–Э–Ю-–С–Р–Ч–Ш–°–Э–Ю–Щ –Э–Х–Щ–†–Ю–Э–Э–Ю–Щ –°–Х–Ґ–Ш –Э–Р –Ь–Р–°–°–Ш–Т–Э–Ю-–Я–Р–†–Р–Ы–Ы–Х–Ы–ђ–Э–Ю–Щ –Р–†–•–Ш–Ґ–Х–Ъ...

–†–Х–Р–Ы–Ш–Ч–Р–¶–Ш–ѓ –†–Р–Ф–Ш–Р–Ы–ђ–Э–Ю-–С–Р–Ч–Ш–°–Э–Ю–Щ –Э–Х–Щ–†–Ю–Э–Э–Ю–Щ –°–Х–Ґ–Ш –Э–Р –Ь–Р–°–°–Ш–Т–Э–Ю-–Я–Р–†–Р–Ы–Ы–Х–Ы–ђ–Э–Ю–Щ –Р–†–•–Ш–Ґ–Х–Ъ...ITMO University

ћэ

–Ф–Њ–Ї—Г–Љ–µ–љ—В –Њ–њ–Є—Б—Л–≤–∞–µ—В —А–µ–∞–ї–Є–Ј–∞—Ж–Є—О —А–∞–і–Є–∞–ї—М–љ–Њ-–±–∞–Ј–Є—Б–љ–Њ–є –љ–µ–є—А–Њ–љ–љ–Њ–є —Б–µ—В–Є (RBFNN) –љ–∞ –∞—А—Е–Є—В–µ–Ї—В—Г—А–µ –≥—А–∞—Д–Є—З–µ—Б–Ї–Њ–≥–Њ –њ—А–Њ—Ж–µ—Б—Б–Њ—А–∞ —Б –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞–љ–Є–µ–Љ —В–µ—Е–љ–Њ–ї–Њ–≥–Є–Є CUDA –і–ї—П —А–µ—И–µ–љ–Є—П –Ї—А–∞–µ–≤—Л—Е –Ј–∞–і–∞—З –Љ–∞—В–µ–Љ–∞—В–Є—З–µ—Б–Ї–Њ–є —Д–Є–Ј–Є–Ї–Є. –Р–≤—В–Њ—А –њ—А–Є–≤–Њ–і–Є—В —А–µ–Ј—Г–ї—М—В–∞—В—Л —Б—А–∞–≤–љ–Є—В–µ–ї—М–љ–Њ–≥–Њ –∞–љ–∞–ї–Є–Ј–∞ –≤—А–µ–Љ–µ–љ–Є –Њ–±—Г—З–µ–љ–Є—П RBFNN –љ–∞ —Ж–µ–љ—В—А–∞–ї—М–љ—Л—Е –Є –≥—А–∞—Д–Є—З–µ—Б–Ї–Є—Е –њ—А–Њ—Ж–µ—Б—Б–Њ—А–∞—Е, –і–µ–Љ–Њ–љ—Б—В—А–Є—А—Г—П –Ј–љ–∞—З–Є—В–µ–ї—М–љ–Њ–µ —Б–Њ–Ї—А–∞—Й–µ–љ–Є–µ –≤—А–µ–Љ–µ–љ–Є –≤—Л—З–Є—Б–ї–µ–љ–Є–є –њ—А–Є —А–∞—Б–њ–∞—А–∞–ї–ї–µ–ї–Є–≤–∞–љ–Є–Є. –Ю—Б–љ–Њ–≤–љ–Њ–µ –≤–љ–Є–Љ–∞–љ–Є–µ —Г–і–µ–ї—П–µ—В—Б—П —Н—Д—Д–µ–Ї—В–Є–≤–љ–Њ—Б—В–Є –∞–ї–≥–Њ—А–Є—В–Љ–Њ–≤ –љ–∞—Б—В—А–Њ–є–Ї–Є –њ–∞—А–∞–Љ–µ—В—А–Њ–≤ —Б–µ—В–Є –Є –µ–Ї—Б–њ–µ—А–Є–Љ–µ–љ—В–∞–ї—М–љ—Л–Љ –і–∞–љ–љ—Л–Љ, –њ–Њ–і—В–≤–µ—А–ґ–і–∞—О—Й–Є–Љ –њ—А–µ–Є–Љ—Г—Й–µ—Б—В–≤–Њ GPU –≤ –≤—Л—З–Є—Б–ї–µ–љ–Є—П—Е.–Ы–µ–Ї—Ж–Є—П вДЦ11 "–Ю—Б–љ–Њ–≤—Л –љ–µ–є—А–Њ–љ–љ—Л—Е —Б–µ—В–µ–є"

–Ы–µ–Ї—Ж–Є—П вДЦ11 "–Ю—Б–љ–Њ–≤—Л –љ–µ–є—А–Њ–љ–љ—Л—Е —Б–µ—В–µ–є" Technosphere1

ћэ

–Ы–µ–Ї—Ж–Є—П –Њ—Е–≤–∞—В—Л–≤–∞–µ—В –Њ—Б–љ–Њ–≤—Л –љ–µ–є—А–Њ–љ–љ—Л—Е —Б–µ—В–µ–є, –≤–Ї–ї—О—З–∞—П –Є—Б—В–Њ—А–Є—О –Є—Е —В–µ–Њ—А–Є–Є –Є –Ї–ї—О—З–µ–≤—Л–µ –Ї–Њ–љ—Ж–µ–њ—Ж–Є–Є, —В–∞–Ї–Є–µ –Ї–∞–Ї –Љ–љ–Њ–≥–Њ—Б–ї–Њ–є–љ—Л–µ –љ–µ–є—А–Њ–љ–љ—Л–µ —Б–µ—В–Є –Є –∞–ї–≥–Њ—А–Є—В–Љ—Л –Њ–±—А–∞—В–љ–Њ–≥–Њ —А–∞—Б–њ—А–Њ—Б—В—А–∞–љ–µ–љ–Є—П –Њ—И–Є–±–Ї–Є. –Ю–±—Б—Г–ґ–і–∞—О—В—Б—П —А–∞–Ј–ї–Є—З–љ—Л–µ –Љ–Њ–і–µ–ї–Є –љ–µ–є—А–Њ–љ–Њ–≤ –Є –Ї–ї–∞—Б—Б—Л –∞–ї–≥–Њ—А–Є—В–Љ–Њ–≤, –∞ —В–∞–Ї–ґ–µ –≤–µ–Ї—В–Њ—А–љ—Л–µ –њ—А–µ–і—Б—В–∞–≤–ї–µ–љ–Є—П –Є –Љ–µ—Е–∞–љ–Є–Ј–Љ—Л –Њ–±—Г—З–µ–љ–Є—П, –≤–Ї–ї—О—З–∞—П –њ—А–∞–≤–Є–ї–∞ –•–µ–±–±–∞. –Ы–µ–Ї—Ж–Є—П —В–∞–Ї–ґ–µ –Њ—Б–≤–µ—Й–∞–µ—В –і–Њ—Б—В–Є–ґ–µ–љ–Є—П –≤ –љ–µ–є—А–Њ–±–Є–Њ–ї–Њ–≥–Є–Є –Є —Б—А–∞–≤–љ–Є–≤–∞–µ—В —А–∞–±–Њ—В—Г –Љ–Њ–Ј–≥–∞ —Б —Б–Њ–≤—А–µ–Љ–µ–љ–љ—Л–Љ–Є –Ї–Њ–Љ–њ—М—О—В–µ—А–љ—Л–Љ–Є —Б–Є—Б—В–µ–Љ–∞–Љ–Є.–Т–≤–µ–і–µ–љ–Є–µ –≤ Deep Learning

–Т–≤–µ–і–µ–љ–Є–µ –≤ Deep LearningGrigory Sapunov

ћэ

–Ф–Њ–Ї—Г–Љ–µ–љ—В —А–∞—Б—Б–Љ–∞—В—А–Є–≤–∞–µ—В —А–∞–Ј–ї–Є—З–Є—П –Є —Б—Е–Њ–і—Б—В–≤–∞ –Љ–µ–ґ–і—Г –≥–ї—Г–±–Њ–Ї–Є–Љ –Њ–±—Г—З–µ–љ–Є–µ–Љ –Є –Љ–∞—И–Є–љ–љ—Л–Љ –Њ–±—Г—З–µ–љ–Є–µ–Љ, –∞ —В–∞–Ї–ґ–µ –Њ—Б–≤–µ—Й–∞–µ—В —В—А–µ–љ–і—Л, —В–∞–Ї–Є–µ –Ї–∞–Ї —А–Њ—Б—В —В–Њ—З–љ–Њ—Б—В–Є –Є —Б–ї–Њ–ґ–љ–Њ—Б—В–Є –љ–µ–є—А–Њ—Б–µ—В–µ–є –Є —Г–≤–µ–ї–Є—З–µ–љ–Є–µ –Њ–±—К–µ–Љ–Њ–≤ –і–∞–љ–љ—Л—Е. –У–ї—Г–±–Њ–Ї–Є–µ –љ–µ–є—А–Њ—Б–µ—В–Є, –≤ —В–Њ–Љ —З–Є—Б–ї–µ —Б–≤–µ—А—В–Њ—З–љ—Л–µ –Є –њ–Њ–ї–љ–Њ—Б–≤—П–Ј–љ—Л–µ, –Њ–њ–Є—Б—Л–≤–∞—О—В—Б—П —Б –∞–Ї—Ж–µ–љ—В–Њ–Љ –љ–∞ –Є—Е —Б—В—А—Г–Ї—В—Г—А—Г, —Д—Г–љ–Ї—Ж–Є–Є –∞–Ї—В–Є–≤–∞—Ж–Є–Є, –Љ–µ—Е–∞–љ–Є–Ј–Љ—Л –Њ–±—Г—З–µ–љ–Є—П –Є –∞–ї–≥–Њ—А–Є—В–Љ—Л –Њ–њ—В–Є–Љ–Є–Ј–∞—Ж–Є–Є, —В–∞–Ї–Є–µ –Ї–∞–Ї –≥—А–∞–і–Є–µ–љ—В–љ—Л–є —Б–њ—Г—Б–Ї –Є –Њ–±—А–∞—В–љ–Њ–µ —А–∞—Б–њ—А–Њ—Б—В—А–∞–љ–µ–љ–Є–µ –Њ—И–Є–±–Ї–Є. –Ґ–∞–Ї–ґ–µ –Њ–±—Б—Г–ґ–і–∞—О—В—Б—П —А–∞–Ј–ї–Є—З–љ—Л–µ –∞—А—Е–Є—В–µ–Ї—В—Г—А—Л –Є –∞–ї–≥–Њ—А–Є—В–Љ—Л, –≤–Ї–ї—О—З–∞—П –∞–≤—В–Њ—Н–љ–Ї–Њ–і–µ—А—Л –Є –Њ–≥—А–∞–љ–Є—З–µ–љ–љ—Л–µ –±–Њ–ї—Ж–Љ–∞–љ–Њ–≤—Б–Ї–Є–µ –Љ–∞—И–Є–љ—Л.–Ы–µ–Ї—Ж–Є—П 2

–Ы–µ–Ї—Ж–Є—П 2Ivan Stolyarov

ћэ

–Ф–Њ–Ї—Г–Љ–µ–љ—В –Њ–њ–Є—Б—Л–≤–∞–µ—В –њ—А–Є–љ—Ж–Є–њ—Л —А–∞–±–Њ—В—Л –Њ–і–љ–Њ—Б–ї–Њ–є–љ—Л—Е –љ–µ–є—А–Њ–љ–љ—Л—Е —Б–µ—В–µ–є (–Э–°), –≤–Ї–ї—О—З–∞—П —Б—В—А—Г–Ї—В—Г—А—Г –љ–µ–є—А–Њ–љ–∞, –∞–Ї—В–Є–≤–∞—Ж–Є–Њ–љ–љ—Л–µ —Д—Г–љ–Ї—Ж–Є–Є, —В–∞–Ї–Є–µ –Ї–∞–Ї —Б–Є–≥–Љ–Њ–Є–і–∞ –Є –≥–Є–њ–µ—А–±–Њ–ї–Є—З–µ—Б–Ї–Є–є —В–∞–љ–≥–µ–љ—Б, –∞ —В–∞–Ї–ґ–µ –∞–ї–≥–Њ—А–Є—В–Љ—Л –Њ–±—Г—З–µ–љ–Є—П, –Њ—Б–љ–Њ–≤–∞–љ–љ—Л–µ –љ–∞ –Ї–Њ—А—А–µ–Ї—Ж–Є–Є –≤–µ—Б–Њ–≤ —Б–Є–љ–∞–њ—В–Є—З–µ—Б–Ї–Є—Е —Б–≤—П–Ј–µ–є. –†–∞—Б—Б–Љ–∞—В—А–Є–≤–∞—О—В—Б—П –њ—А–Њ–±–ї–µ–Љ—Л, –≤–Њ–Ј–љ–Є–Ї–∞—О—Й–Є–µ –љ–∞ —Н—В–∞–њ–µ –Њ–±—Г—З–µ–љ–Є—П, —В–∞–Ї–Є–µ –Ї–∞–Ї –≤—Л–±–Њ—А –∞–ї–≥–Њ—А–Є—В–Љ–∞ –Є –љ–∞—З–∞–ї—М–љ–∞—П –Є–љ–Є—Ж–Є–∞–ї–Є–Ј–∞—Ж–Є—П –≤–µ—Б–Њ–≤, –∞ —В–∞–Ї–ґ–µ –Ј–∞–і–∞—З–∞ –Ї–ї–∞—Б—Б–Є—Д–Є–Ї–∞—Ж–Є–Є —Б –њ–Њ–Љ–Њ—Й—М—О –Њ–і–љ–Њ—Б–ї–Њ–є–љ–Њ–≥–Њ –њ–µ—А—Б–µ–њ—В—А–Њ–љ–∞. –Ф–Њ–Ї—Г–Љ–µ–љ—В —В–∞–Ї–ґ–µ –Ј–∞—В—А–∞–≥–Є–≤–∞–µ—В –Љ–µ—В–Њ–і—Л –Љ–Є–љ–Є–Љ–Є–Ј–∞—Ж–Є–Є –Њ—И–Є–±–Ї–Є –Є –Ї—А–Є—В–µ—А–Є–Є –Њ–Ї–Њ–љ—З–∞–љ–Є—П –Њ–±—Г—З–µ–љ–Є—П, –≤–Ї–ї—О—З–∞—П –њ–µ—А–µ–Њ–±—Г—З–µ–љ–Є–µ.–Ш–ї—М—П –Ґ—А–Њ—Д–Є–Љ–Њ–≤ - –Љ–∞—И–Є–љ–љ–Њ–µ –Њ–±—Г—З–µ–љ–Є–µ —Б –њ–Њ–Љ–Њ—Й—М—О vw

–Ш–ї—М—П –Ґ—А–Њ—Д–Є–Љ–Њ–≤ - –Љ–∞—И–Є–љ–љ–Њ–µ –Њ–±—Г—З–µ–љ–Є–µ —Б –њ–Њ–Љ–Њ—Й—М—О vwPavel Mezentsev

ћэ

–Ф–Њ–Ї—Г–Љ–µ–љ—В –Њ–њ–Є—Б—Л–≤–∞–µ—В –њ—А–Њ–µ–Ї—В Vowpal Wabbit, –Ї–Њ—В–Њ—А—Л–є –њ—А–µ–і—Б—В–∞–≤–ї—П–µ—В —Б–Њ–±–Њ–є –±—Л—Б—В—А–Њ–µ –Њ–±—Г—З–µ–љ–Є–µ –ї–Є–љ–µ–є–љ—Л—Е —Д—Г–љ–Ї—Ж–Є–є, —А–∞–Ј—А–∞–±–Њ—В–∞–љ–љ–Њ–µ –≤ Yahoo Research –Є —Б–µ–є—З–∞—Б –њ–Њ–і–і–µ—А–ґ–Є–≤–∞–µ–Љ–Њ–µ Microsoft Research. –Ю–љ –њ–Њ–і–і–µ—А–ґ–Є–≤–∞–µ—В –Љ–љ–Њ–ґ–µ—Б—В–≤–Њ –Љ–µ—В–Њ–і–Њ–≤ –Њ–њ—В–Є–Љ–Є–Ј–∞—Ж–Є–Є –Є –Њ–±—Г—З–µ–љ–Є–µ –љ–∞ —А–∞—Б–њ—А–µ–і–µ–ї–µ–љ–љ—Л—Е —Б–Є—Б—В–µ–Љ–∞—Е, —В–∞–Ї–Є—Е –Ї–∞–Ї Hadoop, –±–µ–Ј –љ–µ–Њ–±—Е–Њ–і–Є–Љ–Њ—Б—В–Є –≤ –Ї–ї–∞—Б—В–µ—А–µ. –Я—А–Њ–µ–Ї—В —П–≤–ї—П–µ—В—Б—П –Њ—В–Ї—А—Л—В—Л–Љ –Є—Б—Е–Њ–і–љ—Л–Љ –Ї–Њ–і–Њ–Љ –Є –њ—А–µ–і–ї–∞–≥–∞–µ—В –њ–ї–∞—В—Д–Њ—А–Љ—Г –і–ї—П –Є—Б—Б–ї–µ–і–Њ–≤–∞–љ–Є–є –≤ –Њ–±–ї–∞—Б—В–Є –Љ–∞—И–Є–љ–љ–Њ–≥–Њ –Њ–±—Г—З–µ–љ–Є—П.2012.11.06 –Љ–∞—И–Є–љ–љ–Њ–µ –Њ–±—Г—З–µ–љ–Є–µ —Б –њ–Њ–Љ–Њ—Й—М—О vw

2012.11.06 –Љ–∞—И–Є–љ–љ–Њ–µ –Њ–±—Г—З–µ–љ–Є–µ —Б –њ–Њ–Љ–Њ—Й—М—О vw–Ш–ї—М—П –Ґ—А–Њ—Д–Є–Љ–Њ–≤

ћэ

–Ф–Њ–Ї—Г–Љ–µ–љ—В –Њ–њ–Є—Б—Л–≤–∞–µ—В –њ—А–Њ–µ–Ї—В Vowpal Wabbit, –ї–Є–љ–µ–є–љ—Г—О –Њ–±—Г—З–∞—О—Й—Г—О —Б–Є—Б—В–µ–Љ—Г —Б –Њ—В–Ї—А—Л—В—Л–Љ –Є—Б—Е–Њ–і–љ—Л–Љ –Ї–Њ–і–Њ–Љ, —А–∞–Ј—А–∞–±–Њ—В–∞–љ–љ—Г—О –і–ї—П –Њ–±—А–∞–±–Њ—В–Ї–Є –±–Њ–ї—М—И–Є—Е –і–∞–љ–љ—Л—Е –Є –Њ–њ—В–Є–Љ–Є–Ј–∞—Ж–Є–Є –∞–ї–≥–Њ—А–Є—В–Љ–Њ–≤ –Њ–±—Г—З–µ–љ–Є—П. –Я—А–Њ–≥—А–∞–Љ–Љ–∞ –њ–Њ–і–і–µ—А–ґ–Є–≤–∞–µ—В –Љ–љ–Њ–ґ–µ—Б—В–≤–Њ —Д—Г–љ–Ї—Ж–Є–є –њ–Њ—В–µ—А—М –Є –Љ–µ—В–Њ–і–Њ–≤ –Њ–њ—В–Є–Љ–Є–Ј–∞—Ж–Є–Є, —В–∞–Ї–Є—Е –Ї–∞–Ї SGD –Є L-BFGS, –Є –љ–µ —В—А–µ–±—Г–µ—В –і–ї—П —А–∞–±–Њ—В—Л Hadoop-–Ї–ї–∞—Б—В–µ—А–∞, —Е–Њ—В—П –Љ–Њ–ґ–µ—В –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞—В—М –µ–≥–Њ –і–ї—П —А–∞—Б–њ—А–µ–і–µ–ї–µ–љ–љ–Њ–≥–Њ –Њ–±—Г—З–µ–љ–Є—П. –≠—В–Њ —А–µ—И–µ–љ–Є–µ –њ–Њ–і—Е–Њ–і–Є—В –і–ї—П –Ј–∞–і–∞—З, —Б–≤—П–Ј–∞–љ–љ—Л—Е —Б –∞–љ–∞–ї–Є–Ј–Њ–Љ –њ–Њ–ї—М–Ј–Њ–≤–∞—В–µ–ї—М—Б–Ї–Є—Е –ї–Њ–≥–Њ–≤ –Є –њ—А–µ–і—Б–Ї–∞–Ј–∞–љ–Є–µ–Љ —А–µ–Ј—Г–ї—М—В–∞—В–Њ–≤ –≤ —А–∞–Ј–ї–Є—З–љ—Л—Е –Њ–±–ї–∞—Б—В—П—Е, –≤–Ї–ї—О—З–∞—П —А–µ–Ї–ї–∞–Љ—Г –Є –≥–µ–љ–µ—В–Є–Ї—Г.–Ы–µ–Ї—Ж–Є—П 5

–Ы–µ–Ї—Ж–Є—П 5Ivan Stolyarov

ћэ

–Ф–Њ–Ї—Г–Љ–µ–љ—В —Б–Њ–і–µ—А–ґ–Є—В —А–µ–Ї–Њ–Љ–µ–љ–і–∞—Ж–Є–Є –њ–Њ –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞–љ–Є—О –∞–ї–≥–Њ—А–Є—В–Љ–∞ –Њ–±—А–∞—В–љ–Њ–≥–Њ —А–∞—Б–њ—А–Њ—Б—В—А–∞–љ–µ–љ–Є—П –Њ—И–Є–±–Ї–Є –≤ –Њ–±—Г—З–µ–љ–Є–Є –љ–µ–є—А–Њ–љ–љ—Л—Е —Б–µ—В–µ–є, –Њ–њ–Є—Б—Л–≤–∞—П —А–µ–ґ–Є–Љ—Л –Њ–±—Г—З–µ–љ–Є—П, —В–∞–Ї–Є–µ –Ї–∞–Ї –њ–Њ—Б–ї–µ–і–Њ–≤–∞—В–µ–ї—М–љ—Л–є –Є –њ–∞–Ї–µ—В–љ—Л–є. –†–∞—Б—Б–Љ–∞—В—А–Є–≤–∞—О—В—Б—П –∞—Б–њ–µ–Ї—В—Л –Њ–њ—В–Є–Љ–Є–Ј–∞—Ж–Є–Є –≤—Л–±–Њ—А–Ї–Є –і–∞–љ–љ—Л—Е, –≤–Ї–ї—О—З–∞—П –њ–µ—А–µ–Ї—А–µ—Б—В–љ—Г—О –њ—А–Њ–≤–µ—А–Ї—Г, —А–∞–љ–љ—О—О –Њ—Б—В–∞–љ–Њ–≤–Ї—Г –Є –Є–љ–Є—Ж–Є–∞–ї–Є–Ј–∞—Ж–Є—О –≤–µ—Б–Њ–≤. –Ґ–∞–Ї–ґ–µ —Г–њ–Њ–Љ–Є–љ–∞–µ—В—Б—П –≤–∞–ґ–љ–Њ—Б—В—М –љ–Њ—А–Љ–Є—А–Њ–≤–Ї–Є –≤—Е–Њ–і–Њ–≤ –Є –≤—Л–±–Њ—А–∞ —Ж–µ–ї–µ–≤—Л—Е –Ј–љ–∞—З–µ–љ–Є–є –і–ї—П –њ—А–∞–≤–Є–ї—М–љ–Њ–є —А–∞–±–Њ—В—Л —Д—Г–љ–Ї—Ж–Є–є –∞–Ї—В–Є–≤–∞—Ж–Є–Є.NVIDIA Deep Learning.

NVIDIA Deep Learning. Skolkovo Robotics Center

ћэ

–Ф–Љ–Є—В—А–Є–є –Ъ–Њ—А–Њ–±—З–µ–љ–Ї–Њ, –Є–љ–ґ–µ–љ–µ—А –≤ –Њ–±–ї–∞—Б—В–Є –≥–ї—Г–±–Њ–Ї–Њ–≥–Њ –Њ–±—Г—З–µ–љ–Є—П –≤ NVIDIA, –Њ–њ–Є—Б—Л–≤–∞–µ—В –Љ–µ—В–Њ–і—Л –Є –∞—А—Е–Є—В–µ–Ї—В—Г—А—Л –≥–ї—Г–±–Њ–Ї–Є—Е –љ–µ–є—А–Њ–љ–љ—Л—Е —Б–µ—В–µ–є, –≤–Ї–ї—О—З–∞—П –Њ–±—Г—З–µ–љ–Є–µ —Б —Г—З–Є—В–µ–ї–µ–Љ –Є –±–µ–Ј —Г—З–Є—В–µ–ї—П. –Ю—Б–љ–Њ–≤–љ—Л–µ —В–µ–Љ—Л –≤–Ї–ї—О—З–∞—О—В –≥—А–∞–і–Є–µ–љ—В–љ—Л–є —Б–њ—Г—Б–Ї, —Б–≤—С—А—В–Њ—З–љ—Л–µ –љ–µ–є—А–Њ–љ–љ—Л–µ —Б–µ—В–Є, —А–µ–Ї—Г—А—А–µ–љ—В–љ—Л–µ –љ–µ–є—А–Њ–љ–љ—Л–µ —Б–µ—В–Є –Є –Є—Е –њ—А–Є–Љ–µ–љ–µ–љ–Є–µ –≤ –Ј–∞–і–∞—З–∞—Е –Ї–Њ–Љ–њ—М—О—В–µ—А–љ–Њ–≥–Њ –Ј—А–µ–љ–Є—П –Є –Њ–±—А–∞–±–Њ—В–Ї–Є –µ—Б—В–µ—Б—В–≤–µ–љ–љ–Њ–≥–Њ —П–Ј—Л–Ї–∞. –Ф–Њ–Ї—Г–Љ–µ–љ—В —В–∞–Ї–ґ–µ –Ј–∞—В—А–∞–≥–Є–≤–∞–µ—В —Б–ї–Њ–ґ–љ–Њ—Б—В–Є –Њ–±—А–∞–±–Њ—В–Ї–Є –љ–µ—Б—В—А—Г–Ї—В—Г—А–Є—А–Њ–≤–∞–љ–љ—Л—Е –і–∞–љ–љ—Л—Е –Є —Б–Њ–≤—А–µ–Љ–µ–љ–љ—Л–µ –њ—А–Є–ї–Њ–ґ–µ–љ–Є—П –≥–ї—Г–±–Њ–Ї–Њ–≥–Њ –Њ–±—Г—З–µ–љ–Є—П –≤ —А–∞–Ј–ї–Є—З–љ—Л—Е –Њ–±–ї–∞—Б—В—П—Е.–†–Х–Р–Ы–Ш–Ч–Р–¶–Ш–ѓ –†–Р–Ф–Ш–Р–Ы–ђ–Э–Ю-–С–Р–Ч–Ш–°–Э–Ю–Щ –Э–Х–Щ–†–Ю–Э–Э–Ю–Щ –°–Х–Ґ–Ш –Э–Р –Ь–Р–°–°–Ш–Т–Э–Ю-–Я–Р–†–Р–Ы–Ы–Х–Ы–ђ–Э–Ю–Щ –Р–†–•–Ш–Ґ–Х–Ъ...

–†–Х–Р–Ы–Ш–Ч–Р–¶–Ш–ѓ –†–Р–Ф–Ш–Р–Ы–ђ–Э–Ю-–С–Р–Ч–Ш–°–Э–Ю–Щ –Э–Х–Щ–†–Ю–Э–Э–Ю–Щ –°–Х–Ґ–Ш –Э–Р –Ь–Р–°–°–Ш–Т–Э–Ю-–Я–Р–†–Р–Ы–Ы–Х–Ы–ђ–Э–Ю–Щ –Р–†–•–Ш–Ґ–Х–Ъ...ITMO University

ћэ

More from Ivan Stolyarov (6)

–Ы–µ–Ї—Ж–Є—П 9

–Ы–µ–Ї—Ж–Є—П 9Ivan Stolyarov

ћэ

–Ф–Њ–Ї—Г–Љ–µ–љ—В –Њ–њ–Є—Б—Л–≤–∞–µ—В –Ї–Њ–љ—Ж–µ–њ—Ж–Є—О –Є–Ј–≤–ї–µ—З–µ–љ–Є—П –Ј–љ–∞–љ–Є–є (data mining) –Є–Ј –љ–µ–є—А–Њ–љ–љ—Л—Е —Б–µ—В–µ–є, –∞–Ї—Ж–µ–љ—В–Є—А—Г—П –≤–љ–Є–Љ–∞–љ–Є–µ –љ–∞ –њ–Њ–Є—Б–Ї –Ј–∞–Ї–Њ–љ–Њ–Љ–µ—А–љ–Њ—Б—В–µ–є –Є –≤–Ј–∞–Є–Љ–Њ—Б–≤—П–Ј–µ–є –≤ –±–Њ–ї—М—И–Є—Е –Њ–±—К–µ–Љ–∞—Е –і–∞–љ–љ—Л—Е. –Ю–љ –і–µ–ї–Є—В –Ј–∞–і–∞—З–Є data mining –љ–∞ –і–≤–µ –Ї–∞—В–µ–≥–Њ—А–Є–Є: —А–∞–Ј—А–∞–±–Њ—В–Ї—Г –њ—А–Є–ї–Њ–ґ–µ–љ–Є–є –і–ї—П –љ–µ–є—А–Њ–љ–љ—Л—Е —Б–µ—В–µ–є –Є –њ–Њ–і–і–µ—А–ґ–Ї—Г –њ—А–Є–љ—П—В–Є—П —А–µ—И–µ–љ–Є–є, –≤–Ї–ї—О—З–∞—П –Њ–±—Г—З–µ–љ–Є–µ –Є –Є–Ј–≤–ї–µ—З–µ–љ–Є–µ –Љ–Њ–і–µ–ї–Є. –Ґ–∞–Ї–ґ–µ —А–∞—Б—Б–Љ–∞—В—А–Є–≤–∞—О—В—Б—П —А–∞–Ј–ї–Є—З–љ—Л–µ –њ–Њ–і—Е–Њ–і—Л –Ї –Є–Ј–≤–ї–µ—З–µ–љ–Є—О –Ј–љ–∞–љ–Є–є, —В–∞–Ї–Є–µ –Ї–∞–Ї –∞–љ–∞–ї–Є–Ј —А–µ–∞–Ї—Ж–Є–Є —Б–µ—В–Є, –≤–Є–Ј—Г–∞–ї–Є–Ј–∞—Ж–Є—П –Є –њ–Њ—Б—В—А–Њ–µ–љ–Є–µ –њ—А–∞–≤–Є–ї –Ї–ї–∞—Б—Б–Є—Д–Є–Ї–∞—Ж–Є–Є —Б –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞–љ–Є–µ–Љ –∞–ї–≥–Њ—А–Є—В–Љ–Њ–≤.–Ы–µ–Ї—Ж–Є—П 8

–Ы–µ–Ї—Ж–Є—П 8Ivan Stolyarov

ћэ

–Ф–Њ–Ї—Г–Љ–µ–љ—В –Њ–±—Б—Г–ґ–і–∞–µ—В –њ—А–Є–Љ–µ–љ–µ–љ–Є–µ –љ–µ–є—А–Њ–љ–љ—Л—Е —Б–µ—В–µ–є (–Э–°) –і–ї—П –Ј–∞–і–∞—З –Ї–ї–∞—Б—Б–Є—Д–Є–Ї–∞—Ж–Є–Є –Њ–±—А–∞–Ј–Њ–≤, –≤–Ї–ї—О—З–∞—П —А–∞—Б–њ–Њ–Ј–љ–∞–≤–∞–љ–Є–µ –ї–Є—Ж –Є –і—А—Г–≥–Є–µ –њ—А–Є–Љ–µ—А—Л, —В–∞–Ї–Є–µ –Ї–∞–Ї –Љ–µ–і–Є—Ж–Є–љ—Б–Ї–Є–µ –Є–Ј–Њ–±—А–∞–ґ–µ–љ–Є—П –Є –Є–і–µ–љ—В–Є—Д–Є–Ї–∞—Ж–Є—П –ї–Є—З–љ–Њ—Б—В–Є. –†–∞—Б—Б–Љ–∞—В—А–Є–≤–∞—О—В—Б—П –њ—А–µ–Є–Љ—Г—Й–µ—Б—В–≤–∞ –Є –љ–µ–і–Њ—Б—В–∞—В–Ї–Є –Э–°, –Є—Е –∞–і–∞–њ—В–Є–≤–љ–Њ—Б—В—М –Є –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ—Б—В—М —В–Њ—З–љ–Њ–є –∞–њ–њ—А–Њ–Ї—Б–Є–Љ–∞—Ж–Є–Є, –∞ —В–∞–Ї–ґ–µ –њ—А–Њ–±–ї–µ–Љ—Л —Б–Њ–Ј–і–∞–љ–Є—П –Њ–±—Г—З–∞—О—Й–Є—Е –≤—Л–±–Њ—А–Њ–Ї. –Т–љ–µ–і—А—П—О—В—Б—П —А–∞–Ј–ї–Є—З–љ—Л–µ –∞—А—Е–Є—В–µ–Ї—В—Г—А—Л –љ–µ–є—А–Њ–љ–љ—Л—Е —Б–µ—В–µ–є, –≤–Ї–ї—О—З–∞—П —Б—В—А—Г–Ї—В—Г—А—Л, –Є–љ–≤–∞—А–Є–∞–љ—В–љ—Л–µ –Ї –≤—А–∞—Й–µ–љ–Є—О, –Є —Б–≤–µ—А—В–Њ—З–љ—Л–µ —Б–µ—В–Є, —Б –≤—Л–≤–Њ–і–∞–Љ–Є –Њ–± –Є—Е —Н—Д—Д–µ–Ї—В–Є–≤–љ–Њ—Б—В–Є –њ—А–Є –і–µ—В–µ–Ї—В–Є—А–Њ–≤–∞–љ–Є–Є –ї–Є—Ж –Є –і—А—Г–≥–Є—Е –Ј–∞–і–∞—З–∞—Е.–Ы–µ–Ї—Ж–Є—П 7

–Ы–µ–Ї—Ж–Є—П 7Ivan Stolyarov

ћэ

–Ф–Њ–Ї—Г–Љ–µ–љ—В –Њ–±—Б—Г–ґ–і–∞–µ—В —Б–µ—В—М –Ъ–Њ—Е–Њ–љ–µ–љ–∞, —Б–Њ—Б—А–µ–і–Њ—В–∞—З–Є–≤–∞—П—Б—М –љ–∞ —Б–∞–Љ–Њ–Њ—А–≥–∞–љ–Є–Ј–∞—Ж–Є–Є –Є –Є–Ј–Љ–µ–љ–µ–љ–Є–Є –≤–µ—Б–Њ–≤ –њ–Њ –њ—А–∞–≤–Є–ї—Г –Ъ–Њ—Е–Њ–љ–µ–љ–∞, –∞ —В–∞–Ї–ґ–µ –Љ–µ—В–Њ–і–∞—Е –љ–Њ—А–Љ–∞–ї–Є–Ј–∞—Ж–Є–Є –Є —А–µ—И–µ–љ–Є—П –њ—А–Њ–±–ї–µ–Љ—Л –Љ–µ—А—В–≤—Л—Е –љ–µ–є—А–Њ–љ–Њ–≤. –Ю–±—Б—Г–ґ–і–∞—О—В—Б—П –∞–ї–≥–Њ—А–Є—В–Љ—Л –Њ–±—Г—З–µ–љ–Є—П, –Є—Е —Б—А–∞–≤–љ–µ–љ–Є–µ –Є –њ—А–Є–Љ–µ–љ–µ–љ–Є–µ —Б–µ—В–Є –і–ї—П –Ї–Њ–Љ–њ—А–µ—Б—Б–Є–Є –і–∞–љ–љ—Л—Е, –і–Є–∞–≥–љ–Њ—Б—В–Є–Ї–Є –љ–µ–Є—Б–њ—А–∞–≤–љ–Њ—Б—В–µ–є –Є –≤–Є–Ј—Г–∞–ї–Є–Ј–∞—Ж–Є–Є –Љ–љ–Њ–≥–Њ–Љ–µ—А–љ–Њ–є –Є–љ—Д–Њ—А–Љ–∞—Ж–Є–Є. –Т –Ј–∞–Ї–ї—О—З–µ–љ–Є–µ –њ—А–Є–≤–Њ–і—П—В—Б—П –і–Њ—Б—В–Њ–Є–љ—Б—В–≤–∞ –Є –љ–µ–і–Њ—Б—В–∞—В–Ї–Є —Б–µ—В–Є –Ъ–Њ—Е–Њ–љ–µ–љ–∞.–Ы–µ–Ї—Ж–Є—П 4

–Ы–µ–Ї—Ж–Є—П 4Ivan Stolyarov

ћэ

–Ф–Њ–Ї—Г–Љ–µ–љ—В –њ—А–µ–і—Б—В–∞–≤–ї—П–µ—В –ї–µ–Ї—Ж–Є—О –њ–Њ –∞–ї–≥–Њ—А–Є—В–Љ—Г –Њ–±—А–∞—В–љ–Њ–≥–Њ —А–∞—Б–њ—А–Њ—Б—В—А–∞–љ–µ–љ–Є—П –Њ—И–Є–±–Ї–Є –≤ –љ–µ–є—А–Њ–љ–љ—Л—Е —Б–µ—В—П—Е –Є —А–∞–Ј–ї–Є—З–љ—Л–Љ –Љ–µ—В–Њ–і–∞–Љ –Њ–±—Г—З–µ–љ–Є—П, –≤–Ї–ї—О—З–∞—П –Њ–±—Г—З–µ–љ–Є–µ —Б —Г—З–Є—В–µ–ї–µ–Љ –Є –±–µ–Ј —Г—З–Є—В–µ–ї—П. –Ю–њ–Є—Б—Л–≤–∞—О—В—Б—П –Њ—Б–љ–Њ–≤–љ—Л–µ —И–∞–≥–Є –∞–ї–≥–Њ—А–Є—В–Љ–∞, –њ—А–Њ–±–ї–µ–Љ—Л, —В–∞–Ї–Є–µ –Ї–∞–Ї –њ–∞—А–∞–ї–Є—З —Б–µ—В–Є –Є –ї–Њ–Ї–∞–ї—М–љ—Л–µ –Љ–Є–љ–Є–Љ—Г–Љ—Л, –∞ —В–∞–Ї–ґ–µ –Љ–µ—В–Њ–і—Л –Њ–њ—В–Є–Љ–Є–Ј–∞—Ж–Є–Є, —В–∞–Ї–Є–µ –Ї–∞–Ї –≥—А–∞–і–Є–µ–љ—В–љ—Л–є —Б–њ—Г—Б–Ї –Є –Є–Љ–Є—В–∞—Ж–Є—П –Њ—В–ґ–Є–≥–∞. –Ы–µ–Ї—Ж–Є—П –Њ—Е–≤–∞—В—Л–≤–∞–µ—В —В–∞–Ї–ґ–µ —В–µ—Е–љ–Є–Ї–Є, –љ–∞–њ—А–∞–≤–ї–µ–љ–љ—Л–µ –љ–∞ —Г–ї—Г—З—И–µ–љ–Є–µ —Б—Е–Њ–і–Є–Љ–Њ—Б—В–Є –Є —Г–Љ–µ–љ—М—И–µ–љ–Є–µ —А–Є—Б–Ї–∞ –њ–µ—А–µ–Њ–±—Г—З–µ–љ–Є—П.–Ы–µ–Ї—Ж–Є—П 3

–Ы–µ–Ї—Ж–Є—П 3Ivan Stolyarov

ћэ

–Ф–Њ–Ї—Г–Љ–µ–љ—В —А–∞—Б—Б–Љ–∞—В—А–Є–≤–∞–µ—В –њ—А–Њ–±–ї–µ–Љ—Л –њ–Њ—Б—В—А–Њ–µ–љ–Є—П –љ–µ–є—А–Њ–љ–љ—Л—Е —Б–µ—В–µ–є, –≤ —З–∞—Б—В–љ–Њ—Б—В–Є, –Њ–і–љ–Њ—Б–ї–Њ–є–љ—Л—Е –њ–µ—А—Б–µ–њ—В—А–Њ–љ–Њ–≤ –і–ї—П —А–µ—И–µ–љ–Є—П –Ј–∞–і–∞—З–Є '–Є—Б–Ї–ї—О—З–∞—О—Й–µ–≥–Њ –Є–ї–Є' (XOR), —Г—В–≤–µ—А–ґ–і–∞—П, —З—В–Њ —В–∞–Ї–Є–µ —Б–µ—В–Є –љ–µ –Љ–Њ–≥—Г—В —А–µ–∞–ї–Є–Ј–Њ–≤–∞—В—М —Н—В—Г —Д—Г–љ–Ї—Ж–Є—О –±–µ–Ј –њ—А–µ–і–Њ–±—А–∞–±–Њ—В–Ї–Є –і–∞–љ–љ—Л—Е. –Ґ–∞–Ї–ґ–µ –Њ–±—Б—Г–ґ–і–∞—О—В—Б—П –Љ–љ–Њ–≥–Њ—Б–ї–Њ–є–љ—Л–µ –њ–µ—А—Б–µ–њ—В—А–Њ–љ—Л –Є –Є—Е –њ—А–µ–Є–Љ—Г—Й–µ—Б—В–≤–∞ –≤ —Г–≤–µ–ї–Є—З–µ–љ–Є–Є —В–Њ—З–љ–Њ—Б—В–Є —А–∞–Ј–і–µ–ї–µ–љ–Є—П –Њ–±—А–∞–Ј–Њ–≤ –Ј–∞ —Б—З–µ—В –і–Њ–±–∞–≤–ї–µ–љ–Є—П –љ–µ–є—А–Њ–љ–Њ–≤ –Є —Б–ї–Њ–µ–≤, –∞ —В–∞–Ї–ґ–µ —В–µ–Њ—А–µ–Љ—Л –Њ–± —Г–љ–Є–≤–µ—А—Б–∞–ї—М–љ–Њ–є –∞–њ–њ—А–Њ–Ї—Б–Є–Љ–∞—Ж–Є–Є, –њ–Њ–і—З–µ—А–Ї–Є–≤–∞—О—Й–Є–µ —Б–њ–Њ—Б–Њ–±–љ–Њ—Б—В—М –Љ–љ–Њ–≥–Њ—Б–ї–Њ–є–љ—Л—Е —Б–µ—В–µ–є –∞–њ–њ—А–Њ–Ї—Б–Є–Љ–Є—А–Њ–≤–∞—В—М –ї—О–±—Л–µ —Д—Г–љ–Ї—Ж–Є–Є. –Т –≤—Л–≤–Њ–і–∞—Е –њ–Њ–і—З–µ—А–Ї–Є–≤–∞–µ—В—Б—П –≤–∞–ґ–љ–Њ—Б—В—М –∞—А—Е–Є—В–µ–Ї—В—Г—А—Л –љ–µ–є—А–Њ–љ–љ–Њ–є —Б–µ—В–Є –і–ї—П –µ–µ —Д—Г–љ–Ї—Ж–Є–Њ–љ–∞–ї—М–љ–Њ—Б—В–Є –Є –Ї–ї–∞—Б—Б–Є—Д–Є–Ї–∞—Ж–Є–Є –Њ–±—А–∞–Ј–Њ–≤.–Ы–µ–Ї—Ж–Є—П 1

–Ы–µ–Ї—Ж–Є—П 1Ivan Stolyarov

ћэ

–Ы–µ–Ї—Ж–Є—П –њ–Њ—Б–≤—П—Й–µ–љ–∞ –Њ—Б–љ–Њ–≤–∞–Љ –љ–µ–є—А–Њ–љ–љ—Л—Е —Б–µ—В–µ–є (–Э–°), –Є—Е —Б—В—А—Г–Ї—В—Г—А–µ –Є –Љ–µ—В–Њ–і–∞–Љ –Њ–±—Г—З–µ–љ–Є—П, –≤–Ї–ї—О—З–∞—П –Є—Б—В–Њ—А–Є—З–µ—Б–Ї–Є–µ –і–Њ—Б—В–Є–ґ–µ–љ–Є—П –≤ —Н—В–Њ–є –Њ–±–ї–∞—Б—В–Є. –Ю–±—Б—Г–ґ–і–∞—О—В—Б—П —А–∞–Ј–ї–Є—З–љ—Л–µ –Ї–ї–∞—Б—Б–Є—Д–Є–Ї–∞—Ж–Є–Є –Э–°, –Њ–±–ї–∞—Б—В–Є –Є—Е –њ—А–Є–Љ–µ–љ–µ–љ–Є—П, —В–∞–Ї–Є–µ –Ї–∞–Ї —А–∞—Б–њ–Њ–Ј–љ–∞–≤–∞–љ–Є–µ –Њ–±—А–∞–Ј–Њ–≤, –њ—А–Њ–≥–љ–Њ–Ј–Є—А–Њ–≤–∞–љ–Є–µ –Є –Њ–њ—В–Є–Љ–Є–Ј–∞—Ж–Є—П, –∞ —В–∞–Ї–ґ–µ –њ—А–Є–Љ–µ—А—Л –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞–љ–Є—П –Э–° –≤ —А–∞–Ј–ї–Є—З–љ—Л—Е —Б–Є—Б—В–µ–Љ–∞—Е. –£–њ–Њ–Љ–Є–љ–∞—О—В—Б—П –Ї–Њ–љ–Ї—А–µ—В–љ—Л–µ –Ј–∞–і–∞—З–Є –Є –њ—А–Є–Љ–µ—А—Л —Б–Є—Б—В–µ–Љ, –і–µ–Љ–Њ–љ—Б—В—А–Є—А—Г—О—Й–Є–µ –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ—Б—В–Є –Є —Н—Д—Д–µ–Ї—В–Є–≤–љ–Њ—Б—В—М –љ–µ–є—А–Њ–љ–љ—Л—Е —Б–µ—В–µ–є.Ad

–Ы–µ–Ї—Ж–Є—П 6

- 1. –Ы–µ–Ї—Ж–Є—П 6 –†–µ–Ї—Г—А—А–µ–љ—В–љ—Л–µ —Б–µ—В–Є –љ–∞ –±–∞–Ј–µ –њ–µ—А—Б–µ–њ—В—А–Њ–љ–∞ –°–µ—В—М –•–Њ–њ—Д–Є–ї–і–∞. –°–µ—В—М –•–µ–Љ–Љ–Є–љ–≥–∞.

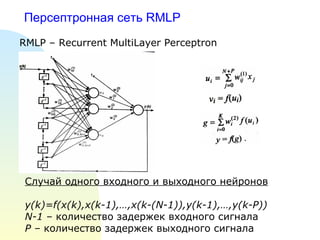

- 2. –Я–µ—А—Б–µ–њ—В—А–Њ–љ–љ–∞—П —Б–µ—В—М RMLP RMLP вАУ Recurrent MultiLayer Perceptron –°–ї—Г—З–∞–є –Њ–і–љ–Њ–≥–Њ –≤—Е–Њ–і–љ–Њ–≥–Њ –Є –≤—Л—Е–Њ–і–љ–Њ–≥–Њ –љ–µ–є—А–Њ–љ–Њ–≤ y(k)=f(x(k),x(k-1),вА¶,x(k-(N-1)),y(k-1),вА¶,y(k-P)) N-1 вАУ –Ї–Њ–ї–Є—З–µ—Б—В–≤–Њ –Ј–∞–і–µ—А–ґ–µ–Ї –≤—Е–Њ–і–љ–Њ–≥–Њ —Б–Є–≥–љ–∞–ї–∞ P вАУ –Ї–Њ–ї–Є—З–µ—Б—В–≤–Њ –Ј–∞–і–µ—А–ґ–µ–Ї –≤—Л—Е–Њ–і–љ–Њ–≥–Њ —Б–Є–≥–љ–∞–ї–∞

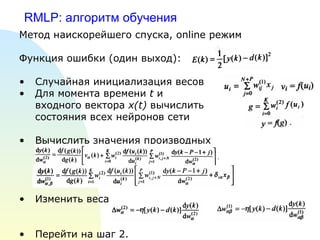

- 3. RMLP: –∞–ї–≥–Њ—А–Є—В–Љ –Њ–±—Г—З–µ–љ–Є—П –Ь–µ—В–Њ–і –љ–∞–Є—Б–Ї–Њ—А–µ–є—И–µ–≥–Њ —Б–њ—Г—Б–Ї–∞, online —А–µ–ґ–Є–Љ –§—Г–љ–Ї—Ж–Є—П –Њ—И–Є–±–Ї–Є (–Њ–і–Є–љ –≤—Л—Е–Њ–і): –°–ї—Г—З–∞–є–љ–∞—П –Є–љ–Є—Ж–Є–∞–ї–Є–Ј–∞—Ж–Є—П –≤–µ—Б–Њ–≤ –Ф–ї—П –Љ–Њ–Љ–µ–љ—В–∞ –≤—А–µ–Љ–µ–љ–Є t –Є –≤—Е–Њ–і–љ–Њ–≥–Њ –≤–µ–Ї—В–Њ—А–∞ x(t) –≤—Л—З–Є—Б–ї–Є—В—М —Б–Њ—Б—В–Њ—П–љ–Є—П –≤—Б–µ—Е –љ–µ–є—А–Њ–љ–Њ–≤ —Б–µ—В–Є –Т—Л—З–Є—Б–ї–Є—В—М –Ј–љ–∞—З–µ–љ–Є—П –њ—А–Њ–Є–Ј–≤–Њ–і–љ—Л—Е –Ш–Ј–Љ–µ–љ–Є—В—М –≤–µ—Б–∞ –Я–µ—А–µ–є—В–Є –љ–∞ —И–∞–≥ 2.

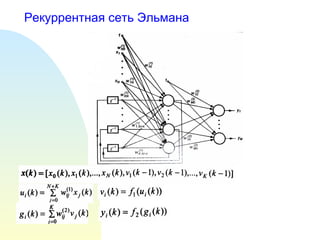

- 5. –°–µ—В—М –≠–ї—М–Љ–∞–љ–∞ : –∞–ї–≥–Њ—А–Є—В–Љ –Њ–±—Г—З–µ–љ–Є—П –Ь–µ—В–Њ–і –љ–∞–Є—Б–Ї–Њ—А–µ–є—И–µ–≥–Њ —Б–њ—Г—Б–Ї–∞, online —А–µ–ґ–Є–Љ –§—Г–љ–Ї—Ж–Є—П –Њ—И–Є–±–Ї–Є: –°–ї—Г—З–∞–є–љ–∞—П –Є–љ–Є—Ж–Є–∞–ї–Є–Ј–∞—Ж–Є—П –≤–µ—Б–Њ–≤, —А–∞–≤–љ–Њ–Љ–µ—А–љ–Њ–µ –Є–Ј [-1,1] –Ф–ї—П –Љ–Њ–Љ–µ–љ—В–∞ –≤—А–µ–Љ–µ–љ–Є t —Б—Д–Њ—А–Љ–Є—А–Њ–≤–∞—В—М –≤—Е–Њ–і–љ–Њ–є –≤–µ–Ї—В–Њ—А x(t) –Т—Л—З–Є—Б–ї–Є—В—М –≤–µ–Ї—В–Њ—А –≥—А–∞–і–Є–µ–љ—В–∞ –Ш–Ј–Љ–µ–љ–Є—В—М –≤–µ—Б–∞ –Я–µ—А–µ–є—В–Є –љ–∞ —И–∞–≥ 2.

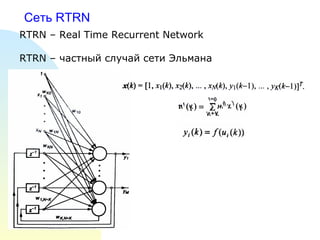

- 6. –°–µ—В—М RTRN RTRN вАУ Real Time Recurrent Network RTRN вАУ —З–∞—Б—В–љ—Л–є —Б–ї—Г—З–∞–є —Б–µ—В–Є –≠–ї—М–Љ–∞–љ–∞

- 7. RTRN вАУ –∞–ї–≥–Њ—А–Є—В–Љ –Њ–±—Г—З–µ–љ–Є—П –Ь–µ—В–Њ–і –љ–∞–Є—Б–Ї–Њ—А–µ–є—И–µ–≥–Њ —Б–њ—Г—Б–Ї–∞, online —А–µ–ґ–Є–Љ –°–ї—Г—З–∞–є–љ–∞—П –Є–љ–Є—Ж–Є–∞–ї–Є–Ј–∞—Ж–Є—П –≤–µ—Б–Њ–≤, —А–∞–≤–љ–Њ–Љ–µ—А–љ–Њ–µ –Є–Ј [-1,1] –Ф–ї—П –Љ–Њ–Љ–µ–љ—В–∞ –≤—А–µ–Љ–µ–љ–Є t —Б—Д–Њ—А–Љ–Є—А–Њ–≤–∞—В—М –≤—Е–Њ–і–љ–Њ–є –≤–µ–Ї—В–Њ—А x(t) –Т—Л—З–Є—Б–ї–Є—В—М –≤–µ–Ї—В–Њ—А –≥—А–∞–і–Є–µ–љ—В–∞ –Ш–Ј–Љ–µ–љ–Є—В—М –≤–µ—Б–∞ –Я–µ—А–µ–є—В–Є –љ–∞ —И–∞–≥ 2.

- 8. –°–µ—В—М —Б –Њ–±—А–∞—В–љ—Л–Љ–Є —Б–≤—П–Ј—П–Љ–Є

- 9. –Р—Б—Б–Њ—Ж–Є–∞—В–Є–≤–љ–∞—П –њ–∞–Љ—П—В—М –Р—Б—Б–Њ—Ж–Є–∞—В–Є–≤–љ–∞—П –њ–∞–Љ—П—В—М: —Б–µ—В—М –•–Њ–њ—Д–Є–ї–і–∞. –У–µ—В–µ—А–Њ–∞—Б—Б–Њ—Ж–Є–∞—В–Є–≤–љ–∞—П –њ–∞–Љ—П—В—М: —Б–µ—В—М –•–µ–Љ–Љ–Є–љ–≥–∞, BAM (–і–≤—Г–љ–∞–њ—А–∞–≤–ї–µ–љ–љ–∞—П –∞—Б—Б–Њ—Ж–Є–∞—В–Є–≤–љ–∞—П –њ–∞–Љ—П—В—М).

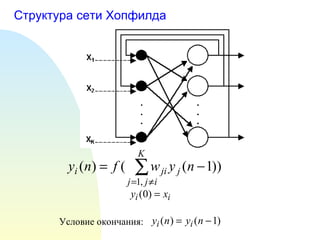

- 10. –°—В—А—Г–Ї—В—Г—А–∞ —Б–µ—В–Є –•–Њ–њ—Д–Є–ї–і–∞ –£—Б–ї–Њ–≤–Є–µ –Њ–Ї–Њ–љ—З–∞–љ–Є—П:

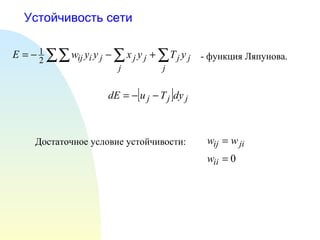

- 12. –£—Б—В–Њ–є—З–Є–≤–Њ—Б—В—М —Б–µ—В–Є –Ф–Њ—Б—В–∞—В–Њ—З–љ–Њ–µ —Г—Б–ї–Њ–≤–Є–µ —Г—Б—В–Њ–є—З–Є–≤–Њ—Б—В–Є: - —Д—Г–љ–Ї—Ж–Є—П –Ы—П–њ—Г–љ–Њ–≤–∞.

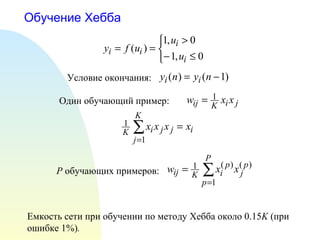

- 13. –Ю–±—Г—З–µ–љ–Є–µ –•–µ–±–±–∞ –Х–Љ–Ї–Њ—Б—В—М —Б–µ—В–Є –њ—А–Є –Њ–±—Г—З–µ–љ–Є–Є –њ–Њ –Љ–µ—В–Њ–і—Г –•–µ–±–±–∞ –Њ–Ї–Њ–ї–Њ 0.15 K ( –њ—А–Є –Њ—И–Є–±–Ї–µ 1%) . –£—Б–ї–Њ–≤–Є–µ –Њ–Ї–Њ–љ—З–∞–љ–Є—П: –Ю–і–Є–љ –Њ–±—Г—З–∞—О—Й–Є–є –њ—А–Є–Љ–µ—А: P –Њ–±—Г—З–∞—О—Й–Є—Е –њ—А–Є–Љ–µ—А–Њ–≤:

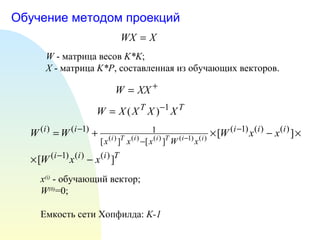

- 14. –Ю–±—Г—З–µ–љ–Є–µ –Љ–µ—В–Њ–і–Њ–Љ –њ—А–Њ–µ–Ї—Ж–Є–є W - –Љ–∞—В—А–Є—Ж–∞ –≤–µ—Б–Њ–≤ K*K ; X - –Љ–∞—В—А–Є—Ж–∞ K*P , —Б–Њ—Б—В–∞–≤–ї–µ–љ–љ–∞—П –Є–Ј –Њ–±—Г—З–∞—О—Й–Є—Е –≤–µ–Ї—В–Њ—А–Њ–≤. x (i) - –Њ–±—Г—З–∞—О—Й–Є–є –≤–µ–Ї—В–Њ—А; W (0) =0; –Х–Љ–Ї–Њ—Б—В—М —Б–µ—В–Є –•–Њ–њ—Д–Є–ї–і–∞: K-1

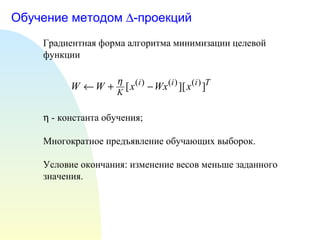

- 15. –Ю–±—Г—З–µ–љ–Є–µ –Љ–µ—В–Њ–і–Њ–Љ пБД -–њ—А–Њ–µ–Ї—Ж–Є–є –У—А–∞–і–Є–µ–љ—В–љ–∞—П —Д–Њ—А–Љ–∞ –∞–ї–≥–Њ—А–Є—В–Љ–∞ –Љ–Є–љ–Є–Љ–Є–Ј–∞—Ж–Є–Є —Ж–µ–ї–µ–≤–Њ–є —Д—Г–љ–Ї—Ж–Є–Є пБ® - –Ї–Њ–љ—Б—В–∞–љ—В–∞ –Њ–±—Г—З–µ–љ–Є—П; –Ь–љ–Њ–≥–Њ–Ї—А–∞—В–љ–Њ–µ –њ—А–µ–і—К—П–≤–ї–µ–љ–Є–µ –Њ–±—Г—З–∞—О—Й–Є—Е –≤—Л–±–Њ—А–Њ–Ї. –£—Б–ї–Њ–≤–Є–µ –Њ–Ї–Њ–љ—З–∞–љ–Є—П: –Є–Ј–Љ–µ–љ–µ–љ–Є–µ –≤–µ—Б–Њ–≤ –Љ–µ–љ—М—И–µ –Ј–∞–і–∞–љ–љ–Њ–≥–Њ –Ј–љ–∞—З–µ–љ–Є—П.

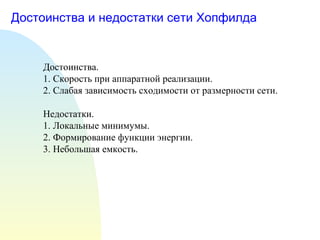

- 16. –Ф–Њ—Б—В–Њ–Є–љ—Б—В–≤–∞ –Є –љ–µ–і–Њ—Б—В–∞—В–Ї–Є —Б–µ—В–Є –•–Њ–њ—Д–Є–ї–і–∞ –Ф–Њ—Б—В–Њ–Є–љ—Б—В–≤–∞. 1. –°–Ї–Њ—А–Њ—Б—В—М –њ—А–Є –∞–њ–њ–∞—А–∞—В–љ–Њ–є —А–µ–∞–ї–Є–Ј–∞—Ж–Є–Є. 2. –°–ї–∞–±–∞—П –Ј–∞–≤–Є—Б–Є–Љ–Њ—Б—В—М —Б—Е–Њ–і–Є–Љ–Њ—Б—В–Є –Њ—В —А–∞–Ј–Љ–µ—А–љ–Њ—Б—В–Є —Б–µ—В–Є. –Э–µ–і–Њ—Б—В–∞—В–Ї–Є. 1. –Ы–Њ–Ї–∞–ї—М–љ—Л–µ –Љ–Є–љ–Є–Љ—Г–Љ—Л. 2. –§–Њ—А–Љ–Є—А–Њ–≤–∞–љ–Є–µ —Д—Г–љ–Ї—Ж–Є–Є —Н–љ–µ—А–≥–Є–Є. 3. –Э–µ–±–Њ–ї—М—И–∞—П –µ–Љ–Ї–Њ—Б—В—М.

- 17. –Ю–±–ї–∞—Б—В–Є –њ—А–Є–Љ–µ–љ–µ–љ–Є—П 1. –Р—Б—Б–Њ—Ж–Є–∞—В–Є–≤–љ–∞—П –њ–∞–Љ—П—В—М. 2. –†–∞—Б–њ–Њ–Ј–љ–∞–≤–∞–љ–Є–µ –Њ–±—А–∞–Ј–Њ–≤. 3. –Ч–∞–і–∞—З–Є –Њ–њ—В–Є–Љ–Є–Ј–∞—Ж–Є–Є.

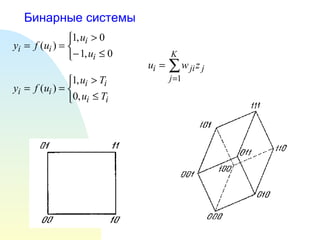

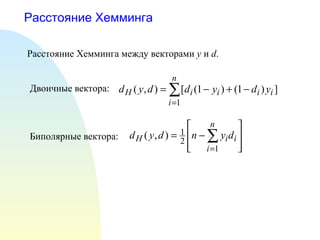

- 18. –†–∞—Б—Б—В–Њ—П–љ–Є–µ –•–µ–Љ–Љ–Є–љ–≥–∞ –†–∞—Б—Б—В–Њ—П–љ–Є–µ –•–µ–Љ–Љ–Є–љ–≥–∞ –Љ–µ–ґ–і—Г –≤–µ–Ї—В–Њ—А–∞–Љ–Є y –Є d . –Ф–≤–Њ–Є—З–љ—Л–µ –≤–µ–Ї—В–Њ—А–∞: –С–Є–њ–Њ–ї—П—А–љ—Л–µ –≤–µ–Ї—В–Њ—А–∞:

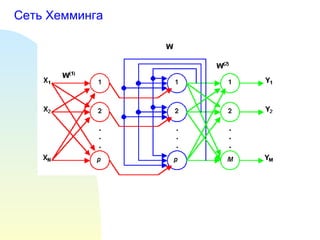

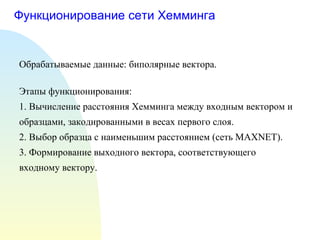

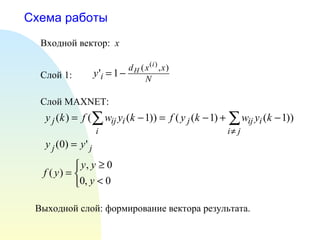

- 20. –§—Г–љ–Ї—Ж–Є–Њ–љ–Є—А–Њ–≤–∞–љ–Є–µ —Б–µ—В–Є –•–µ–Љ–Љ–Є–љ–≥–∞ –Ю–±—А–∞–±–∞—В—Л–≤–∞–µ–Љ—Л–µ –і–∞–љ–љ—Л–µ: –±–Є–њ–Њ–ї—П—А–љ—Л–µ –≤–µ–Ї—В–Њ—А–∞. –≠—В–∞–њ—Л —Д—Г–љ–Ї—Ж–Є–Њ–љ–Є—А–Њ–≤–∞–љ–Є—П: 1. –Т—Л—З–Є—Б–ї–µ–љ–Є–µ —А–∞—Б—Б—В–Њ—П–љ–Є—П –•–µ–Љ–Љ–Є–љ–≥–∞ –Љ–µ–ґ–і—Г –≤—Е–Њ–і–љ—Л–Љ –≤–µ–Ї—В–Њ—А–Њ–Љ –Є –Њ–±—А–∞–Ј—Ж–∞–Љ–Є, –Ј–∞–Ї–Њ–і–Є—А–Њ–≤–∞–љ–љ—Л–Љ–Є –≤ –≤–µ—Б–∞—Е –њ–µ—А–≤–Њ–≥–Њ —Б–ї–Њ—П. 2. –Т—Л–±–Њ—А –Њ–±—А–∞–Ј—Ж–∞ —Б –љ–∞–Є–Љ–µ–љ—М—И–Є–Љ —А–∞—Б—Б—В–Њ—П–љ–Є–µ–Љ (—Б–µ—В—М MAXNET). 3 . –§–Њ—А–Љ–Є—А–Њ–≤–∞–љ–Є–µ –≤—Л—Е–Њ–і–љ–Њ–≥–Њ –≤–µ–Ї—В–Њ—А–∞, —Б–Њ–Њ—В–≤–µ—В—Б—В–≤—Г—О—Й–µ–≥–Њ –≤—Е–Њ–і–љ–Њ–Љ—Г –≤–µ–Ї—В–Њ—А—Г.

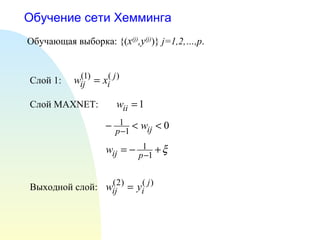

- 21. –Ю–±—Г—З–µ–љ–Є–µ —Б–µ—В–Є –•–µ–Љ–Љ–Є–љ–≥–∞ –Ю–±—Г—З–∞—О—Й–∞—П –≤—Л–±–Њ—А–Ї–∞: {( x (j) ,y (j) )} j=1,2,вА¶,p . –°–ї–Њ–є MAXNET : –°–ї–Њ–є 1: –Т—Л—Е–Њ–і–љ–Њ–є —Б–ї–Њ–є:

- 22. –°—Е–µ–Љ–∞ —А–∞–±–Њ—В—Л –Т—Е–Њ–і–љ–Њ–є –≤–µ–Ї—В–Њ—А: x –Т—Л—Е–Њ–і–љ–Њ–є —Б–ї–Њ–є: —Д–Њ—А–Љ–Є—А–Њ–≤–∞–љ–Є–µ –≤–µ–Ї—В–Њ—А–∞ —А–µ–Ј—Г–ї—М—В–∞—В–∞. –°–ї–Њ–є 1: –°–ї–Њ–є MAXNET :

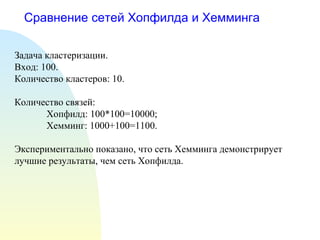

- 23. –°—А–∞–≤–љ–µ–љ–Є–µ —Б–µ—В–µ–є –•–Њ–њ—Д–Є–ї–і–∞ –Є –•–µ–Љ–Љ–Є–љ–≥–∞ –Ч–∞–і–∞—З–∞ –Ї–ї–∞—Б—В–µ—А–Є–Ј–∞—Ж–Є–Є. –Т—Е–Њ–і: 100. –Ъ–Њ–ї–Є—З–µ—Б—В–≤–Њ –Ї–ї–∞—Б—В–µ—А–Њ–≤: 10. –Ъ–Њ–ї–Є—З–µ—Б—В–≤–Њ —Б–≤—П–Ј–µ–є: –•–Њ–њ—Д–Є–ї–і: 100*100=10000; –•–µ–Љ–Љ–Є–љ–≥: 1000+100=1100. –≠–Ї—Б–њ–µ—А–Є–Љ–µ–љ—В–∞–ї—М–љ–Њ –њ–Њ–Ї–∞–Ј–∞–љ–Њ, —З—В–Њ —Б–µ—В—М –•–µ–Љ–Љ–Є–љ–≥–∞ –і–µ–Љ–Њ–љ—Б—В—А–Є—А—Г–µ—В –ї—Г—З—И–Є–µ —А–µ–Ј—Г–ї—М—В–∞—В—Л, —З–µ–Љ —Б–µ—В—М –•–Њ–њ—Д–Є–ї–і–∞.

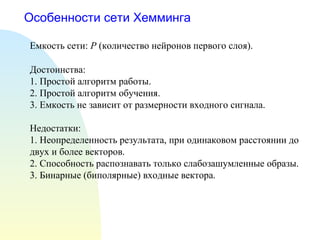

- 24. –Ю—Б–Њ–±–µ–љ–љ–Њ—Б—В–Є —Б–µ—В–Є –•–µ–Љ–Љ–Є–љ–≥–∞ –Х–Љ–Ї–Њ—Б—В—М —Б–µ—В–Є: P (–Ї–Њ–ї–Є—З–µ—Б—В–≤–Њ –љ–µ–є—А–Њ–љ–Њ–≤ –њ–µ—А–≤–Њ–≥–Њ —Б–ї–Њ—П). –Ф–Њ—Б—В–Њ–Є–љ—Б—В–≤–∞: 1. –Я—А–Њ—Б—В–Њ–є –∞–ї–≥–Њ—А–Є—В–Љ —А–∞–±–Њ—В—Л. 2. –Я—А–Њ—Б—В–Њ–є –∞–ї–≥–Њ—А–Є—В–Љ –Њ–±—Г—З–µ–љ–Є—П. 3. –Х–Љ–Ї–Њ—Б—В—М –љ–µ –Ј–∞–≤–Є—Б–Є—В –Њ—В —А–∞–Ј–Љ–µ—А–љ–Њ—Б—В–Є –≤—Е–Њ–і–љ–Њ–≥–Њ —Б–Є–≥–љ–∞–ї–∞. –Э–µ–і–Њ—Б—В–∞—В–Ї–Є: 1. –Э–µ–Њ–њ—А–µ–і–µ–ї–µ–љ–љ–Њ—Б—В—М —А–µ–Ј—Г–ї—М—В–∞—В–∞, –њ—А–Є –Њ–і–Є–љ–∞–Ї–Њ–≤–Њ–Љ —А–∞—Б—Б—В–Њ—П–љ–Є–Є –і–Њ –і–≤—Г—Е –Є –±–Њ–ї–µ–µ –≤–µ–Ї—В–Њ—А–Њ–≤. 2. –°–њ–Њ—Б–Њ–±–љ–Њ—Б—В—М —А–∞—Б–њ–Њ–Ј–љ–∞–≤–∞—В—М —В–Њ–ї—М–Ї–Њ —Б–ї–∞–±–Њ–Ј–∞—И—Г–Љ–ї–µ–љ–љ—Л–µ –Њ–±—А–∞–Ј—Л. 3. –С–Є–љ–∞—А–љ—Л–µ (–±–Є–њ–Њ–ї—П—А–љ—Л–µ) –≤—Е–Њ–і–љ—Л–µ –≤–µ–Ї—В–Њ—А–∞.