金融×础滨で解くべき问题は何か?

- 1. 金融 × AI で解くべき問題は何か? みずほ第一フィナンシャルテクノロジー/東京大学 永山恒彦

- 3. 自己紹介 3 永山 恒彦 みずほ第一フィナンシャルテクノロジー データアナリティクス技術開発部 東京大学 ? 2016年4月 みずほ銀行入行 ? 2016年11月~ みずほ第一フィナンシャルテクノロジーで勤務 ? 投資助言におけるニュースデータ活用のためのモデル開発 ? トランザクションデータを活用したスコアリングモデル開発 ? 機械学習自動化アプリケーションの開発とそれを活用したコンサルティング ? 金融文書(アナリストレポート?有価証券報告書など)の活用のための実証分析 ? 機械学習の技術調査 ? 2020年9月~ 博士課程入学

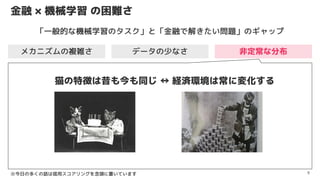

- 6. 金融 × 機械学習 の困難さ 6 メカニズムの複雑さ データの少なさ 非定常な分布 「一般的な機械学習のタスク」と「金融で解きたい問題」のギャップ

- 7. 金融 × 機械学習 の困難さ 7 メカニズムの複雑さ データの少なさ 非定常な分布 「犬と猫の分類」?「デフォルト予測」 犬 猫 犬 資産 100 負債 50 純資産 50 デフォルトする…? ※今日の多くの話は信用スコアリングを念頭に置いています 「一般的な機械学習のタスク」と「金融で解きたい問題」のギャップ

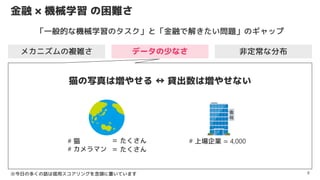

- 8. 金融 × 機械学習 の困難さ 8 非定常な分布 # 上場企業 ? 4,000 猫の写真は増やせる ? 貸出数は増やせない メカニズムの複雑さ データの少なさ ※今日の多くの話は信用スコアリングを念頭に置いています # 猫 # カメラマン = たくさん = たくさん 「一般的な機械学習のタスク」と「金融で解きたい問題」のギャップ

- 9. 金融 × 機械学習 の困難さ 9 非定常な分布 猫の特徴は昔も今も同じ ? 経済環境は常に変化する メカニズムの複雑さ データの少なさ ※今日の多くの話は信用スコアリングを念頭に置いています 「一般的な機械学習のタスク」と「金融で解きたい問題」のギャップ

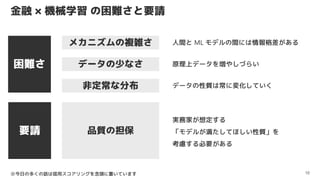

- 10. 金融 × 機械学習 の困難さと要請 10 困難さ 非定常な分布 メカニズムの複雑さ データの少なさ 要請 品質の担保 人間と ML モデルの間には情報格差がある 原理上データを増やしづらい データの性質は常に変化していく 実務家が想定する 「モデルが満たしてほしい性質」を 考慮する必要がある ※今日の多くの話は信用スコアリングを念頭に置いています

- 11. 本日のテーマ 11 困難さ 非定常な分布 メカニズムの複雑さ データの少なさ 要請 品質の担保 人間と ML モデルの間には情報格差がある 原理上データを増やしづらい データの性質は常に変化していく 実務家が想定する 「モデルが満たしてほしい性質」を 考慮する必要がある ※今日の多くの話は信用スコアリングを念頭に置いています 金融 × 機械学習の 困難さのもとで 求められる要請?品質とは? 本日のテーマ

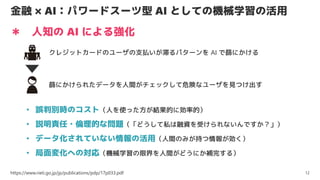

- 12. 金融 × AI:パワードスーツ型 AI としての機械学習の活用 12 https://www.rieti.go.jp/jp/publications/pdp/17p033.pdf * 人知の AI による強化 クレジットカードのユーザの支払いが滞るパターンを AI で篩にかける 篩にかけられたデータを人間がチェックして危険なユーザを見つけ出す ? 誤判別時のコスト(人を使った方が結果的に効率的) ? 説明責任?倫理的な問題(「どうして私は融資を受けられないんですか?」) ? データ化されていない情報の活用(人間のみが持つ情報が効く) ? 局面変化への対応(機械学習の限界を人間がどうにか補完する)

- 13. そのモデル、どう使う? 13 [Lai+ FAccT19] 人間が意思決定 モデルで意思決定 Human-AI Collaboration モデル の出力と 人間 の判断を 組みあわせて 最終的な意思決定

- 14. Human-AI Collaboration:モデルへの要件 14 * モデルの予測の一貫性 * 人间の判断を前提にしたモデリング

- 15. 人间の判断を前提にしたモデリング 15 [Bansal+ HCOMP19] モデル単体のパフォーマンス向上 Human-AI Team のパフォーマンス向上 重要な要素:Mental Model が適切に構築できるか? ≒モデルのエラー境界について人間が持つモデル 予測が正しい領域 予測を誤る領域 モデルのエラー境界 Mental Model

- 16. モデルの予測の一貫性 16 [Bansal+ AAAI19] モデルは1回作れば終わり? NO! 随時更新されるのが普通 Acc: 95% Decision Making & Feedback Age>70 なら モデルを信じてよさそう 旧モデル データが増えたので モデルを更新します 正解率も上がりました!! Age>70 の時の正解率は 下がったけど… Acc: 98% 新モデル !?!!?

- 17. Human-AI Collaboration:モデルへの要件 17 [Bansal+ HCOMP19] 1 Parsimonious Error Boundaries 2 Small Stochasticity of System Errors 3 Low Task Dimensionality 4 Backward Compatibility of Error Boundaries エラー境界が単純であること エラー境界に不確実性がないこと タスクの次元が低いこと モデル更新時にエラー境界が大きく変化しないこと

- 18. そのモデル、どう使う?-具体例(1/2) 18 * モデルの出力をもとに人間が判断 - 人間が全件見るが参考情報としてモデルを利用 [Mozannar+ ICML20] 資産 100 負債 50 純資産 50 PD=10% OK! 資産 100 負債 90 純資産 10 PD=90% NG! 前頁までの話はこの状況を念頭に置いていた

- 19. そのモデル、どう使う?-具体例(2/2) 19 * 予測の確信度が低いときのみ人間が判断 [Mozannar+ ICML20] 資産 100 負債 50 純資産 50 ??? OK! 資産 100 負債 90 純資産 10 倒れる! NG! - 確信度が高いサンプルはモデルの出力を利用

- 20. 予測の確信度が低いときのみ人間が判断するケース 20 * Learning to Defer Classifier Rejector 人間の予測 Defer しない Defer する モデルのコスト 人間のコスト * 「人間のコスト」が定数のとき “Learning with Rejection” - 「人間のコスト」=「誤判別時のコスト」+「人間を使うコスト」 * Learning to Defer は 人間の誤判別やバイアスを考慮 した定式化 [Madras+ NeurIPS18] [Mozannar+ ICML20]

- 21. Human-AI Collaboration:どのように検証するか? 21 実際に検証を行おうとすると難しい * 定量化しづらい要素がたくさん * 現場の意思決定プロセスにモデルを組み込み PDCA サイクルを回せれば何とかなるが…? ? 人間の Mental Model ってどうやって評価するの? (※) ? 人間が評価する際のコストってどうやって決めるの? ? … (※)論文では実験用のプラットフォームを作り人為的に環境を作ることでこの問題をうまく回避しているような印象 ? 人間を用いた評価のスキーム作りはいろいろと大変 ? 手元のデータだけで何とかしたい

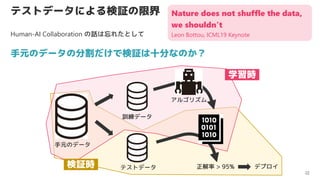

- 22. テストデータによる検証の限界 22 手元のデータの分割だけで検証は十分なのか? 手元のデータ テストデータ 訓練データ 正解率 > 95% デプロイ 学習時 検証時 Nature does not shuffle the data, we shouldn’t Leon Bottou, ICML19 Keynote アルゴリズム Human-AI Collaboration の話は忘れたとして

- 24. どのように検証を行うべきか? 24 * 投資戦略のバックテストのための研究プロトコル [Arnott+ 18] ※多少意訳してます 合理的な仮説をベースにモデリングせよ 同一テストデータで何度も検証する場合は注意 データのとり方に留意 CV は真の Out-of-sample 検証でないので注意 非定常性の存在に注意せよ シンプルなモデルの方が好ましい 戦略が勝てるか否かでなく研究の質を重視せよ

- 25. 金融機関のストレステスト 25 * ストレスシナリオ を想定し [池森, 18] * その場合の ダメージをシミュレーション して * アクションプラン をあらかじめ議論しておく ? 景気の大幅な悪化 ? 資産価格の急落 ? 金融市場の流動性枯渇 ? 損失の発生 ? 資金繰りの悪化 ポイントは 一度も観測されていないシナリオを シミュレーションで作ること リスク管理体制の不備をカバーするための検証

- 26. ストレスシナリオでの検証 26 * ストレスシナリオ=非 IID データを活用 * モデルが信頼に足るか?本質的な構造をエンコードしているか検証 1 Stratified Performance Evaluation 2 Shifted Performance Evaluation 3 Contrastive Evaluation Subgroup で検証 分布をシフトさせて検証 特定サンプルに対して特定の変換を施し出力を検証 [D'Amour+ 20]

- 27. Stratified Performance Evaluation 27 1 [Oakden-Rayner+ 19] * ラベル付けされた各クラスは 複数のサブセットから構成される * 全体の正解率だけを見ていると 性能が劣る少数のサブセットや Spurious Correlation を見落とす ベンガル シャム ペルシャ ラベル:猫 2% 38% 60% ChestXray14 の例: * 気胸のラベルがついた画像のうち大半は胸腔チューブあり (気胸の治療として用いられるもの) * むしろ胸腔チューブの写っていない画像 を正しく予測しないと生死に関わる

- 28. Shifted Performance Evaluation 28 2 訓練データの分布と異なる分布を作る * ラベルを変えないように入力を変換させる ImageNet の画像を変換した ImageNetC など * データの収集の方法を変える ImageNet に含まれないようなイレギュラーな ケースを集めたObjectNet など [Hendrycks+ 19] [Barbu+ 19] どんな変換が考えられるか/どうやってデータを集めなおすかは 現実的には大きな問題

- 29. Contrastive Evaluation 29 3 個別サンプルごとに変換を施し予測値の挙動を確認 * Fairness にフォーカスした研究が多数 * NLP においてもいくつかテストが提案されている サンプルごとにラベルを保持する/反転させる変換が作れればそれをもとにデータ拡張して学習できる Sensitive attribute のみが変わってもモデルの出力は変わってほしくない ②:分布をシフトさせたデータセット全体の精度にフォーカス ③:個々のサンプルの予測値が期待通り変わるかにフォーカス 文章中の地名が変わってもセンチメントは変わってほしくない [Kaushik+ 20] [Ribeiro+ 20] [Kusner+ 17]

- 30. 【まとめ】金融 × 機械学習で求められる要請?品質とは? 30 ? 非定常な分布を前提にしたモデルの信頼性が必要 ? 適切なストレスシナリオを設定してモデルが信頼できそうか確認 ? モデルに人間が介在した意思決定が多く 状況毎に様々な要件 ? 検証にも人手が必要なので検証は高コスト 資産 100 負債 50 純資産 50 ここ6カ月の日経平均 ?

- 31. Reference ? Arnott, Robert D. and Harvey, Campbell R. and Markowitz, Harry, A Backtesting Protocol in the Era of Machine Learning (November 21, 2018). Available at SSRN: https://ssrn.com/abstract=3275654 or http://dx.doi.org/10.2139/ssrn.3275654 ? Gagan Bansal, Besmira Nushi, Ece Kamar, Walter S. Lasecki, Daniel S. Weld, Eric HorvitzIn. Beyond Accuracy: The Role of Mental Models in Human-AI Team Performance. In Proceedings of the AAAI Conference on Human Computation and Crowdsourcing, 2019. ? Gagan Bansal, Besmira Nushi, Ece Kamar, Daniel S. Weld, Walter S. Lasecki and Eric Horvitz. Updates in Human-AI Teams: Understanding and Addressing the Performance/Compatibility Tradeoff. In AAAI, 2019. ? Andrei Barbu, David Mayo, Julian Alverio, William Luo, Christopher Wang, Dan Gutfreund, Josh Tenenbaum, Boris Katz. ObjectNet: A large-scale bias-controlled dataset for pushing the limits of object recognition models. In NeurIPS, 2019. ? A. D’Amour, K. Heller, D. Moldovan, B. Adlam, B. Alipanahi, A. Beutel, C. Chen, J. Deaton, J. Eisenstein, M. D. Hoffman, et al. Underspecification presents challenges for credibility in modern machine learning. arXiv preprint arXiv:2011.03395, 2020. ? Dan Hendrycks and Thomas Dietterich. Benchmarking Neural Network Robustness to Common Corruptions and Perturbations. In ICLR, 2019. ? Divyansh Kaushik, Eduard Hovy, Zachary Lipton. Learning The Difference That Makes A Difference With Counterfactually-Augmented Data. In ICLR, 2020. ? Matt J. Kusner, Joshua Loftus, Chris Russell, Ricardo Silva. Counterfactual Fairness. In NeurIPS, 2017. ? Vivian Lai and Chenhao Tan. On Human Predictions with Explanations and Predictions of Machine Learning Models: A Case Study on Deception Detection. In FAccT, 2019. ? David Madras, Toniann Pitassi & Richard Zemel. Predict Responsibly: Improving Fairness and Accuracy by Learning to Defer. In NeurIPS, 2018. ? Hussein Mozannar, David Sontag. Consistent Estimators for Learning to Defer to an Expert. In ICML, 2020. ? Luke Oakden-Rayner, Jared Dunnmon, Gustavo Carneiro, Christopher Ré. Hidden Stratification Causes Clinically Meaningful Failures in Machine Learning for Medical Imaging. In Machine Learning for Health (ML4H) at NeurIPS, 2019. ? Marco Tulio Ribeiro, Tongshuang Wu, Carlos Guestrin, Sameer Singh. Beyond Accuracy: Behavioral Testing of NLP Models with CheckList. In ACL, 2020. ? 池森 俊文. 銀行経営のための数理的枠組み―金融リスクの制御. プログレス,2018. (拾ってきた画像) ? https://press.share-wis.com/german-hyperinflation ? https://buzzap.jp/news/20140324-cantury-old-animal-photography/ 31

![そのモデル、どう使う?

13

[Lai+ FAccT19]

人間が意思決定 モデルで意思決定

Human-AI Collaboration

モデル の出力と 人間 の判断を 組みあわせて

最終的な意思決定](https://image.slidesharecdn.com/20210313-210313070054/85/xAI-13-320.jpg)

![人间の判断を前提にしたモデリング

15

[Bansal+ HCOMP19]

モデル単体のパフォーマンス向上

Human-AI Team のパフォーマンス向上

重要な要素:Mental Model が適切に構築できるか?

≒モデルのエラー境界について人間が持つモデル

予測が正しい領域

予測を誤る領域

モデルのエラー境界

Mental Model](https://image.slidesharecdn.com/20210313-210313070054/85/xAI-15-320.jpg)

![モデルの予測の一貫性

16

[Bansal+ AAAI19]

モデルは1回作れば終わり?

NO! 随時更新されるのが普通

Acc:

95%

Decision Making

& Feedback

Age>70 なら

モデルを信じてよさそう

旧モデル

データが増えたので

モデルを更新します

正解率も上がりました!!

Age>70 の時の正解率は

下がったけど…

Acc:

98%

新モデル

!?!!?](https://image.slidesharecdn.com/20210313-210313070054/85/xAI-16-320.jpg)

![Human-AI Collaboration:モデルへの要件

17

[Bansal+ HCOMP19]

1 Parsimonious Error Boundaries

2 Small Stochasticity of System Errors

3 Low Task Dimensionality

4 Backward Compatibility of Error Boundaries

エラー境界が単純であること

エラー境界に不確実性がないこと

タスクの次元が低いこと

モデル更新時にエラー境界が大きく変化しないこと](https://image.slidesharecdn.com/20210313-210313070054/85/xAI-17-320.jpg)

![そのモデル、どう使う?-具体例(1/2)

18

* モデルの出力をもとに人間が判断

- 人間が全件見るが参考情報としてモデルを利用

[Mozannar+ ICML20]

資産

100

負債 50

純資産 50 PD=10% OK!

資産

100

負債 90

純資産 10

PD=90% NG!

前頁までの話はこの状況を念頭に置いていた](https://image.slidesharecdn.com/20210313-210313070054/85/xAI-18-320.jpg)

![そのモデル、どう使う?-具体例(2/2)

19

* 予測の確信度が低いときのみ人間が判断

[Mozannar+ ICML20]

資産

100

負債 50

純資産 50 ??? OK!

資産

100

負債 90

純資産 10

倒れる!

NG!

- 確信度が高いサンプルはモデルの出力を利用](https://image.slidesharecdn.com/20210313-210313070054/85/xAI-19-320.jpg)

![予測の確信度が低いときのみ人間が判断するケース

20

* Learning to Defer

Classifier Rejector 人間の予測 Defer しない Defer する

モデルのコスト 人間のコスト

* 「人間のコスト」が定数のとき “Learning with Rejection”

- 「人間のコスト」=「誤判別時のコスト」+「人間を使うコスト」

* Learning to Defer は 人間の誤判別やバイアスを考慮 した定式化

[Madras+ NeurIPS18] [Mozannar+ ICML20]](https://image.slidesharecdn.com/20210313-210313070054/85/xAI-20-320.jpg)

![どのように検証を行うべきか?

23

* 投資戦略のバックテストのための研究プロトコル [Arnott+ 18]](https://image.slidesharecdn.com/20210313-210313070054/85/xAI-23-320.jpg)

![どのように検証を行うべきか?

24

* 投資戦略のバックテストのための研究プロトコル [Arnott+ 18]

※多少意訳してます

合理的な仮説をベースにモデリングせよ

同一テストデータで何度も検証する場合は注意

データのとり方に留意

CV は真の Out-of-sample 検証でないので注意

非定常性の存在に注意せよ

シンプルなモデルの方が好ましい

戦略が勝てるか否かでなく研究の質を重視せよ](https://image.slidesharecdn.com/20210313-210313070054/85/xAI-24-320.jpg)

![金融機関のストレステスト

25

* ストレスシナリオ を想定し

[池森, 18]

* その場合の ダメージをシミュレーション して

* アクションプラン をあらかじめ議論しておく

? 景気の大幅な悪化

? 資産価格の急落

? 金融市場の流動性枯渇

? 損失の発生

? 資金繰りの悪化

ポイントは

一度も観測されていないシナリオを

シミュレーションで作ること

リスク管理体制の不備をカバーするための検証](https://image.slidesharecdn.com/20210313-210313070054/85/xAI-25-320.jpg)

![ストレスシナリオでの検証

26

* ストレスシナリオ=非 IID データを活用

* モデルが信頼に足るか?本質的な構造をエンコードしているか検証

1 Stratified Performance Evaluation

2 Shifted Performance Evaluation

3 Contrastive Evaluation

Subgroup で検証

分布をシフトさせて検証

特定サンプルに対して特定の変換を施し出力を検証

[D'Amour+ 20]](https://image.slidesharecdn.com/20210313-210313070054/85/xAI-26-320.jpg)

![Stratified Performance Evaluation

27

1

[Oakden-Rayner+ 19]

* ラベル付けされた各クラスは

複数のサブセットから構成される

* 全体の正解率だけを見ていると

性能が劣る少数のサブセットや

Spurious Correlation を見落とす

ベンガル

シャム

ペルシャ

ラベル:猫

2% 38% 60%

ChestXray14 の例:

* 気胸のラベルがついた画像のうち大半は胸腔チューブあり

(気胸の治療として用いられるもの)

* むしろ胸腔チューブの写っていない画像 を正しく予測しないと生死に関わる](https://image.slidesharecdn.com/20210313-210313070054/85/xAI-27-320.jpg)

![Shifted Performance Evaluation

28

2

訓練データの分布と異なる分布を作る

* ラベルを変えないように入力を変換させる

ImageNet の画像を変換した ImageNetC など

* データの収集の方法を変える

ImageNet に含まれないようなイレギュラーな

ケースを集めたObjectNet など

[Hendrycks+ 19]

[Barbu+ 19]

どんな変換が考えられるか/どうやってデータを集めなおすかは

現実的には大きな問題](https://image.slidesharecdn.com/20210313-210313070054/85/xAI-28-320.jpg)

![Contrastive Evaluation

29

3

個別サンプルごとに変換を施し予測値の挙動を確認

* Fairness にフォーカスした研究が多数

* NLP においてもいくつかテストが提案されている

サンプルごとにラベルを保持する/反転させる変換が作れればそれをもとにデータ拡張して学習できる

Sensitive attribute のみが変わってもモデルの出力は変わってほしくない

②:分布をシフトさせたデータセット全体の精度にフォーカス

③:個々のサンプルの予測値が期待通り変わるかにフォーカス

文章中の地名が変わってもセンチメントは変わってほしくない

[Kaushik+ 20]

[Ribeiro+ 20]

[Kusner+ 17]](https://image.slidesharecdn.com/20210313-210313070054/85/xAI-29-320.jpg)