【DL輪読会】SimPer: Simple self-supervised learning of periodic targets( ICLR 2023 )

- 1. 1 Atsuya Kitada, Matsuo Lab, M2 SimPer: Simple self-supervised learning of periodic targets ( ICLR 2023 )

- 2. 2 書誌情報 SimPer: Simple self-supervised learning of periodic targets ? ICLR 2023 Notable-top-5% ? 著者:Yuzhe Yang*1, Xin Liu*2, Jiang Wu * 3, Silviu Borac * 3, Dina Katabi * 1, Ming-Zher Poh * 3, Daniel McDuff * 2,3 (*1 MIT CSAIL, *2 University of Washington, *3 Google)

- 3. 3 概要 背景 ? 周期性を持つデータは機械学習の応用先として重要だが、ラベリングが困難である ? データの周期性を考慮した自己教師あり学習が提案されていない 提案手法 ? インスタンスの違いで正例/負例を定義していた従来の対照学習と異なり、周期性の 違いで正例/負例を定義 ? InfoNCE損失から、周期的な類似性を測る損失関数へと拡張。 有効性 ? 様々な周期性予測タスクで従来のSSLを上回る精度。 ? データ効率性が高い。 ? 未知データに対する汎化性能が高い。

- 4. 4 背景 周期性を持つデータ?タスクは機械学習の応用先として重要だが、ラベリングが困難である 応用先の例 ? ヘルスケア領域 ? 心拍数、呼吸、血圧 ? リモートセンシング ? 降水パターン、地表の温度変化 ? 行動分析 ? 人物動作の周期?回数 周期性を持ったデータのラベリングは一般に困難 ? 医療用センサー ? プライバシーに配慮した生体計測

- 5. 5 背景 従来の自己教師あり学習手法は周期的な帰納バイアスを組み込んでいない ? Contrastive Lossに基づく一連の研究が自己教師あり学習で成功を収めている。 ? 同一のサンプルの異なるビュー(正例)に対しては似た埋め込みに、異なるサンプル (負例)に対しては異なる埋め込みになるよう学習する。 ? ビデオ理解やアクション分類などの時系列データ領域への拡張がなされている。 ? Video representation learning by recognizing temporal transformations. ? Spatiotemporal Contrastive Video Representation Learning ? しかし、現在の自己教師あり学習は周期性に関する帰納バイアスが見落とされている。

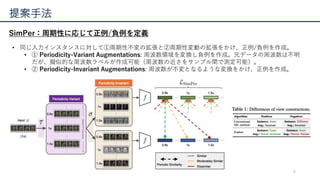

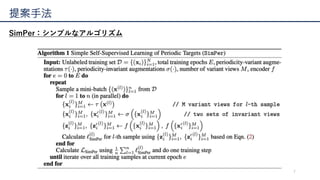

- 6. 6 提案手法 SimPer:周期性に応じて正例/負例を定義 ? 同じ入力インスタンスに対して①周期性不変の拡張と②周期性変動の拡張をかけ、正例/負例を作成。 ? ① Periodicity-Variant Augmentations: 周波数領域を変換し負例を作成。元データの周波数は不明 だが、擬似的な周波数ラベルが作成可能(周波数の近さをサンプル間で測定可能)。 ? ② Periodicity-Invariant Augmentations: 周波数が不変となるような変換をかけ、正例を作成。

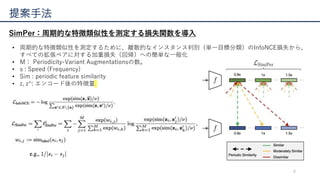

- 8. 8 提案手法 SimPer:周期的な特徴類似性を測定する損失関数を導入 ? 周期的な特徴類似性を測定するために、離散的なインスタンス判別(単一目標分類)のInfoNCE損失から、 すべての拡張ペアに対する加重損失(回帰)への簡単な一般化 ? M: Periodicity-Variant Augmentationsの数。 ? s : Speed (Frequency) ? Sim : periodic feature similarity ? z, z^: エンコード後の特徴量

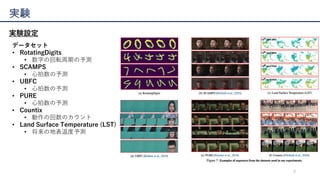

- 9. 9 実験 実験設定 データセット ? RotatingDigits ? 数字の回転周期の予測 ? SCAMPS ? 心拍数の予測 ? UBFC ? 心拍数の予測 ? PURE ? 心拍数の予測 ? Countix ? 動作の回数のカウント ? Land Surface Temperature (LST) ? 将来の地表温度予測

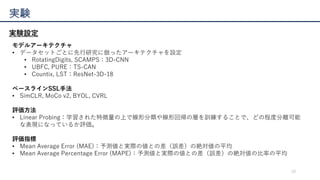

- 10. 10 実験 実験設定 モデルアーキテクチャ ? データセットごとに先行研究に倣ったアーキテクチャを設定 ? RotatingDigits, SCAMPS:3D-CNN ? UBFC, PURE:TS-CAN ? Countix, LST:ResNet-3D-18 ベースラインSSL手法 ? SimCLR, MoCo v2, BYOL, CVRL 評価方法 ? Linear Probing:学習された特徴量の上で線形分類や線形回帰の層を訓練することで、どの程度分離可能 な表現になっているか評価。 評価指標 ? Mean Average Error (MAE):予測値と実際の値との差(誤差)の絶対値の平均 ? Mean Average Percentage Error (MAPE):予測値と実際の値との差(誤差)の絶対値の比率の平均

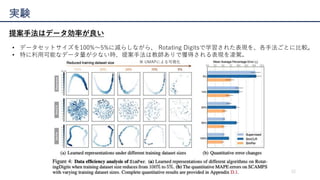

- 12. 12 実験 提案手法はデータ効率が良い ? データセットサイズを100%?5%に減らしながら、 Rotating Digitsで学習された表現を、各手法ごとに比較。 ? 特に利用可能なデータ量が少ない時、提案手法は教師ありで獲得される表現を凌駕。 ※ UMAPによる可視化

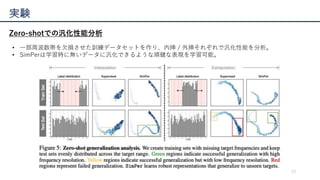

- 13. 13 実験 Zero-shotでの汎化性能分析 ? 一部周波数帯を欠損させた訓練データセットを作り、内挿 / 外挿それぞれで汎化性能を分析。 ? SimPerは学習時に無いデータに汎化できるような頑健な表現を学習可能。

- 14. 14 結論(再掲) 背景 ? 周期性を持つデータは機械学習の応用先として重要だが、ラベリングが困難である ? データの周期性を考慮した自己教師あり学習が提案されていない 提案手法 ? インスタンスの違いで正例/負例を定義していた従来の対照学習と異なり、周期性の 違いで正例/負例を区別 ? InfoNCE損失から、周期的な類似性を測る損失関数へと拡張。 有効性 ? 多様な周期性予測タスクで従来のSSLを上回る精度。 ? データ効率性が高い。 ? 未知データに対する汎化性能が高い。

Editor's Notes

- #7: データの負の視点は、周波数領域での変換を通じて構築されます。 入力シーケンスxに対して、周波数変化の補強τ ∈ Tを定義します。ここで、TはNyquistサンプリング定理の下で可能な任意の速度でxを変化させる変換のセットを表します。 図2に示すように、SimPerはxをM回補強し、一連の速度(周波数)変化したサンプル {τ1(x), τ2(x), ..., τM(x)}を得ます。これらの相対速度はs1 < s2 < ... < sM、si ∝ freq(τi(x))を満たします。 このような補強は、シフトした周波数を持つ基礎となる周期的なターゲットを効果的に変更し、異なる負の視点を作り出します。 よって、元の目標周波数は不明であるが、我々はラベルなしのxに対して擬似的な速度(周波数)ラベルを効果的に考案します。 実際には、速度変化の範囲を[smin , smax]の範囲内に制限し、時間次元での拡張シーケンスが一定の長さ以上になるように確認します。 周期性不変の補強σ ∈ Sをさらに定義します。ここで、Sは元の入力のアイデンティティを変えない変換の集合を示します。 集合が有限であるとき、つまり、S = {σ1,...,σk}であるとき、我々はfreq(σi(x)) = freq(σj(x)),?i,j ∈ [k]を持ちます。 このような補強は、周期性の観点からデータの不変性を学習するために使用でき、異なる正の視点を作り出します。 実際には、空間的な(例:クロップ&リサイズ)および時間的な(例:リバース、ディレイ)補強を利用して、同一のインスタンスの異なる視点を作り出します(図2参照)。

- #8: データの負の視点は、周波数領域での変換を通じて構築されます。 入力シーケンスxに対して、周波数変化の補強τ ∈ Tを定義します。ここで、TはNyquistサンプリング定理の下で可能な任意の速度でxを変化させる変換のセットを表します。 図2に示すように、SimPerはxをM回補強し、一連の速度(周波数)変化したサンプル {τ1(x), τ2(x), ..., τM(x)}を得ます。これらの相対速度はs1 < s2 < ... < sM、si ∝ freq(τi(x))を満たします。 このような補強は、シフトした周波数を持つ基礎となる周期的なターゲットを効果的に変更し、異なる負の視点を作り出します。 よって、元の目標周波数は不明であるが、我々はラベルなしのxに対して擬似的な速度(周波数)ラベルを効果的に考案します。 実際には、速度変化の範囲を[smin , smax]の範囲内に制限し、時間次元での拡張シーケンスが一定の長さ以上になるように確認します。 周期性不変の補強σ ∈ Sをさらに定義します。ここで、Sは元の入力のアイデンティティを変えない変換の集合を示します。 集合が有限であるとき、つまり、S = {σ1,...,σk}であるとき、我々はfreq(σi(x)) = freq(σj(x)),?i,j ∈ [k]を持ちます。 このような補強は、周期性の観点からデータの不変性を学習するために使用でき、異なる正の視点を作り出します。 実際には、空間的な(例:クロップ&リサイズ)および時間的な(例:リバース、ディレイ)補強を利用して、同一のインスタンスの異なる視点を作り出します(図2参照)。

- #9: LSimPerは、離散的なインスタンス判別(単一目標分類)のInfoNCE損失から、すべての拡張ペアに対する加重損失(ソフト回帰バリアント)への簡単な一般化です。ここで、ソフトターゲットexp(wi,j )/Σk exp(wi,k )は、各ペアのラベル(速度)類似性wi,jによって駆動されます。 ラベルが離散的になると(すなわち、wi,j ∈ {0, 1})、LSimPerは元のInfoNCE損失に退化します。 付録D.4.4で示していますが、このような一般化された損失を通じた連続性モデリングは、単純にInfoNCEを適用するよりも優れたダウンストリームパフォーマンスを達成するのに役立ちます。