[IGC2018] м—”м”ЁмҶҢн”„нҠё мқҙкІҪмў… - мӢ¬мёөк°•нҷ”н•ҷмҠөмқ„ нҷңмҡ©н•ң н”„лЎңкІҢмқҙлЁё мҲҳмӨҖмқҳ AI л§Ңл“Өкё°

- 2. м§ҖлӮңлІҲ IGC к°•м—°: 2016-10-07 л§Ҳм§Җл§ү Comment: вҖңлҚ” л°ңм „мӢңмјң мқҙ мһҗлҰ¬м—җм„ң лӢӨмӢң кіөмң н• мҲҳ мһҲлҠ” мӢңк°„мқ„ к°Җм§ҖлҸ„лЎқ н•ҳкІ мҠө I. Overview

- 3. Contents вҖңмӢ¬мёөк°•нҷ”н•ҷмҠөмқ„ нҷңмҡ©н•ң н”„лЎңкІҢмқҙлЁё мҲҳмӨҖмқҳ AI л§Ңл“Өкё°вҖқ I. Overview II. к°•нҷ”н•ҷмҠө III. B&S 비л¬ҙ AI IV. B&S мӣ”л“ңмұ”н”јм–ёмүҪ Blind Match I. Overview

- 4. Game AI Since 2011 Vision AI Since 2017 Speech AI Since 2016 Knowledge AI Since 2011 Language AI Since 2014 Knowledge Lab Language Lab Vision TFSpeech Lab Game AI Lab AI Center NLP Center I. Overview NCSOFT AI R&D кё°мҲ мҳҒм—ӯ

- 5. NCSOFT Game AI AI Assistant: кІҢмһ„кіј кҙҖл Ёлҗң мқјмқ„ лҸ„мҷҖмЈјлҠ” AI вҖңкІҢмһ„м—җ н•„мҡ”н•ң AIлҘј н”„лЎңк·ёлһҳл°ҚвҖқ к°ңл°ңмһҗ Assistant к°•нҷ”н•ҷмҠө кё°л°ҳ кІҢмһ„ Playing AI вҖңк·ёлһҳн”Ҫ лҰ¬мҶҢмҠӨлҘј л””мһҗмқёвҖқ м•„нӢ°мҠӨнҠё Assistant AI кё°л°ҳ м• лӢҲл©”мқҙм…ҳ кё°мҲ вҖңкІҢмһ„мқ„ кё°нҡҚн•ҳкі м„Өкі„вҖқ кё°нҡҚмһҗ Assistant мһҗлҸҷ м „нҲ¬ л°ёлҹ°мҠӨ л°Ҹ мҪҳн…җмё мғқм„ұ м–ҙл–»кІҢ н•ҳл©ҙ м§ҖлЈЁн•ң мҲҳмһ‘м—…мқ„ мӨ„мқҙкі , мӮ¬лһҢмқҙ м°Ҫмқҳм Ғмқё мқјм—җ м „л…җн•ҳкІҢ лҸ„мҡё мҲҳ мһҲмқ„к№Ң? I. Overview

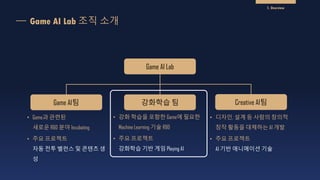

- 6. Game AI Lab Game AIнҢҖ к°•нҷ”н•ҷмҠө нҢҖ Creative AIнҢҖ вҖў Gameкіј кҙҖл Ёлҗң мғҲлЎңмҡҙ R&D 분야 Incubating вҖў мЈјмҡ” н”„лЎңм қнҠё мһҗлҸҷ м „нҲ¬ л°ёлҹ°мҠӨ л°Ҹ мҪҳн…җмё мғқ м„ұ вҖў к°•нҷ” н•ҷмҠөмқ„ нҸ¬н•Ён•ң Gameм—җ н•„мҡ”н•ң Machine Learning кё°мҲ R&D вҖў мЈјмҡ” н”„лЎңм қнҠё к°•нҷ”н•ҷмҠө кё°л°ҳ кІҢмһ„ Playing AI вҖў л””мһҗмқё, м„Өкі„ л“ұ мӮ¬лһҢмқҳ м°Ҫмқҳм Ғ м°Ҫмһ‘ нҷңлҸҷмқ„ лҢҖмІҙн•ҳлҠ” AI к°ңл°ң вҖў мЈјмҡ” н”„лЎңм қнҠё AI кё°л°ҳ м• лӢҲл©”мқҙм…ҳ кё°мҲ Game AI Lab мЎ°м§Ғ мҶҢк°ң I. Overview

- 7. к°•нҷ”н•ҷмҠө R&D History 2016 2016. к°Җмқ„ 2018.9.15 л¬ҙн•ңмқҳ нғ‘ м¶ңмӢң B&S AI v1.0 B&S AI v2.0 к°ңл°ң мӢңмһ‘ B&S мӣ”л“ңмұ”н”јм–ёмүҪ Blind Match вҖңAI vs. н”„лЎңкІҢмқҙлЁёвҖқ I. Overview 2016. к°Җмқ„, B&S мӣ”л“ңмұ”н”јм–ёмүҪ

- 8. B&S мӣ”л“ңмұ”н”јм–ёмүҪ (9.15) мӨҖкІ°мҠ№, кІ°мҠ№ мӮ¬мқҙ Blind Match вҖңAI vs. н”„лЎңкІҢмқҙлЁёвҖң I. Overview

- 9. Blind Match: AI vs н”„лЎңкІҢмқҙлЁё лҢҖкІ°(3лӘ…, 3м „2мҠ№м ң 3кІҪкё°) Full мҳҒмғҒ: https://www.youtube.com/watch?v=BY2Srj8yJAM I. Overview

- 10. II. к°•нҷ”н•ҷмҠө

- 11. вҖў вҖңLearning without a TeacherвҖқ вҖў м•„кё°мқҳ н•ҷмҠө кіјм •кіј ліём„ұмқ„ лӘЁлҚёл§Ғ вҖў кё°кұ°лӮҳ кұ·лҠ” лІ•мқ„ м•Ңм•„к°ҖлҠ” кіјм •м—җм„ң, м§Ғм ‘ н–үлҸҷмқ„ н•ҳкі Feedbackмқ„ нҶөн•ҙ м җм җ лҚ” лӮҳмқҖ н–үлҸҷмқ„ н•ҳкІҢ лҗЁ Trial Error Great conceptual leaps л°ҳліөлҗң Trial & Error кіјм •м—җм„ң Feedbackм—җ мқҳн•ҙм„ң н•ҷмҠө к°•нҷ”н•ҷмҠө [1/3] II. к°•нҷ”н•ҷмҠө

- 12. пғј н•ҷмҠө мқҙм „ пғј н•ҷмҠө мқҙнӣ„ Example в‘ : нҢ¬мјҖмқө л’Ө집기 лЎңлҙҮ Trial пғ м„ұкіө, мӢӨнҢЁ Feedback пғ кҙҖм Ҳм—җ мһ…л ҘлҗҳлҠ” нһҳмқ„ мЎ°м • пғ лӢӨмӢң Trial вҖҰ. к°•нҷ”н•ҷмҠө [2/3] Task лЎңлҙҮ нҢ”мқҳ мӣҖм§Ғмһ„мқ„ м ңм–ҙн•ҳм—¬ нҢ¬мјҖмқө л’Ө집기 What to learn (Action) к°Ғ кҙҖм Ҳм—җ мһ…л ҘлҗҳлҠ” нһҳ мЎ°м Ҳ Feedback (Reward) нҢ¬мјҖмқө л’Ө집기лҘј м–јл§ҲлӮҳ мһҳн–ҲлҠ”к°Җ? II. к°•нҷ”н•ҷмҠө

- 13. к°•нҷ”н•ҷмҠө [3/3] Example в‘Ў: Playing Atari [Deepmind] Task Breakout кІҢмһ„мқ„ Play What to learn (Action) BarлҘј мўҢмҡ°лЎң мӣҖм§Ғмһ„ (2к°ң лҸҷмһ‘) Feedback (Reward) м–јл§ҲлӮҳ кі л“қм җмқ„ мҳ¬л ёлҠ”к°Җ? [ 10분 н•ҷмҠө ] [ 120분 н•ҷмҠө ] [ 240분 н•ҷмҠө ] II. к°•нҷ”н•ҷмҠө

- 15. вҖў вҖў пғ м „нҶөм Ғ л°©мӢқ кІҢмһ„ Playing AI II. к°•нҷ”н•ҷмҠө

- 16. н•ҙкІ°мұ…: к°•нҷ” н•ҷмҠө кё°л°ҳ AI вҖў Trial & ErrorлҘј нҶөн•ҙ мҠӨмҠӨлЎң н•ҷмҠө вҖў мқјл°ҳм Ғмқё Deep Learningкіј лӢ¬лҰ¬ н•ҷмҠө лҚ°мқҙн„°к°Җ н•„мҡ”м—Ҷкё° л•Ңл¬ём—җ лқјмқҙлёҢ м„ң비мҠӨ мқҙм „ AI к°ңл°ңм—җ мң мҡ© лӘ©н‘ң: кі н’Ҳм§Ҳ AI м ңмһ‘ кіјм • мһҗлҸҷнҷ” вҖў к·ңм№ҷ мһ…л Ҙ м—Ҷмқҙ AI к°ңл°ң вҖў Super-human Level AI к°ңл°ң л¬ём ңв‘ : ліөмһЎн•ң кІҢмһ„мқ„ мң„н•ң AI м ңмһ‘мқҳ м–ҙл ӨмӣҖ вҖў лӢӨм–‘н•ң м•Ўм…ҳ, мӢӨмӢңк°„м„ұмңјлЎң мқён•ҙ м—„мІӯлӮҳ кІҢ л§ҺмқҖ мғҒнҷ©мқҙ л°ңмғқ л¬ём ңв‘Ў: м—…лҚ°мқҙнҠёлЎң мқён•ң м§ҖмҶҚм Ғмқё мҲҳмһ‘м—… кё°кі„н•ҷмҠө кё°л°ҳ кІҢмһ„ Playing AI ex) Blade &Soul мҠӨнӮ¬м°Ҫ (мҠӨнӮ¬ 50к°ң мқҙмғҒ) II. к°•нҷ”н•ҷмҠө

- 17. Blue: нҸүк°ҖмғҒлҢҖ AI (Hard-coded AI) к°•нҷ”н•ҷмҠөмқҙ м–јл§ҲлӮҳ к°ңл°ңмһҗлҘј лҸ„мҡё мҲҳ мһҲмқ„ к№Ң? Red: к°•нҷ”н•ҷмҠө AI лӮҙл¶Җм—җм„ң л§Ңл“ RTS AI н…ҢмҠӨнҠёмҡ© кІҢмһ„ к°ңл°ң(н•ҷмҠө) мӢңк°„ м„ұлҠҘ Hard-coded AI 30 Days Human Level к°•нҷ”н•ҷмҠө AI 2 Days Super Human Level пғ Super-human Level AIлҘј л№ лҘҙкІҢ к°ңл°ңн• мҲҳ мһҲм—ҲмқҢ II. к°•нҷ”н•ҷмҠө лӮҙл¶Җ мӢӨн—ҳ кІ°кіј

- 18. мӮ°м—…кі„ к°•нҷ”н•ҷмҠө R&D 추세 OpenAI Dota2: 1 vs.1 [2017] OpenAI Five: 5 vs.5 [2018] Playing Atari [2013] AlphaGo [2016~2017] Quake III Arena [2018] Starcraft II [2017~] II. к°•нҷ”н•ҷмҠө Simple, Single Player Game Complex, Multi Player Game B&S AI [2016~]

- 19. III. B&S 비л¬ҙ AI

- 20. к°•нҷ”н•ҷмҠө кё°л°ҳ AIлҘј к°ңл°ңн•ҳм—¬ вҖҳB&S л¬ҙн•ңмқҳ нғ‘вҖҷ м»Ён…җмё м„ң비мҠӨ мӨ‘ вҖў B&S 비л¬ҙ AI: м „нҲ¬ мғҒнҷ©м—җ м Ғм Ҳн•ң м•Ўм…ҳ(кіөкІ©/л°©м–ҙ/мқҙлҸҷ) м„ нғқ вҖў л¬ҙн•ңмқҳ нғ‘: 9к°ң м§Ғм—… AI м„ң비мҠӨ (ver.1.0 / 2016л…„ 1мӣ”) B&S кё°л°ҳмңјлЎң м§ҖмҶҚм Ғмқё к°•нҷ”н•ҷмҠө кё°мҲ R&D 진н–ү NCSOFT к°•нҷ”н•ҷмҠө R&D III. B&S 비л¬ҙ AI [ v1.0: м„ң비мҠӨ лІ„м „ ] вҖў к°•нҷ” н•ҷмҠө + (н•ҷмҠөмқҙ м–ҙл Өмҡҙ мқјл¶Җ кё°лҠҘм—җ к·ңм№ҷ м Ғмҡ©) [ v2.0: к°ңл°ң 진н–ү лІ„м „ ] вҖў мӢ¬мёө к°•нҷ” н•ҷмҠөDeep Reinforcement Learning : к°•нҷ”н•ҷмҠө + л”Ҙлҹ¬лӢқ вҖў мӮ¬мҡ©мһҗ м „нҲ¬ лЎңк·ё нҷңмҡ© вҖў к·ңм№ҷ м—Ҷмқҙ кё°кі„ н•ҷмҠө л§ҢмңјлЎң м ңмһ‘ л¬ҙн•ңмқҳ нғ‘ Play мҳҒмғҒ( м№јмқ„ мӮ¬мҡ©н•ҳлҠ” мәҗлҰӯн„° = AI )

- 21. B&S AI н•„мҡ”н•ң AIлҠ” л¬ҙм—Үмқёк°Җ? HumanAI 1:1 PvP [ Input ] вҖў нҳ„мһ¬ мғҒнҷ© (State) вҖў м§Ғм—…лі„ мӮ¬мҡ© к°ҖлҠҘн•ң мҠӨнӮ¬ (Action, мөңлҢҖ 50к°ң) вҖў мҙқ 11к°ң м§Ғм—… [ Output ] вҖў л§Ө мҲңк°„л§ҲлӢӨ нҳ„мһ¬ мғҒнҷ©м—җ к°ҖмһҘ м Ғм Ҳн•ң мҠӨнӮ¬кіј мӣҖм§Ғмһ„ м„ нғқ III. B&S 비л¬ҙ AI Task 1:1 м „нҲ¬м—җм„ң мҠ№лҰ¬ What to learn (Action) 50м—¬ к°ңмқҳ мҠӨнӮ¬ Feedback (Reward) мһҘкё°м Ғ: кІҢмһ„ мҠ№нҢЁ + лӢЁкё°м Ғ: мІҙл Ҙ к°җмҶҢ л“ұ

- 22. Alpha Zero м•Ңкі лҰ¬мҰҳмқ„ к·ёлҢҖлЎң м Ғмҡ©н• мҲҳ м—ҶлҠ”к°Җ? мӢӨмӢңк°„м„ұмңјлЎң мқён•ң мҶҚлҸ„ м ңн•ң III. B&S 비л¬ҙ AI вҖ» B&SлҠ” м–јл§ҲлӮҳ м–ҙл Өмҡҙ кІҢмһ„мқёк°Җ? кІҪмҡ°мқҳ мҲҳ вү’ 10^768GO B&S Action мҲҳ мҠӨнӮ¬ мҲҳ = м•Ҫ 50к°ң Moving = 8л°©н–Ҙ Targeting = 2к°Җм§Җ кІҪкё°мӢңк°„ кІҪкё° мӢңк°„ = мөңлҢҖ 180 sec Tick = 0.1 sec Decision Tick = 1800нҡҢ кІҪмҡ°мқҳ мҲҳ вү’ 800^1800 * вҖў Alpha Zeroмқҳ к·јк°„мқҙ лҗҳлҠ” Monte Carlo Tree Search вҖў л§Өмҡ° к°•л Ҙн•ҳм§Җл§Ң мҶҚлҸ„ м ңм•Ҫ л•Ңл¬ём—җ Turn м ңк°Җ м•„лӢҲл©ҙ мӮ¬мҡ©н• мҲҳ м—Ҷ мқҢ вҖў мӢӨмӢңк°„ кІҢмһ„м—җм„ң Tree Search кё°л°ҳ Planning мӮ¬мҡ© л¶Ҳк°Җ вҖў B&SлҠ” 0.1 sec лӮҙм—җ Decision лҗҳм–ҙм•ј н•ҳлҠ” мӢӨмӢңк°„ кІҢмһ„ вҖў End-to-end Neural Network Only лӘЁлҚё мӮ¬мҡ©н• мҲҳ л°–м—җ м—ҶмқҢ

- 23. B&S AI: к°ңл°ң н”„лЎңм„ёмҠӨ Multi-trainer Reinforcement Learning Self Learning Single-trainer Reinforcement Learning Simulator н•ҷмҠөмӢңмҠӨн…ң к°ңл°ң к°•нҷ”н•ҷмҠөмқҖ л§Өмҡ° ліөмһЎн•ҳкі м •көҗн•ң м•Ңкі лҰ¬мҰҳ пғ лӢЁкі„м ҒмңјлЎң мӢңмҠӨн…ңкіј м•Ңкі лҰ¬мҰҳмқҳ мІ м Җн•ң кІҖмҰқмқҙ н•„ мҡ”н•Ё мӢ¬мёөк°•нҷ”н•ҷмҠө кё°л°ҳ AI AIк°Җ мһҗкё° мһҗмӢ лҳҗлҠ” лӢӨлҘё AIл“Өкіј лҢҖкІ°н•ҙм„ң мҠӨмҠӨлЎң н•ҷмҠөн•ҳкІҢ н•Ё III. B&S 비л¬ҙ AI

- 24. Simulator & н•ҷмҠө мӢңмҠӨн…ң III. B&S 비л¬ҙ AI н•ҷмҠө мӢңмҠӨн…ң Part Simulator Part AI Server Game Server Game Client вҖў ліөмһЎн•ң м„ңлІ„ кө¬мЎ°: м„ұлҠҘ Bottleneck л°Ҹ Scalability мқҙмҠҲ вҖў кІҢмһ„ кІ°кіјмқҳ мһ¬нҳ„м„ұ: к°ҖмһҘ Criticalн–ҲлҚҳ мқҙмҠҲ. мӢӨн–ү нҷҳкІҪ л“ұм—җ л”°лқј кІҢмһ„ кІ°кіјмҷҖ м„ұлҠҘмқҙ Deterministicн•ҳм§Җ м•ҠмқҖ м җ

- 25. Single-trainer Reinforcement Learning III. B&S 비л¬ҙ AI кі м •лҗң 1лӘ…мқҳ мғҒлҢҖк°Җ мЈјм–ҙмЎҢмқ„ л•Ң мғҒлҢҖлҘј мқҙкёё мҲҳ мһҲлҠ” AI н•ҷмҠө вҖў лӘ©н‘ң: мғҒлҢҖл°© 1лӘ…м—җ лҢҖн•ң мҠ№лҘ 90% мқҙмғҒ лӢ¬м„ұ вҖў лӘ©м Ғ: Robustн•ҳкі н•ҷмҠө мҶҚлҸ„к°Җ л№ лҘё м•Ңкі лҰ¬мҰҳмқҳ нҷ•ліҙ вҖў м–ҙл–Ө мғҒлҢҖк°Җ мЈјм–ҙм§ҖлҚ”лқјлҸ„ л№ лҘҙкІҢ м„ұлҠҘмқ„ лҶ’мқј мҲҳ мһҲлҠ” м•Ңкі лҰ¬мҰҳ нҷ•ліҙ лӢӨм–‘н•ң 분лҘҳмқҳ м•Ңкі лҰ¬мҰҳмқ„ лі‘н–үн•ҙм„ң н…ҢмҠӨнҠё вҖў PDD DQN, DQfD, A3C л“ұ мөңмӢ м•Ңкі лҰ¬мҰҳ л“ұмқ„ Parallelн•ҳкІҢ н…ҢмҠӨнҠё вҖў мөңмҙҲ мӢӨн—ҳ: ver1.0 лҳҗлҠ” мӮ¬мҡ©мһҗ лЎңк·ёлЎң н•ҷмҠөн•ҙм„ң л§Ңл“ мғҒлҢҖлЎң н•ҷмҠө мӢӨн—ҳмқ„ нҶөн•ҙ кІҖмҰқ вҖў мҙҲкё°м—җлҠ” 1к°ң мғҒлҢҖлЎңлҠ” лҢҖл¶Җ분 м•Ңкі лҰ¬мҰҳ л“Өмқҳ м„ұлҠҘмқҙ нҒ¬кІҢ м°ЁмқҙлӮҳм§Җ м•Ҡм•ҳмқҢ мӮ¬мҡ©мһҗ лЎңк·ё кё°л°ҳ Supervised Learning вҖў мӮ¬мҡ©мһҗл“Өмқҳ 1:1 비л¬ҙмһҘ лЎңк·ёлҘј мҲҳ집 пғ Supervised Learning вҖў мўӢмқҖ н’Ҳм§Ҳмқҳ AIлҘј л№ лҘҙкІҢ м ңмһ‘ к°ҖлҠҘ. лҳҗн•ң, к°•нҷ”н•ҷмҠөмқҳ SeedлЎң мӮ¬мҡ© к°ҖлҠҘ пғ мөңмў… лІ„м „мқҖ мӮ¬мҡ©мһҗ лЎңк·ё кё°л°ҳ Seedм—ҶмқҙлҸ„ н•ҷмҠөмқҙ мһҳ лҗҳм–ҙм„ң мөңмў… лІ„м „мқҖ м Ғмҡ©лҗҳм§Җ м•ҠмқҢ

- 26. Self Play Learning III. B&S 비л¬ҙ AI мһҗкё° мһҗмӢ лҳҗлҠ” кіјкұ°мқҳ мһҗкё° мһҗмӢ мқ„ мғҒлҢҖлЎң мҠӨмҠӨлЎң н•ҷмҠө вҖў лӘ©н‘ң: мһҗкё° мһҗмӢ мқ„ мғҒлҢҖлЎң кі„мҶҚ н•ҷмҠөмқ„ н•ҳл©ҙм„ңлҸ„ кҫёмӨҖнһҲ м „нҲ¬ м„ұлҠҘмқҙ лӮҳм•„м§ҖлҸ„лЎқ н•Ё вҖў лӘ©м Ғ: мөңмҙҲмқҳ мғҒлҢҖк°Җ м—ҶлҚ”лқјлҸ„ Random Initialize мғҒнғңмқҳ AIл“Өл§Ң мһҲм–ҙлҸ„ н•ҷмҠөмқҙ мқҙлЈЁм–ҙм§Ҳ мҲҳ мһҲлҸ„лЎқ н•Ё вҖ» кё°мҲ м Ғ лӮңм ң: мӮ¬лһҢ мғҒлҢҖ лӮңмқҙлҸ„ вҖў к°•нҷ”н•ҷмҠө: кё°ліём ҒмңјлЎң мЈјм–ҙ진 Environmentм—җ м Ғмқ‘н•ҳлҠ” кІғ вҖў к°•нҷ”н•ҷмҠөмңјлЎң л§Ңл“Өм–ҙм§ҖлҠ” AIлҠ” к·ё нҷҳкІҪм—җ Overfitлҗ мҲҳ л°–м—җ м—ҶмқҢ вҖў мІҙк°җ лӮңмқҙлҸ„ м Җн•ҳ: AI мғҒлҢҖ мӢӨл Ҙ вү мӮ¬лһҢ мғҒлҢҖ мІҙк°җ лӮңмқҙлҸ„ пғ Solution: Multi-trainer н•ҷмҠөлІ• вҖў кІ°көӯ лӢӨм–‘н•ң кІҪн—ҳмқ„ м§ҖмҶҚм ҒмңјлЎң мЈјл©ҙм„ң мӢӨл Ҙмқ„ лҶ’мқҙлҠ” л°©лІ• мқҙмҷём—җлҠ” мЎҙмһ¬н•ҳм§Җ м•ҠмқҢ вҖў ліөмҲҳк°ңмқҳ лӢӨм–‘н•ң м—¬лҹ¬ мғҒлҢҖ(мһҗмӢ кіј кіјкұ°мқҳ мһҗкё° мһҗмӢ л“ұ)мқ„ мғҒлҢҖлЎң лҸҷмӢңм—җ н•ҷмҠө

- 27. Multi-trainer Reinforcement Learning & ACER Detailн•ң м•Ңкі лҰ¬мҰҳмқҖ л…јл¬ёмңјлЎң м •лҰ¬ мӨ‘. л…јл¬ёмңјлЎң л°ңн‘ңн•ҳл©ҙ лӢӨмӢң кіөк°ңн•ҙл“ңлҰҙ мҳҲм • III. B&S 비л¬ҙ AI л§Ҳм§Җл§ү лӮңм ң: Multi-trainer мғҒлҢҖ н•ҷмҠө вҖў мӮ¬лһҢ мғҒлҢҖ м„ұлҠҘмқ„ лҶ’мқҙкё° мң„н•ҙ Multi-trainer мғҒлҢҖ н•ҷмҠөмқҙ н•„мҲҳм Ғ вҖў к·ёлҹ¬лӮҳ, м—¬лҹ¬ AIлҘј мғҒлҢҖлЎң н•ҷмҠөмқҙ л§Өмҡ° нҡЁмңЁм Ғмқҙм§Җ лӘ»н•ҳмҳҖмқҢ вҖў м–ҙлҠҗ м •лҸ„ мҲҳмӨҖмңјлЎң м„ұлҠҘмқҙ лҶ’м•„м§Җкёҙ н•ҳм§Җл§Ң н”„лЎңкІҢмқҙлЁё мҲҳмӨҖк№Ңм§Җ мқҙлҘҙм§Җ лӘ»н•Ё Solution: ACER вҖў м§ҖкёҲк№Ңм§Җ н…ҢмҠӨнҠён•ң м•Ңкі лҰ¬мҰҳкіј B&S л¬ём ңлҘј лӢӨмӢң мқҙлЎ м ҒмңјлЎң мһ¬кІҖнҶ вҖў B&S л¬ём ңм—җ мһҳл§һлҠ” м•Ңкі лҰ¬мҰҳ (off policy, discrete action space)мқ„ м°ҫм•„лғ„ пғ ACER(Actor-Critic with Experience Replay): https://arxiv.org/abs/1611.01224 пғ лӢЁмқј мғҒлҢҖ, ліөмҲҳ мғҒлҢҖ лӘЁл‘җ н•ҷмҠө м„ұлҠҘмқҙ л§Өмҡ° лҶ’м•ҳмқҢ н•ҷмҠө мҶҚлҸ„ вҖў 2017л…„ лІ„м „: ver1.0 90% мқҙмғҒ лӢ¬м„ұм—җ 48мӢңк°„ мҶҢмҡ” вҖў 2018л…„ лІ„м „: ver1.0 95% мқҙмғҒ лӢ¬м„ұм—җ 30분 лҜёл§Ң мҶҢмҡ”

- 28. B&S AI к°•нҷ”н•ҷмҠө кІ°кіј HPлҘј лӘЁл‘җ к№ҺлҠ”лҚ° мҶҢмҡ”лҗҳлҠ” мӢңк°„: 2분 45мҙҲ 20мҙҲ III. B&S 비л¬ҙ AI [ н•ҷмҠө мӢңмһ‘ лӢЁкі„ ] [ 1 Day н•ҷмҠө нӣ„ ] [ 1 Week н•ҷмҠө нӣ„ ] мӮ¬лһҢ AI Full мҳҒмғҒ: https://www.youtube.com/watch?v=NGeryFck8sw

- 29. м„ұлҠҘ кІҖмҰқ: 비кіөк°ң н”„лЎңкІҢмқҙлЁё н…ҢмҠӨнҠё кіөкІ©нҳ• AI Top Level н”„лЎңкІҢмқҙлЁё III. B&S 비л¬ҙ AI

- 30. кІ°лЎ Top Level н”„лЎңкІҢмқҙлЁё 2лӘ… мғҒлҢҖлЎң 비кіөк°ң н…ҢмҠӨнҠё мӢӨмӢң - мөңм •мғҒкёү н”„лЎңкІҢмқҙлЁё 2лӘ…мқ„ 비кіөк°ң м„ӯмҷён•ҳм—¬ лӢӨм–‘н•ң лІ„м „мқҳ м„ұлҠҘ кІҖмҰқ - лІ„м „ лі„лЎң м•Ҫк°„мқҳ м°Ёмқҙк°Җ мһҲм—ҲмңјлӮҳ м „мІҙм ҒмңјлЎң н”„лЎңкІҢмқҙлЁёлҘј мқҙкёё мҲҳ мһҲлҠ” кІғмқ„ нҷ•мқё - нҠ№нһҲ, к°ҖмһҘ к°•н•ң лІ„м „(кіөкІ©м Ғмқё м„ұн–Ҙмқ„ ліҙмқё лӘЁлҚё)мқҖ 2лІҲмқҳ 비кіөк°ң н…ҢмҠӨнҠё кё°к°„ лҸҷм•Ҳ 100% мҠ№лҘ ліҙмһ„ кё°мҲ м Ғ м„ұм·Ё - мӢӨмӢңк°„ кІҢмһ„м—җм„ң FSM, Behavior TreeмҷҖ к°ҷмқҖ к·ңм№ҷ Hardcoding м—Ҷмқҙ мөңкі мҲҳмӨҖмқҳ AI м ңмһ‘ к°ҖлҠҘ нҷ•мқё III. B&S 비л¬ҙ AI

- 32. B&S мӣ”л“ңмұ”н”јм–ёмүҪ IV. B&S мӣ”л“ңмұ”н”јм–ёмүҪ NCSOFT лҢҖн‘ң e-sports н–үмӮ¬ вҖў Blade & Soul 비л¬ҙ кІҪкё°(1:1, нғңк·ёл§Өм№ҳ) e-sports лҢҖнҡҢ вҖў мӢңмҰҢмқ„ кұ°міҗ м„ л°ңлҗң к°Ғ көӯк°Җлі„ лҢҖн‘ңнҢҖл“Өмқҙ лӘЁм—¬м„ң мӣ”л“ң мұ”н”јм–ёмқ„ к°ҖлҰј вҖў OGN кёҖлЎңлІҢ мғқл°©мҶЎ

- 33. вҖңкІҢмһ„нҡҢмӮ¬ NCSOFTлӢӨмҡҙ мһ¬лҜёмһҲлҠ” ShowлҘј кө¬м„ұн•ҙліҙмһҗвҖң вҖў мІҳмқҢ кі„нҡҚ: 3м „2м„ мҠ№ 1кІҢмһ„ мқҙлІӨнҠё Match вҖў мҳҲмғҒ л¬ём ңм җ пғј н”„лЎңкІҢмқҙлЁё лҢҖмғҒ мӮ¬м „ н…ҢмҠӨнҠё кІ°кіјк°Җ мғҒлӢ№нһҲ м••лҸ„м Ғ пғј л°©мҶЎнҢҖмқҳ мқҳкІ¬ вҖ“ вҖңAIк°Җ л„Ҳл¬ҙ к°•н•ҙм„ң л°©мҶЎ 분лҹүмқҙ м•ҲлӮҳмҳ¬ кІғ к°ҷлӢӨвҖқ н–үмӮ¬ мӨҖ비 л°Ҹ кё°нҡҚ мҡ°лҰ° м–ҙл–Ө AIлҘј лӘ©н‘ңлЎң н•ҳкі мһҲм—ҲлҠ”к°Җ? IV. B&S мӣ”л“ңмұ”н”јм–ёмүҪ

- 34. вҖңкІҢмһ„нҡҢмӮ¬ NCSOFTлӢӨмҡҙ мһ¬лҜёмһҲлҠ” ShowлҘј кө¬м„ұн•ҙліҙмһҗвҖң вҖў 3к°Җм§Җ Type AI к°ңл°ң: кіөкІ©нҳ•, мҲҳ비нҳ•, кіөмҲҳк· нҳ• пғ 3кІҪкё°лЎң нҷ•мһҘ вҖў лӮңмқҙлҸ„ мЎ°м Ҳ вҖ’ м—¬лҹ¬ лӮңмқҙлҸ„мқҳ AIлҘј м¶ңм „мӢңмјң 박진к°җмһҲлҠ” ShowлҘј л§Ңл“Өм–ҙліҙмһҗ вҖ’ лӘЁл“ кІҪкё°л§ҲлӢӨ 1м„ёнҠёлҠ” л¬ҙмЎ°кұҙ лӮңмқҙлҸ„к°Җ лӮ®мқҖ AI м¶ңм „, 2м„ёнҠёл¶Җн„° к°•н•ң AIк°Җ м¶ңм „ н–үмӮ¬ мӨҖ비 л°Ҹ кё°нҡҚ Type 1 кіөмҲҳл°ёлҹ°мҠӨнҳ• AI Type 2 мҲҳ비нҳ• AI Type 3 кіөкІ©нҳ• AI 1кІҪкё° 2кІҪкё° 3кІҪкё° н”„лЎңкІҢмқҙлЁё 1 н”„лЎңкІҢмқҙлЁё 2 н”„лЎңкІҢмқҙлЁё 3 3м „ 2м„ мҠ№м ң 3м „ 2м„ мҠ№м ң 3м „ 2м„ мҠ№м ң IV. B&S мӣ”л“ңмұ”н”јм–ёмүҪ

- 35. мқҙлІӨнҠёмҡ© AI 추к°Җ к°ңл°ң: Reward мЎ°м •м—җ л”°лҘё м—¬лҹ¬ Type AI к°ңл°ң вҖў кіөкІ©нҳ• Reward: мӢңк°„мқҙ м§ҖлӮ мҲҳлЎқ Penalty пғ м ҲлҢҖ л¬јлҹ¬м„ңм§Җ м•ҠмқҢ вҖў мҲҳ비нҳ• Reward: мһҗмӢ мқҳ HPк°Җ к№Һмқҙл©ҙ Penalty пғ к°ҖлҠҘн•ң м„ кіөмқ„ н•ҳм§Җ м•ҠмқҢ AI мӮ¬лһҢ IV. B&S мӣ”л“ңмұ”н”јм–ёмүҪ

- 36. мқҙлІӨнҠёмҡ© AI 추к°Җ к°ңл°ң: н”„лЎңкІҢмқҙлЁё мӮ¬м „ кІҖмҰқ мҲҳ비нҳ• AI Top Level н”„лЎңкІҢмқҙлЁё IV. B&S мӣ”л“ңмұ”н”јм–ёмүҪ

- 37. вҖў н”„лЎңкІҢмқҙлЁё мӮ¬м „ н…ҢмҠӨнҠё вҖў м „мІҙм Ғмқё м„ұлҠҘ л°Ҹ мІҙк°җ лӮңмқҙлҸ„: кіөкІ©нҳ• >> мҲҳ비нҳ• вү’ кіөмҲҳк· нҳ• вҖў л¬ҙмЎ°кұҙ 1кІҪкё°лҠ” B лІ„м „, 2кІҪкё°л¶Җн„°лҠ” A лІ„м „мқҙ м¶ңм „н•ҳм—¬ л°•л№ҷмқҳ мҠ№л¶ҖлҘј м—°м¶ңн•ҳ мһҗ! 1кІҪкё°: кіөмҲҳк· нҳ• AI 2кІҪкё°: мҲҳ비нҳ• AI 3кІҪкё°: кіөкІ©нҳ• AI (к°ҖмһҘ к°•л Ҙн•ң лІ„м „) к· нҳ•B к· нҳ•A мҲҳ비B мҲҳ비A кіөкІ©B кіөкІ©A н”„лЎңкІҢмқҙлЁё лҢҖмғҒ мӮ¬м „ 비кіөк°ң н…ҢмҠӨнҠё кІ° кіј 33% 50% 50% 100% 66% 100% лӘ©н‘ң мӢңлӮҳлҰ¬мҳӨ 2мҠ№1нҢЁ 1мҠ№2нҢЁ 2мҠ№ мқҙлІӨнҠёмҡ© AI 추к°Җ к°ңл°ң IV. B&S мӣ”л“ңмұ”н”јм–ёмүҪ

- 38. мқҙлІӨнҠё кІ°кіј IV. B&S мӣ”л“ңмұ”н”јм–ёмүҪ Full мҳҒмғҒ: https://www.youtube.com/watch?v=JQfLbEBJCbg

- 39. B&S мӣ”л“ңмұ”н”јм–ёмүҪ (9/15): Blind Match вҖ“ вҖңAI vs. н”„лЎңкІҢмқҙлЁёвҖқ мқҙлІӨнҠё кІ°кіј көҗнӣҲ: мҠӨнҸ¬мё лҠ” м—ӯмӢң мҠӨнҸ¬мё лӢөкІҢ к·ёлғҘ мөңм„ мқ„ лӢӨн•ҳмһҗ T.T 1кІҪкё°: кіөмҲҳк· нҳ• AI 2кІҪкё°: мҲҳ비нҳ• AI 3кІҪкё°: кіөкІ©нҳ• AI (к°ҖмһҘ к°•л Ҙн•ң лІ„м „) к· нҳ•B к· нҳ•A мҲҳ비нҳ•B мҲҳ비нҳ•A кіөкІ©нҳ•B кіөкІ©нҳ•A 비кіөк°ң н…ҢмҠӨнҠё кІ°кіј (н”„лЎңкІҢмқҙлЁё 2лӘ… лҢҖмғҒ мҠ№лҘ ) 33% 50% 50% 100% 66% 100% лӘ©н‘ң мӢңлӮҳлҰ¬мҳӨ 2мҠ№1нҢЁ 1мҠ№2нҢЁ 2мҠ№ мӢӨм ң кІ°кіј 1мҠ№2нҢЁ 2нҢЁ 2мҠ№ IV. B&S мӣ”л“ңмұ”н”јм–ёмүҪ

- 40. Special Thanks to Reinforcement Learning Team! IV

- 41. Contact: мқҙкІҪмў… мӢӨмһҘ kjlee@ncsoft.com

![вҖў вҖңLearning without a TeacherвҖқ

вҖў м•„кё°мқҳ н•ҷмҠө кіјм •кіј ліём„ұмқ„ лӘЁлҚёл§Ғ

вҖў кё°кұ°лӮҳ кұ·лҠ” лІ•мқ„ м•Ңм•„к°ҖлҠ” кіјм •м—җм„ң,

м§Ғм ‘ н–үлҸҷмқ„ н•ҳкі Feedbackмқ„ нҶөн•ҙ м җм җ лҚ” лӮҳмқҖ н–үлҸҷмқ„ н•ҳкІҢ лҗЁ

Trial Error Great conceptual leaps

л°ҳліөлҗң Trial & Error кіјм •м—җм„ң Feedbackм—җ мқҳн•ҙм„ң н•ҷмҠө

к°•нҷ”н•ҷмҠө [1/3]

II. к°•нҷ”н•ҷмҠө](https://image.slidesharecdn.com/11-181023083452/85/IGC2018-AI-11-320.jpg)

![пғј н•ҷмҠө мқҙм „ пғј н•ҷмҠө мқҙнӣ„

Example в‘ : нҢ¬мјҖмқө л’Ө집기 лЎңлҙҮ

Trial пғ м„ұкіө, мӢӨнҢЁ Feedback пғ кҙҖм Ҳм—җ мһ…л ҘлҗҳлҠ” нһҳмқ„ мЎ°м • пғ лӢӨмӢң Trial вҖҰ.

к°•нҷ”н•ҷмҠө [2/3]

Task лЎңлҙҮ нҢ”мқҳ мӣҖм§Ғмһ„мқ„ м ңм–ҙн•ҳм—¬ нҢ¬мјҖмқө л’Ө집기

What to learn (Action) к°Ғ кҙҖм Ҳм—җ мһ…л ҘлҗҳлҠ” нһҳ мЎ°м Ҳ

Feedback (Reward) нҢ¬мјҖмқө л’Ө집기лҘј м–јл§ҲлӮҳ мһҳн–ҲлҠ”к°Җ?

II. к°•нҷ”н•ҷмҠө](https://image.slidesharecdn.com/11-181023083452/85/IGC2018-AI-12-320.jpg)

![к°•нҷ”н•ҷмҠө [3/3]

Example в‘Ў: Playing Atari [Deepmind]

Task Breakout кІҢмһ„мқ„ Play

What to learn (Action) BarлҘј мўҢмҡ°лЎң мӣҖм§Ғмһ„ (2к°ң лҸҷмһ‘)

Feedback (Reward) м–јл§ҲлӮҳ кі л“қм җмқ„ мҳ¬л ёлҠ”к°Җ?

[ 10분 н•ҷмҠө ] [ 120분 н•ҷмҠө ] [ 240분 н•ҷмҠө ]

II. к°•нҷ”н•ҷмҠө](https://image.slidesharecdn.com/11-181023083452/85/IGC2018-AI-13-320.jpg)

![мӮ°м—…кі„ к°•нҷ”н•ҷмҠө R&D 추세

OpenAI Dota2: 1 vs.1 [2017] OpenAI Five: 5 vs.5 [2018]

Playing Atari [2013] AlphaGo [2016~2017] Quake III Arena [2018] Starcraft II [2017~]

II. к°•нҷ”н•ҷмҠө

Simple, Single Player Game Complex, Multi Player Game

B&S AI [2016~]](https://image.slidesharecdn.com/11-181023083452/85/IGC2018-AI-18-320.jpg)

![к°•нҷ”н•ҷмҠө кё°л°ҳ AIлҘј к°ңл°ңн•ҳм—¬ вҖҳB&S л¬ҙн•ңмқҳ нғ‘вҖҷ м»Ён…җмё м„ң비мҠӨ мӨ‘

вҖў B&S 비л¬ҙ AI: м „нҲ¬ мғҒнҷ©м—җ м Ғм Ҳн•ң м•Ўм…ҳ(кіөкІ©/л°©м–ҙ/мқҙлҸҷ) м„ нғқ

вҖў л¬ҙн•ңмқҳ нғ‘: 9к°ң м§Ғм—… AI м„ң비мҠӨ (ver.1.0 / 2016л…„ 1мӣ”)

B&S кё°л°ҳмңјлЎң м§ҖмҶҚм Ғмқё к°•нҷ”н•ҷмҠө кё°мҲ R&D 진н–ү

NCSOFT к°•нҷ”н•ҷмҠө R&D

III. B&S 비л¬ҙ AI

[ v1.0: м„ң비мҠӨ лІ„м „ ]

вҖў к°•нҷ” н•ҷмҠө + (н•ҷмҠөмқҙ м–ҙл Өмҡҙ мқјл¶Җ кё°лҠҘм—җ к·ңм№ҷ м Ғмҡ©)

[ v2.0: к°ңл°ң 진н–ү лІ„м „ ]

вҖў мӢ¬мёө к°•нҷ” н•ҷмҠөDeep Reinforcement Learning : к°•нҷ”н•ҷмҠө + л”Ҙлҹ¬лӢқ

вҖў мӮ¬мҡ©мһҗ м „нҲ¬ лЎңк·ё нҷңмҡ©

вҖў к·ңм№ҷ м—Ҷмқҙ кё°кі„ н•ҷмҠө л§ҢмңјлЎң м ңмһ‘

л¬ҙн•ңмқҳ нғ‘ Play мҳҒмғҒ( м№јмқ„ мӮ¬мҡ©н•ҳлҠ” мәҗлҰӯн„° = AI )](https://image.slidesharecdn.com/11-181023083452/85/IGC2018-AI-20-320.jpg)

![B&S AI

н•„мҡ”н•ң AIлҠ” л¬ҙм—Үмқёк°Җ?

HumanAI

1:1 PvP

[ Input ]

вҖў нҳ„мһ¬ мғҒнҷ© (State)

вҖў м§Ғм—…лі„ мӮ¬мҡ© к°ҖлҠҘн•ң мҠӨнӮ¬

(Action, мөңлҢҖ 50к°ң)

вҖў мҙқ 11к°ң м§Ғм—…

[ Output ]

вҖў л§Ө мҲңк°„л§ҲлӢӨ нҳ„мһ¬ мғҒнҷ©м—җ

к°ҖмһҘ м Ғм Ҳн•ң мҠӨнӮ¬кіј

мӣҖм§Ғмһ„ м„ нғқ

III. B&S 비л¬ҙ AI

Task 1:1 м „нҲ¬м—җм„ң мҠ№лҰ¬

What to learn (Action) 50м—¬ к°ңмқҳ мҠӨнӮ¬

Feedback (Reward) мһҘкё°м Ғ: кІҢмһ„ мҠ№нҢЁ + лӢЁкё°м Ғ: мІҙл Ҙ к°җмҶҢ л“ұ](https://image.slidesharecdn.com/11-181023083452/85/IGC2018-AI-21-320.jpg)

![B&S AI к°•нҷ”н•ҷмҠө кІ°кіј

HPлҘј лӘЁл‘җ к№ҺлҠ”лҚ° мҶҢмҡ”лҗҳлҠ” мӢңк°„: 2분 45мҙҲ 20мҙҲ

III. B&S 비л¬ҙ AI

[ н•ҷмҠө мӢңмһ‘ лӢЁкі„ ] [ 1 Day н•ҷмҠө нӣ„ ] [ 1 Week н•ҷмҠө нӣ„ ]

мӮ¬лһҢ

AI

Full мҳҒмғҒ: https://www.youtube.com/watch?v=NGeryFck8sw](https://image.slidesharecdn.com/11-181023083452/85/IGC2018-AI-28-320.jpg)

![[NDC 2010] к·ёлҹҙл“Ҝн•ң лһңлҚӨ мғқм„ұ м»Ён…җмё л§Ңл“Өкё°](https://cdn.slidesharecdn.com/ss_thumbnails/hsf4fdvtjgcprbeczm9r-signature-8b01151cfddd883a338efa8a6603d585034336564338d911ab6e95aca4592fa0-poli-150122014503-conversion-gate02-thumbnail.jpg?width=560&fit=bounds)

![NDC 2015 мқҙкҙ‘мҳҒ [м•јмғқмқҳ л•…: л“Җлһ‘кі ] м „нҲ¬ мӢңмҠӨн…ң к°ңл°ң мқјм§Җ](https://cdn.slidesharecdn.com/ss_thumbnails/ndc2015-kwangyoung-150522112340-lva1-app6891-thumbnail.jpg?width=560&fit=bounds)

![[IGC 2017] л„ҘмҠЁмҪ”лҰ¬м•„ мҳӨнҳ„к·ј - нҸүмғқ кІҢмһ„ кё°нҡҚмһҗ н•ҳкё°](https://cdn.slidesharecdn.com/ss_thumbnails/igc2017in-170905063633-thumbnail.jpg?width=560&fit=bounds)

![[IGC 2016] м»ҙнҲ¬мҠӨ к№ҖлҸҷмӨҖ - кё°нҡҚ м§Җл§қмғқмқҖ л¬ҙм—Үмқ„ мӨҖ비н•ҳлӮҳмҡ”?](https://cdn.slidesharecdn.com/ss_thumbnails/3-161009035837-thumbnail.jpg?width=560&fit=bounds)

![[IGC] м—”м”ЁмҶҢн”„нҠё мқҙкІҪмў… - к°•нҷ” н•ҷмҠөмқ„ мқҙмҡ©н•ң NPC AI кө¬нҳ„](https://cdn.slidesharecdn.com/ss_thumbnails/igcnpcai20161007-161010052405-thumbnail.jpg?width=560&fit=bounds)

![[Gdc2011]scoping success kor](https://cdn.slidesharecdn.com/ss_thumbnails/gdc2011scopingsuccesskor-111022070147-phpapp01-thumbnail.jpg?width=560&fit=bounds)

![[м•„мқҙнҺҖнҢ©нҶ лҰ¬] нҒҙлқјмқҙм–ёнҠё к°ңл°ңмһҗ, м„ңлІ„ к°ңл°ң мӢңмһ‘н•ҳкё°](https://cdn.slidesharecdn.com/ss_thumbnails/3final-170519054846-thumbnail.jpg?width=560&fit=bounds)

![[IGC2018] мІӯк°•лҢҖ мқҙл“қмҡ° - м–ёлҰ¬м–јм—җл””н„°нҷ•мһҘмқ„мң„н•ҙм•Ңм•„м•јн• кІғл“Ө](https://cdn.slidesharecdn.com/ss_thumbnails/1-181023075713-thumbnail.jpg?width=560&fit=bounds)

![[IGC2018] SUB мңӨлҜј - лӮҳл§Ңмқҳ мӮ¬мҡҙл“ңвҖ”м ңмһ‘н•ҳкі м—°м¶ңн•ҳкё°](https://cdn.slidesharecdn.com/ss_thumbnails/4-181023024811-thumbnail.jpg?width=560&fit=bounds)

![[IGC2018] мқҙлқҪл””м§Җн„ёл¬ёнҷ”м—°кө¬мҶҢ лӮЁкё°лҚ• - кІҢмһ„ л””мһҗмқёмқҳ мӢңмһ‘, н…Ңл§Ҳ](https://cdn.slidesharecdn.com/ss_thumbnails/3-181023024743-thumbnail.jpg?width=560&fit=bounds)

![[IGC2018] мҷ“мҠӨнҠңл””мҳӨ л°©мҳҒнӣҲ - лҶҖл©ҙм„ңкіөл¶Җн•ҳкё°](https://cdn.slidesharecdn.com/ss_thumbnails/2-181023024737-thumbnail.jpg?width=560&fit=bounds)

![[IGC2018] л„·л§Ҳлё” мқҙмғҒмІ - лӘЁл°”мқј кІҢмһ„ ліҙм•Ҳ AR(Android Republic) ліҖмЎ°м•ұ лӮҙл¶ҖлҘј нҢҢн—Өм№ҳлӢӨ](https://cdn.slidesharecdn.com/ss_thumbnails/1-181023024706-thumbnail.jpg?width=560&fit=bounds)

![[IGC2018] TeamHoray л¬ём§Җнҷҳ - лҚҳк·ёлҰ¬л“ң, мқҙлһ¬мңјл©ҙ лҚ” мўӢм•ҳмқ„ н…җлҚ°](https://cdn.slidesharecdn.com/ss_thumbnails/4-181023024052-thumbnail.jpg?width=560&fit=bounds)

![[IGC2018] м—җн”ҪкІҢмһ„мҰҲ мӢ кҙ‘м„ӯ - м–ёлҰ¬м–јм—”진4 нҸ¬нҠёлӮҳмқҙнҠё л©ҖнӢ°н”Ңлһ«нҸј к°ңл°ң м§Җмӣҗ](https://cdn.slidesharecdn.com/ss_thumbnails/3-181023024046-thumbnail.jpg?width=560&fit=bounds)

![[IGC2018] мһ”л””мҶҢн”„нҠё мңӨм„ёлҜј - HTML5 кІҢмһ„ м–ҙл””к№Ңм§Җ к°ҖлҠҘн•ңк°Җ](https://cdn.slidesharecdn.com/ss_thumbnails/2-181023024034-thumbnail.jpg?width=560&fit=bounds)

![[IGC2018] н•ҙн”јнҲӯ к№Җлҙүк· - лҢҖл§Ң кІҢмһ„ мӢңмһҘ 진м¶ңмӢң мң мқҳн•ҙм•ј н• м җ](https://cdn.slidesharecdn.com/ss_thumbnails/1-181023024023-thumbnail.jpg?width=560&fit=bounds)

![[IGC2018] мәЎмҪӨ нҶ мҝ лӢӨ мң м•ј - лӘ¬мҠӨн„°н—Ңн„° мӣ”л“ңмқҳ кІҢмһ„ м»Ём…үкіј л ҲлІЁ л””мһҗмқё](https://cdn.slidesharecdn.com/ss_thumbnails/3-181023023843-thumbnail.jpg?width=560&fit=bounds)

![[IGC2018] мӮ°нғҖлӘЁлӢҲм№ҙмҠӨнҠңл””мҳӨ м—җмқҙлёҢ нғҖлқјнӮӨ - кІҢмһ„мқҳ м»Ём…ү л””мһҗмқёкіј м„ёкі„лҘј л§Ңл“ңлҠ” лІ•](https://cdn.slidesharecdn.com/ss_thumbnails/2-181023023824-thumbnail.jpg?width=560&fit=bounds)

![[IGC2018] нҺ„м–ҙ비мҠӨ к°•кұҙмҡ° - нҺ„м–ҙ비мҠӨм—җм„ң кё°нҡҚмһҗк°Җ мқјн•ҳлҠ” л°©лІ•](https://cdn.slidesharecdn.com/ss_thumbnails/1-181023023810-thumbnail.jpg?width=560&fit=bounds)

![[IGC2018] мҠӨнҠңл””мҳӨEIM м •мӮ¬мқё - мўӢмқҖ мҶҢлҰ¬лҠ” л¬ҙм—Үмқёк°Җ](https://cdn.slidesharecdn.com/ss_thumbnails/4-181023021153-thumbnail.jpg?width=560&fit=bounds)

![[IGC2018] мң мң мһҗм Ғлқјмқҙн”„ к№ҖмңӨм • - SunShine лІ лҘјлҰ°мқ„ л°қкІҢ 비추лӢӨ](https://cdn.slidesharecdn.com/ss_thumbnails/3-181023021149-thumbnail.jpg?width=560&fit=bounds)

![[IGC2018] мһҗлқјлӮҳлҠ” м”Ём•— к№ҖнҡЁнғқ - MazM мӢңлҰ¬мҰҲлЎң л°”лқјліё мҠӨнҶ лҰ¬ кІҢмһ„мқҳ к°ҖлҠҘм„ұ](https://cdn.slidesharecdn.com/ss_thumbnails/2-181023021131-thumbnail.jpg?width=560&fit=bounds)

![[IGC2018] мқён”ҢлЈЁм „ кіҪ노진 - мқёл””кІҢмһ„мқҙ л§қн• мҲҳ л°–м—җ м—ҶлҠ” нҳ„мӢӨкіј мқҙмң](https://cdn.slidesharecdn.com/ss_thumbnails/1-181023021126-thumbnail.jpg?width=560&fit=bounds)

![[IGC2018] лқјмҡҙл“ң8 л°•м„ұмӨҖ - лё”л ҲмҠӨ м–ёлҰ¬мү¬л“ң мҡ°лҰ¬лҠ” мҷң лӘЁл“ кІғмқ„ мһ¬м„Өкі„н–ҲлӮҳ](https://cdn.slidesharecdn.com/ss_thumbnails/4-181023020222-thumbnail.jpg?width=560&fit=bounds)

![[IGC2018] м•„мқҙлҙү м •лҙүмһ¬ - м•„м§Ғ м•„мқҙ л§қн•ҳлӢҲ](https://cdn.slidesharecdn.com/ss_thumbnails/3-181023020219-thumbnail.jpg?width=560&fit=bounds)

![[IGC2018] нҚјлӢҲнҢҢмҡ° мөңмһ¬мҳҒ - к°җм„ұмқ„ мң„н•ң к°ңл°ңмҡ”мҶҢ](https://cdn.slidesharecdn.com/ss_thumbnails/2-181023020204-thumbnail.jpg?width=560&fit=bounds)

![[IGC2018] мң лӢҲнӢ° н•ЁмҳҒнҳё - л””л°”мқҙмҠӨлҘј нҶөн•ҙ ліё лӘЁл°”мқј кІҢмһ„ л§Ҳмј“ мқёмӮ¬мқҙнҠё](https://cdn.slidesharecdn.com/ss_thumbnails/1-181023020158-thumbnail.jpg?width=560&fit=bounds)